Obtenir des données à partir d’Eventstream

Dans cet article, vous allez apprendre à obtenir des données d’un flux d’événements existant dans une table nouvelle ou existante.

Pour obtenir des données à partir d’un nouveau flux d’événements, consultez Obtenir des données à partir d’un nouveau flux d’événements.

Conditions préalables

- Un espace de travail avec une capacité compatible Microsoft Azure Fabric

- Une base de données KQL avec des autorisations de modification

- Un eventstream avec une source de données

Source

Pour obtenir des données à partir d’un flux d’événements, vous devez sélectionner le flux d’événements comme source de données. Vous pouvez sélectionner un flux d’événements existant de la manière suivante :

Dans le ruban inférieur de votre base de données KQL, choisissez l'une des options suivantes :

Dans le menu déroulant Obtenir des données, puis sous continu , sélectionnez Flux d'événements>Flux d'événements existant.

Sélectionnez Obtenir des données, puis dans la fenêtre Obtenir des données, sélectionnez Eventstream .

Dans le menu déroulant Obtenir des données, sous Continu, sélectionnez Real-Time hub de données>Flux d’événements existant.

Configurer

Sélectionnez une table cible. Si vous souhaitez ingérer des données dans une nouvelle table, sélectionnez + Nouvelle table et entrez un nom de table.

Remarque

Les noms de tables peuvent comporter jusqu’à 1 024 caractères, y compris des espaces, des caractères alphanumériques, des traits d’union et des traits de soulignement. Les caractères spéciaux ne sont pas pris en charge.

Sous Configurer la source de données, renseignez les paramètres à l’aide des informations contenues dans le tableau suivant :

Paramètre Description Espace de travail Emplacement de votre espace de travail Eventstream. Sélectionnez un espace de travail dans la liste déroulante. Nom du flux d’événements Nom de votre flux d’événements. Sélectionnez un flux d’événements dans la liste déroulante. Nom de la connexion de données Nom utilisé pour référencer et gérer votre connexion de données dans votre espace de travail. Le nom de la connexion de données est automatiquement rempli. Si vous le souhaitez, vous pouvez entrer un nouveau nom. Le nom ne peut contenir que des caractères alphanumériques, des tirets et des points, et comporter jusqu’à 40 caractères. Traiter l’événement avant l’ingestion dans Eventstream Cette option vous permet de configurer le traitement des données avant l’ingestion des données dans la table de destination. Si cette option est sélectionnée, vous poursuivez le processus d’ingestion des données dans Eventstream. Pour plus d’informations, consultez Processus des événements avant l’ingestion dans Eventstream. filtres avancés Compression Compression des données des événements, à partir du hub d’événements. Les options sont None (valeur par défaut) ou la compression Gzip. Propriétés du système d’événements S’il existe plusieurs enregistrements par message d’événement, les propriétés système sont ajoutées au premier. Pour plus d’informations, consultez les propriétés du système d’événements . Date de début de la récupération d’événements La connexion de données récupère les événements existants créés depuis la date de début de la récupération d’événements. Il peut uniquement récupérer les événements conservés par le hub d’événements, en fonction de sa période de rétention. Le fuseau horaire est UTC. Si aucune heure n’est spécifiée, l’heure par défaut est l’heure à laquelle la connexion de données est créée. Sélectionnez Suivant

Traiter l’événement avant l’ingestion dans Eventstream

L’événement Process avant l’ingestion dans Eventstream vous permet de traiter les données avant d’être ingérées dans la table de destination. Avec cette option, le processus d’obtention des données continue en toute transparence dans Eventstream, avec les détails de la table de destination et de la source de données automatiquement renseignés.

Pour traiter l’événement avant l’ingestion dans Eventstream :

Sous l’onglet Configuration, sélectionnez Traiter l'événement avant l'ingestion dans Eventstream.

Dans la boîte de dialogue Traiter les événements dans Eventstream, sélectionnez Continuer dans eventstream.

Important

La sélection de Continuer dans Eventstream met fin au processus d’obtention des données dans Real-Time Intelligence et continue dans Eventstream avec les détails de la table de destination et de la source de données automatiquement renseignés.

Dans Eventstream, sélectionnez le nœud de destination base de données KQL et, dans le volet base de données KQL, vérifiez que traitement des événements avant l’ingestion est sélectionné et que les détails de destination sont corrects.

Sélectionnez Ouvrir le processeur d’événements pour configurer le traitement des données, puis sélectionnez Enregistrer. Pour plus d’informations, consultez Traiter les données d’événement avec l’éditeur de processeur d’événements.

De retour dans le volet base de données KQL, sélectionnez Ajouter pour terminer la configuration du nœud de destination de la base de données KQL .

Vérifiez que les données sont ingérées dans la table de destination.

Remarque

L’événement de processus avant l’ingestion dans le processus Eventstream est terminé et les étapes restantes de cet article ne sont pas requises.

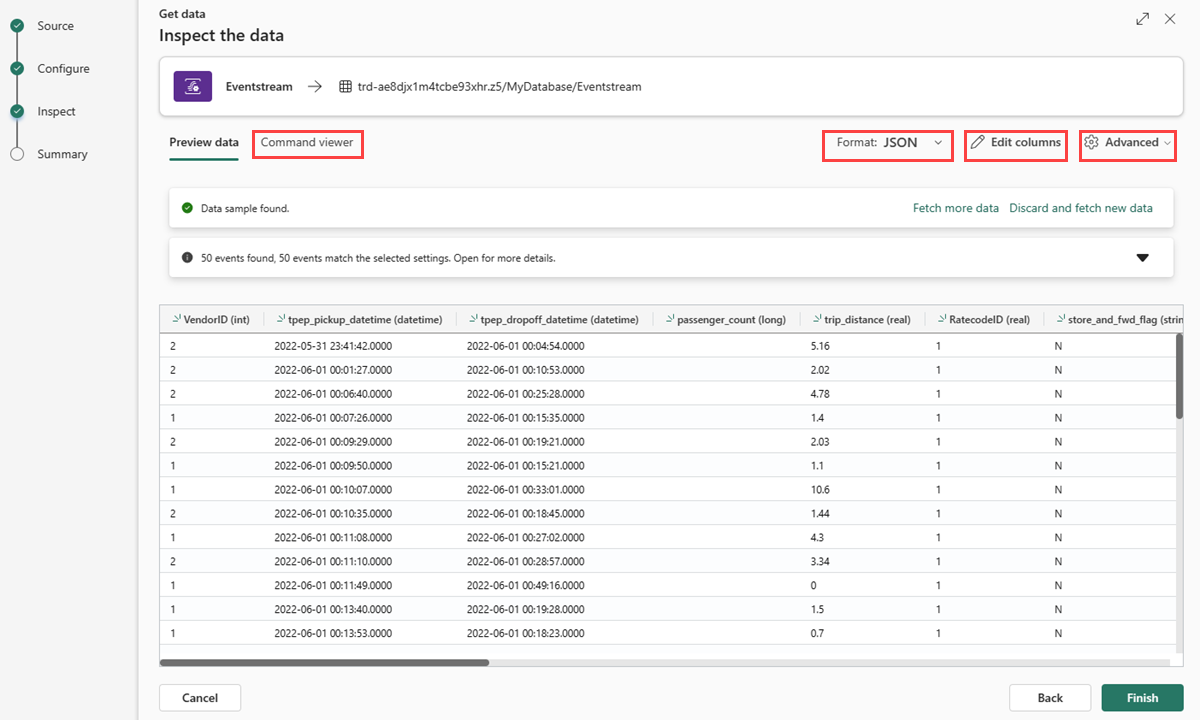

Inspecter

L’onglet Inspecter s’ouvre avec un aperçu des données.

Pour terminer le processus d’ingestion, sélectionnez Terminer.

Optionnellement:

- Sélectionnez Visionneuse de commandes pour afficher et copier les commandes automatiques générées à partir de vos entrées.

- Modifiez le format de données déduit automatiquement en sélectionnant le format souhaité dans la liste déroulante. Les données sont lues à partir du hub d’événements sous la forme d’objets EventData. Les formats pris en charge sont CSV, JSON, PSV, SCsv, SOHsv TSV, TXT et TSVE.

- Modifier les colonnes.

- Explorez les options avancées basées sur le type de données.

Modifier les colonnes

Remarque

- Pour les formats tabulaires (CSV, TSV, PSV), vous ne pouvez pas mapper une colonne deux fois. Pour mapper à une colonne existante, commencez par supprimer la nouvelle colonne.

- Vous ne pouvez pas modifier un type de colonne existant. Si vous essayez de mapper à une colonne avec un format différent, vous risquez de vous retrouver avec des colonnes vides.

Les modifications que vous pouvez apporter dans une table dépendent des paramètres suivants :

- Si le type de la table est nouveau ou existant

- Si le type du mappage est nouveau ou existant

| Type de la table | Type de mappage | Ajustements disponibles |

|---|---|---|

| Nouvelle table | Nouveau mappage | Renommer une colonne, modifier le type de données, modifier la source de données, transformation de mappage, ajouter une colonne, supprimer une colonne |

| Table existante | Nouveau mappage | Ajouter une colonne (sur laquelle vous pouvez ensuite modifier le type de données, renommer et mettre à jour) |

| Table existante | Cartographie existante | aucun |

Mappage des transformations

Certaines correspondances de formats de données (Parquet, JSON et Avro) prennent en charge des transformations simples au moment de l'ingestion. Pour appliquer des transformations de mappage, créez ou mettez à jour une colonne dans la fenêtre Modifier les colonnes.

Les transformations de mappage peuvent être effectuées sur une colonne de type chaîne ou datetime, avec la source ayant un type de données int ou long. Les transformations de mappage prises en charge sont les suivantes :

- DateTimeFromUnixSeconds

- DateTimeFromUnixMilliseconds

- DateTimeFromUnixMicroseconds

- DateTimeFromUnixNanoseconds

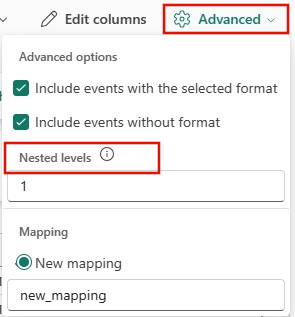

Options avancées basées sur le type de données

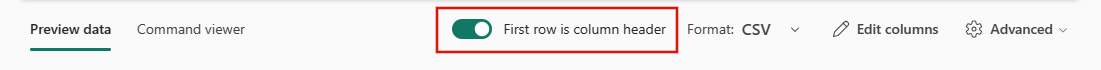

Tabulaire (CSV, TSV, PSV) :

Les données tabulaires n’incluent pas nécessairement les noms de colonnes utilisés pour mapper les données sources aux colonnes existantes. Pour utiliser la première ligne comme noms de colonnes, activez Première ligne est l’en-tête de colonne.

JSON :

Pour déterminer la division des colonnes des données JSON, sélectionnez Avancé>niveaux imbriqués, de 1 à 100.

Résumé

Dans la fenêtre Préparation des données, les trois étapes sont signalées par des coches vertes quand l’ingestion des données s’est terminée avec succès. Vous pouvez sélectionner une carte à interroger, supprimer les données ingérées ou afficher un tableau de bord de votre résumé d’ingestion. Sélectionnez Fermer pour fermer la fenêtre.

Contenu connexe

- Pour gérer votre base de données, consultez Gérer les données

- Pour créer, stocker et exporter des requêtes, consultez Données de requête dans un ensemble de requêtes KQL