Ajouter Apache Kafka en tant que source dans Fabric Real-Time Hub (préversion)

Cet article explique comment ajouter Apache Kafka en tant que source de l’événement dans le hub en temps réel Fabric.

Prérequis

- Accès à un espace de travail en mode licence de capacité Fabric ou en mode licence d’évaluation avec des autorisations Contributeur ou supérieures.

- Un cluster Apache Kafka en cours d’exécution.

- Votre Apache Kafka doit être accessible au public et ne pas se trouver derrière un pare-feu ou sécurisé dans un réseau virtuel.

Page Sources de données

Connectez-vous à Microsoft Fabric.

Sélectionnez En temps réel dans la barre de navigation gauche.

Sur la page Hub en temps réel, sélectionnez + Sources de données sous Se connecter à dans le menu de navigation de gauche. Vous pouvez également accéder à la page Sources de données à partir des pages Tous les flux de données ou Mes flux de données en sélectionnant le bouton + Se connecter à la source de données dans le coin supérieur droit.

Ajouter Apache Kafka en tant que source

Voici les étapes à suivre pour ajouter une rubrique Apache Kafka en tant que source dans Fabric Real-Time hub.

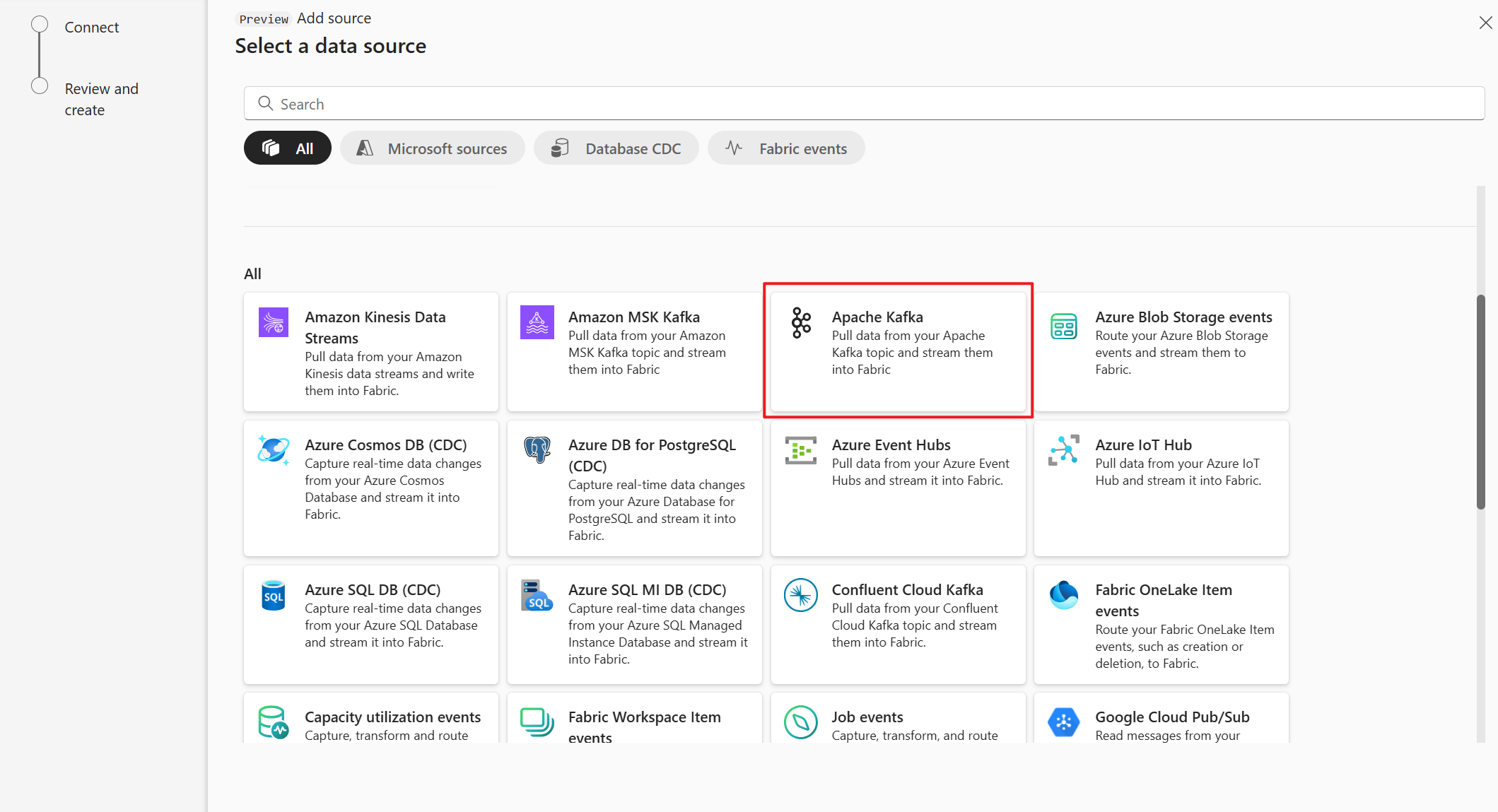

Sur la page Sélectionner une source de données, sélectionnez Apache Kafka.

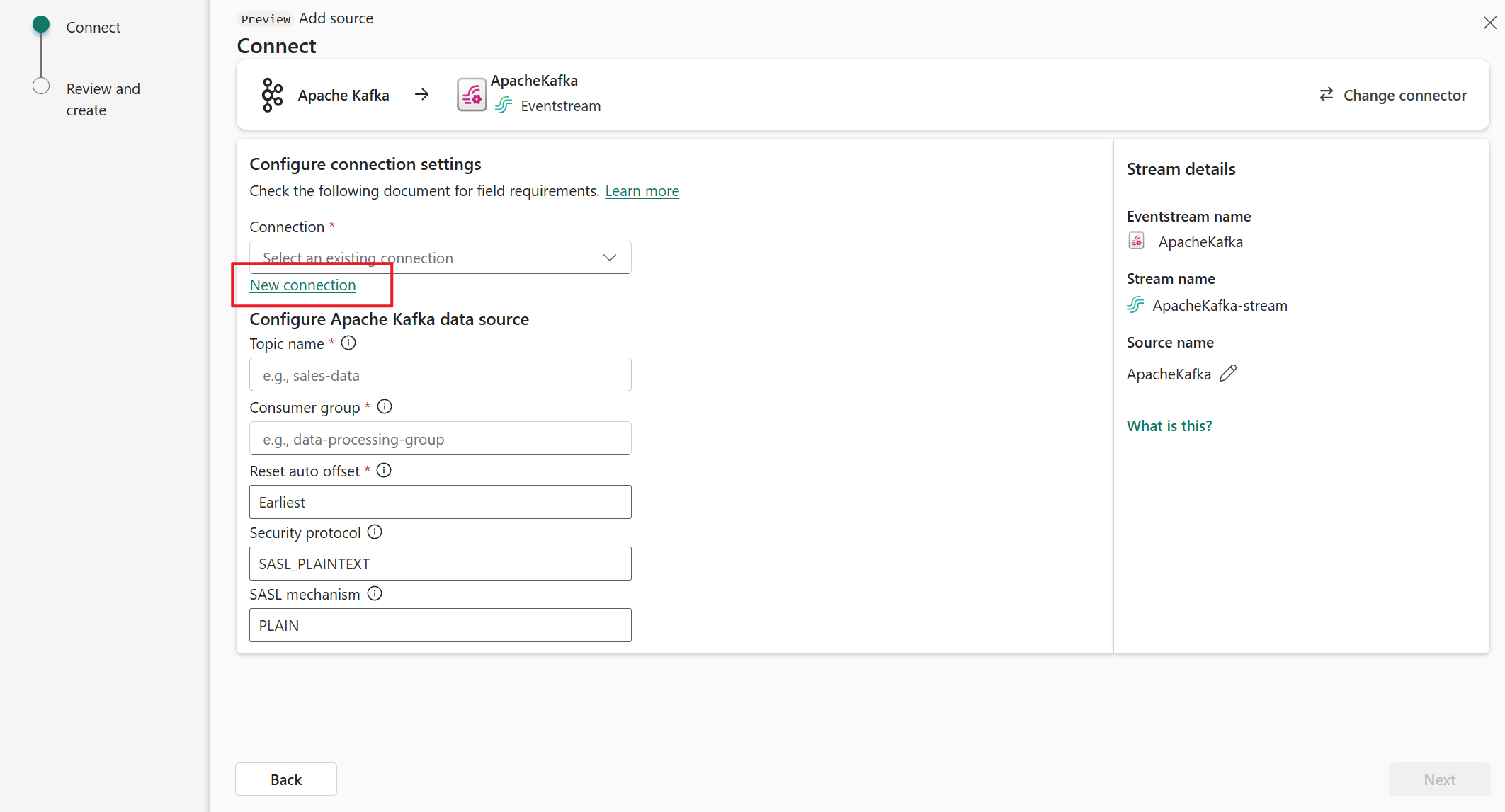

Sur la page Connecter, sélectionnez Nouvelle connexion.

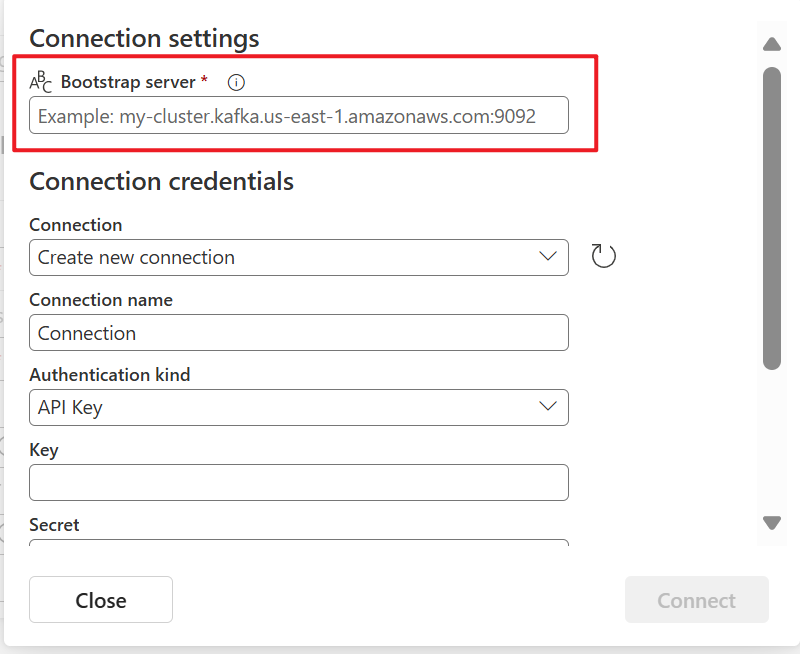

Dans la section Paramètres de connexion, pour Serveur de démarrage, entrez l’adresse de votre serveur Apache Kafka.

Dans la section Informations d’identification de la connexion, si vous avez une connexion existante au cluster Apache Kafka, sélectionnez-la dans la liste déroulante de Connexion. Dans le cas contraire, procédez ainsi :

- Dans le champ Nom de la connexion, saisissez un nom pour la connexion.

- Pour Type d’authentification, confirmez que Clé API est sélectionné.

- Pour Clé et Secret, entrez la clé API et la clé secrète.

Sélectionnez Connecter.

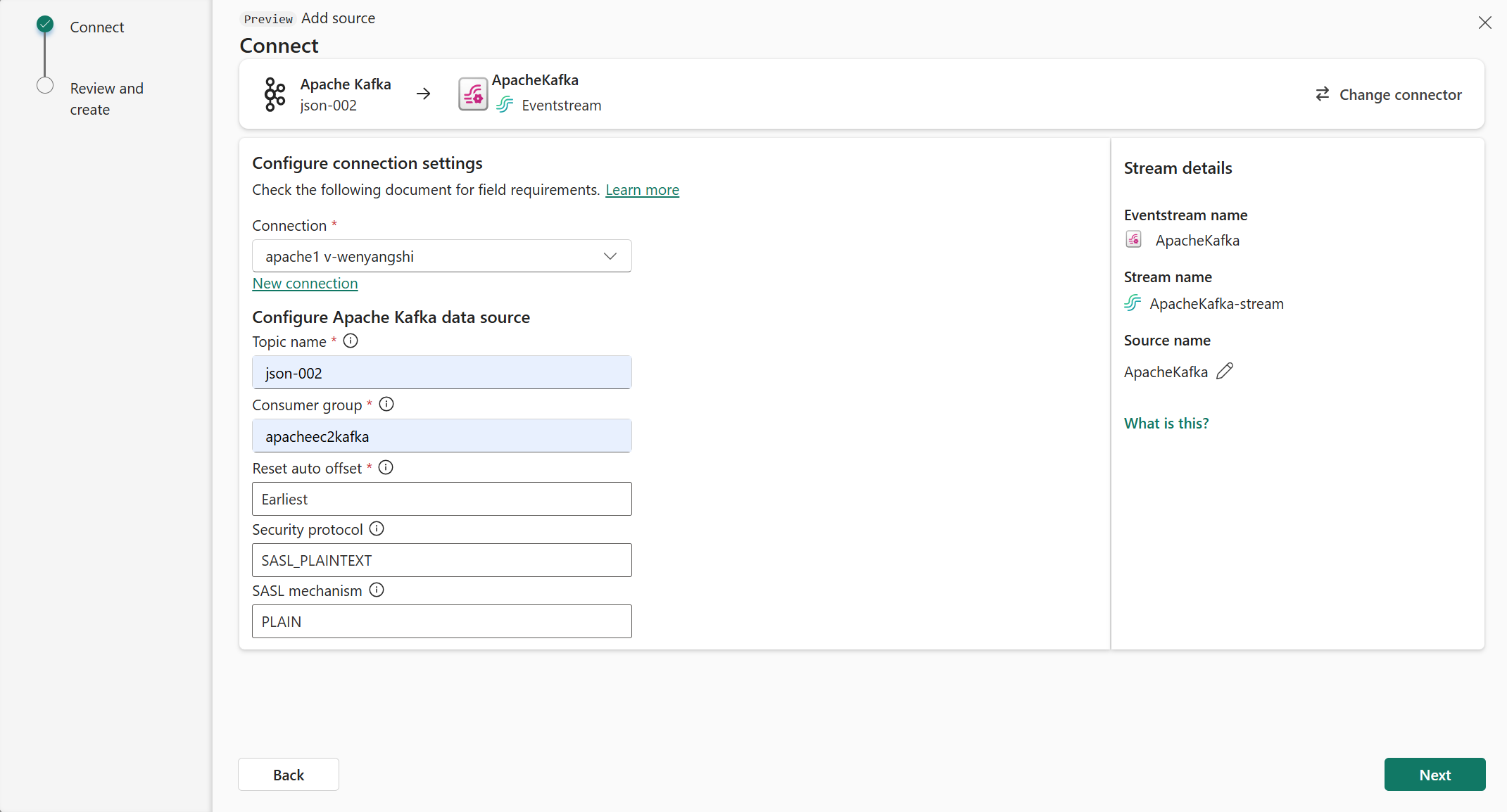

À présent, dans la page Se connecter, procédez comme suit.

Pour Rubrique, entrez la rubrique Kafka.

Pour le Groupe consommateur, entrez le groupe de consommateurs de votre cluster Apache Kafka. Ce champ vous fournit un groupe de consommateurs dédié pour obtenir des événements.

Sélectionnez Réinitialiser le décalage automatique pour spécifier où démarrer les décalages de lecture s’il n’y a pas de validation.

Pour le protocole de sécurité, la valeur par défaut est SASL_PLAINTEXT.

Remarque

La source Apache Kafka prend actuellement en charge uniquement la transmission de données non chiffrée (SASL_PLAINTEXT et PLAINTEXT) entre votre cluster Apache Kafka et Eventstream. La prise en charge de la transmission de données chiffrées via SSL sera bientôt disponible.

Le mécanisme SASL par défaut est généralement PLAIN, sauf configuration contraire. Vous pouvez sélectionner le mécanisme SCRAM-SHA-256 ou SCRAM-SHA-512 qui répond à vos besoins de sécurité.

Cliquez sur Suivant. Dans l’écran Vérifier et créer, passez en revue le résumé, puis sélectionnez Ajouter.

Afficher les détails du flux de données

Sur la page Vérifier + se connecter, si vous sélectionnez Ouvrir l’eventstream, l’assistant ouvre l’eventstream qu’il a créé pour vous avec la source Apache Kafka sélectionnée. Pour fermer l’assistant, sélectionnez Fermer au bas de la page.

Dans le hub en temps réel, basculez vers l’onglet Flux de données du hub en temps réel. Actualisez la page. Vous devriez voir le flux de données créé pour vous.

Pour obtenir des étapes détaillées, consultez Afficher les détails des flux de données dans le hub En temps réel de Fabric.

Contenu connexe

Pour en savoir plus sur l’utilisation de flux de données, consultez les articles suivants :