Qu’est-ce que Science des données dans Microsoft Fabric ?

Microsoft Fabric offre des expériences Science des données pour permettre aux utilisateurs d’effectuer des workflows de science des données de bout en bout à des fins d’enrichissement des données et d’insights métier. Vous pouvez effectuer un large éventail d’activités dans l’ensemble du processus de science des données, allant de l’exploration, de la préparation et du nettoyage des données à l’expérimentation, à la modélisation, au scoring des modèles et à la distribution d’insights prédictifs aux rapports décisionnels.

Les utilisateurs de Microsoft Fabric peuvent accéder à une page d’accueil Science des données. À partir de là, ils peuvent découvrir et accéder à diverses ressources pertinentes. Par exemple, ils peuvent créer des expériences, des modèles et des notebooks de machine learning. Ils peuvent également importer des Notebooks existants sur la Page d'accueil Science des données.

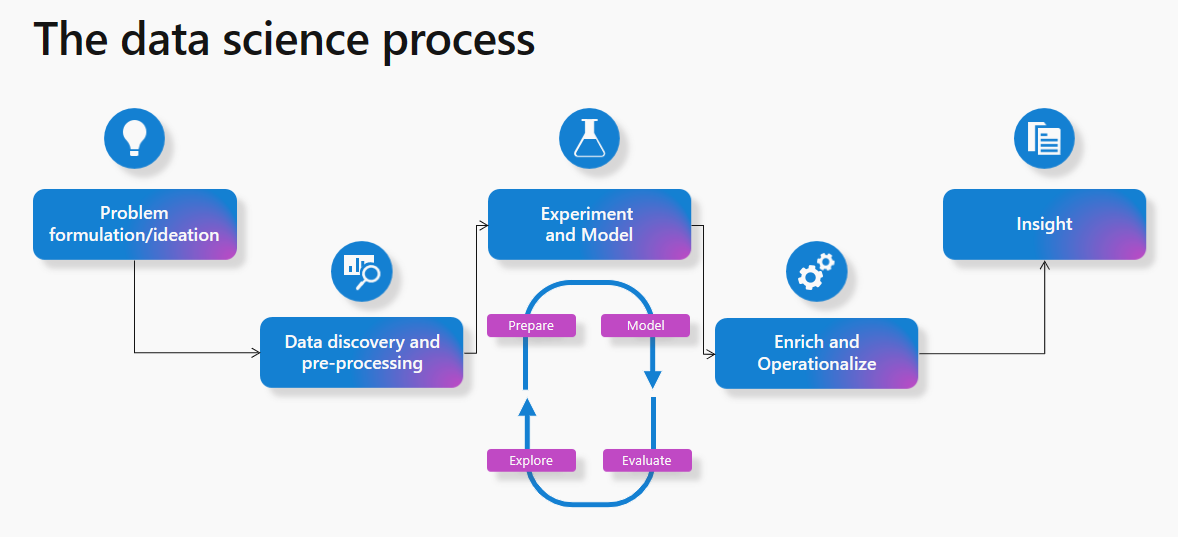

Vous savez peut-être comment fonctionne un processus de science des données classique. En tant que processus bien connu, la plupart des projets machine learning le suivent.

À un niveau élevé, le processus implique les étapes suivantes :

- Formulation et idéation du problème

- Découverte et prétraitement des données

- Expérimentation et modélisation

- Enrichir et opérationnaliser

- Obtenir des informations

Cet article décrit les fonctionnalités de Microsoft Fabric Science des données du point de vue du processus de science des données. Pour chaque étape du processus de science des données, cet article résume les fonctionnalités de Microsoft Fabric qui peuvent vous aider.

Formulation et idéation du problème

Les utilisateurs Science des données de Microsoft Fabric travaillent sur la même plateforme que les utilisateurs professionnels et les analystes. Le partage de données et la collaboration deviennent ainsi plus transparents entre différents rôles. Les analystes peuvent facilement partager des rapports et des jeux de données Power BI avec des professionnels de la science des données. La facilité de collaboration entre les rôles dans Microsoft Fabric simplifie grandement les transitions pendant la phase de formulation des problèmes.

Découverte et prétraitement des données

Les utilisateurs de Microsoft Fabric peuvent interagir avec des données dans OneLake à l’aide de l’élément Lakehouse. Lakehouse s’attache facilement à un notebook pour parcourir et interagir avec les données.

Les utilisateurs peuvent facilement lire les données d’un Lakehouse directement dans un dataframe Pandas. Pour l’exploration, cela permet de lire des données transparentes à partir de OneLake.

Un ensemble puissant d’outils existe pour l’ingestion des données et les pipelines d’orchestration des données avec des pipelines d’intégration de données, une partie intégrée en mode natif de Microsoft Fabric. Les pipelines de données faciles à créer peuvent accéder aux données et les transformer dans un format que le Machine Learning peut utiliser.

Exploration des données

Une partie importante du processus de Machine Learning consiste à comprendre les données grâce à l’exploration et à des visualisations.

En fonction de l'emplacement de stockage des données, Microsoft Fabric offre un ensemble d'outils différents pour explorer et préparer les données pour l'analyse et l'apprentissage automatique. Les notebooks deviennent l’un des moyens les plus rapides de commencer à explorer les données.

Apache Spark et Python pour la préparation des données

Microsoft Fabric offre des capacités de transformation, de préparation et d'exploration de vos données à grande échelle. Avec Spark, les utilisateurs peuvent tirer parti des outils PySpark/Python, Scala et SparkR/SparklyR pour le prétraitement des données à grande échelle. De puissantes bibliothèques de visualisation open source peuvent améliorer l’expérience d’exploration des données pour mieux comprendre les données.

Data Wrangler pour un nettoyage transparent des données

L’expérience Notebook de Microsoft Fabric a ajouté une fonctionnalité permettant d’utiliser Data Wrangler, un outil de codage pour préparer les données et générer du code Python. Cette expérience facilite l’accélération des tâches fastidieuses et banales, par exemple le nettoyage des données et la création de la répétabilité et de l’automatisation par le biais du code généré. Pour en savoir plus sur Data Wrangler, consultez la section Data Wrangler de ce document.

Expérimentation et modélisation ML

Avec des outils tels que PySpark/Python, SparklyR/R, les notebooks peuvent gérer l’apprentissage des modèles Machine Learning.

Les bibliothèques et algorithmes ML peuvent aider à former des modèles Machine Learning. Les outils de gestion de bibliothèque peuvent installer ces bibliothèques et algorithmes. Les utilisateurs ont donc la possibilité de tirer parti d’une grande variété de bibliothèques de Machine Learning populaires pour suivre leur formation de modèle ML dans Microsoft Fabric.

En outre, les bibliothèques populaires comme Scikit Learn peuvent également développer des modèles.

Les expériences et les exécutions MLflow peuvent suivre l'apprentissage du modèle ML. Microsoft Fabric offre une expérience MLflow intégrée avec laquelle les utilisateurs peuvent interagir pour enregistrer des expériences et des modèles. En savoir plus sur l’utilisation de MLflow pour suivre des expériences et gérer des modèles dans Microsoft Fabric.

SynapseML

La bibliothèque open source SynapseML (anciennement MMLSpark), que Microsoft possède et gère, simplifie la création de pipelines d'apprentissage automatique à l'échelle massive. En tant qu’écosystème d’outils, il étend l’infrastructure Apache Spark dans plusieurs nouvelles directions. SynapseML unifie plusieurs cadres d'apprentissage automatique existants et de nouveaux algorithmes Microsoft dans une API unique et évolutive. La bibliothèque open source SynapseML comprend un riche écosystème d’outils ML pour le développement de modèles prédictifs, ainsi que pour tirer parti des modèles IA pré-formés d’Azure AI services. En savoir plus sur SynapseML.

Enrichir et opérationnaliser

Les notebooks peuvent gérer le scoring par lots de modèles Machine Learning avec des bibliothèques open source pour la prédiction, ou la fonction de prédiction Spark universelle évolutive de Microsoft Fabric, qui prend en charge les modèles empaquetés MLflow dans le registre de modèles Microsoft Fabric.

Obtenir des informations

Dans Microsoft Fabric, les valeurs prédites peuvent facilement être écrites dans OneLake et consommées en toute transparence à partir de rapports Power BI, avec le mode Direct Lake Power BI. Cela permet aux praticiens de la science des données de partager très facilement les résultats de leur travail avec les parties prenantes et simplifie également l’opérationnalisation.

Les notebooks qui contiennent le scoring par lots peuvent être planifiés pour s’exécuter à l’aide des fonctionnalités de planification des notebooks. Le scoring par lots peut également être planifié dans le cadre d’activités de pipeline de données ou de travaux Spark. Power BI obtient automatiquement les dernières prédictions sans avoir besoin de charger ou d’actualiser les données, grâce au mode Direct Lake dans Microsoft Fabric.

Exploration des données avec le lien sémantique

Les scientifiques des données et les analystes commerciaux passent beaucoup de temps à essayer de comprendre, nettoyer et transformer des données avant de commencer une analyse significative. Les analystes commerciaux travaillent généralement avec des modèles sémantiques et encodent leur connaissance du domaine et leur logique métier dans les mesures Power BI. En revanche, les scientifiques des données peuvent travailler avec les mêmes données, mais généralement dans un environnement de code ou langage différent.

Le lien sémantique permet aux scientifiques des données d’établir une connexion entre les modèles sémantiques Power BI et l’expérience Synapse Science des données dans Microsoft Fabric via la bibliothèque Python SemPy . SemPy simplifie l’analytique données en capturant et en tirant parti de la sémantique des données lorsque les utilisateurs effectuent différentes transformations sur les modèles sémantiques. En tirant parti de la liaison sémantique, les scientifiques des données peuvent :

- éviter la nécessité de réinscrire la logique métier et les connaissances de domaine dans leur code

- accéder et utiliser facilement des mesures Power BI dans leur code

- utiliser la sémantique pour alimenter de nouvelles expériences, telles que des fonctions sémantiques

- explorer et valider des dépendances fonctionnelles et des relations entre les données

Grâce à l’utilisation de SemPy, les organisations peuvent s’attendre à voir :

- une productivité accrue et une collaboration plus rapide entre les équipes qui opèrent sur les mêmes jeux de données

- collaboration croisée accrue entre les équipes d'intelligence d'affaires et d'intelligence artificielle

- une réduction de l’ambiguïté et une courbe d’apprentissage plus facile lors de l’intégration à un nouveau modèle ou à un nouveau jeu de données

Pour plus d’informations sur le lien sémantique, consultez la Présentation du lien sémantique.

Contenu connexe

- Commencez avec des exemples complets de science des données, consultez les tutoriels de science des données

- En savoir plus sur la préparation et le nettoyage des données avec Data Wrangler. Consultez Data Wrangler

- Pour en savoir plus sur le suivi des expériences, consultez Expérience Machine Learning

- En savoir plus sur la gestion des modèles, consultez Modèle Machine Learning

- En savoir plus sur le scoring par lots avec Predict, consultez Noter des modèles avec PREDICT

- Fournir des prédictions de Lakehouse à Power BI avec le mode Direct Lake