Copier de Stockage Blob Azure vers un lakehouse

Dans ce tutoriel, vous allez créer un pipeline de données pour déplacer un fichier CSV d’un dossier d’entrée d’une source Stockage Blob Azure vers une destination Lakehouse.

Prérequis

Pour commencer, vous devez remplir les conditions préalables suivantes :

Vérifiez que vous disposez d’un espace de travail avec Project Microsoft Fabric : Créer un espace de travail.

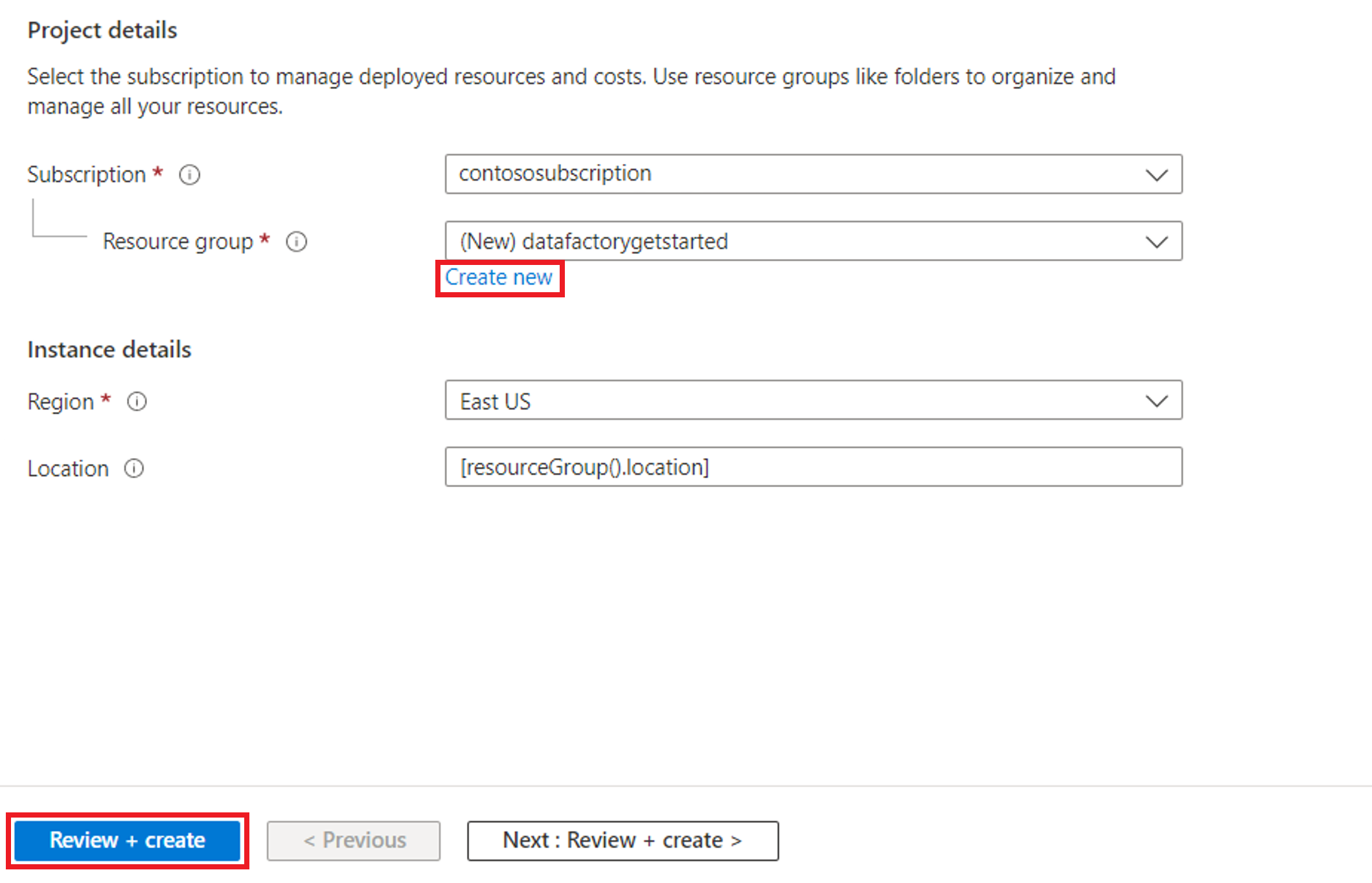

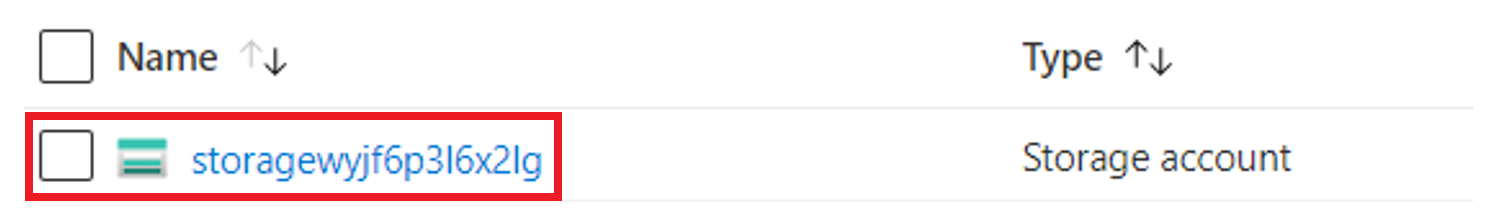

Sélectionnez le bouton Essayer maintenant ! pour préparer la source de données Stockage Blob Azure de la copie. Créez un groupe de ressources pour ce Stockage Blob Azure, puis sélectionnez Vérifier + Créer>Créer.

Ensuite, un Stockage Blob Azure est créé et moviesDB2.csv est chargé dans le dossier d’entrée du Stockage Blob Azure créé.

Créer un pipeline de données

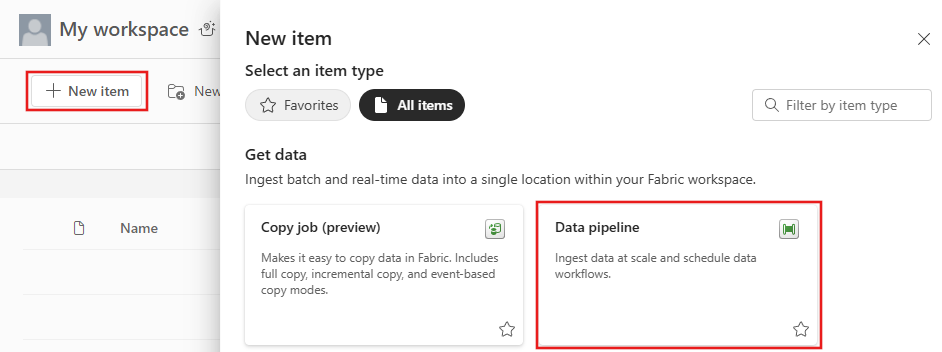

Basculez vers Fabrique de données dans la page app.powerbi.com.

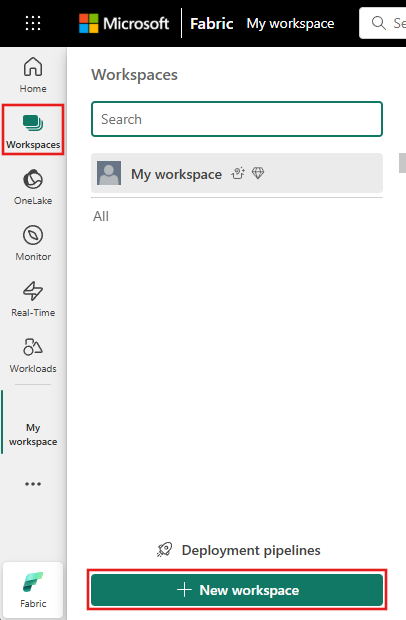

Créez un espace de travail pour cette démonstration.

Sélectionnez Nouveau, puis Pipeline de données.

Copier des données à l’aide de l’assistant de copie

Dans cette session, vous allez commencer à créer un pipeline de données en suivant ces étapes. Ces étapes copient un fichier CSV d’un dossier d’entrée d’un Stockage Blob Azure vers une destination lakehouse à l’aide de l’assistant de copie.

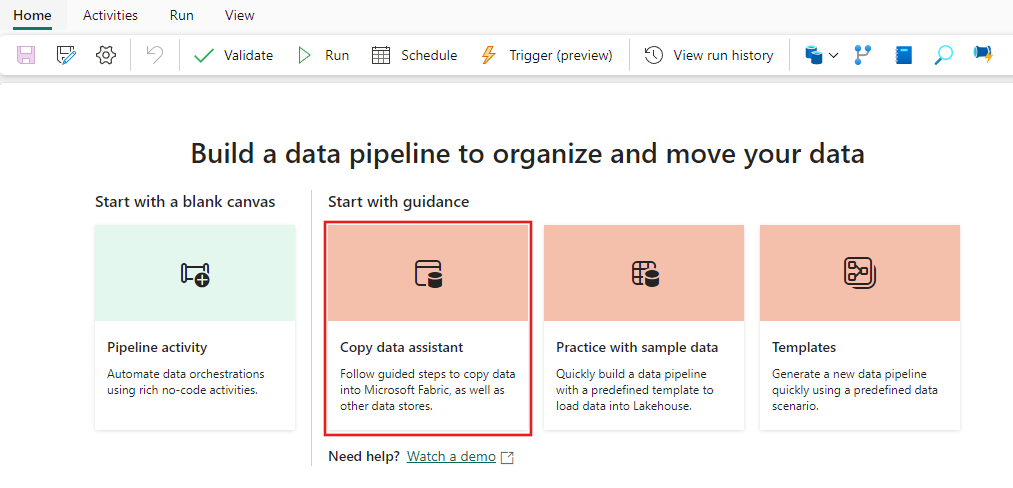

Étape 1 : démarrer avec l’assistant de copie

Sélectionnez Assistant pour copier les données sur le canevas pour ouvrir l’outil Assistant de copie pour démarrer. Vous pouvez également sélectionner Utiliser l’assistant de copie dans la liste déroulante Copier les données sous l’onglet Activités du ruban.

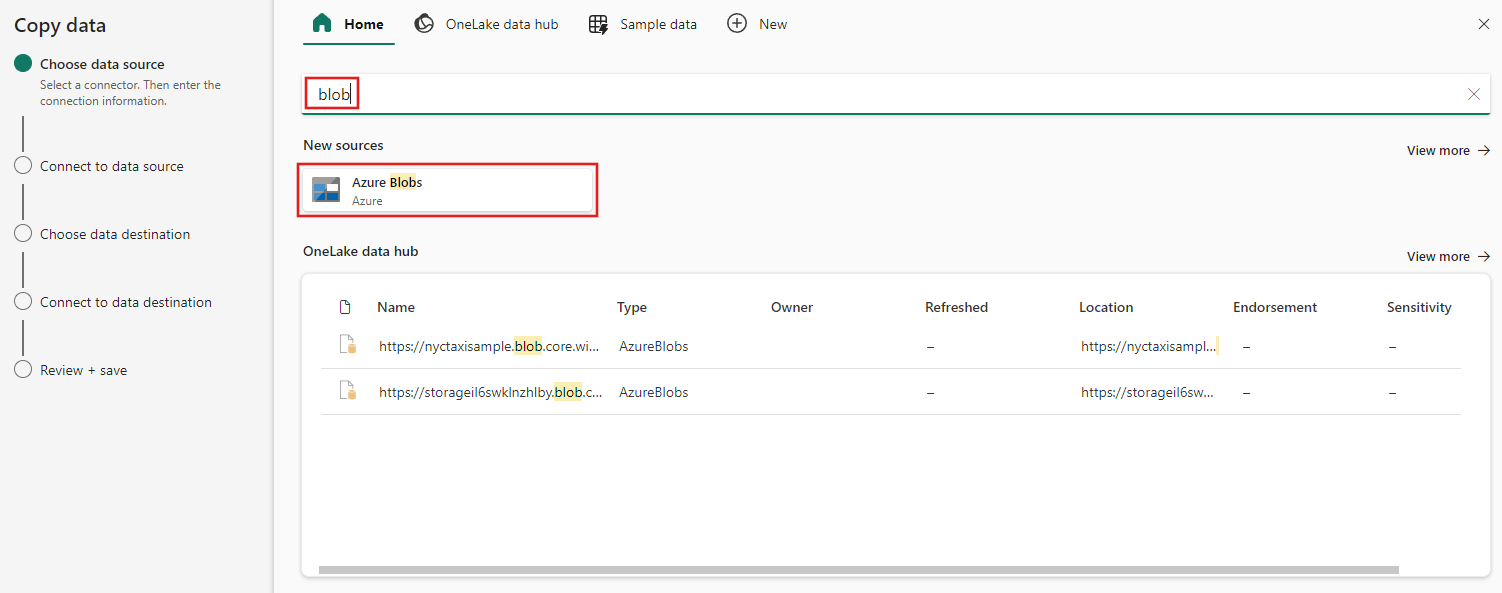

Étape 2 : configurer votre source

Saisissez objet blob dans le filtre de sélection, sélectionnez Objets blob Azure, puis cliquez sur Suivant.

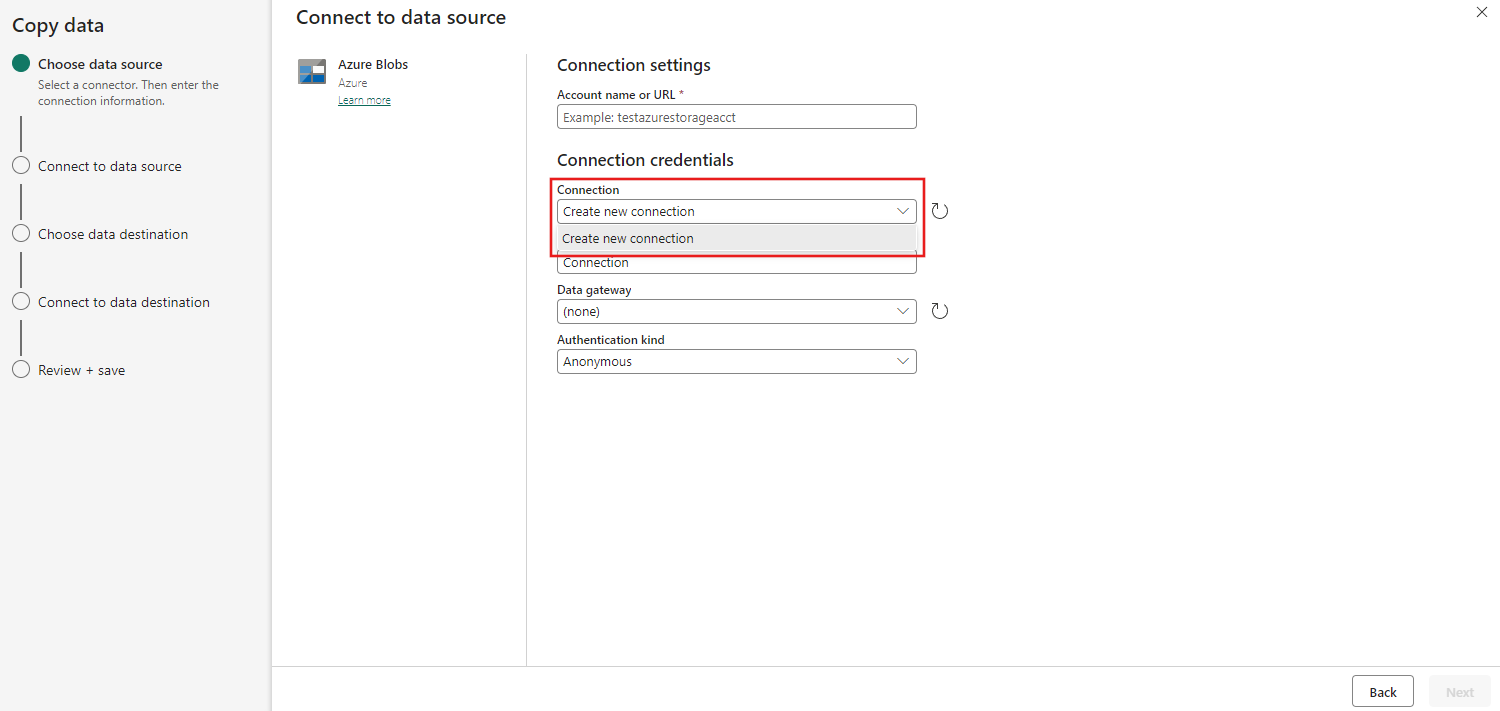

Indiquez le nom ou l’URL de votre compte, puis créez une connexion à votre source de données en sélectionnant Créer une nouvelle connexion sous la liste déroulante Connexion.

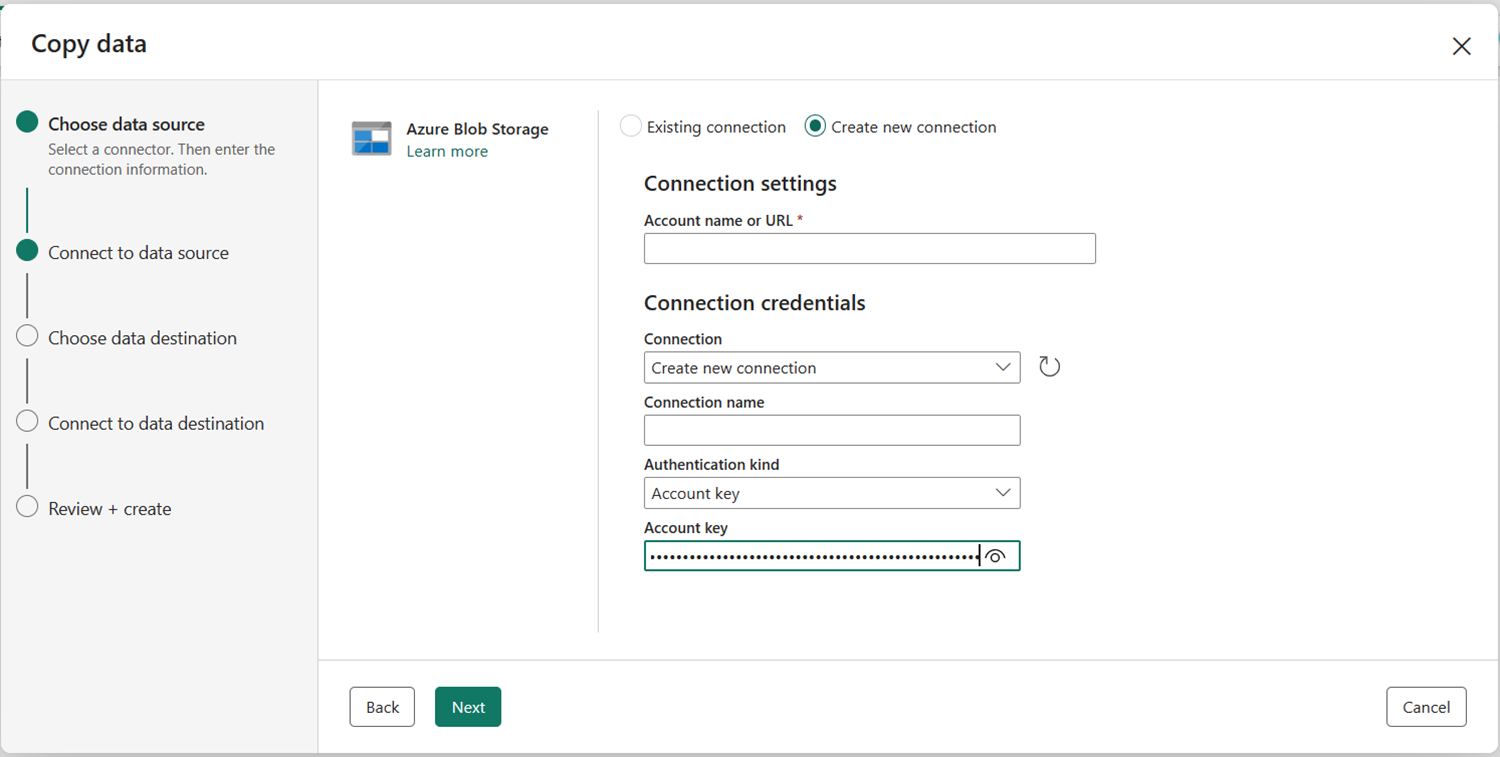

Après avoir sélectionné Créer une nouvelle connexion avec votre compte de stockage spécifié, il vous suffit de renseigner le champ Type d’authentification. Dans cette démonstration, nous allons choisir Clé de compte, mais vous pouvez choisir un autre Type d’authentification en fonction de votre préférence.

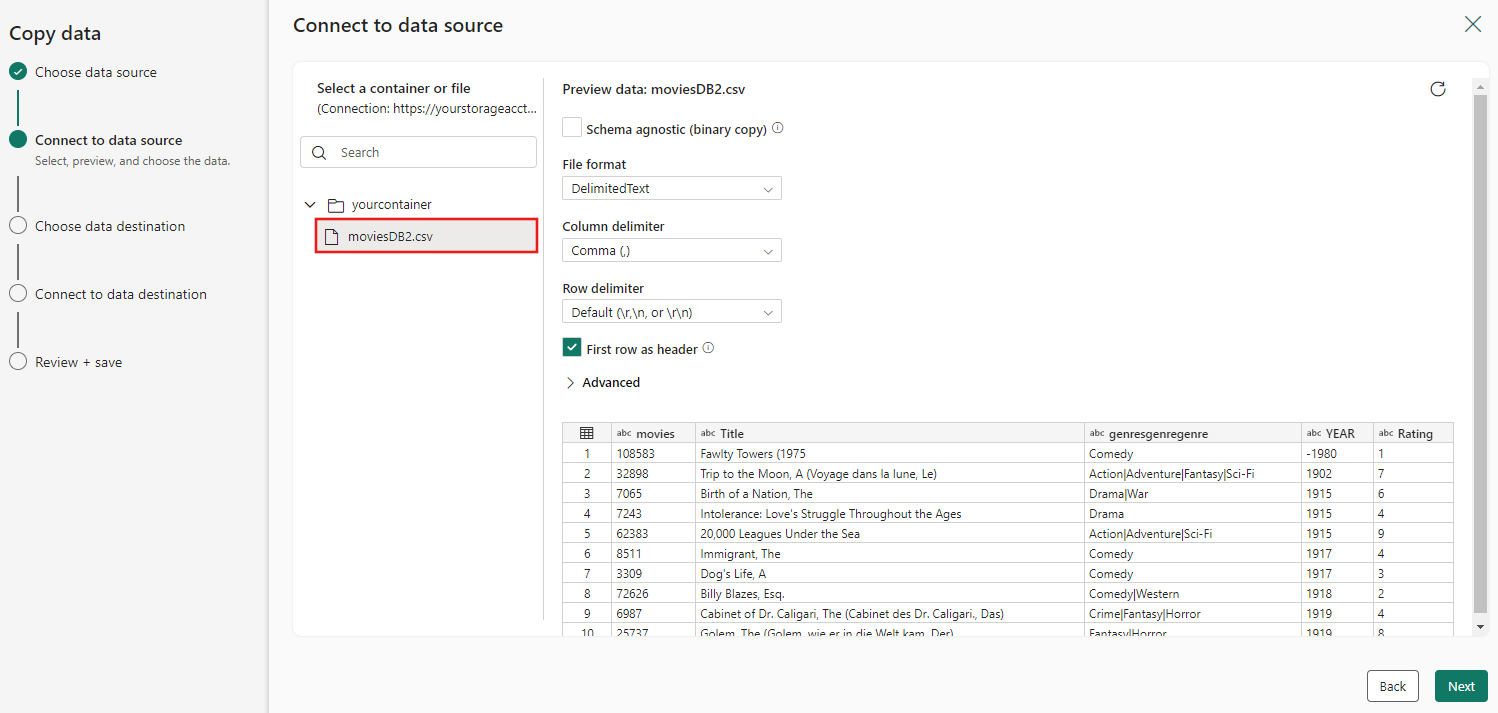

Une fois votre connexion créée, il vous suffit de sélectionner Suivant pour Se connecter à une source de données.

Choisissez le fichier moviesDB2.csv dans la configuration source pour afficher son aperçu, puis sélectionnez Suivant.

Étape 3 : configurer votre destination

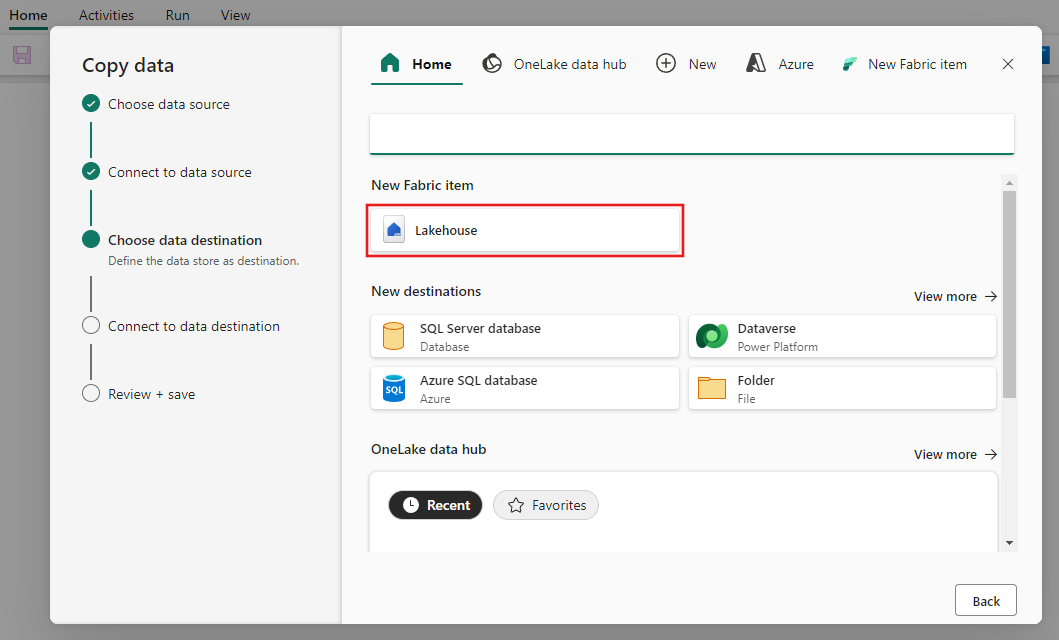

Sélectionnez Lakehouse.

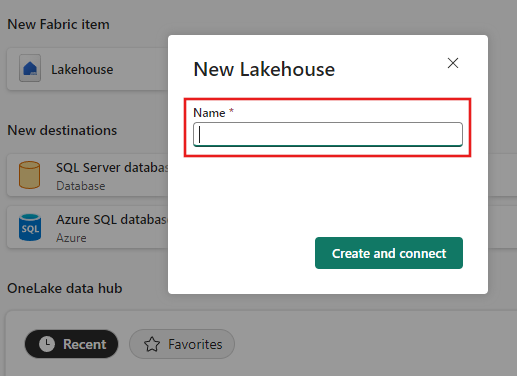

Saisissez un nom pour le nouveau Lakehouse. Sélectionnez ensuite Créer et connecter.

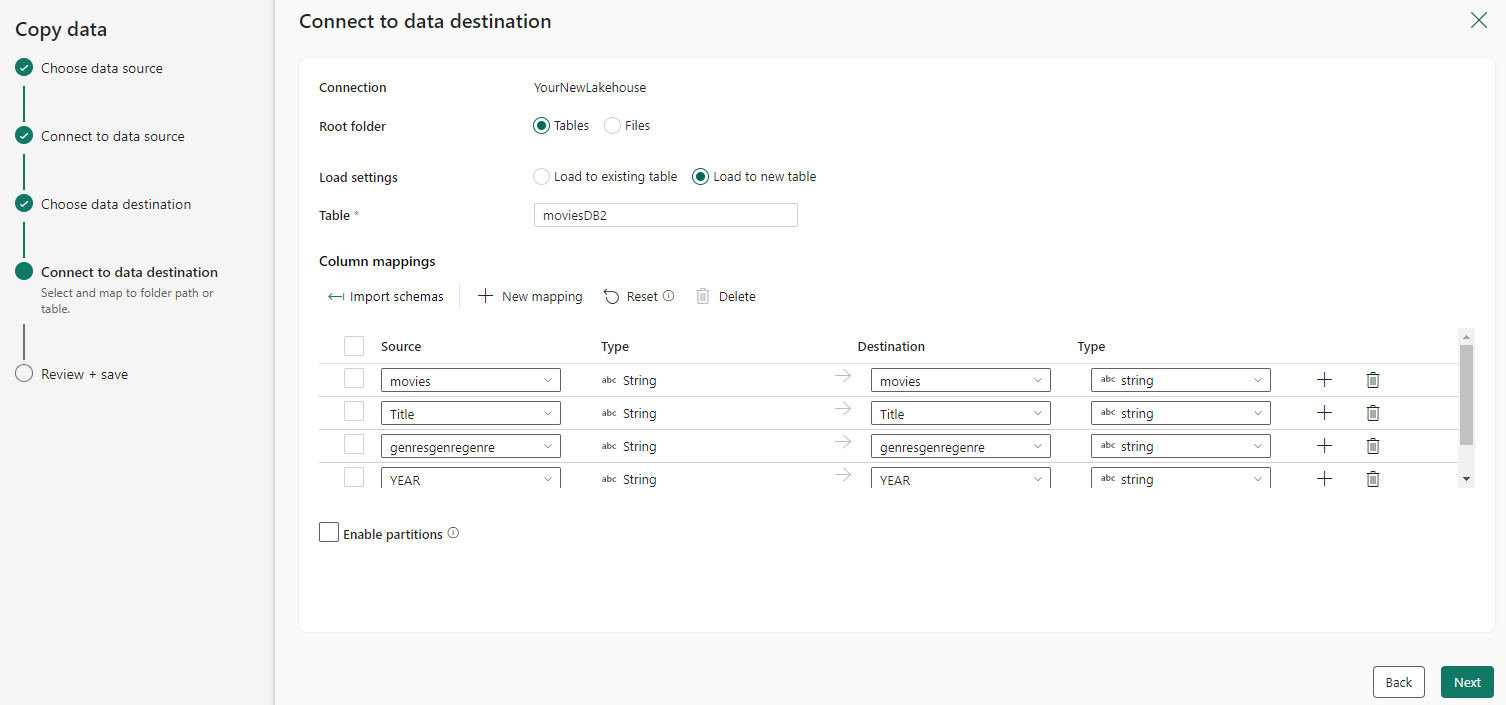

Configurez vos données sources et mappez-les à votre destination, puis sélectionnez Suivant pour terminer vos configurations de destination.

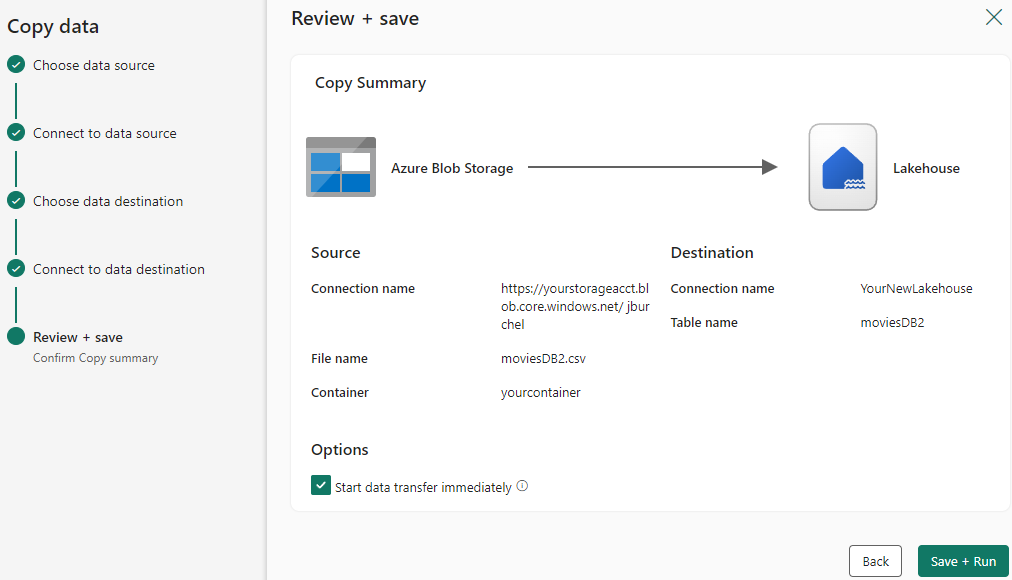

Étape 4 : vérifier et créer votre activité Copy

Passez en revue vos paramètres d’activité de copie dans les étapes précédentes, puis sélectionnez Enregistrer + Exécuter pour terminer. Vous pouvez également revenir aux étapes précédentes pour modifier vos paramètres si nécessaire dans l’outil.

Une fois l’opération terminée, l’activité de copie est ajoutée à votre canevas de pipeline de données et s’exécute directement si vous coché la case Démarrer le transfert de données immédiatement.

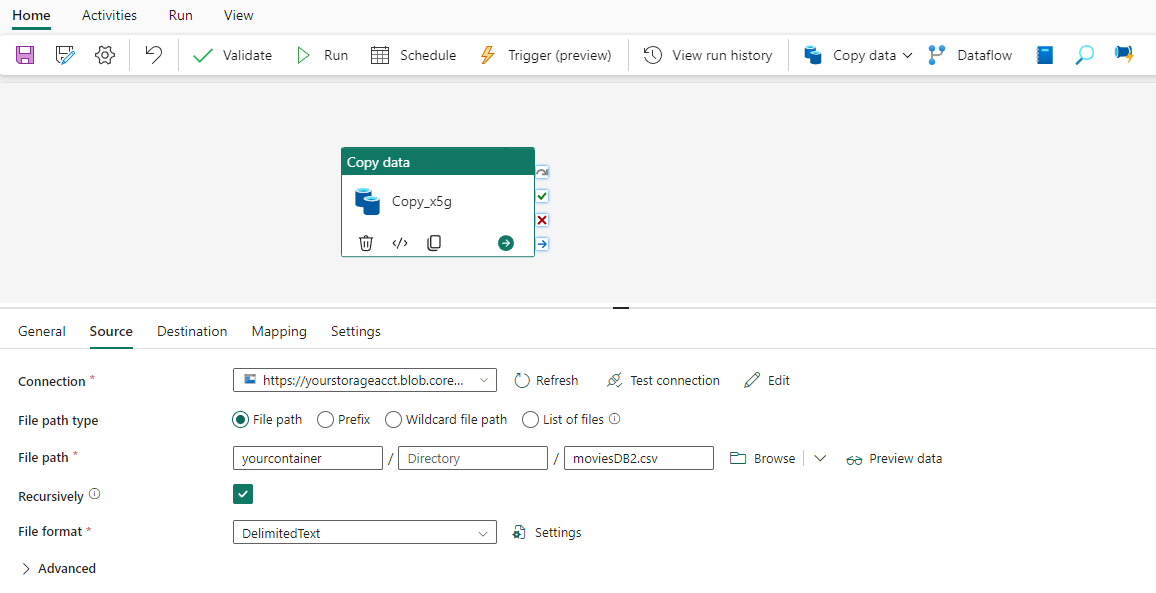

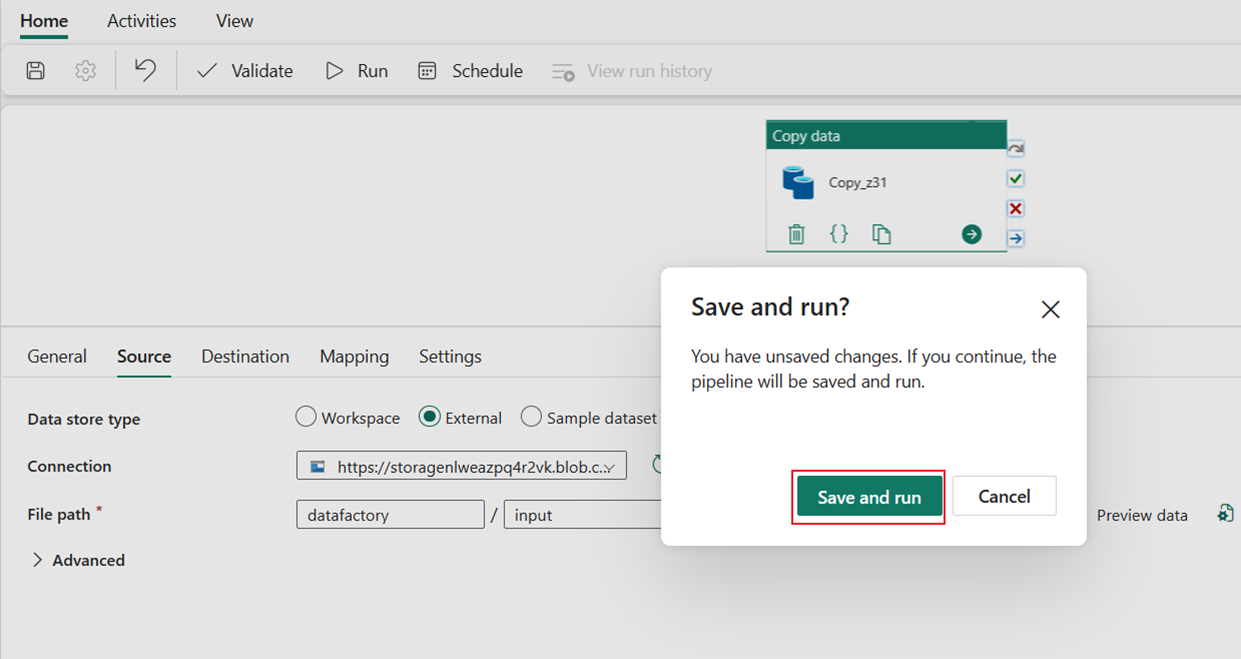

Exécuter et planifier votre pipeline de données

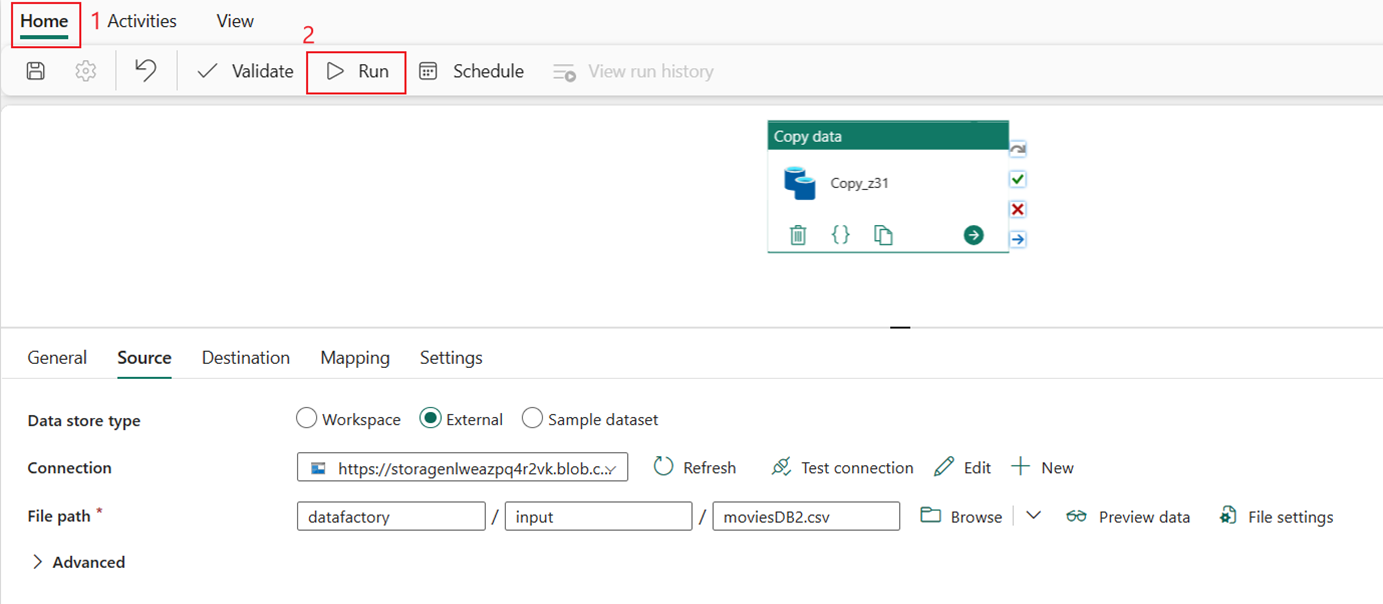

Si vous n’avez pas coché la case Démarrer le transfert de données immédiatement sur la page Revoir + Créer, basculez vers l’onglet Accueil, puis sélectionnez Exécuter. Sélectionnez ensuite Enregistrer et exécuter.

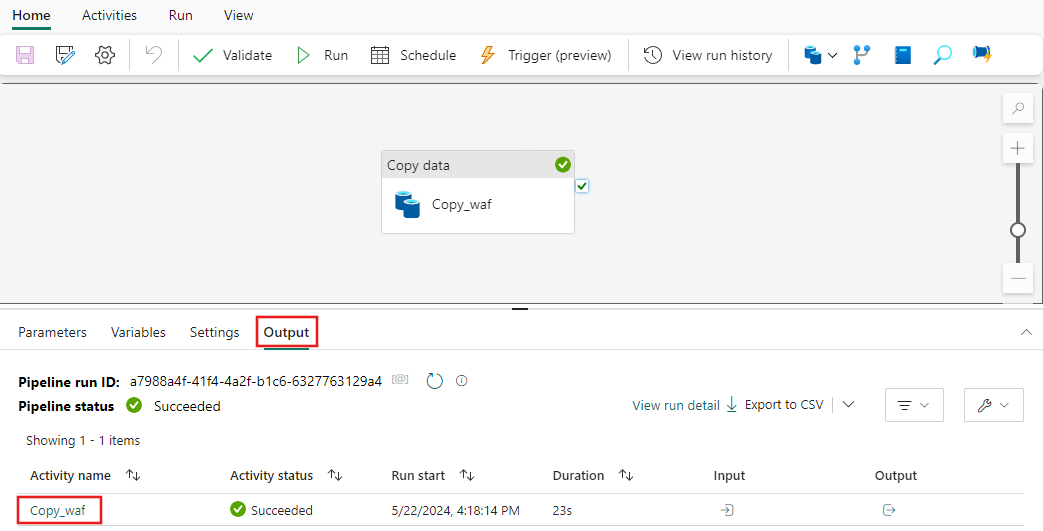

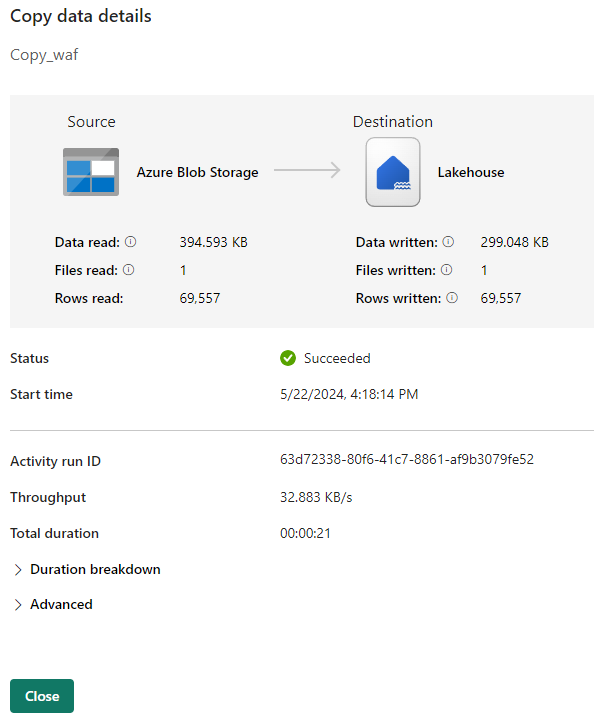

Sous l’onglet Sortie, sélectionnez le lien portant le nom de votre activité de copie pour surveiller la progression et consulter les résultats de l’exécution.

La boîte de dialogue Détails de copie des données affiche les résultats de l’exécution, y compris l’état, le volume de données lues et écrites, les heures de début et d’arrêt, et la durée.

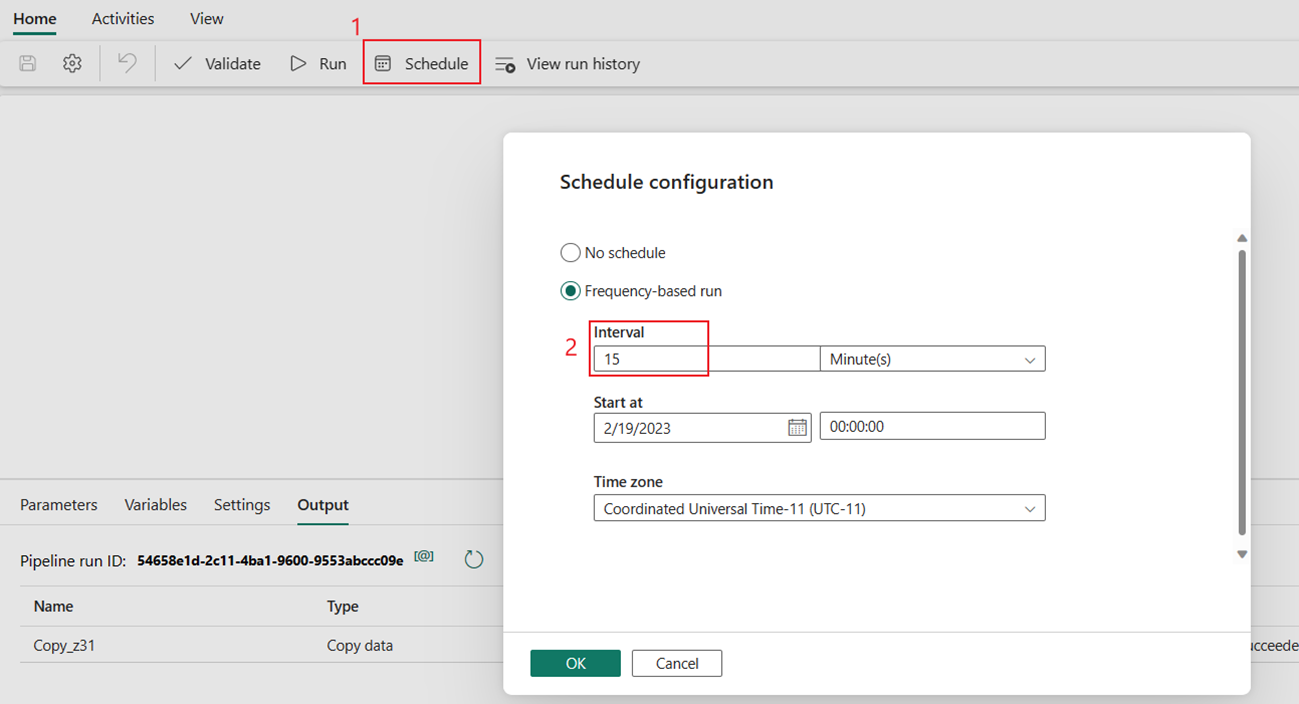

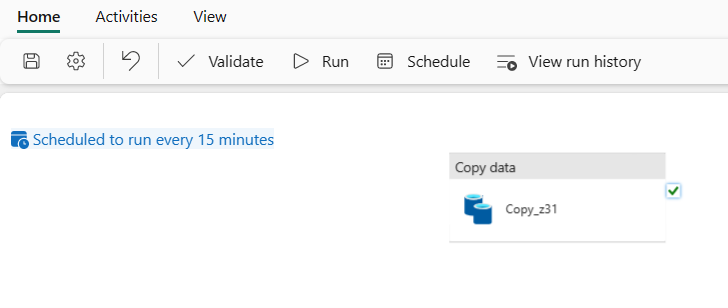

Vous pouvez également planifier l’exécution du pipeline avec une fréquence spécifique si nécessaire. L’exemple suivant montre comment planifier l’exécution du pipeline toutes les 15 minutes.

Contenu connexe

Le pipeline de cet exemple vous montre comment copier des données de Stockage Blob Azure vers Lakehouse. Vous avez appris à :

- Créer un pipeline de données.

- Copiez des données avec l’assistant de copie.

- Exécutez et planifiez votre pipeline de données.

Ensuite, avancez pour en savoir plus sur la surveillance des exécutions de votre pipeline.