Scénario de tarification utilisant Dataflow Gen2 pour charger 2 Go de données CSV locales dans une table Lakehouse

Dans ce scénario, Dataflow Gen2 est utilisé pour charger 2 Go de données CSV locales dans une table Lakehouse dans Microsoft Fabric.

Les prix utilisés dans l’exemple suivant sont hypothétiques et n’ont pas vocation à indiquer une tarification réelle exacte. Il s’agit simplement de montrer comment estimer, planifier et gérer les coûts des projets Data Factory dans Microsoft Fabric. En outre, étant donné que les capacités de Fabric sont facturées de manière unique entre les régions, nous utilisons la tarification de paiement à l’utilisation pour une capacité Fabric dans la région USA Ouest 2 (région Azure classique), à 0,18 $ par unité de capacité par heure. Reportez-vous ici à Microsoft Fabric : tarification pour explorer d’autres options de tarification de capacité Fabric.

Configuration

Pour réaliser ce scénario, vous devez créer un flux de données en suivant ces étapes :

- Initialiser le flux de données : commencez par charger des fichiers CSV de 2 Go à partir de votre environnement local dans le flux de données.

- Configurer Power Query :

- Accédez à Power Query.

- Désactivez l’option de préproduction de la requête.

- Combinez ensuite les fichiers CSV.

- Transformation des données :

- Promouvez les en-têtes pour plus de clarté.

- Supprimez les colonnes inutiles.

- Ajustez les types de données de colonne en fonction des besoins.

- Définir la destination des données de sortie :

- Configurez Lakehouse comme destination de sortie de données.

- Dans cet exemple, un Lakehouse dans Fabric a été créé et utilisé.

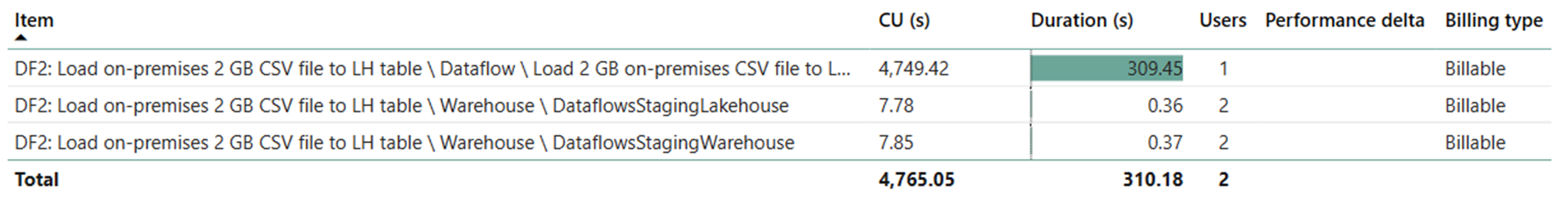

Estimation des coûts à l’aide de l’application de métriques Fabric

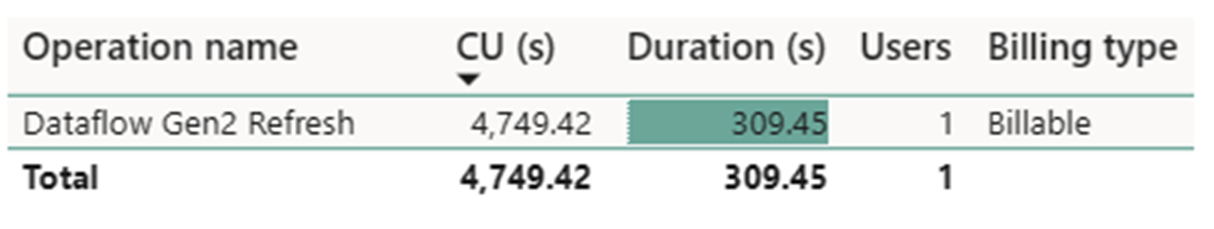

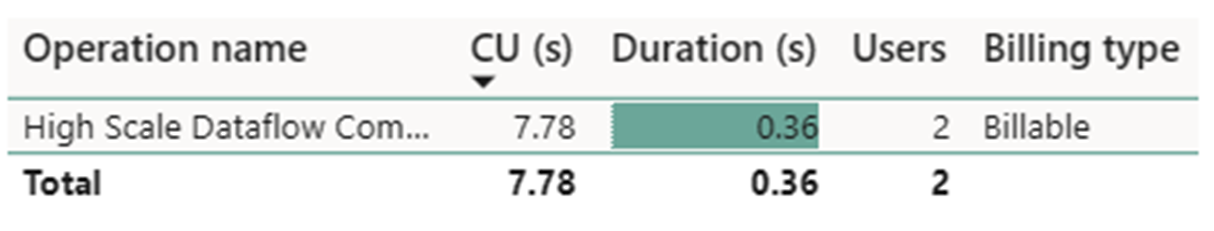

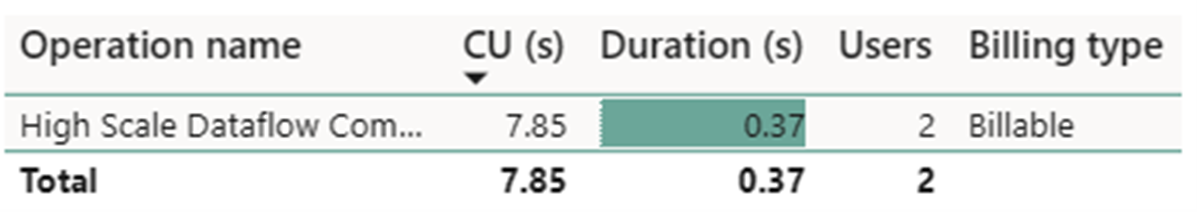

L’opération d’actualisation Dataflow Gen2 a consommé 4749,42 CU secondes, et deux opérations de calcul de flux de données à grande échelle ont consommé 7,78 CU secondes + 7,85 CU secondes chacune.

Remarque

Bien qu’elle soit signalée en tant que métrique, la durée réelle de l’exécution n’est pas pertinente lors du calcul des CU heures effectives avec l’application de métriques Fabric étant donné que la métrique CU secondes qu’elle signale est déjà comptabilisée pour sa durée.

| Métrique | Consommation de calcul |

|---|---|

| Actualisation de Dataflow Gen2 en CU secondes | 4749,42 CU secondes |

| Calcul de flux de données à grande échelle en CU secondes | (7,78 + 7,85) = 15,63 CU seconds |

| CU heures effectives facturées | (4749,42 + 15,63) / (60*60) = 1,32 CU heures |

Coût total d’exécution à 0,18 $/CU heure = (1,32 CU heures) * (0,18 $/CU heure) ~= 0,24 $