Comment ingérer des données dans Fabric à l’aide de l’activité de copie Azure Data Factory

Le connecteur Microsoft Fabric Lakehouse dans Azure Data Factory (ADF) et Azure Synapse Analytics permet d’effectuer des opérations de lecture et d’écriture dans Microsoft Fabric Lakehouse (à la fois pour les tables et les fichiers). Ce connecteur vous permet d’utiliser vos pipelines ADF et Synapse et flux de données de mappage existants pour interagir avec Fabric Lakehouses. Cet article vous aide à configurer Microsoft Fabric pour autoriser l’authentification du principal de service, puis montre le connecteur Lakehouse pour la lecture et l’écriture dans Fabric Lakehouse.

Pour plus d’informations sur Microsoft Fabric Lakehouse, consultez Qu’est-ce qu’un lakehouse ?

Connecteur Azure Data Factory Lakehouse

Un nouveau connecteur de service lié Lakehouse et deux nouveaux jeux de données sont désormais disponibles pour les clients qui souhaitent commencer à lire et écrire dans Microsoft Fabric Lakehouse. Pour obtenir un guide complet sur le connecteur Lakehouse, reportez-vous à Copier et transformer des données dans les fichiers Microsoft Fabric Lakehouse (aperçu).

Authentification

Service lié à Azure Data Factory

Le connecteur Microsoft Fabric Lakehouse nécessite un principal de service (SPN)/une inscription d’application pour l’authentification. Pour commencer, vous devez créer un nouveau SPN ou utiliser un SPN existant. Microsoft Fabric permet l’accès SPN à des groupes de sécurité spécifiques ou à l’ensemble de l’organisation. Si un groupe de sécurité spécifique est l’option utilisée par votre organisation, le SPN utilisé dans le connecteur Lakehouse doit appartenir à un groupe de sécurité ajouté à la liste autorisée.

Remarque

Les autorisations d’API Power BI (déléguées) ne sont pas nécessaires

Accès aux API Power BI

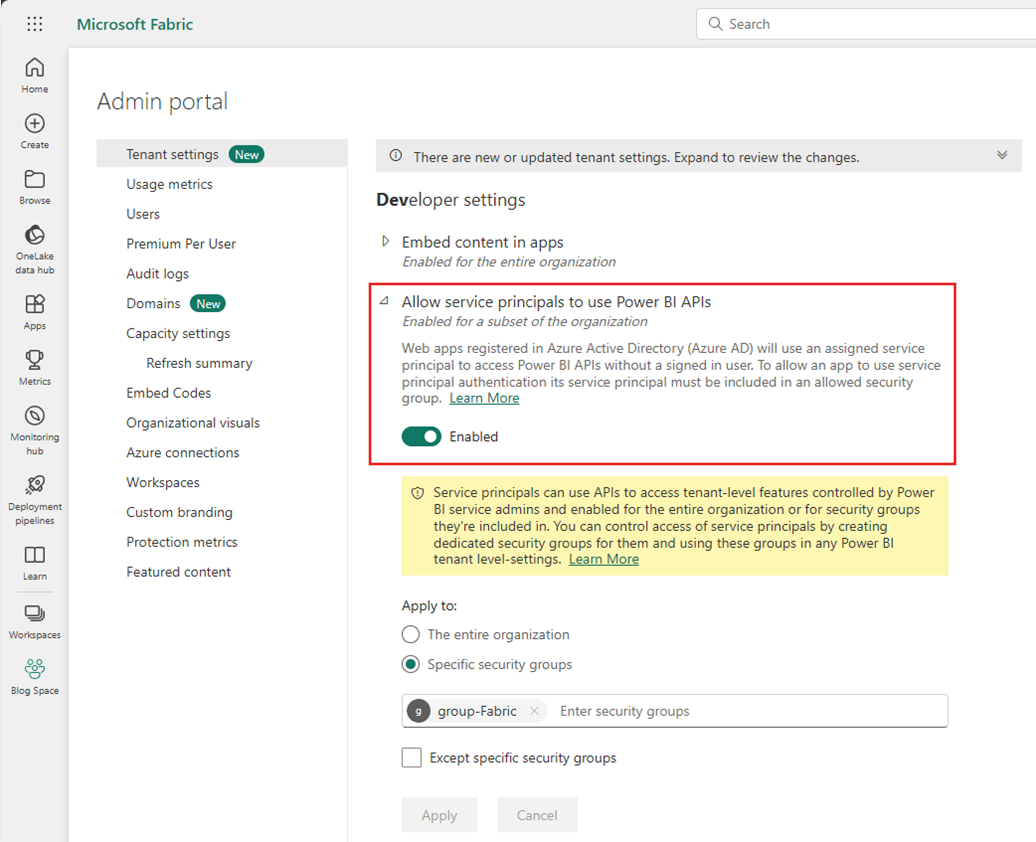

À partir du portail d’administration Power BI, l’administrateur du locataire Power BI doit activer Autoriser le principal de service à utiliser les API Power BI. Le groupe de sécurité doit être spécifié dans le paramètre Autoriser les principaux de service à utiliser les API Power BI, ou vous pouvez l'activer pour l’ensemble de l’organisation.

Pour obtenir un guide complet, reportez-vous à Intégrer du contenu Power BI dans une application d’analytique intégrée avec un principal de service et un secret d’application.

Remarque

Lors de l’affectation du groupe de sécurité à l’espace de travail, il peut y avoir un délai pour que le principal de service soit autorisé à accéder à l’espace de travail en raison de la mise en cache des autorisations dans Azure. Si vous avez besoin d’un accès immédiat, vous pouvez utiliser PowerShell pour forcer l’actualisation des autorisations de l’utilisateur. Pour ce faire, ouvrez PowerShell en tant qu’administrateur, puis exécutez les commandes suivantes :

Install-Module -Name MicrosoftPowerBIMgmt

Connect-PowerBIServiceAccount -Tenant '<TENANT ID>' -ServicePrincipal -Credential (Get-Credential)

Get-PowerBIWorkspace

Invoke-PowerBIRestMethod -URL 'https://api.powerbi.com/v1.0/myorg/RefreshUserPermissions' -Method Post -Body ''

Get-PowerBIWorkspace

Accès à l’espace de travail

Une fois le groupe de sécurité ajouté, le groupe de sécurité ou le principal du service doivent également être ajoutés à chaque espace de travail en tant que membre, contributeur ou administrateur. Pour plus d’informations, consultez Donner aux utilisateurs l’accès aux espaces de travail.

Démonstration : Configurer l’authentification

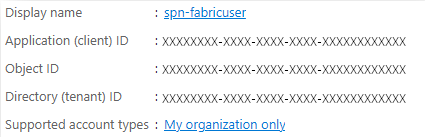

Principal du service d'enregistrement d'application

Créez ou utilisez un principal de service d'enregistrement d'application (SPN) existant. Suivez les étapes décrites dans Inscrire une application auprès de Microsoft Entra ID et créez un principal de service.

Remarque

Vous n’avez pas besoin d’affecter un URI de redirection.

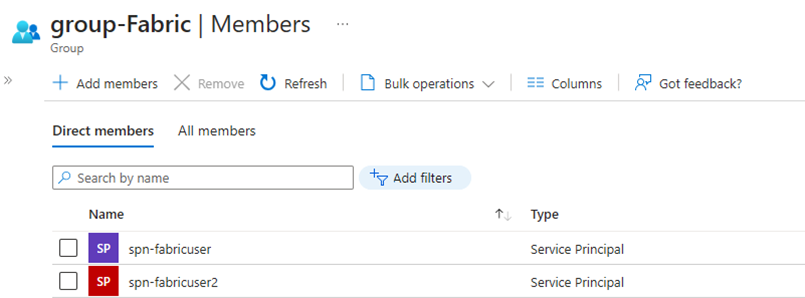

Groupe de sécurité

Créez un groupe de sécurité Microsoft Entra ou utilisez-en un existant, puis ajoutez-y le SPN. Suivez les étapes décrites dans Créer un groupe de base et ajouter des membres pour créer un groupe de sécurité Microsoft Entra.

Portail d’administration Power BI

À partir du portail d’administration Power BI, accédez aux paramètres du développeur et sélectionnez Autoriser les principaux de service à utiliser les API Power BI, puis activez-le. Ajoutez ensuite le groupe de sécurité de l’étape précédente. Pour plus d’informations sur les paramètres du locataire du portail d’administration Power BI, consultez paramètres du locataire.

Remarque

Vérifiez que le paramètre Utilisateurs peuvent accéder aux données stockées dans OneLake avec des applications externes à Fabric est activé. Reportez-vous à Autoriser les applications s’exécutant en dehors de Fabric à accéder aux données via OneLake.

Espace de travail

Ajoutez le SPN ou le groupe de services à l’espace de travail avec l'accès Membre , Contributeur ou Administrateur.

Azure Data Factory : Service lié

À partir de Azure Data Factory, créez un nouveau service lié Microsoft Fabric Lakehouse.

Remarque

Pour rechercher l’espace de travail et les ID Lakehouse, accédez à votre Fabric Lakehouse et identifiez-le à partir de l’URL. Par exemple : https://.../groups/<ID d’espace de travail>>/lakehouses/<ID de Lakehouse>

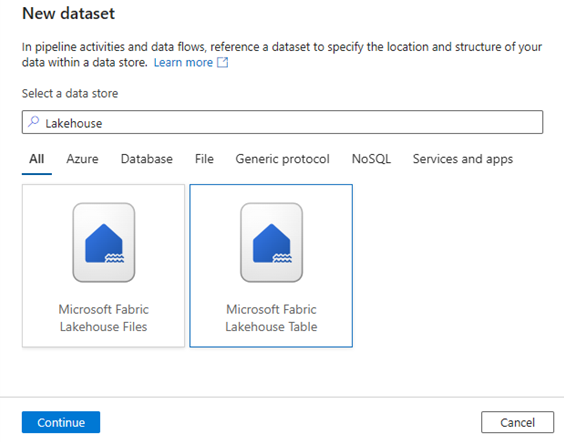

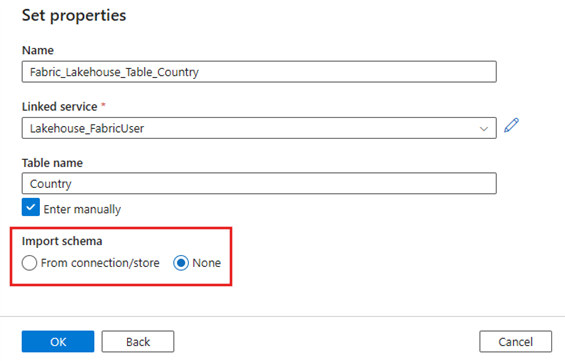

Azure Data Factory : Jeu de données

Créez un jeu de données qui référence le service lié Microsoft Fabric Lakehouse.

Remarque

Sélectionnez Aucun pour l’option Importer le schéma si la table n’existe pas encore et que vous spécifiez manuellement un nouveau nom de table.

Démonstration : Insérer des données dans une table Fabric Lakehouse avec un pipeline ADF

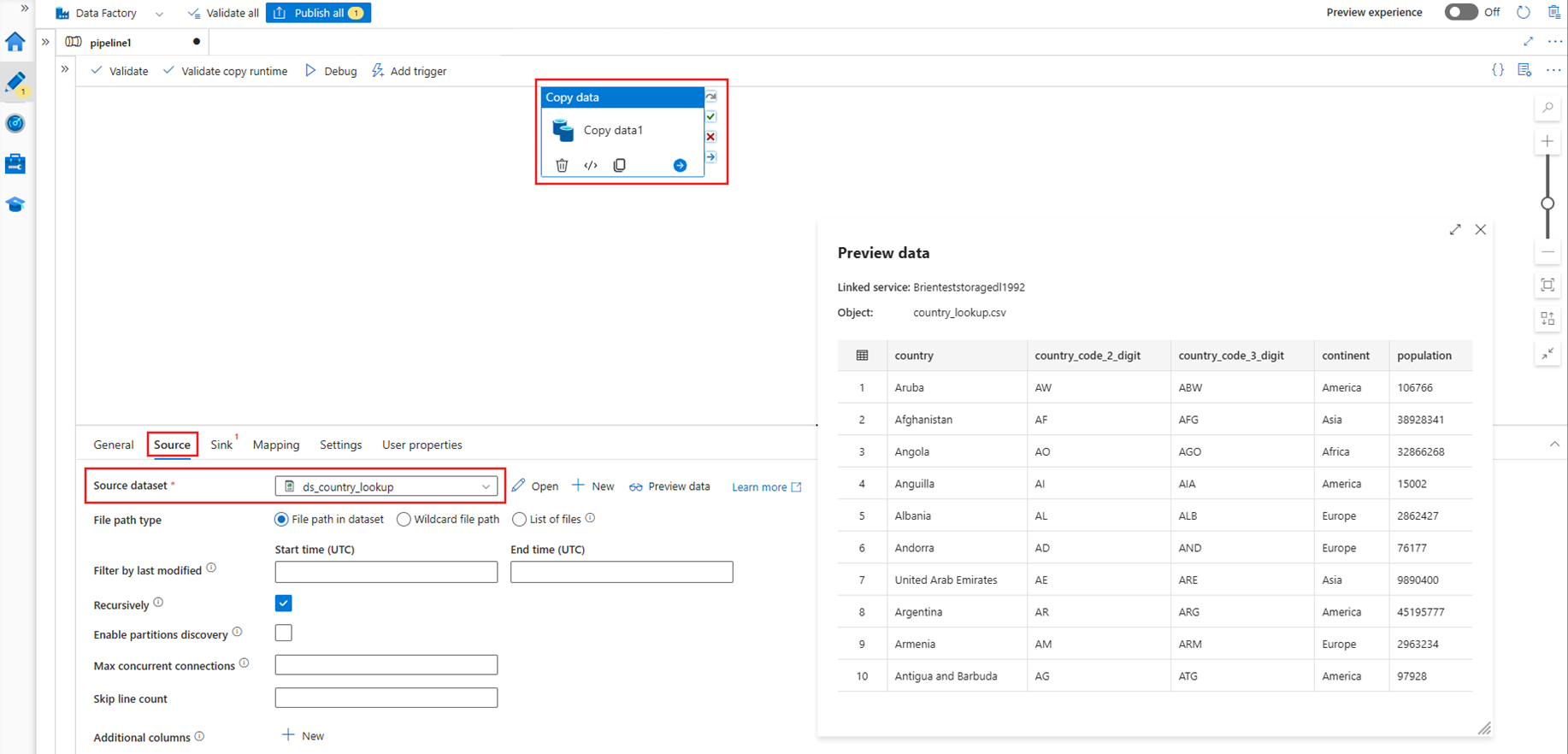

Source

Créez un nouveau pipeline et ajoutez une activité Copy dans le canevas du pipeline. Sous l’onglet Source de l’activité de copie, sélectionnez un jeu de données source que vous souhaitez déplacer dans une table Lakehouse. Dans cet exemple, nous référeçons un fichier .csv à partir d’un compte Azure Data Lake Storage (ADLS) Gen2.

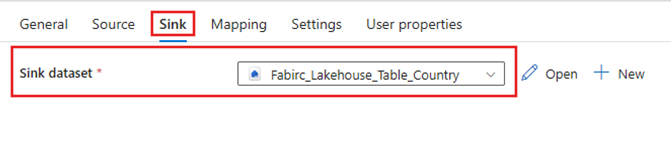

Récepteur

Accédez à l’onglet Récepteur de l’activité Copy, puis sélectionnez le jeu de données Fabric Lakehouse créé précédemment.

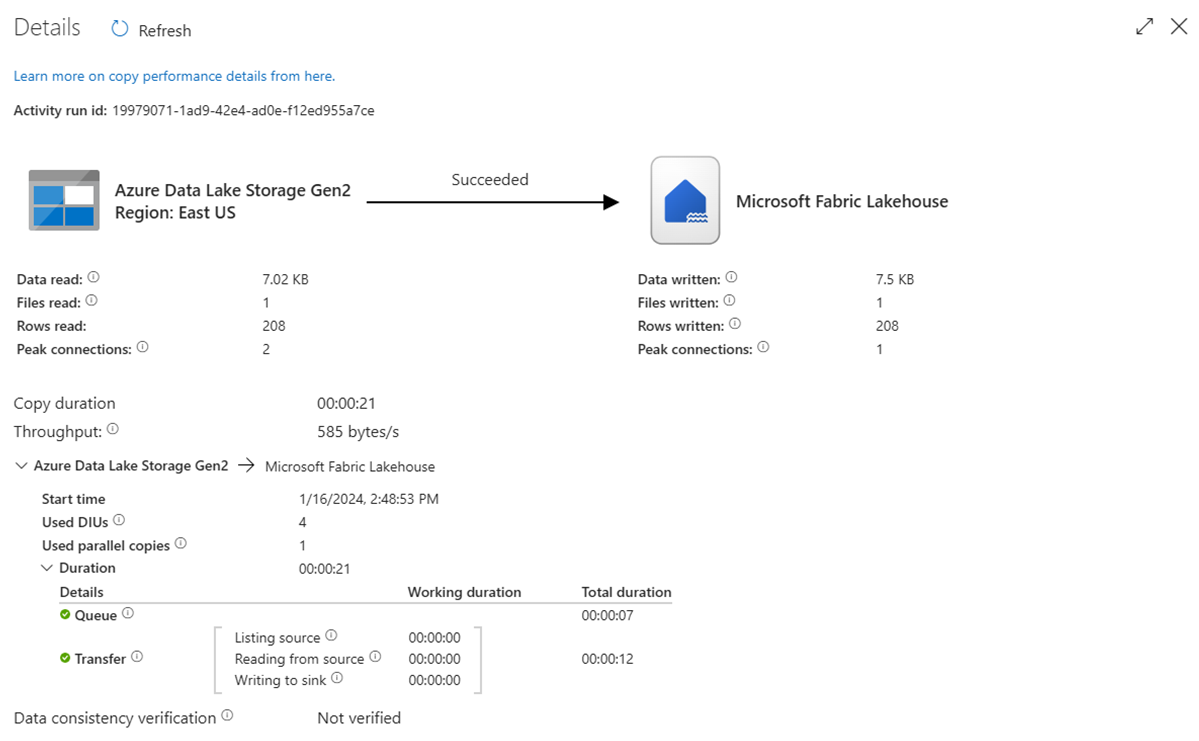

Exécuter le pipeline

Exécutez le pipeline pour transférer les données .csv dans la table Fabric Lakehouse.

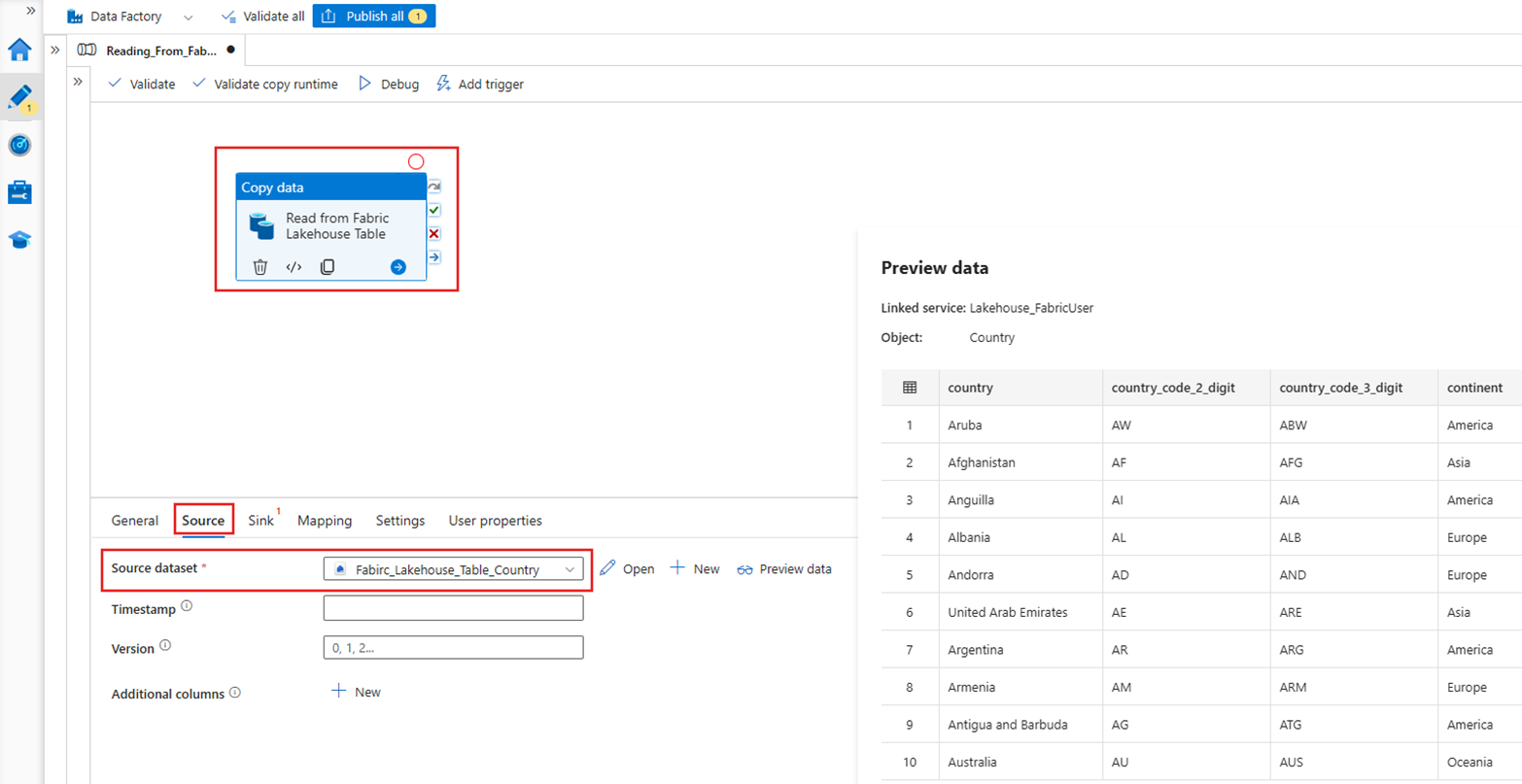

Démonstration : Lecture à partir d’une table Fabric Lakehouse avec un pipeline ADF

Dans la section ci-dessus, nous avons montré comment utiliser ADF pour écrire dans une table Fabric Lakehouse. Maintenant, lisons depuis une table Fabric Lakehouse et écrivons dans un fichier Parquet dans Azure Data Lake Storage (ADLS) Gen2 avec un pipeline similaire.

Source

Créez un nouveau pipeline et ajoutez une activité Copy dans le canevas du pipeline. Dans l’onglet Source de l’activité de copie, sélectionnez le jeu de données Fabric Lakehouse créé précédemment.

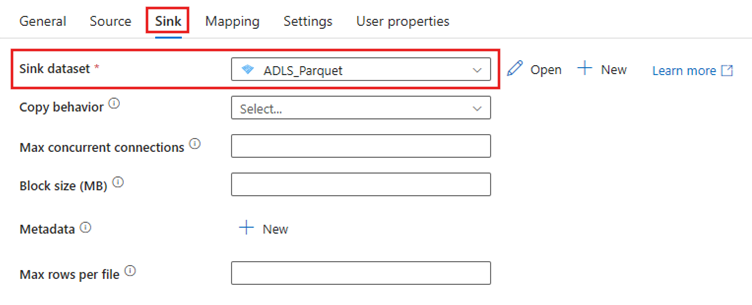

Récepteur

Accédez à l'onglet Sink de l'activité de copie, puis sélectionnez le jeu de données de destination. Dans cet exemple, la destination est Azure Data Lake Storage (Gen2), en tant que fichier Parquet.

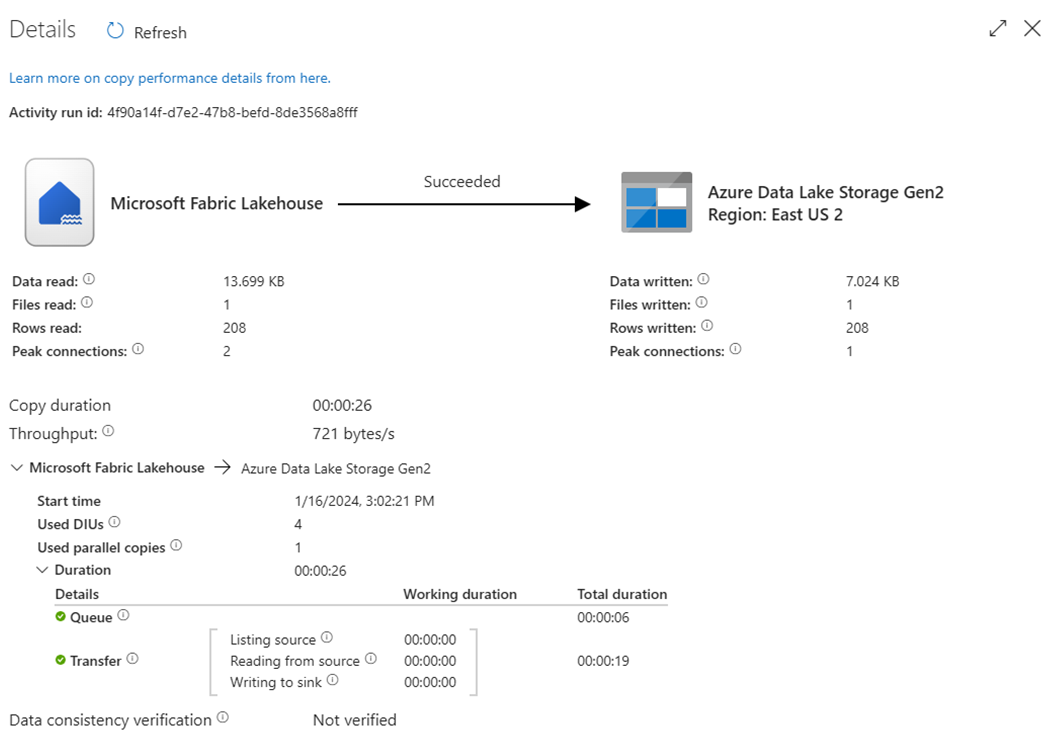

Exécuter le pipeline

Exécutez le pipeline pour déplacer les données de la table Fabric Lakehouse dans le fichier Parquet dans ADLS Gen2.

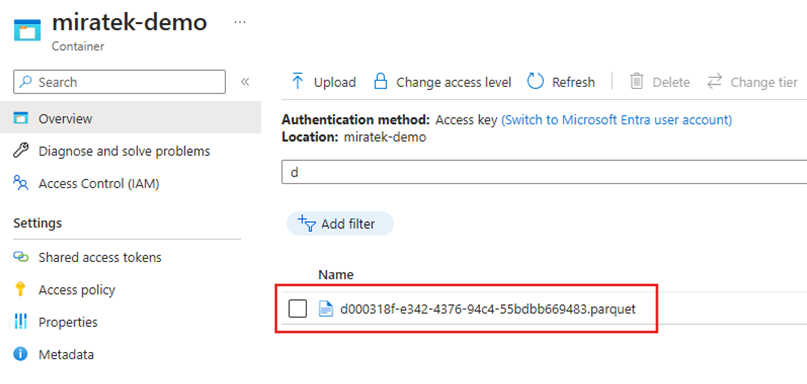

Inspecter le fichier Parquet dans ADLS Gen2

Les données de la table Fabric Lakehouse sont désormais disponibles dans ADLS Gen2 sous forme de fichier Parquet.

Résumé

Dans cette section, nous avons exploré les exigences pour le connecteur Lakehouse en utilisant l'authentification par principal de service pour un Microsoft Fabric Lakehouse, puis nous avons illustré un exemple pour la lecture et l'écriture dans le Lakehouse à partir d’un pipeline Azure Data Factory. Ce connecteur et ces fonctionnalités sont également disponibles dans les flux de données de mappage d'Azure Data Factory et d'Azure Synapse Analytics.