Démarrage rapide : Créer un travail Apache Airflow

Remarque

Apache Airflow Job est basé sur Apache Airflow.

Apache Airflow est une plateforme open source utilisée pour créer, planifier et surveiller des travaux complexes par programmation. Elle vous permet de définir un ensemble de tâches, appelées opérateurs, qui peuvent être combinées en graphes orientés acyclique (DAG) pour représenter des pipelines de données.

Apache Airflow Job fournit un moyen simple et efficace de créer et gérer des environnements Apache Airflow, ce qui vous permet d’exécuter facilement vos travaux d’orchestration à grande échelle. Dans ce démarrage rapide, nous allons créer un travail Apache Airflow simple pour vous familiariser avec l’environnement et les fonctionnalités d’Apache Airflow Job.

Prérequis

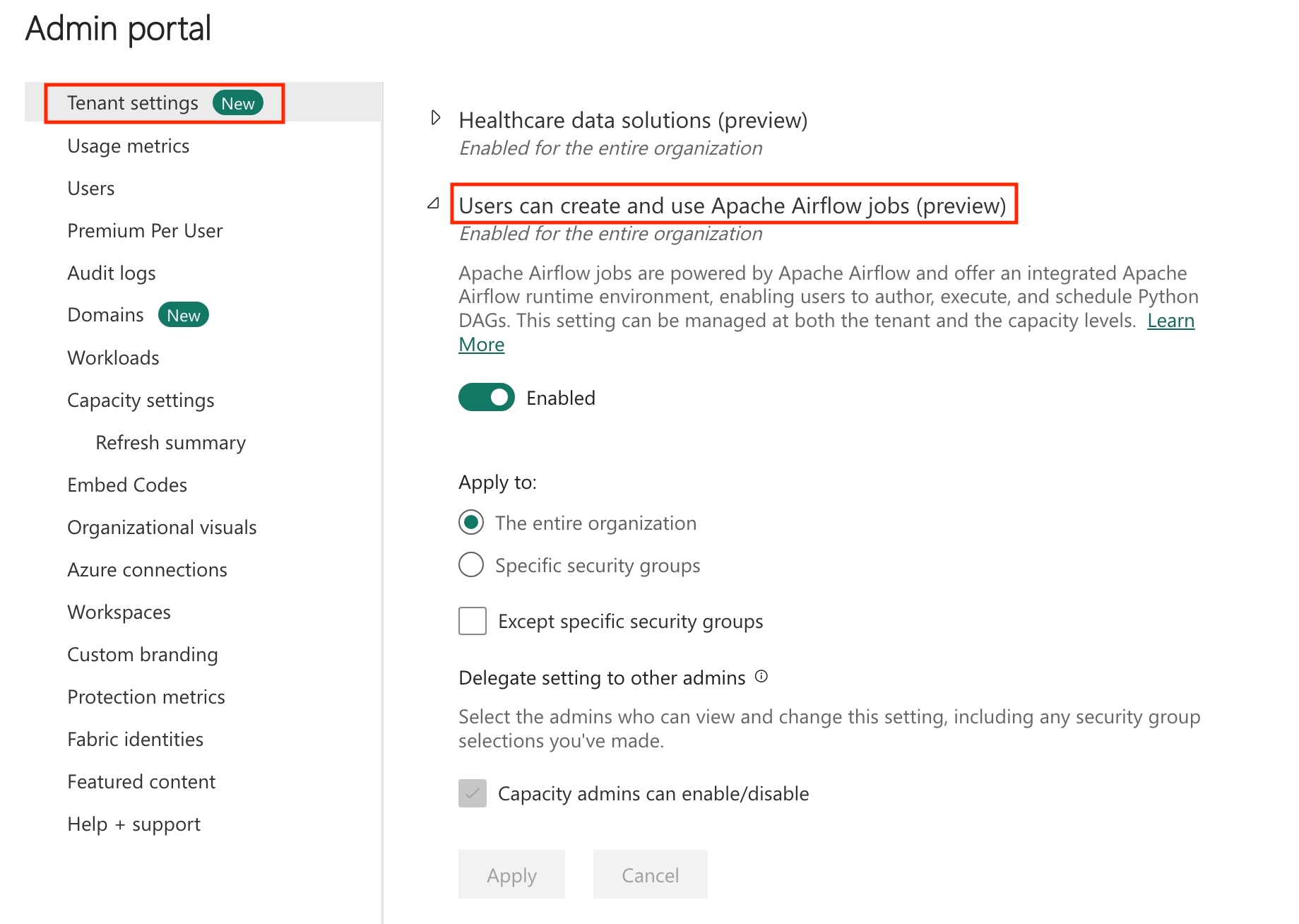

- Activez Apache Airflow Job dans votre locataire.

Remarque

Comme Apache Airflow Job est en préversion, vous devez l’activer via l’administrateur de votre tenant. Si vous voyez déjà Apache Airflow Job, c’est que l’administrateur de votre tenant peut l’avoir déjà activé.

- Accédez au portail d’administration –> Paramètres du locataire –> Sous Microsoft Fabric –> Développez la section « Les utilisateurs peuvent créer et utiliser Apache Airflow Job (préversion) ».

- Sélectionnez Appliquer.

Créer un travail Apache Airflow

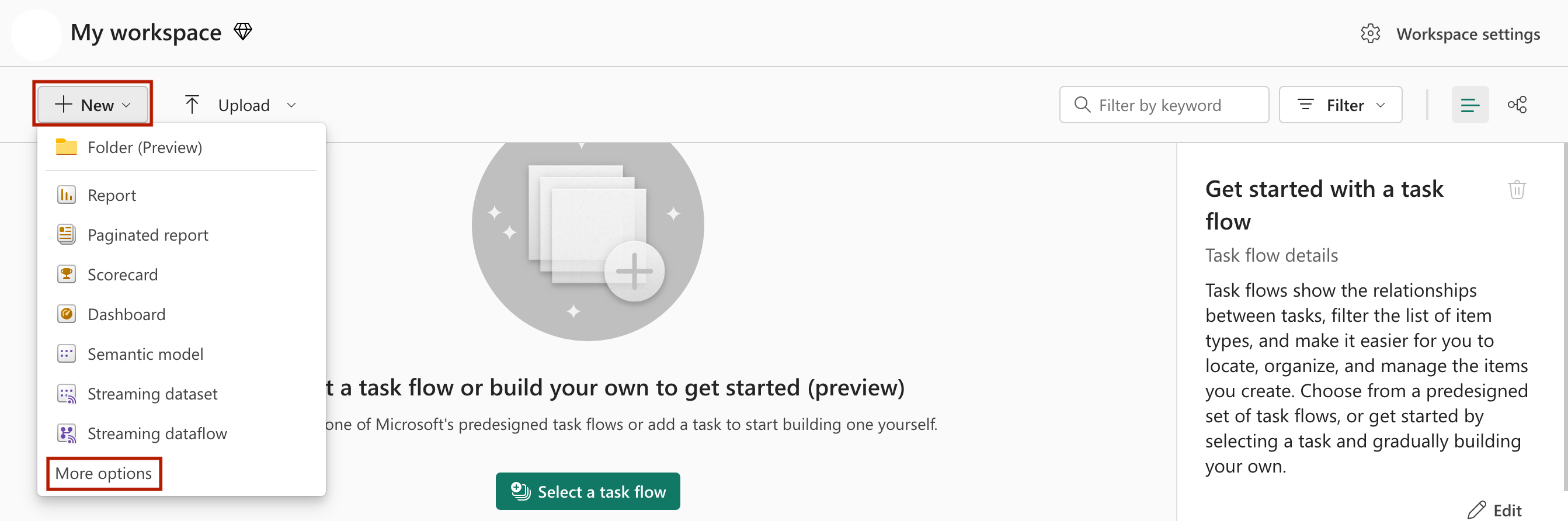

Vous pouvez utiliser un espace de travail existant ou créer un nouvel espace de travail.

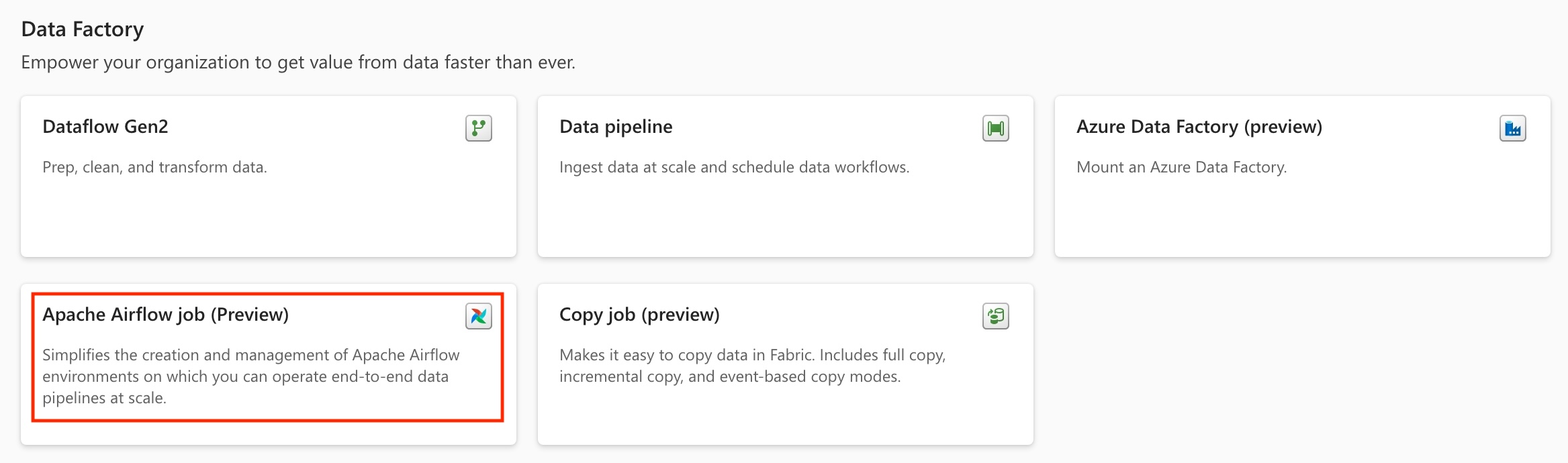

Développez le menu déroulant

+ New–> Cliquez sur Plus d’options –> Sous la sectionData Factory–> Sélectionnez Apache Airflow Job (préversion)

Donnez un nom approprié à votre projet, puis cliquez sur le bouton « Créer ».

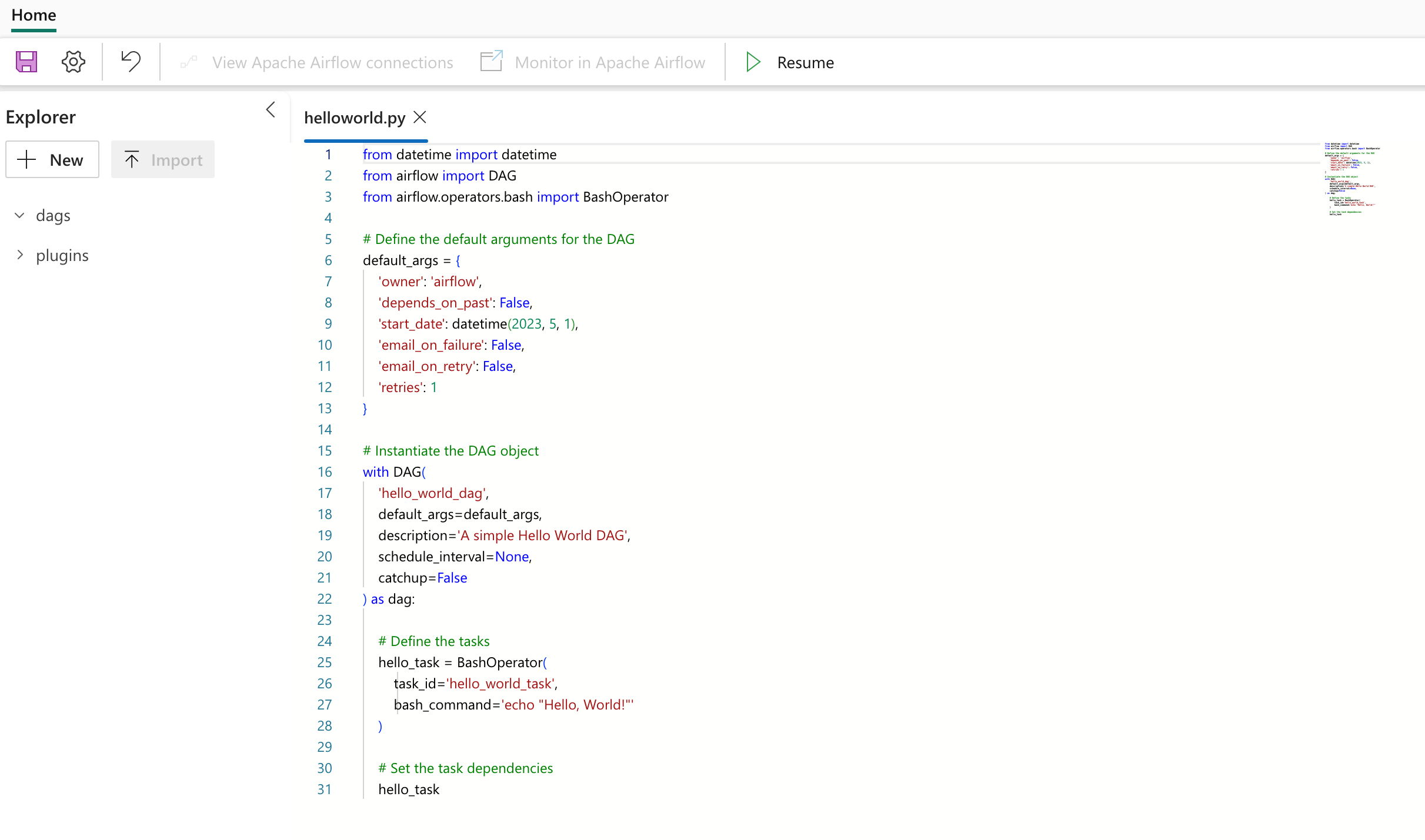

Créer un fichier DAG

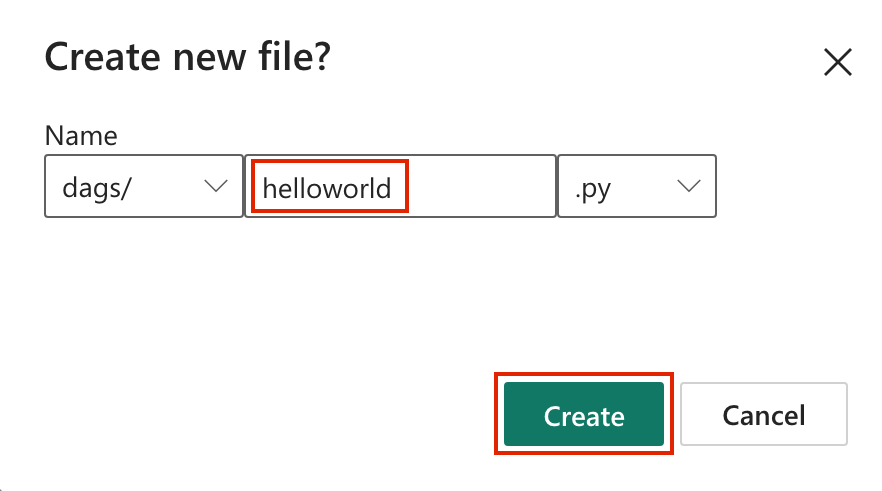

Cliquez sur « Nouveau fichier DAG » carte –> donnez le nom au fichier, puis cliquez sur le bouton « Créer ».

Un code DAG standard vous est présenté. Vous pouvez modifier le fichier en fonction de vos besoins.

Cliquez sur « l’icône Enregistrer ».

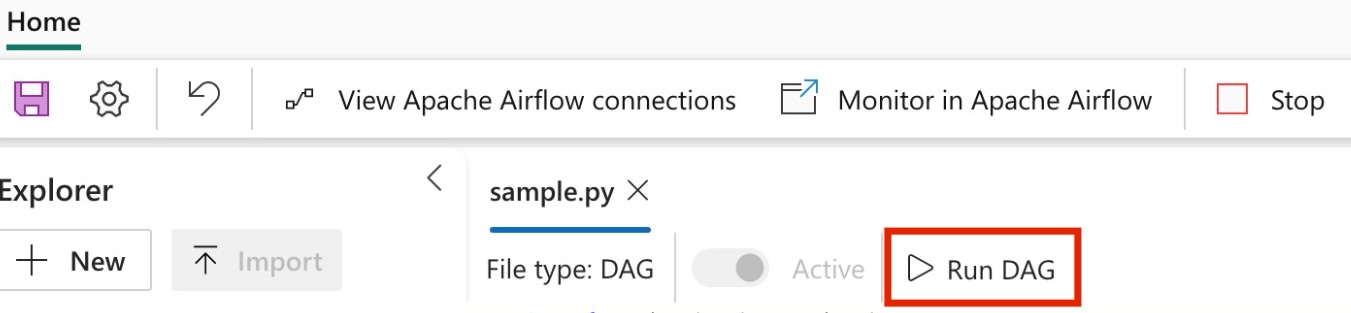

Exécuter un DAG

Commencez par cliquer sur le bouton « Exécuter le DAG ».

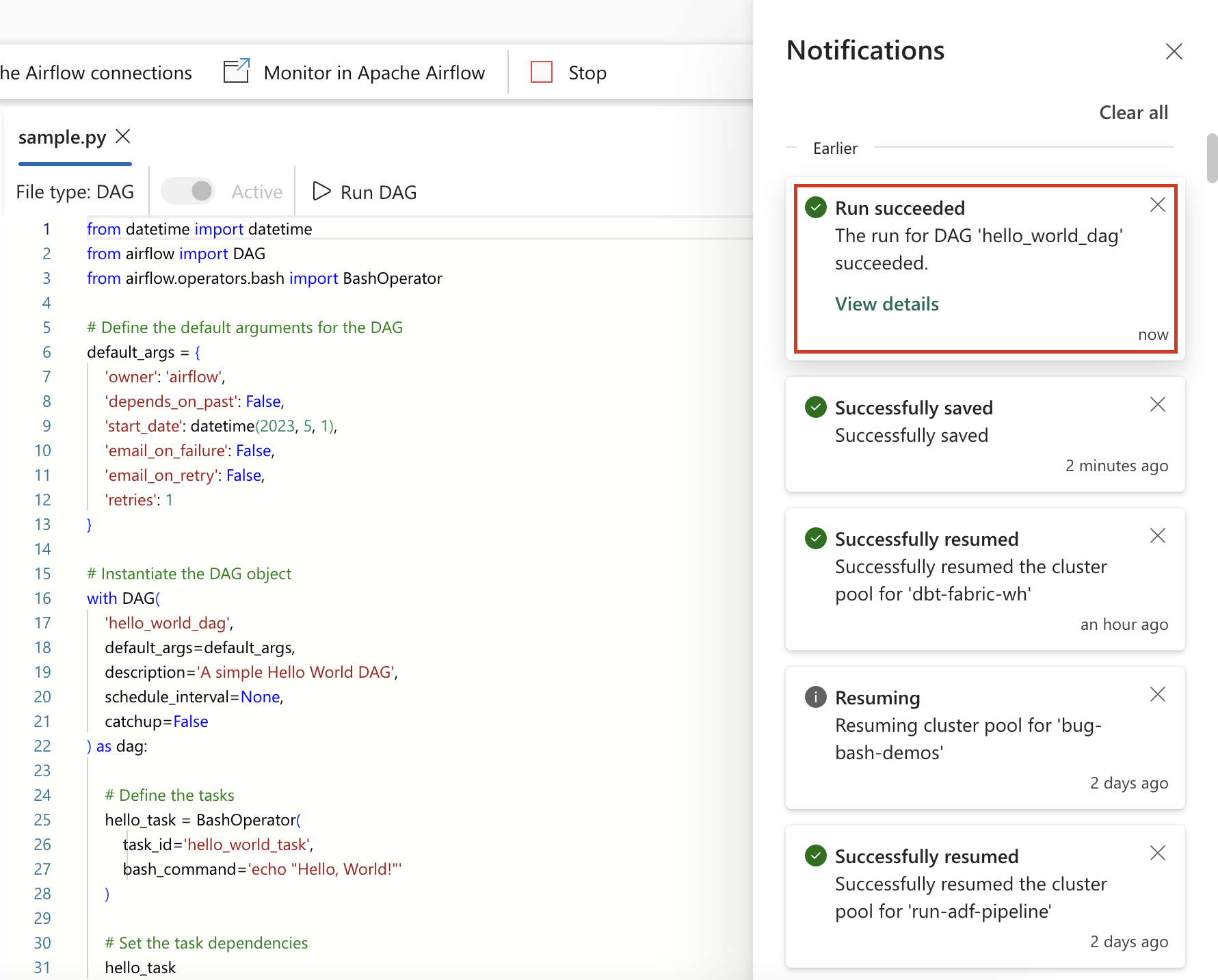

Une fois lancée, une notification s’affiche rapidement indiquant que le DAG est en cours d’exécution.

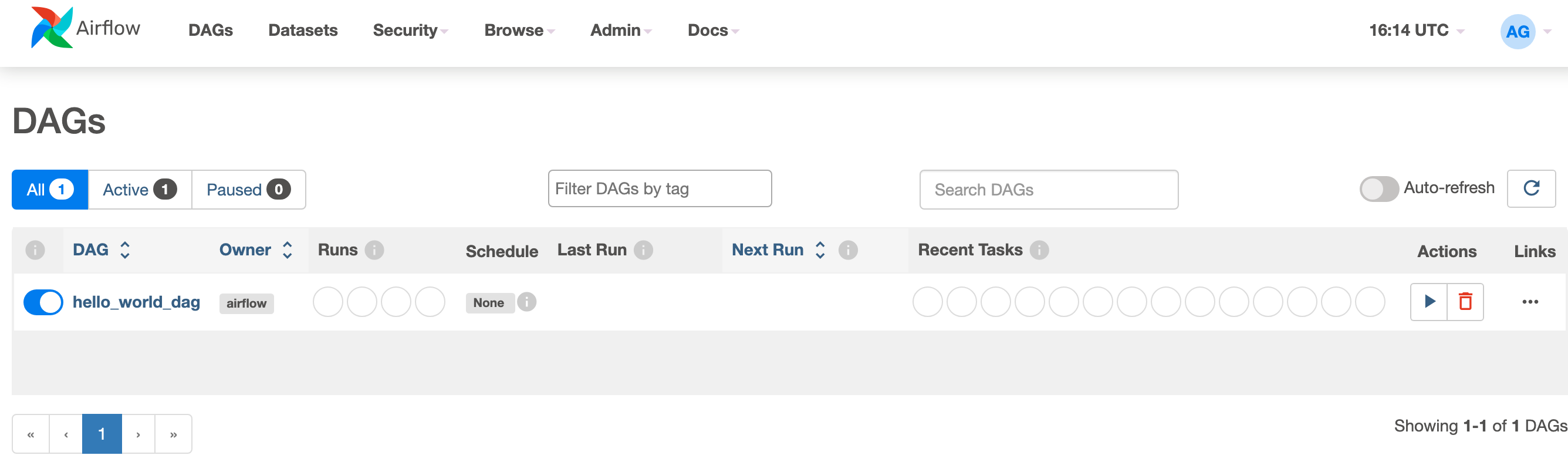

Pour surveiller la progression de l’exécution du DAG, cliquez simplement sur « Afficher les détails » dans le centre de notification. Cette action vous redirige vers l’interface utilisateur (IU) Apache Airflow, où vous pouvez suivre facilement l’état et les détails de l’exécution du DAG.

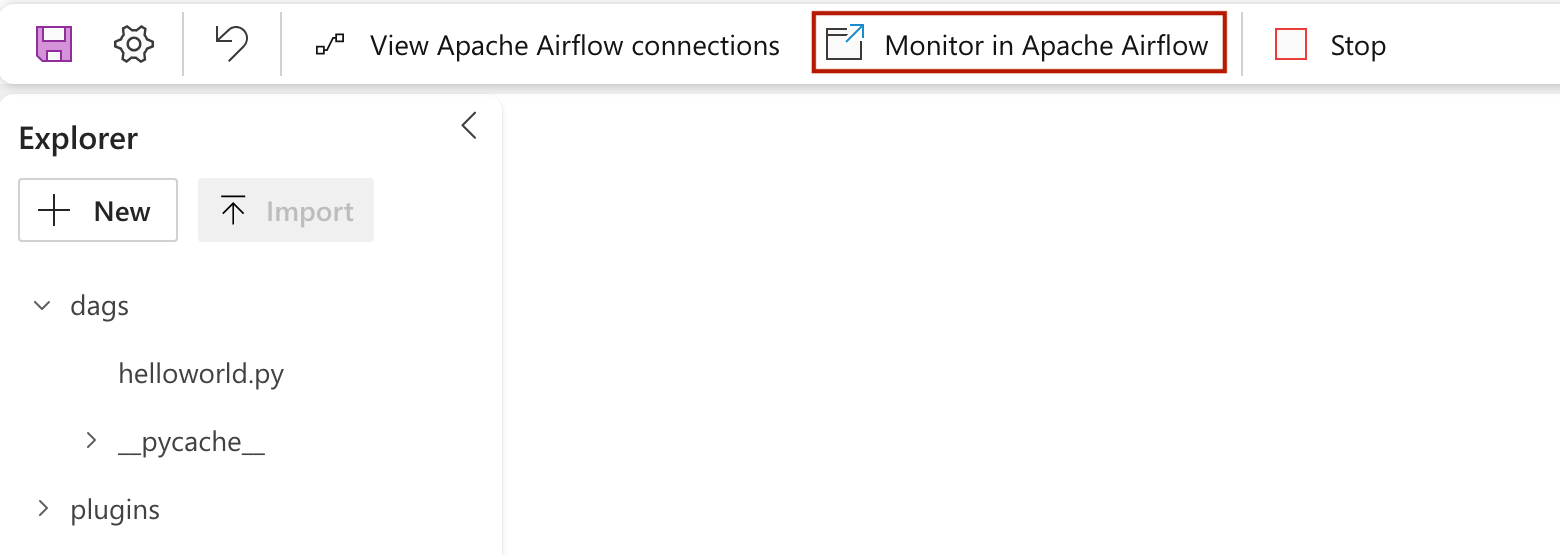

Surveiller votre DAG Apache Airflow dans l’interface utilisateur d’Apache Airflow

Les fichiers DAG enregistrés sont chargés dans l’interface utilisateur (IU) Apache Airflow. Vous pouvez les surveiller en cliquant sur le bouton « Surveiller dans Apache Airflow ».