Surveiller la consommation de capacité Apache Spark

L’objectif de cet article est de fournir des conseils aux administrateurs qui souhaitent surveiller les activités dans les capacités qu’ils gèrent. En utilisant les rapports de consommation de la capacité Apache Spark disponibles dans l’application de indicateurs de performances des capacités Microsoft Fabric, les administrateurs peuvent obtenir des insights sur la consommation de capacité Spark facturable pour des éléments, notamment les définitions de tâches Lakehouse, Notebook et Apache Spark. Certaines activités de consommation de capacité Spark ne sont pas signalées dans l’application.

Consommation de capacité Spark signalée

Les opérations suivantes à partir de lakehouses, de notebooks et de définitions de travaux Spark sont traitées comme des activités facturables.

| Nom d’opération | Article | Commentaires |

|---|---|---|

| Opérations Lakehouse | Lakehouse | Les utilisateurs affichent un aperçu de la table dans l’explorateur Lakehouse. |

| Chargement de table Lakehouse | Lakehouse | Les utilisateurs chargent une table delta dans l’explorateur Lakehouse. |

| Exécution du notebook | Notebook | Notebook s’exécute manuellement par les utilisateurs. |

| Exécution HC du notebook | Notebook | Notebook s’exécute sous la session Apache Spark à haute concurrence. |

| Exécution planifiée du notebook | Notebook | Exécutions de Notebook déclenchées par des événements planifiés de notebook. |

| Exécution du pipeline de notebook | Notebook | Exécutions de Notebook déclenchées par le pipeline. |

| Exécution VS Code du notebook | Notebook | Notebook s’exécute dans VS Code. |

| Exécution de tâche Spark | Définition de la tâche Spark | Exécutions de tâches Spark par lots lancées par l’utilisateur. |

| Exécution planifiée de tâche Spark | Définition de la tâche Spark | Exécutions de traitement par lots déclenchées par des événements planifiés de notebook. |

| Exécution du pipeline de tâche Spark | Définition de la tâche Spark | Exécutions de traitement par lots déclenchées par le pipeline. |

| Exécution de tâches Spark VS Code | Définition de la tâche Spark | Définition de tâche Spark envoyée depuis VS Code. |

Consommation de capacité Spark non signalée

Certaines activités de consommation de capacité Spark ne sont pas signalées dans l’application de métriques. Ces activités incluent les travaux Spark système pour la gestion des bibliothèques et certains travaux Spark système pour le pool ou les sessions en direct Spark.

Gestion des bibliothèques : la consommation de capacité associée à la gestion des bibliothèques au niveau de l’espace de travail n’est pas signalée dans l’application de métriques.

Travaux Spark système : la consommation de capacité Spark qui n’est pas associée à un notebook, à une définition de travail Spark ni à un lakehouse n’est pas incluse dans les rapports de capacité.

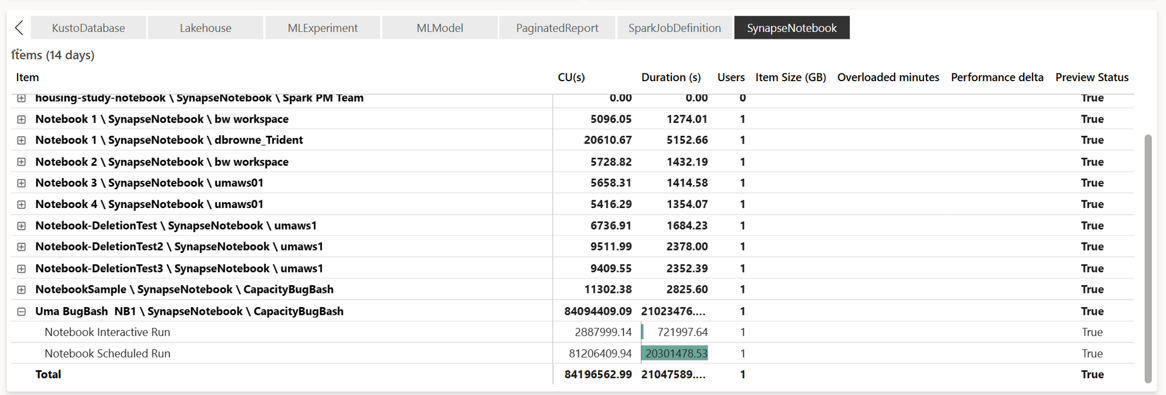

Rapports de consommation de capacité

Toutes les opérations associées à Spark sont classées en tant qu’opérations en arrière-plan. La consommation de capacité à partir de Spark s’affiche sous un notebook, une définition de travail Spark ou un lakehouse, et est agrégée par nom d’opération et par élément.

Rapport des opérations en arrière-plan

Les opérations en arrière-plan sont affichées pour un point de temps spécifique. Dans la table du rapport, chaque ligne fait référence à une opération utilisateur. Passez en revue la colonne Utilisateur pour identifier qui a effectué une opération spécifique. Si vous avez besoin d’informations supplémentaires sur une opération spécifique, vous pouvez utiliser son ID d’opération pour la rechercher dans le hub de supervision Microsoft Fabric.