Vue d’ensemble de l’intelligence artificielle

Quels sont les produits proposés par Microsoft qui utilisent l’IA ?

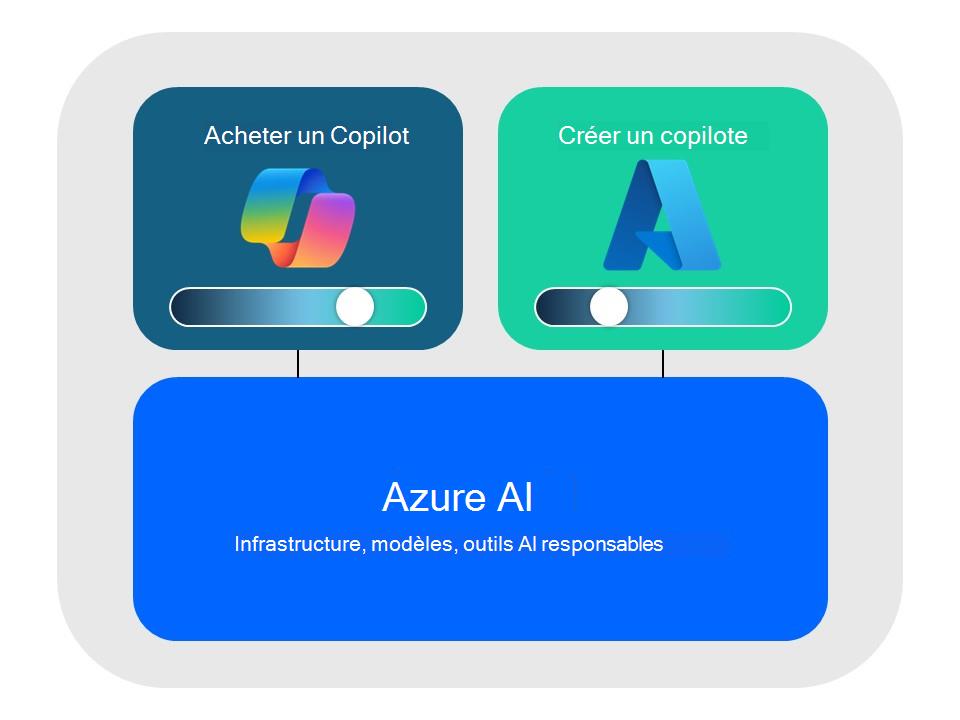

Microsoft propose une variété d’offres d’IA qui peuvent être classées en deux groupes : les systèmes d’IA générative prêts à l’emploi tels que Copilot et les plateformes de développement IA où vous pouvez créer vos propres systèmes d’IA générative.

Azure AI sert de plateforme de développement commune, fournissant une base pour l’innovation responsable avec la confidentialité, la sécurité et la conformité de niveau entreprise.

Pour plus d’informations sur les offres d’IA de Microsoft, consultez la documentation produit suivante :

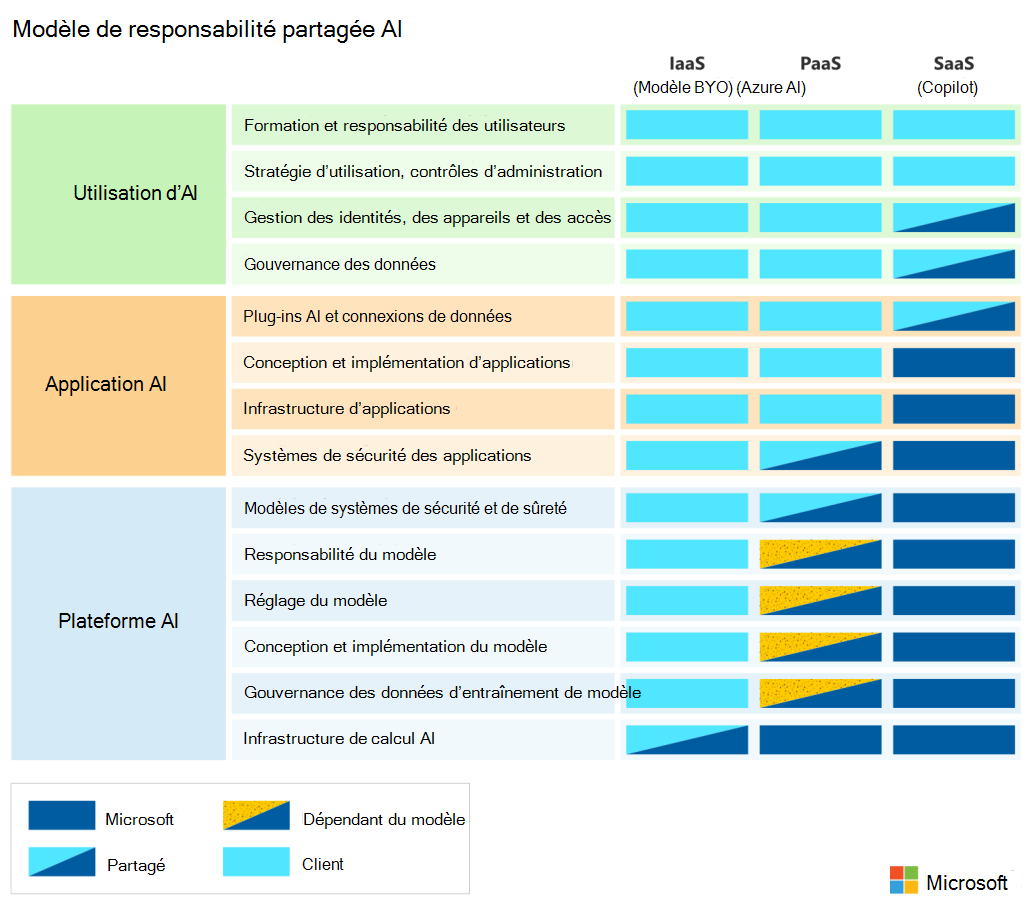

Comment le modèle de responsabilité partagée s’applique-t-il à l’IA ?

Comme pour les autres offres cloud, l’atténuation des risques liés à l’IA est une responsabilité partagée entre Microsoft et les clients. En fonction des fonctionnalités d’IA implémentées dans votre organization, les responsabilités varient entre Microsoft et le client.

Le diagramme suivant illustre les domaines de responsabilité entre Microsoft et nos clients en fonction du type de déploiement.

Pour en savoir plus, consultez Modèle de responsabilité partagée d’intelligence artificielle (IA)

Pour plus d’informations sur la façon dont Microsoft aide les clients à exécuter leur partie du modèle de responsabilité partagée, consultez Comment nous soutenons nos clients dans la création d’une IA responsable.

Comment Microsoft régit-t-il le développement et la gestion des systèmes IA ?

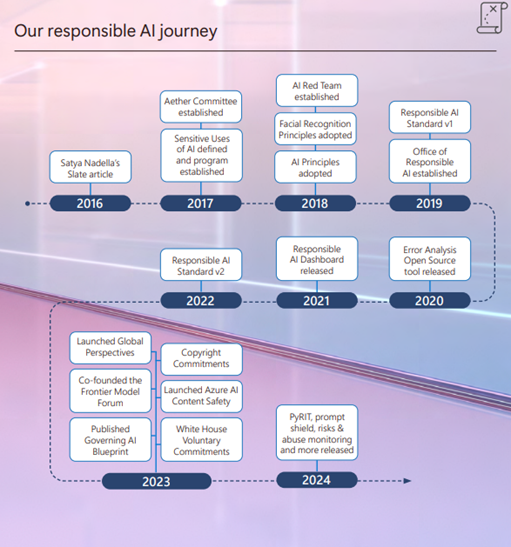

L’IA n’est pas une nouveauté pour Microsoft ; nous sommes à l’origine d’innovations dans les systèmes d’IA depuis des années. Notre initiative d’IA responsable a été au cœur de nos efforts en matière d’IA et a été lancée par la publication de l’article de ardoise de Satya Nadella en 2016 et a conduit à l’emplacement où nous en sommes aujourd’hui dans l’opérationnalisation de l’IA responsable.

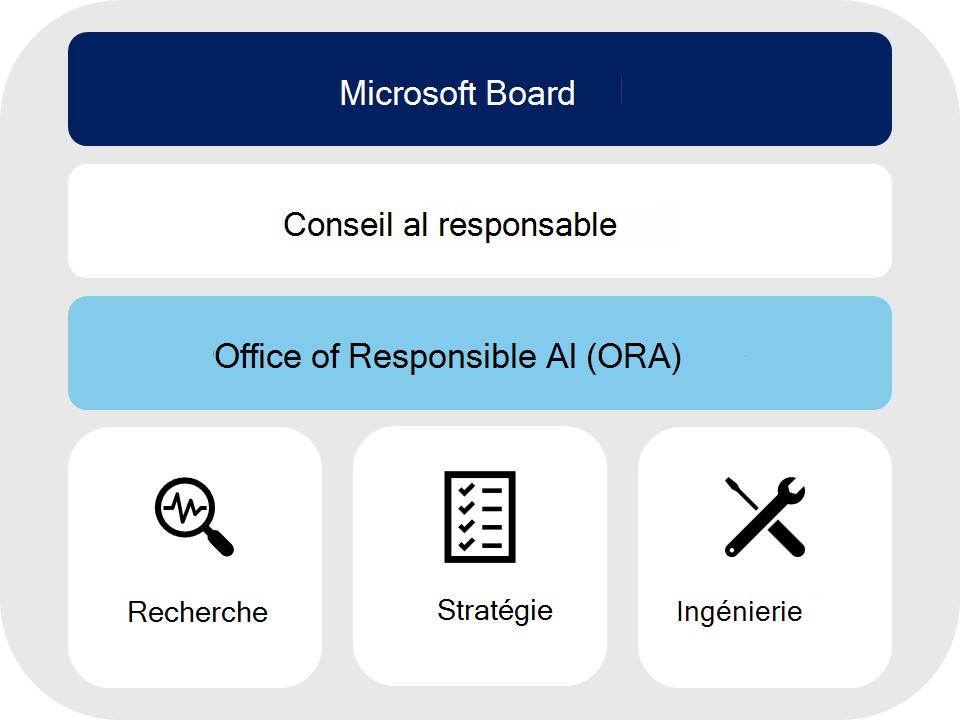

Aucune équipe ou organization n’est seule responsable de l’adoption des pratiques d’IA responsable. Nous combinons une approche fédérée de bas en haut avec un solide soutien et une supervision de haut en bas par la direction de l’entreprise pour alimenter nos stratégies, notre gouvernance et nos processus. Les spécialistes en recherche, en politique et en ingénierie combinent leur expertise et collaborent sur des pratiques de pointe pour nous assurer que nous respectons nos propres engagements tout en soutenant nos clients et partenaires.

- Conseil d’administration Microsoft : Notre gestion de l’IA responsable commence par les Satya Nadella de PDG et s’étend en cascade à l’équipe de direction et à l’ensemble de Microsoft. Le Comité des politiques environnementales, sociales et publiques du Conseil d’administration assure la supervision et l’orientation des politiques et des programmes d’IA responsable.

- Conseil de l’IA responsable : mis en place par le vice-président et président Brad Smith et le directeur de la technologie Kevin Scott, le Conseil de l’IA responsable est un forum pour les dirigeants d’entreprise et les représentants de la recherche, des politiques et de l’ingénierie afin de relever régulièrement les plus grands défis liés à l’IA et de faire progresser nos stratégies et processus d’IA responsable.

- Office of Responsible AI (ORA) : ORA est chargé de mettre en pratique les principes de l’IA responsable, qu’il accomplit par le biais de cinq fonctions clés. ORA définit des stratégies internes à l’échelle de l’entreprise, définit les structures de gouvernance, fournit des ressources pour adopter des pratiques d’IA, examine les cas d’usage sensibles et aide à façonner les stratégies publiques relatives à l’IA.

- Recherche : Les chercheurs du comité Éthique et effets de l’IA dans l’ingénierie et la recherche (Aether), Microsoft Research et les équipes d’ingénierie maintiennent le programme d’IA responsable à la pointe des problèmes grâce à un leadership éclairé.

- Stratégie : ORA collabore avec les parties prenantes et les équipes de stratégie au sein de l’entreprise pour développer des stratégies et des pratiques visant à respecter nos principes d’IA lors de la création d’applications IA.

- Ingénierie : les équipes d’ingénierie créent des plateformes, des applications et des outils IA. Ils fournissent des commentaires pour s’assurer que les politiques et les pratiques sont techniquement réalisables, innover dans de nouvelles pratiques et de nouvelles technologies, et mettre à l’échelle les pratiques d’IA responsable au sein de l’entreprise.

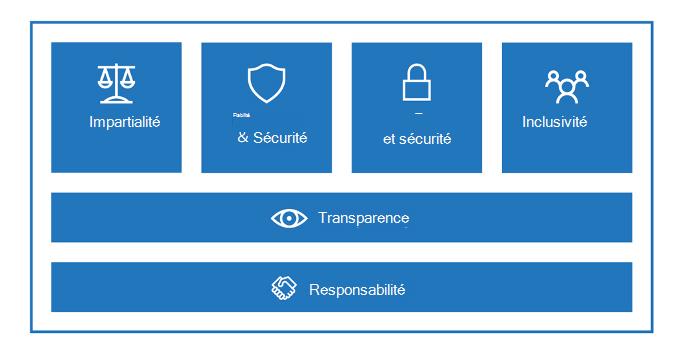

Quels sont les principes qui servent de base au programme RAI de Microsoft ?

Microsoft a développé six principes centrés sur l’homme pour favoriser une culture de sensibilisation, d’apprentissage et d’innovation sur des sujets liés à l’IA responsable. Ces six principes d’IA constituent la base du programme RAI de Microsoft, et les politiques qu’ORA développe.

Pour plus d’informations sur les principes de l’IA responsable, consultez IA responsable.

Comment Microsoft implémente-t-il les stratégies définies par ORA ?

La norme IA responsable (NORME RAI) est le résultat d’un effort à long terme visant à établir des critères de développement de produits et de gestion des risques pour les systèmes IA. Il met en œuvre les principes RAI en définissant des objectifs, des exigences et des pratiques pour tous les systèmes d’IA développés par Microsoft.

- Goals : Définir ce que signifie respecter nos principes d’IA

- Exigences : Définir comment nous devons respecter nos principes d’IA

- Pratiques : les aides qui permettent de répondre aux exigences

La main force motrice de la norme RAI est l’évaluation d’impact, où l’équipe de développement doit documenter les résultats pour chaque exigence d’objectif. Pour les objectifs de confidentialité & de sécurité et d’inclusion, la norme RAI indique que l’exigence est conforme aux programmes existants de confidentialité, de sécurité et d’accessibilité qui existent déjà chez Microsoft et de suivre les instructions spécifiques à l’IA qu’ils peuvent avoir.

La norme RAI complète est disponible dans la documentation relative aux exigences générales de Microsoft Responsible AI Standard.