Packages d’espace de travail

Les packages d’espace de travail peuvent être des fichiers de roue personnalisée ou privée (Python), jar (Scala/Java) ou tar.gz (R). Vous pouvez télécharger ces packages dans votre espace de travail et les attribuer par la suite à un pool Spark spécifique.

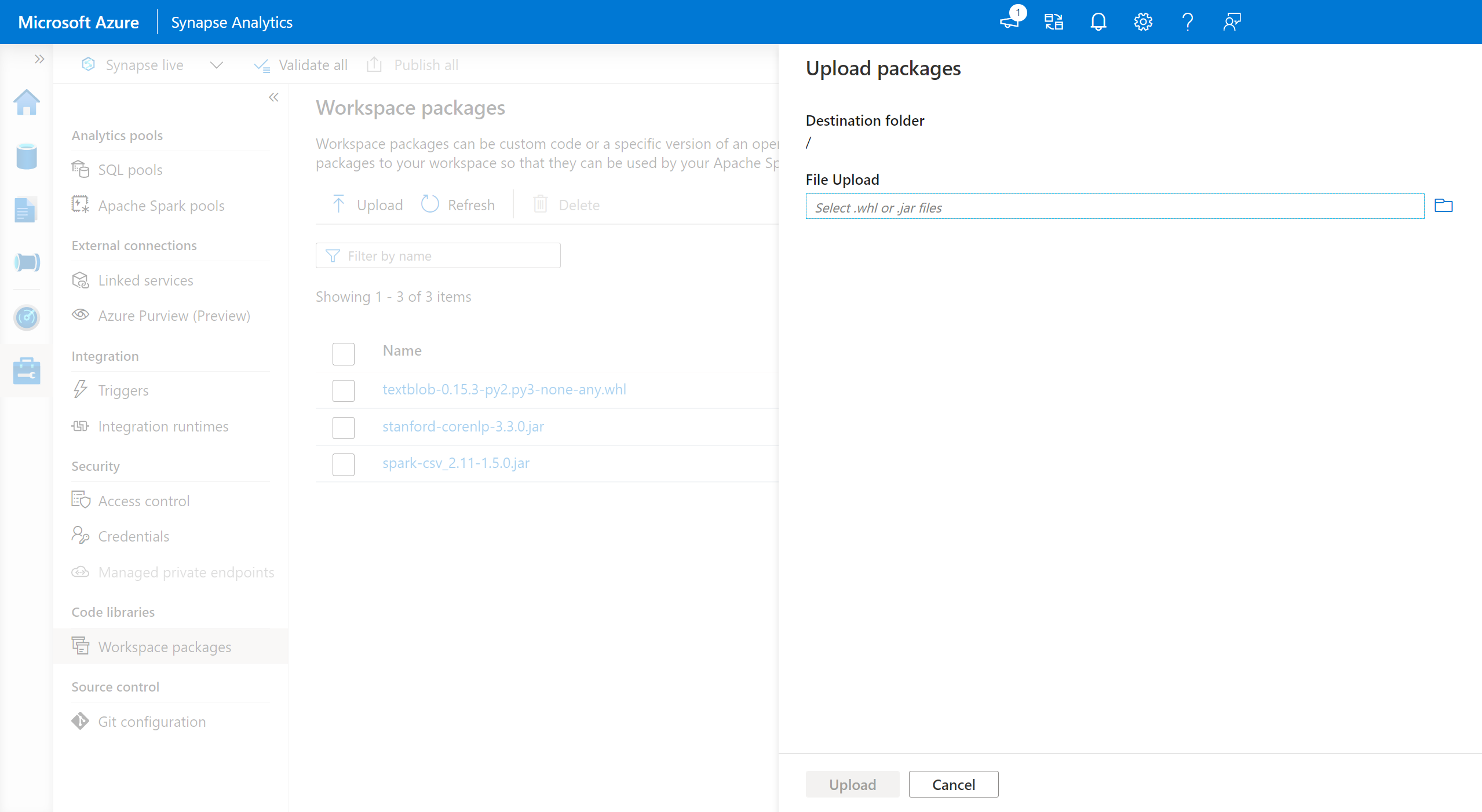

Pour ajouter des packages d’espace de travail :

- Accédez à l’onglet Gérer>Packages d’espace de travail.

- Chargez vos fichiers en utilisant le sélecteur de fichiers.

- Une fois les fichiers téléchargés dans l’espace de travail Azure Synapse, vous pouvez ajouter ces packages à un pool Apache Spark.

Avertissement

Dans Azure Synapse, un pool Apache Spark peut tirer parti des bibliothèques personnalisées qui sont téléchargées en tant que packages d’espace de travail ou dans un chemin d’Azure Data Lake Storage bien connu. Toutefois, ces deux options ne peuvent pas être utilisées simultanément dans le même pool Apache Spark. Si les packages sont fournis à l’aide des deux méthodes, seuls les fichiers de roues spécifiés dans la liste des packages d’espace de travail sont installés.

Une fois que les packages de l’espace de travail sont utilisés pour installer des packages sur un pool Apache Spark donné, vous ne pouvez plus spécifier de packages en utilisant le chemin du compte de stockage sur le même pool.

Remarque

Il est recommandé de ne pas avoir plusieurs packages portant le même nom au sein d’un espace de travail. Si vous voulez utiliser une autre version du même package, vous devez supprimer la version existante et charger la nouvelle.

Compte de stockage

Les packages personnalisés peuvent être installés sur le pool Apache Spark en chargeant tous les fichiers dans le compte Azure Data Lake Storage (Gen2) qui est lié à l’espace de travail Synapse.

Les fichiers doivent être téléchargés vers le chemin d’accès suivant dans le conteneur par défaut du compte de stockage :

abfss://<file_system>@<account_name>.dfs.core.windows.net/synapse/workspaces/<workspace_name>/sparkpools/<pool_name>/libraries/python/

Avertissement

- Dans certains cas, vous devrez peut-être créer le chemin d’accès basé sur la structure au-dessus s’il n’existe pas déjà. Vous devrez peut-être, par exemple, ajouter le dossier

pythondans le dossierlibrariess’il ne s’y trouve pas déjà. - Cette méthode de gestion des fichiers personnalisés n’est pas prise en charge sur le runtime Azure Synapse pour Apache Spark 3.0. Reportez-vous à la fonctionnalité des packages d’espace de travail pour gérer les fichiers personnalisés.

Important

Pour installer des bibliothèques personnalisées à l’aide de la méthode Azure DataLake Storage, vous devez disposer des autorisations Contributeur aux données Blob du stockage ou Propriétaire des données Blob du stockage sur le compte de stockage Gen2 principal qui est lié à l’espace de travail Azure Synapse Analytics.

Étapes suivantes

- Afficher les bibliothèques par défaut : Prise en charge des versions d’Apache Spark

- Résoudre les erreurs d’installation de bibliothèque : Résoudre les erreurs de bibliothèque

- Créer un canal Conda privé à l’aide de votre compte Azure Data Lake Storage : Canaux privés Conda