Connecter Tableau et Azure Databricks

Cet article explique comment utiliser Partner Connect pour vous connecter à partir d’Azure Databricks à Tableau Desktop et à partir de Tableau Desktop ou de Tableau Cloud à Azure Databricks. Cet article inclut également des informations sur Tableau Server sur Linux.

Remarque

Pour configurer la connexion Azure Databricks depuis Tableau Server, consultez Configurer la connexion Azure Databricks depuis Tableau Server.

En utilisant Azure Databricks comme une source de données avec Tableau, vous pouvez fournir des analyses interactives puissantes issues des contributions de vos scientifiques des données et de vos ingénieurs de données en vue de les fournir à vos analystes métier sous forme de jeux de données volumineux.

Découvrir dans Tableau cloud à partir d’Azure Databricks

Lorsque vous utilisez Azure Databricks comme source de données avec Tableau Cloud, vous pouvez créer des sources de données Tableau à partir de tables ou de schémas directement à partir de l’interface utilisateur Databricks.

Spécifications

- Vos données doivent se trouver sur Unity Catalog, et votre calcul (cluster) doit être activé pour le Unity Catalog. Le metastore Hive n’est actuellement pas pris en charge.

Publier des tables Azure Databricks dans un cloud Tableau

- Connectez-vous à votre espace de travail Databricks et cliquez sur

Catalogue dans la barre latérale pour ouvrir l’explorateur de catalogue.

Catalogue dans la barre latérale pour ouvrir l’explorateur de catalogue. - Sélectionnez une ressource de calcul dans la liste déroulante en haut à droite.

- Ouvrez un catalogue et sélectionnez le schéma ou les tables à publier. Ne pas sélectionner dans un metastore Hive ou dans le catalogue d’échantillons.

- Dans le coin supérieur droit, cliquez sur Utiliser avec les outils BI pour un schéma ou sur Ouvrir dans un tableau de bord pour une table.

- Sélectionnez Découvrir dans Tableau Cloud.

- Vérifiez que Calcul et Publier des données sont souhaitées, puis cliquez sur Découvrir dans Tableau Cloud.

- En 10 à 20 secondes, un nouvel onglet vous invite à vous connecter à votre compte Tableau Cloud.

- Après vous être connecté, vous accédez à la page Tableau, qui vous invite à vous reconnecter à Azure Databricks.

- Après vous être connecté à Azure Databricks, vous pouvez commencer à créer un tableau de bord dans la page de l’éditeur de classeur.

- Vous pouvez également cliquer sur le bouton Ouvrir dans Tableau Cloud pour ouvrir le classeur dans Tableau Cloud.

Fonctionnalités et notes

- Vous pouvez publier une table ou un schéma. Lors de la publication d’un schéma, vous devez sélectionner une table dans le volet Source de données Tableau.

- Databricks applique OAuth en tant que mode d’authentification lors de la publication sur Tableau Cloud.

- La source de données publiée est en mode brouillon et n'est enregistrée nulle part, vous devez l’enregistrer depuis Tableau Cloud pour la rendre accessible à d'autres personnes.

- Le lien de redirection retourné par Tableau expirera après environ 5 minutes.

Configuration requise pour connecter Tableau et Azure Databricks

Les détails de connexion pour une ressource de calcul ou un entrepôt SQL, en particulier les valeurs du nom d'hôte du serveur et du chemin HTTP.

Tableau Desktop 2019.3 et versions ultérieures.

Pilote ODBC Databricks 2.6.15 et versions ultérieures.

Un jeton Microsoft Entra ID (anciennement Azure Active Directory) (recommandé), un jeton d’accès personnel Azure Databricks, ou les informations d’identification de votre compte Microsoft Entra ID.

Remarque

En guise de bonne pratique de sécurité, quand vous vous authentifiez avec des outils, systèmes, scripts et applications automatisés, Databricks recommande d’utiliser des jetons d’accès personnels appartenant à des principaux de service et non des utilisateurs de l’espace de travail. Pour créer des jetons d’accès pour des principaux de service, consultez la section Gérer les jetons pour un principal de service.

Vous devez être attribué à l’un des rôles Microsoft Entra ID suivants :

Si le workflow de consentement administrateur est configuré, les non-administrateurs peuvent demander l’accès à Tableau lors de la connexion.

Connecter Azure Databricks à Tableau Desktop à l’aide de Partner Connect

Vous pouvez utiliser Partner Connect pour connecter une ressource de calcul ou un entrepôt SQL à Tableau Desktop en quelques clics seulement.

- Vérifiez que votre compte Azure Databricks, votre espace de travail et l’utilisateur connecté remplissent tous les prérequis de Partner Connect.

- Dans la barre latérale, cliquez sur l’icône

Place de marché.

Place de marché. - Dans intégrations Partner Connect, cliquez sur Tout afficher.

- Cliquez sur la vignette Tableau.

- Dans la boîte de dialogue Se connecter à un partenaire, pour Calcul, choisissez le nom de la ressource de calcul Azure Databricks que vous souhaitez connecter.

- Choisissez Télécharger le fichier de connexion.

- Ouvrez le fichier de connexion téléchargé pour démarrer Tableau Desktop.

- Dans Tableau Desktop, entrez vos informations d’authentification, puis cliquez sur Se connecter :

- Pour utiliser un jeton Microsoft Entra ID, entrez le jeton pour le Nom d’utilisateur et votre jeton Microsoft Entra ID pour le Mot de passe.

- Pour utiliser un jeton d’accès personnel Azure Databricks, entrez jeton dans Nom d’utilisateur et votre jeton d’accès personnel dans Mot de passe.

- Pour utiliser vos informations d’identification Microsoft Entra ID, cliquez sur Modifier la connexion, double-cliquez sur la base de données sous l’onglet Données, puis sélectionnez Microsoft Entra ID dans la liste d’Authentification.

Pour Tableau Desktop 2021.1 et versions ultérieures :

- Si vous n’utilisez pas un compte invité Microsoft Entra ID (anciennement Azure Active Directory) B2B ou Azure Databricks sur Azure Government, vous pouvez simplement entrer

https://login.microsoftonline.com/commoncomme point de terminaison OAuth.

- Si vous utilisez un compte invité Microsoft Entra ID B2B ou Azure Databricks sur Azure Government, contactez votre administrateur pour obtenir un principal de service Microsoft Entra ID dédié.

Remarque

Si vous n’êtes pas administrateur, une erreur d’approbation d’administrateur nécessaire s’affiche. Demandez à un administrateur d’application cloud ou à un administrateur d’application de vous accorder l’autorisation de vous connecter à Tableau, puis essayez de vous reconnecter.

Si votre compte Microsoft Entra ID dispose du workflow de consentement administrateur activé, Tableau Desktop vous invite à demander l’accès à Tableau. Une fois qu’un administrateur d’application cloud ou un administrateur d’application approuve la demande, essayez de vous reconnecter.

- Si vous n’utilisez pas un compte invité Microsoft Entra ID (anciennement Azure Active Directory) B2B ou Azure Databricks sur Azure Government, vous pouvez simplement entrer

Connecter Tableau Desktop à Azure Databricks

Suivez ces instructions pour vous connecter depuis Tableau Desktop à une ressource de calcul ou à un entrepôt SQL.

Remarque

Pour vous connecter plus rapidement à Tableau Desktop, utilisez Partner Connect.

Démarrez Tableau Desktop.

Cliquez sur File > New (Fichier > Nouveau).

Sous l’onglet Data (Données), cliquez sur Connect to Data (Se connecter aux données).

Dans la liste des connecteurs, cliquez sur Databricks.

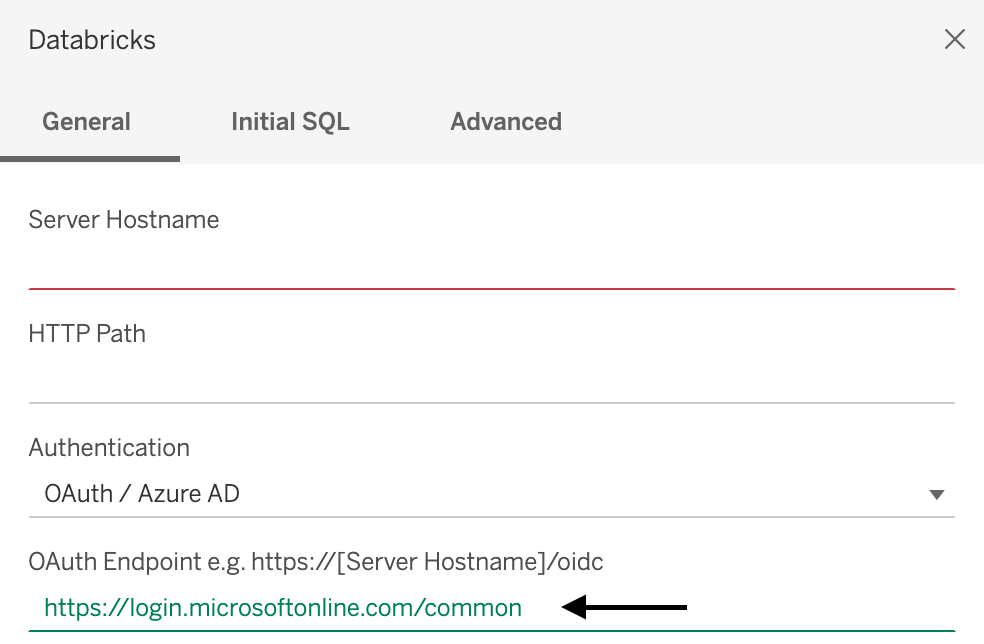

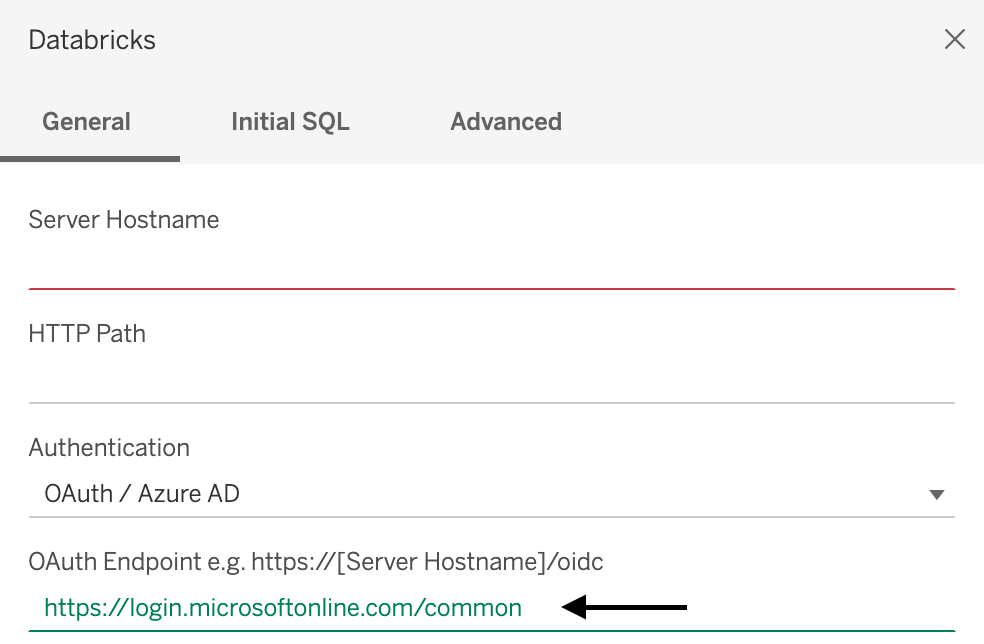

Entrez le nom d’hôte du serveur dans Server Hostname et le chemin HTTP dans HTTP Path.

Pour Authentication (Authentification), choisissez votre méthode d’authentification, entrez vos informations d’authentification, puis cliquez sur Sign In (Se connecter).

Pour utiliser un jeton Microsoft Entra ID, sélectionnez Jeton d’accès personnel et entrez votre jeton Microsoft Entra ID pour le mot de passe.

Pour utiliser un jeton d’accès personnel Azure Databricks, sélectionnez Jeton d’accès personnel, puis entrez votre jeton d’accès personnel dans Mot de passe.

Pour utiliser vos informations d’identification Microsoft Entra ID, sélectionnez Microsoft Entra ID.

Pour Tableau Desktop 2021.1 et versions ultérieures :

Si vous n’utilisez pas un compte invité Microsoft Entra ID (anciennement Azure Active Directory) B2B ou Azure Databricks sur Azure Government, vous pouvez simplement entrer

https://login.microsoftonline.com/commoncomme point de terminaison OAuth.

- Si vous utilisez un compte invité Microsoft Entra ID B2B ou Azure Databricks sur Azure Government, contactez votre administrateur pour obtenir un entrepôt Microsoft Entra ID dédié.

Remarque

Si vous n’êtes pas administrateur, une erreur d’approbation d’administrateur nécessaire s’affiche. Demandez à un administrateur d’application cloud ou à un administrateur d’application de vous accorder des autorisations pour vous connecter à Tableau, puis réessayez de vous connecter.

Si le workflow de consentement d’administrateur est activé pour votre compte Microsoft Entra ID, Tableau Desktop vous invite à demander l’accès à Tableau. Une fois qu’un administrateur d’application cloud ou un administrateur d’application approuve la demande, essayez de vous reconnecter.

Si le catalogue Unity est activé pour votre espace de travail, définissez également le catalogue par défaut. Sous l’onglet Avancé, pour les Propriétés de connexion, ajoutez

Catalog=<catalog-name>. Pour modifier le catalogue par défaut, dans l’onglet SQL initial, entrezUSE CATALOG <catalog-name>.

Connecter Tableau Cloud à Azure Databricks

Suivez ces instructions pour vous connecter à une ressource de calcul ou à un entrepôt SQL à partir de Tableau Cloud.

- Lancer un nouveau classeur

- Dans la barre des menus, cliquez sur Données>Nouvelle source de données.

- Dans la page Se connecter aux données, cliquez sur Connecteurs>Databricks.

- Dans la page Azure Databricks, entrez les valeurs du nom d’hôte du serveur et du chemin HTTP.

- Sélectionnez votre méthode d’authentification et entrez les informations demandées (le cas échéant).

- Cliquez sur Se connecter.

Tableau Server sur Linux

Modifiez /etc/odbcinst.ini pour inclure ce qui suit :

[Simba Spark ODBC Driver 64-bit]

Description=Simba Spark ODBC Driver (64-bit)

Driver=/opt/simba/spark/lib/64/libsparkodbc_sb64.so

Remarque

Tableau Server sur Linux recommande l’architecture de traitement 64 bits.

Publier et actualiser un classeur sur Tableau Cloud à partir de Tableau Desktop

Cet article explique comment publier un classeur à partir de Tableau Desktop dans Tableau Cloud, et comment le maintenir à jour lorsque la source de données est modifiée. Vous avez besoin d’un classeur dans Tableau Desktop ainsi que d’un compte Tableau Cloud.

- Extrayez les données du classeur depuis Tableau Desktop : dans Tableau Desktop, après avoir ouvert le classeur que vous voulez publier, cliquez sur Data >

<data-source-name>> Extract Data (Données > Extraire les données). - Dans la boîte de dialogue Extract Data (Extraire les données), cliquez sur Extract (Extraire).

- Accédez à l’emplacement de votre ordinateur local dans lequel vous souhaitez enregistrer les données extraites, puis cliquez sur Save (Enregistrer).

- Publiez la source de données du classeur dans Tableau Cloud : dans Tableau Desktop, cliquez sur Serveur > Publier la source de données >

<data-source-name>. - Si la boîte de dialogue Connexion à Tableau Server s’affiche, cliquez sur le lien Tableau Cloud et suivez les instructions à l’écran pour vous connecter à Tableau Cloud.

- Dans la boîte de dialogue Publier la source de données dans Tableau Online, en regard de Actualisation non activée, cliquez sur le lien Modifier.

- Dans la zone de menu volant qui s’affiche, pour Authentication (Authentification), remplacez Refresh Not Enabled (Actualisation non activée) par Allow refresh access (Autoriser l’actualisation).

- Cliquez n’importe où en dehors de ce menu volant pour le masquer.

- Sélectionnez Update workbook to use the published data source (Mettre à jour le classeur pour utiliser la source de données publiée).

- Cliquez sur Publier. La source de données s’affiche dans Tableau Cloud.

- Dans Tableau Cloud, dans la boîte de dialogue Publication terminée, cliquez sur Planification, puis suivez les instructions à l’écran.

- Publiez le classeur dans Tableau Cloud : dans Tableau Desktop, après avoir ouvert le classeur que vous souhaitez publier, cliquez sur Serveur > Publier le classeur.

- Dans la boîte de dialogue Publier le classeur dans Tableau Cloud, cliquez sur Publier. Le classeur s’affiche dans Tableau Cloud.

Tableau Cloud recherche les modifications apportées à la source de données en fonction de la planification que vous avez définie, et met à jour le classeur publié si des modifications sont détectées.

Pour plus d’informations, consultez ce qui suit sur le site web Tableau :

- Publier une source de données

- Procédure complète de publication d’un classeur

- Programmer des actualisations d’extrait tandis que vous publiez un classeur

Bonnes pratiques et résoudre des problèmes

Les deux actions fondamentales pour optimiser les requêtes Tableau sont les suivantes :

- Réduire le nombre d’enregistrements interrogés et visualisés dans un même graphique ou tableau de bord.

- Réduire le nombre de requêtes envoyées par Tableau dans un même graphique ou tableau de bord.

L’action que vous devez essayer en premier dépend de votre tableau de bord. Si un même tableau de bord contient plusieurs graphiques pour les différents utilisateurs, il est probable que Tableau envoie un trop grand nombre de requêtes à Azure Databricks. Si vous avez seulement quelques graphiques, mais que leur chargement est très long, il est probable que les enregistrements retournés par Azure Databricks soient trop nombreux pour être chargés correctement.

L’enregistrement des performances Tableau, disponible sur Tableau Desktop et Tableau Server, peut vous aider à identifier les goulots d’étranglement des performances en déterminant les processus qui provoquent une latence lorsque vous exécutez un flux de travail ou un tableau de bord particulier.

Activer l’enregistrement des performances pour déboguer un problème Tableau

Par exemple, si le problème se situe au niveau de l’exécution de la requête, vous savez qu’il s’agit d’un processus du moteur de données ou de la source de données que vous interrogez. Si la disposition visuelle s’exécute lentement, vous savez qu’il s’agit de VizQL.

Si l’enregistrement des performances indique que la latence se trouve dans la requête en cours d’exécution, il est probable que trop de temps soit pris par Azure Databricks pour retourner les résultats ou par la superposition ODBC/Connector qui traite les données dans SQL pour VizQL. Dans ce cas, vous devez analyser ce que vous retournez et tenter de modifier le modèle analytique de manière à avoir un tableau de bord par groupe, par segment ou par article, plutôt que d’essayer de tout mettre dans un tableau de bord et d’utiliser des filtres rapides.

Si les performances sont médiocres en raison du tri ou de la disposition visuelle, le problème peut être dû au nombre de marques que le tableau de bord tente de retourner. Azure Databricks peut retourner rapidement 1 million d’enregistrements. Cependant, Tableau peut ne pas être en mesure de calculer la disposition et de trier les résultats. Si cela pose problème, agrégez la requête et explorez les niveaux inférieurs. Vous pouvez également essayer une machine plus grande, car Tableau n’est limité que par les ressources physiques sur l’ordinateur sur lequel il est en cours d’exécution.

Pour obtenir un tutoriel détaillé sur l’enregistreur des performances, consultez Créer un enregistrement des performances.

Comparaison des performances Tableau Server et Tableau Desktop

En général, un workflow ne s’exécute pas plus rapidement sur Tableau Desktop que sur Tableau Server. Un tableau de bord qui ne s’exécute pas sur Tableau Desktop ne s’exécutera pas non plus sur Tableau Server.

L'utilisation de Desktop est une technique de dépannage beaucoup plus efficace, car Tableau Server comprend plus de processus à prendre en compte lors du dépannage. Si tout fonctionne dans Tableau Desktop mais pas dans Tableau Server, vous pouvez simplement en déduire que le problème est lié aux processus qui sont exécutés dans Tableau Server et non dans Tableau Desktop.

Configuration

Par défaut, les paramètres de l’URL de connexion remplacent ceux qui se trouvent dans le DSN ODBC Simba. Il existe deux façons de personnaliser les configurations ODBC dans Tableau :

Fichier

.tdspour une source de données unique :- Suivez les instructions fournies dans Enregistrer des sources de données afin d’exporter le fichier

.tdspour la source de données. - Recherchez la ligne de propriété

odbc-connect-string-extras=''dans le fichier.tds, puis définissez les paramètres. Par exemple, pour activerAutoReconnectetUseNativeQuery, vous pouvez modifier la ligne ainsi :odbc-connect-string-extras='AutoReconnect=1,UseNativeQuery=1'. - Rechargez le fichier

.tdsen établissant à nouveau la connexion.

La ressource de calcul est optimisée de manière à utiliser moins de mémoire segment pour la collecte de résultats volumineux. Elle peut donc distribuer plus de lignes par bloc de récupération que la valeur par défaut d’ODBC Simba. Ajoutez

RowsFetchedPerBlock=100000'à la valeur de la propriétéodbc-connect-string-extras.- Suivez les instructions fournies dans Enregistrer des sources de données afin d’exporter le fichier

Fichier

.tdcpour toutes les sources de données :- Si vous n’avez jamais créé de fichier

.tdc, vous pouvez ajouter TableauTdcExample.tdc au dossierDocument/My Tableau Repository/Datasources. - Ajoutez le fichier à toutes les installations Tableau Desktop des développeurs, afin qu’il fonctionne lorsque les tableaux de bord sont partagés.

- Si vous n’avez jamais créé de fichier

Optimiser les graphiques (feuilles de calcul)

Il existe un certain nombre d’optimisations de graphiques tactiques qui peuvent vous aider à améliorer les performances de vos feuilles de calcul Tableau.

Pour les filtres qui ne changent pas souvent et avec lesquels aucune interaction n’est prévue, utilisez des filtres de contexte pour accélérer l’exécution.

Une autre bonne règle à suivre consiste à utiliser des instructions if/else plutôt que des instructions case/when dans vos requêtes.

Tableau peut effectuer un pushdown de filtres dans les sources de données pour accélérer les requêtes. Pour plus d’informations sur le pushdown de filtres dans les sources de données, consultez Filtering Across Multiple Data Sources Using a Parameter et Filtrer les données de plusieurs sources de données.

Essayez d’éviter les calculs de table, car ils analysent le jeu de données complet. Pour plus d’informations sur les calculs de table, consultez Transformer des valeurs avec des calculs de table.

Optimiser les tableaux de bord

Voici un certain nombre d’astuces et d’exercices de dépannage que vous pouvez appliquer pour améliorer les performances de votre tableau de bord Tableau.

Une source courante de problèmes avec les tableaux de bord Tableau qui sont connectés à Azure Databricks est l’utilisation de filtres rapides sur des tableaux de bord qui distribuent un certain nombre d’utilisateurs, de fonctions ou de segments différents. Vous pouvez attacher des filtres rapides à tous les graphiques du tableau de bord. Un filtre rapide appliqué à un tableau de bord comprenant cinq graphiques entraînera l’envoi d’un minimum de 10 requêtes à Azure Databricks. Cela peut se traduire par une augmentation du nombre de requêtes lorsque d’autres filtres sont ajoutés. En outre, cela peut entraîner des problèmes de performances car Spark n’est pas conçu pour gérer de nombreuses requêtes simultanées démarrant au même moment. Cela devient plus problématique lorsque le cluster Azure Databricks ou l’entrepôt SQL que vous utilisez n’est pas suffisamment grand pour gérer le volume élevé de requêtes.

Dans un premier temps, nous vous recommandons d’utiliser l’enregistrement des performances Tableau pour résoudre le problème d’origine.

Si les performances sont médiocres en raison du tri ou de la disposition visuelle, le problème peut être dû au nombre de marques que le tableau de bord tente de retourner. Azure Databricks peut retourner rapidement 1 million d’enregistrements. Cependant, Tableau peut ne pas être en mesure de calculer la disposition et de trier les résultats. Si cela pose problème, agrégez la requête et explorez les niveaux inférieurs. Vous pouvez également essayer une machine plus grande, car Tableau est limité uniquement par les ressources physiques sur l’ordinateur sur lequel il s’exécute.

Pour plus d’informations sur l’exploration des données dans Tableau, consultez Explorer en détail.

Si vous voyez de nombreuses marques granulaires, il s’agit souvent d’un modèle analytique médiocre, car il ne fournit pas d’insights. L’approfondissement à partir de niveaux supérieurs d’agrégation a plus de sens et réduit le nombre d’enregistrements qui doivent être traités et visualisés.

Utiliser des actions pour optimiser les tableaux de bord

Utilisez Tableau _actions pour cliquer sur une marque (par exemple, un état sur une carte) et accéder à un autre tableau de bord qui filtre en fonction de l'état que vous avez cliqué. L’utilisation de _actions réduit la nécessité de plusieurs filtres sur un tableau de bord et le nombre d’enregistrements qui doivent être générés. (Vous définissez une action pour pas générer des enregistrements tant qu’il n’obtient pas un prédicat sur lequel filtrer.

Pour plus d’informations, consultez Actions et 6 Tips to Make Your Dashboards More Performant.

Mise en cache

La mise en cache des données est un bon moyen d’améliorer les performances des feuilles de calcul et des tableaux de bord.

Mise en cache dans Tableau

Tableau effectue une mise en cache en quatre couches avant de revenir aux données, qu’il s’agisse de données présentes dans une connexion active ou dans un extrait :

- Vignettes: si quelqu’un charge le même tableau de bord et que rien ne change, Tableau tente de réutiliser les mêmes vignettes pour les graphiques. Ceci est similaire aux vignettes Google Maps.

- modèle: si le cache de vignettes ne peut pas être utilisé, le cache de modèles de calculs mathématiques est utilisé pour générer des visualisations. Tableau Server tente d’utiliser les mêmes modèles.

- Extrait : les résultats agrégés des requêtes sont également stockés. Il s’agit du troisième niveau de « défense ». Si une requête retourne Sum(Sales), Count(orders), Sum(Cost) dans une requête précédente et qu’une requête suivante souhaite uniquement Sum(Sales), Tableau prend le résultat et l’utilise.

- cache natif: si la requête est identique à une autre, Tableau utilise les mêmes résultats. Il s’agit du dernier niveau de mise en cache. En cas d’échec, Tableau accède aux données.

Fréquence de mise en cache dans Tableau

Tableau comprend des paramètres d’administration qui permettent de configurer la fréquence de la mise en cache. Si le serveur est configuré sur Refresh Less Often (Actualisation moins fréquente), Tableau conserve les données dans le cache pendant 12 heures. Si le serveur est défini sur Actualiser plus souvent, Tableau accède aux données à chaque actualisation de page.

Les clients qui utilisent à plusieurs reprises le même tableau de bord, par exemple, « rapports de pipeline du lundi matin », doivent être sur un serveur configuré pour se rafraîchir moins souvent afin que tous les tableaux de bord utilisent le même cache.

Réchauffement du cache dans Tableau

Dans Tableau, vous pouvez réchauffer le cache en configurant un abonnement pour que le tableau de bord soit envoyé avant de vouloir afficher le tableau de bord. (Le tableau de bord doit être rendu pour générer l’image de messagerie de l’abonnement.) Consultez Préchargement du cache du serveur Tableau à l’aide d’abonnements.

Tableau Desktop : erreur The drivers... are not properly installed

Problème : lorsque vous essayez de connecter Tableau Desktop à Databricks, Tableau affiche un message d’erreur dans la boîte de dialogue de connexion avec un lien vers la page de téléchargement du pilote, où vous pouvez trouver des liens vers les pilotes ainsi que des instructions d’installation.

Cause : votre installation de Tableau Desktop n’exécute pas un pilote pris en charge.

Résolution : Téléchargez le pilote ODBC Databricks version 2.6.15 ou ultérieure.

Voir aussi : Erreur « Les pilotes... ne sont pas installés correctement » sur le site web de Tableau.

Contraintes de clé primaire et de clé étrangère

Pour propager les contraintes de clé primaire (PK) et de clé étrangère (FK) depuis Azure Databricks à Tableau, vous devez comprendre les fonctionnalités et limitations des deux plateformes en ce qui concerne les contraintes.

Comprendre les contraintes Azure Databricks

Azure Databricks prend en charge les contraintes de clé primaire et étrangère à partir de Databricks Runtime 15.2. Ces contraintes sont informationnelles et non appliquées par défaut, ce qui signifie qu’elles n’empêchent pas les violations d’intégrité des données, mais peuvent être utilisées pour optimiser les requêtes et fournir des métadonnées sur les relations de données. Consultez Déclarer des relations de clé primaire et de clé étrangère.

Comprendre que Tableau utilise des contraintes pour créer des relations de table

Tableau n’applique pas directement les contraintes de clé primaire et étrangère. Au lieu de cela, Tableau utilise des relations pour modéliser les connexions de données. Pour utiliser des contraintes dans Tableau, vous devez comprendre que le modèle de données de Tableau offre deux niveaux de modélisation : une couche logique et une couche physique. Consultez Modèle de données de Tableau. Les implications de ce modèle de données à deux niveaux sur les contraintes Azure Databricks reconnues comme des relations dans Tableau sont décrites ci-dessous.

Connexion d’Azure Databricks à Tableau

Lorsque vous connectez Azure Databricks à Tableau, Tableau tente de créer des relations au niveau de la couche physique entre les tables en fonction des contraintes de clés existantes et des champs correspondants. Tableau tente automatiquement de détecter et de créer des relations au niveau de la couche physique en fonction des contraintes de clé primaire et étrangère définies dans Azure Databricks. Si aucune contrainte de clé n’est définie, Tableau utilise des noms de colonnes correspondants pour générer automatiquement des jointures. Au niveau de la couche logique, seules les correspondances de nom à une seule colonne sont utilisées pour déterminer une relation. Au niveau de la couche physique, ce nom de colonne correspondant détecte les relations de clés simples (à colonne unique) et composites (à plusieurs colonnes).

Si Tableau ne peut pas déterminer les champs correspondants, vous devez spécifier manuellement la relation de jointure entre les deux tables de la couche physique en fournissant les colonnes, la condition et le type de contrainte. Pour passer de la couche logique de l’interface utilisateur à la couche physique, double-cliquez sur la table au niveau de la couche logique.