Travaux en échec ou exécuteurs supprimés

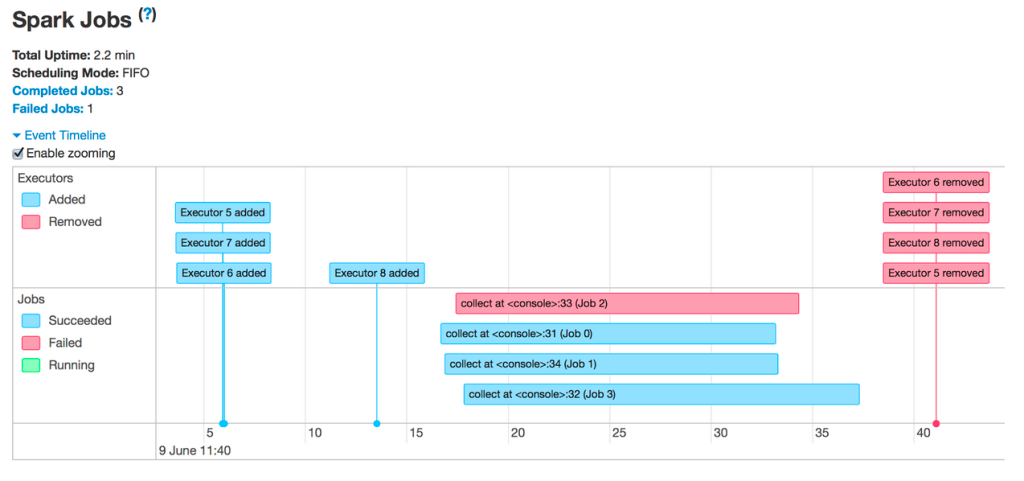

Vous voyez donc des travaux en échec ou des exécuteurs supprimés :

Les raisons les plus courantes de la suppression d’exécuteurs sont les suivantes :

- Mise à l’échelle automatique : dans ce cas, c’est attendu et ce n’est donc pas une erreur. Consultez Activer la mise à l’échelle automatique.

- Pertes d’instance Spot : le fournisseur de cloud récupère vos machines virtuelles. Vous pouvez en savoir plus sur les instances Spot ici.

- Les exécuteurs sont à court de mémoire

Travaux en échec

Si vous voyez des travaux en échec, cliquez sur ceux-ci pour accéder à leurs pages. Faites ensuite défiler vers le bas pour voir l’étape qui a échoué et la raison de l’échec :

Vous pouvez obtenir une erreur générique. Cliquez sur le lien dans la description pour voir si vous pouvez obtenir plus d’informations :

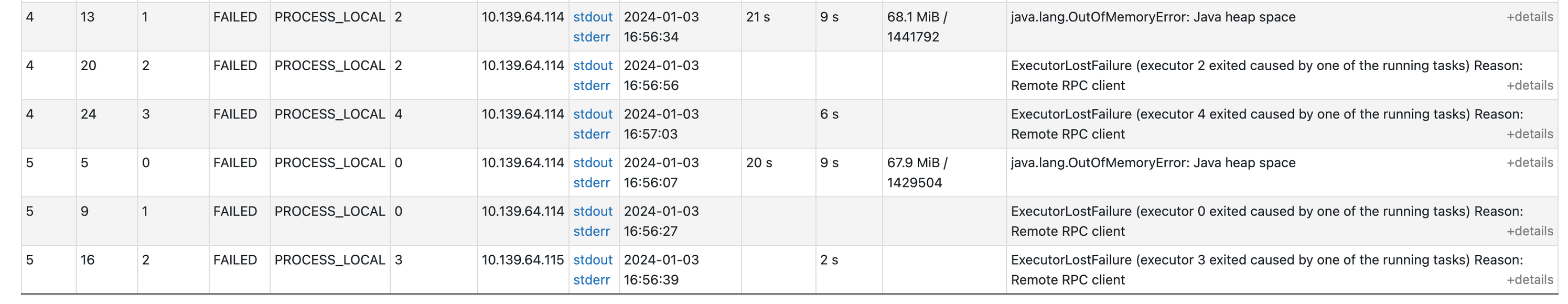

Si vous faites défiler cette page vers le bas, vous verrez pourquoi chaque tâche a échoué. Dans le cas présent, il apparaît qu’il existe un problème de mémoire :

Exécuteurs en échec

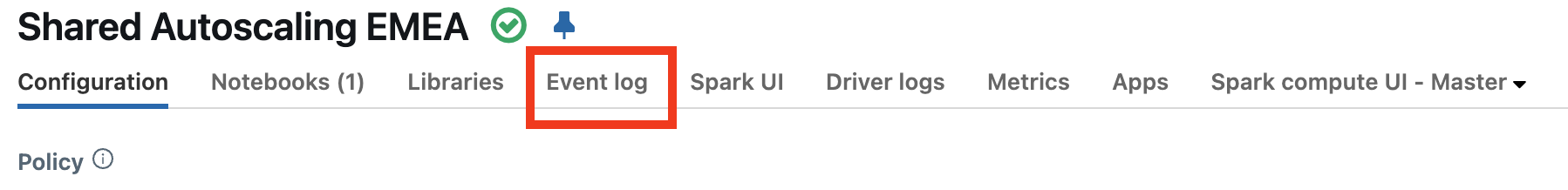

Pour savoir pourquoi vos exécuteurs échouent, vous devez d’abord vérifier le journal des événements du calcul pour voir s’il y a une explication de l’échec des exécuteurs. Par exemple, il est possible vous utilisiez des instances spot et que le fournisseur les reprenne.

Vérifiez s’il existe des événements expliquant la perte des exécuteurs. Par exemple, vous pouvez voir des messages indiquant que le cluster est en cours de redimensionnement ou que des instances spot sont perdues.

- Si vous utilisez des instances spot, consultez Perdre des instances spot.

- Si votre calcul a été redimensionné avec la mise à l’échelle automatique, c’est attendu et ce n’est donc pas une erreur. Consultez En savoir plus sur le redimensionnement des clusters.

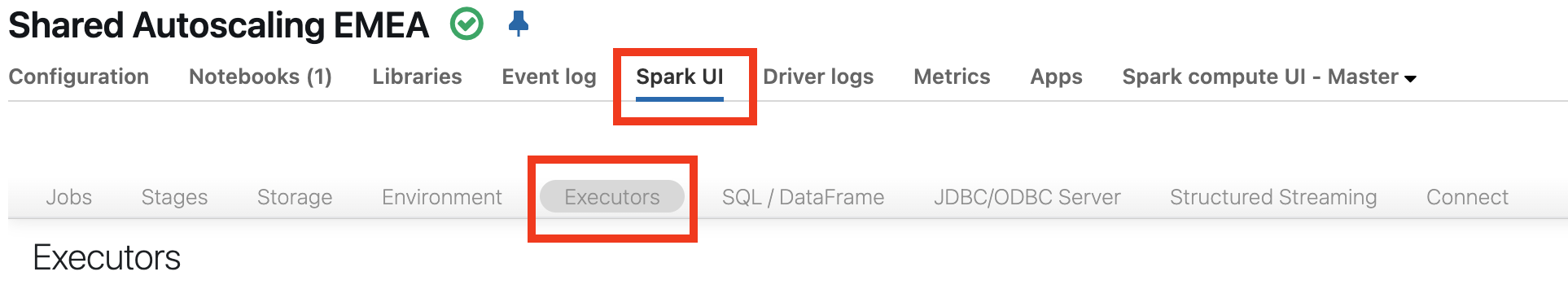

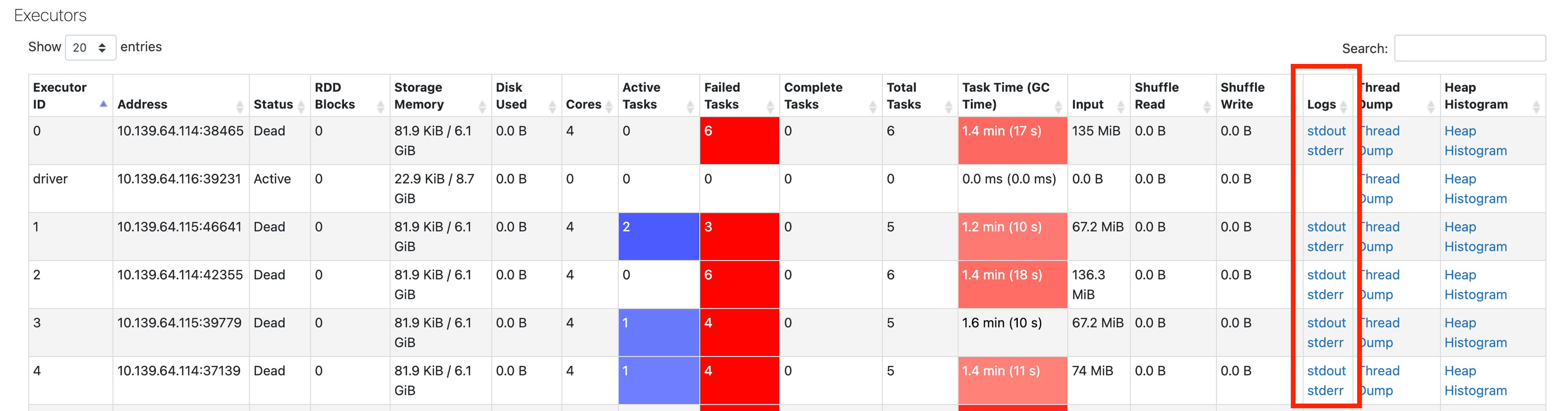

Si vous ne voyez aucune information dans le journal des événements, revenez à l’interface utilisateur Spark, puis cliquez sur l’onglet Exécuteurs :

Vous pouvez obtenir ici les journaux provenant des exécuteurs en échec :

Étape suivante

Si vous êtes arrivé jusqu’ici, l’explication la plus probable est un problème de mémoire. L’étape suivante consiste à examiner les problèmes de mémoire. Consultez Problèmes de mémoire Spark.