Architecture des data lakehouse : Databricks well-architected framework

Cet ensemble d’articles Architecture des data lakehouse fournit des principes et des meilleures pratiques pour l’implémentation et l’exploitation d’un lakehouse à l’aide d’Azure Databricks.

Databricks well-architected framework pour le lakehouse

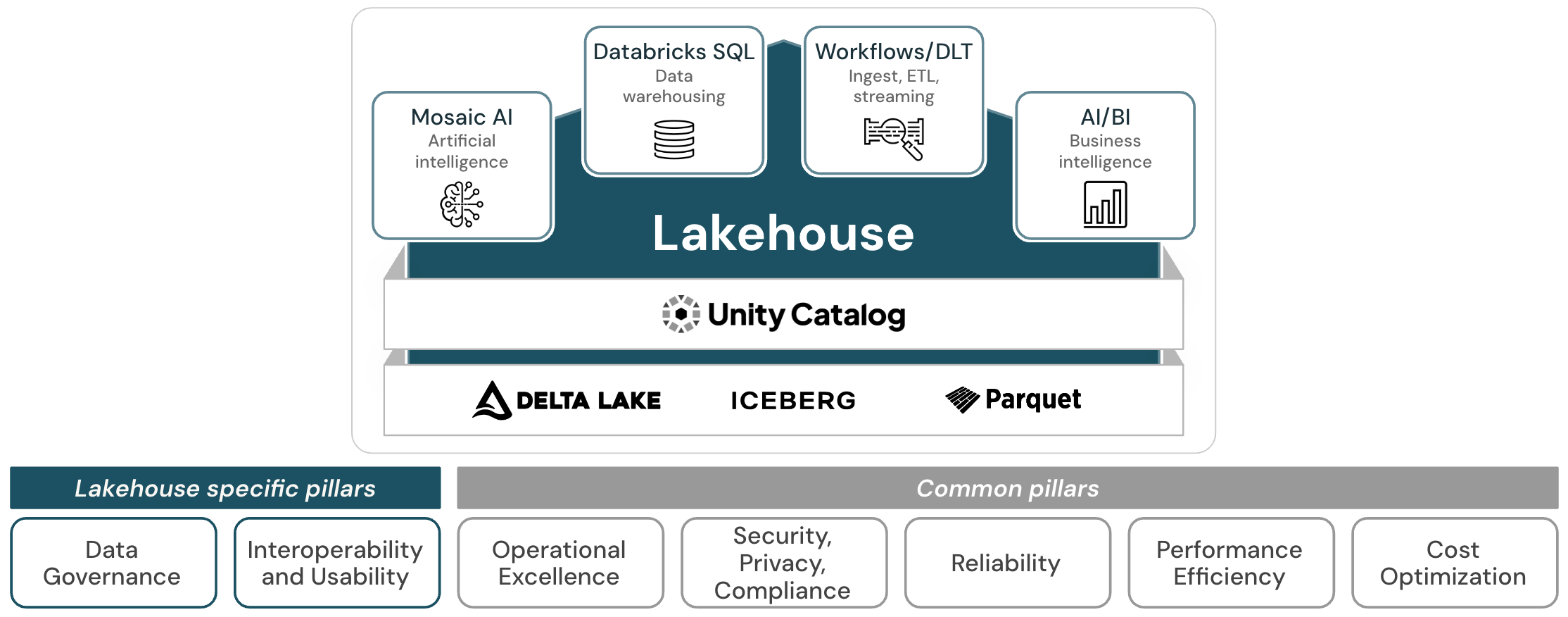

Le lakehouse bien architecturé se compose de sept piliers qui décrivent différents domaines de préoccupation pour l’implémentation d’un data lakehouse dans le cloud :

Gouvernance des données et de l’IA

Supervision pour vous assurer que les données et l’IA apportent de la valeur et prennent en charge votre stratégie métier.

Interopérabilité et facilité d’utilisation

Capacité du lakehouse à interagir avec les utilisateurs et d’autres systèmes.

Excellence opérationnelle

Tous les processus d’exploitation qui maintiennent l’exécution du lakehouse en production.

Sécurité, confidentialité et conformité

Protégez l’application Azure Databricks, les charges de travail client et les données client contre les menaces.

Fiabilité

Capacité d’un système à récupérer après des défaillances et à continuer de fonctionner.

Efficacité des performances

Capacité d’un système à s’adapter aux variations de la charge.

Optimisation des coûts

Gestion des coûts pour optimiser la valeur délivrée.

Le lakehouse bien architecturé étend le Microsoft Azure Well-Architected Framework à la Databricks Data Intelligence Platform et partage les piliers « Excellence opérationnelle », « Sécurité » (en tant que « Sécurité, confidentialité et conformité »), « Fiabilité », « Efficacité des performances » et « Optimisation des coûts ».

Pour ces cinq piliers, les principes et les meilleures pratiques du framework cloud s’appliquent toujours au lakehouse. Le lakehouse bien architecturé étend ces piliers avec des principes et des meilleures pratiques spécifiques au lakehouse et qui sont importantes pour construire un lakehouse efficace et performant.

Piliers spécifiques au lakehouse

Les piliers «Gouvernance des données et de l'IA» et «Interopérabilité et facilité d’utilisation» couvrent des préoccupations spécifiques à la lakehouse.

La gouvernance des données et de l’IA encapsule les stratégies et pratiques implémentées pour gérer en toute sécurité les données et les ressources IA au sein d’une organisation. L’un des aspects fondamentaux d’un lakehouse est la gouvernance centralisée des données et de l’IA : Le lakehouse unifie l’entreposage des données et les cas d’usage de l’IA sur une plateforme unique. Cela simplifie la pile de données moderne en éliminant les silos de données qui séparent et compliquent traditionnellement l’ingénierie des données, l’analytique, la BI, la science des données et le Machine Learning. Pour simplifier ces tâches de gouvernance, lakehouse offre une solution de gouvernance unifiée pour les données, l’analytique et l’IA. En minimisant les copies de vos données et en passant à une couche de traitement des données unique où tous vos contrôles de gouvernance des données et ia peuvent s’exécuter ensemble, vous améliorez vos chances de rester en conformité et de détecter une violation de données.

Un autre élément important du lakehouse est de fournir une expérience utilisateur exceptionnelle pour tous les personnages qui travaillent avec elle, et de pouvoir interagir avec un large écosystème de systèmes externes. Azure dispose déjà d’un large éventail d’outils de données qui effectuent la plupart des tâches dont une entreprise axée sur les données peut avoir besoin. Toutefois, ces outils doivent être correctement assemblés pour fournir toutes les fonctionnalités, chaque service offrant une expérience utilisateur différente. Cette approche peut entraîner des coûts d’implémentation élevés et ne fournit généralement pas la même expérience utilisateur qu’une plateforme native lakehouse : les utilisateurs sont limités par des incohérences entre les outils et un manque de fonctionnalités de collaboration, et doivent souvent passer par des processus complexes pour accéder au système et ainsi aux données.

Un lakehouse intégré de l’autre côté offre une expérience utilisateur cohérente dans toutes les charges de travail et facilite donc davantage l’utilisation. Cela réduit les coûts de formation et d’intégration et améliore la collaboration entre les fonctions. De plus, de nouvelles fonctionnalités sont automatiquement ajoutées au fil du temps pour améliorer davantage l’expérience utilisateur, sans avoir à investir des ressources et budgets internes.

Une approche multicloud peut être une stratégie délibérée d’une entreprise ou résulter des fusions et acquisitions ou des unités commerciales indépendantes choisissant différents fournisseurs de cloud. Dans ce cas, l’utilisation d’un lakehouse multicloud entraîne une expérience utilisateur unifiée sur tous les clouds. Cela réduit la prolifération des systèmes au sein de l’entreprise, ce qui réduit à son tour les compétences et les exigences de formation des employés impliqués dans des tâches axées sur les données.

Enfin, dans un monde en réseau avec des processus métier interentreprises, les systèmes doivent fonctionner ensemble aussi facilement que possible. Le degré d’interopérabilité est un critère crucial ici, et les données les plus récentes, en tant que ressource principale de toute entreprise, doivent circuler en toute sécurité entre les systèmes de partenaires internes et externes.