(Hérité) Obtenir des commentaires sur la qualité d’une application agentique

Important

Cette fonctionnalité est disponible en préversion publique.

Important

Databricks vous recommande d’utiliser la version actuelle de l’application Review App.

Cet article vous montre comment utiliser l’application Databricks Review pour recueillir les commentaires des évaluateurs humains sur la qualité de votre application agentique. Il couvre les points suivants :

- Comment déployer l’application de révision.

- Comment les réviseurs utilisent l’application pour fournir des commentaires sur les réponses de l’application agentique.

- Comment les experts peuvent consulter les conversations journalisées pour fournir des suggestions d’amélioration et d’autres commentaires à l’aide de l’application.

En quoi consiste une évaluation humaine ?

L’application de révision Databricks met en scène le LLM dans un environnement où les parties prenantes d’experts peuvent interagir avec elle , en d’autres termes, avoir une conversation, poser des questions, fournir des commentaires, et ainsi de suite. L’application de révision consigne toutes les questions, réponses et commentaires dans une table d’inférence afin de pouvoir analyser plus en détail les performances du LLM. De cette façon, l’application de révision permet de garantir la qualité et la sécurité des réponses fournies par votre application.

Les parties prenantes peuvent discuter avec le bot de l'application et fournir des commentaires sur ces conversations, ou sur les journaux d'activité historiques, les traces organisées ou les résultats de l'agent.

Spécifications

Les tables d'inférence doivent être activées sur le point de terminaison qui sert l’agent.

Chaque réviseur humain doit avoir accès à l’espace de travail de l’application de révision ou être synchronisé avec votre compte Databricks avec SCIM. Consultez la section suivante, configurer les autorisations pour utiliser l’application de révision.

Les développeurs doivent installer le kit de développement logiciel (SDK)

databricks-agentspour configurer les autorisations et configurer l’application de révision.%pip install databricks-agents dbutils.library.restartPython()

Configurer des autorisations pour utiliser l’application de révision

Remarque

Les réviseurs humains n’ont pas besoin d’accéder à l’espace de travail pour utiliser l’application de révision.

Vous pouvez accorder l’accès à l’application de révision à n’importe quel utilisateur de votre compte Databricks, même s’ils n’ont pas accès à l’espace de travail qui contient l’application de révision.

- Pour les utilisateurs qui n’ont pas accès à l’espace de travail, un administrateur de compte utilise le provisionnement SCIM au niveau du compte pour synchroniser automatiquement les utilisateurs et les groupes de votre fournisseur d’identité vers votre compte Azure Databricks. Vous pouvez également inscrire manuellement ces utilisateurs et groupes pour leur donner accès lorsque vous configurez des identités dans Databricks. Consultez Synchroniser des utilisateurs et des groupes à partir de Microsoft Entra ID à l’aide de SCIM.

- Pour les utilisateurs qui ont déjà accès à l’espace de travail qui contient l’application de révision, aucune configuration supplémentaire n’est requise.

L’exemple de code suivant montre comment accorder aux utilisateurs l’autorisation d’examiner l’application pour un agent. Le users paramètre prend une liste d’adresses e-mail.

from databricks import agents

# Note that <user_list> can specify individual users or groups.

agents.set_permissions(model_name=<model_name>, users=[<user_list>], permission_level=agents.PermissionLevel.CAN_QUERY)

Pour passer en revue un journal de conversation, un utilisateur doit disposer de l’autorisation CAN_REVIEW .

Déployer l’application de révision

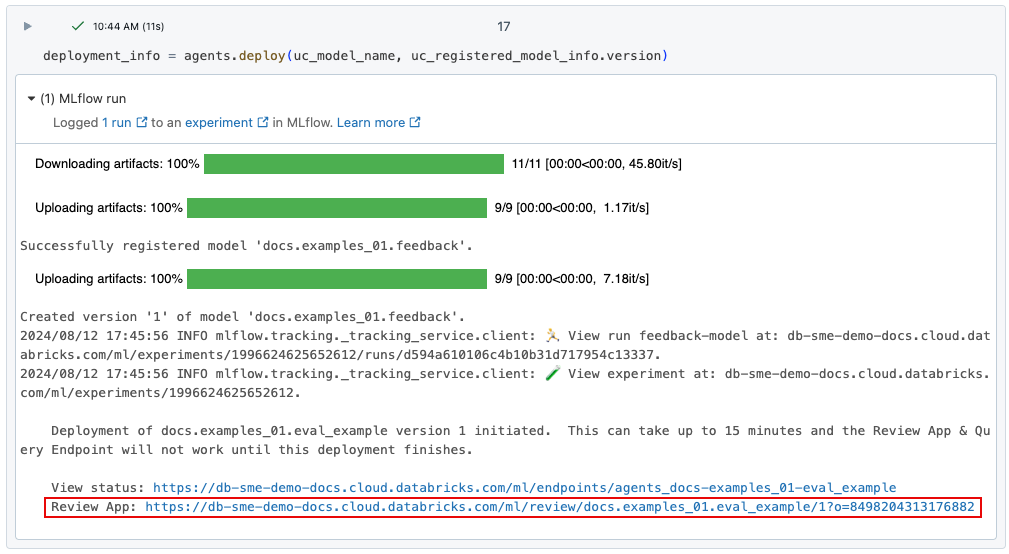

Lorsque vous déployez un agent à l’aide de agents.deploy(), l’application de révision est automatiquement activée et déployée. La sortie de la commande montre l’URL de l’application de révision. Pour plus d’informations sur le déploiement d’un agent, voir Déployer un agent pour une application d’IA générative.

Si vous avez perdu le lien vers le déploiement, vous pouvez le retrouver en utilisant list_deployments().

from databricks import agents

deployments = agents.list_deployments()

deployments

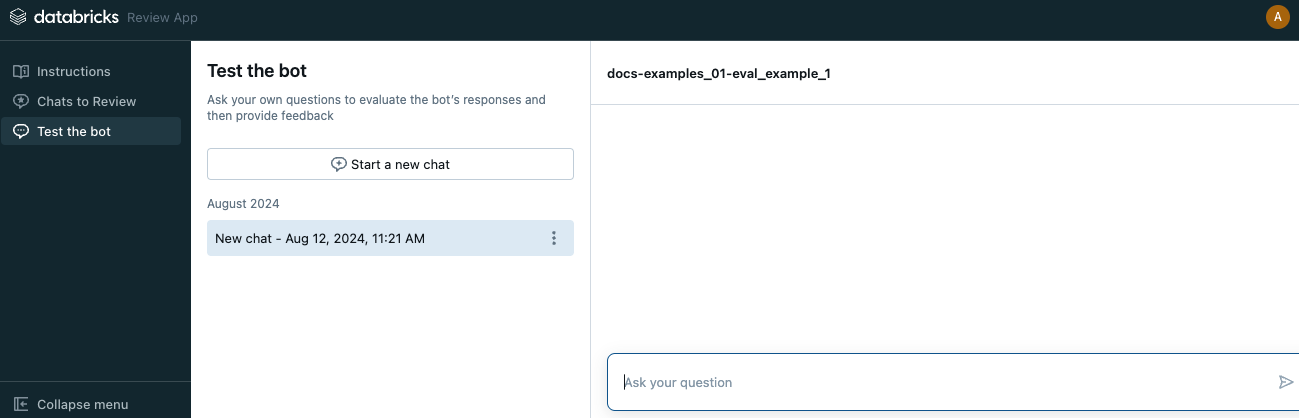

Interface utilisateur de l’application d’évaluation

Pour ouvrir l’application d’évaluation, cliquez sur l’URL fournie. L'interface utilisateur de l'application d'évaluation comporte trois onglets dans la barre latérale gauche.

- Instructions Affiche les instructions destinées au réviseur. Consultez Fournir des instructions aux réviseurs.

- Conversations à consulter Affiche les journaux des interactions des réviseurs avec l’application pour que les experts puissent les évaluer. Consultez Examen expert des journaux d’activité des interactions d’autres utilisateurs avec l’application.

- Tester le bot Permet aux réviseurs de discuter avec l’application et d’envoyer des révisions de ses réponses. Consultez Conversation avec l’application et envoi de révisions.

Lorsque vous ouvrez l’application de révision, la page d’instructions s’affiche.

- Pour discuter avec le bot, cliquez sur Démarrer la révision ou sélectionnez Tester le bot dans la barre latérale gauche. Pour plus d’informations, consultez Conversation avec l’application et envoi de révisions.

- Pour consulter l'historique des chats qui ont été mis à votre disposition, sélectionnez Chats à examiner dans la barre latérale. Pour plus de détails, consultez Examen par un expert des journaux d’interactions d’autres utilisateurs avec l’application. Pour savoir comment rendre les journaux de conversation disponibles à partir de l’application de révision, consultez Rendre les journaux de conversation disponibles pour l’évaluation par les réviseurs experts.

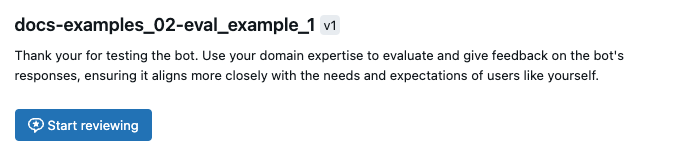

Fournir des instructions aux réviseurs

Pour fournir un texte personnalisé aux instructions affichées pour les évaluateurs, utilisez le code suivant :

from databricks import agents

agents.set_review_instructions(uc_model_name, "Thank you for testing the bot. Use your domain expertise to evaluate and give feedback on the bot's responses, ensuring it aligns with the needs and expectations of users like yourself.")

agents.get_review_instructions(uc_model_name)

Discutez avec l’application et soumettez des commentaires

Pour discuter avec l’application et soumettre des commentaires :

Cliquez sur Tester le bot dans la barre latérale gauche.

Tapez votre question dans la zone, puis appuyez sur Retour ou Entrée sur votre clavier, ou cliquez sur la flèche dans la zone.

L’application affiche sa réponse à votre question et les sources qu’elle a utilisées pour trouver la réponse.

Remarque

Si l’agent utilise un récupérateur, les sources de données sont identifiées par le champ

doc_uridéfini par le schéma du récupérateur défini lors de la création de l’agent. Consultez Définir le schéma de l’extracteur.Examinez la réponse de l’application et sélectionnez Oui, Non ou Je ne sais pas.

L’application demande des informations supplémentaires. Cochez les cases appropriées ou tapez vos commentaires dans le champ fourni.

Vous pouvez également modifier la réponse directement pour donner une meilleure réponse. Pour modifier la réponse, cliquez sur Modifier la réponse, apportez vos modifications dans la boîte de dialogue, puis cliquez sur Enregistrer, comme illustré dans la vidéo suivante.

Cliquez sur Terminé pour enregistrer vos retours d’expérience.

Continuez à poser des questions pour fournir des commentaires supplémentaires.

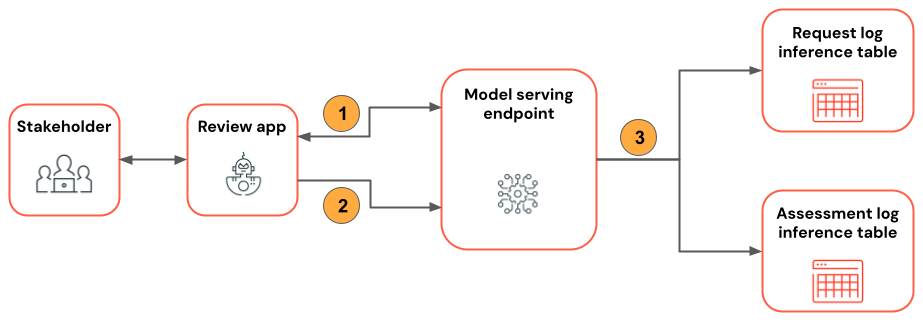

Le diagramme suivant illustre ce flux de travail.

- En utilisant l’application d’évaluation, l’évaluateur converse avec l’application agentique.

- À l’aide de l’application de révision, le réviseur fournit des commentaires sur les réponses de l’application.

- Toutes les demandes, réponses et commentaires sont journalisées dans les tables d’inférence.

Rendre les journaux de conversation disponibles pour l’évaluation par les réviseurs experts

Lorsqu’un utilisateur interagit avec l’application à l’aide de l’API REST ou de l’application de révision, toutes les demandes, réponses et commentaires supplémentaires sont enregistrés dans les tables d’inférence. Les tables d’inférence se trouvent dans le même catalogue et schéma du catalogue Unity où le modèle a été inscrit et sont nommées <model_name>_payload, <model_name>_payload_assessment_logs et <model_name>_payload_request_logs. Pour plus d’informations sur ces tables, y compris les schémas, consultez Surveiller les agents déployés.

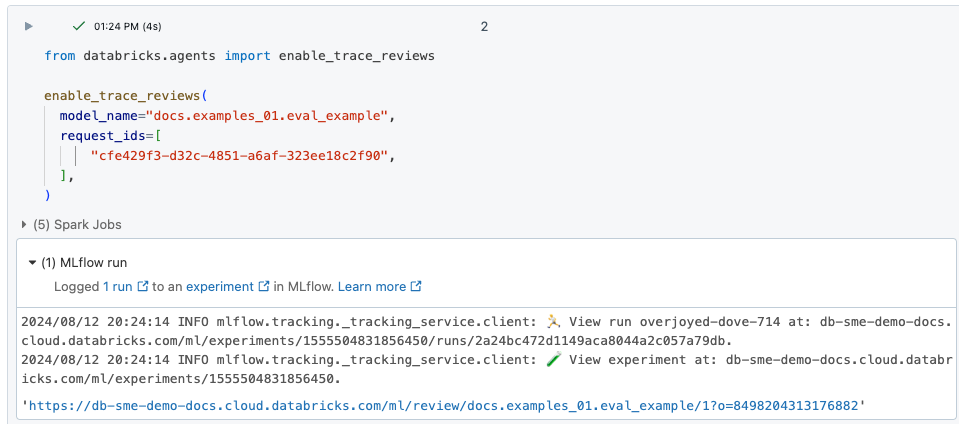

Pour charger ces logs dans l’application de révision pour qu’ils puissent être évalués par des réviseurs experts, vous devez d’abord trouver request_id et activer la révision pour ce request_id comme suit :

Recherchez les

request_idà examiner dans la table d’inférence<model_name>_payload_request_logs. La table d’inférence se trouve dans le même catalogue et schéma Unity Catalog que celui dans lequel le modèle a été enregistré.Utilisez du code similaire à ce qui suit pour charger les journaux d’activité de révision dans l’application de révision :

from databricks import agents agents.enable_trace_reviews( model_name=model_fqn, request_ids=[ "52ee973e-0689-4db1-bd05-90d60f94e79f", "1b203587-7333-4721-b0d5-bba161e4643a", "e68451f4-8e7b-4bfc-998e-4bda66992809", ], )La cellule de résultat comporte un lien vers l’application d’évaluation, et les journaux sélectionnés sont chargés pour être examinés.

Examen expert des journaux à partir des interactions des autres utilisateurs avec l’application

Pour passer en revue les journaux des conversations précédentes, les journaux doivent avoir été activés pour révision. Consultez Rendre les journaux de conversation disponibles pour l’évaluation par les réviseurs experts.

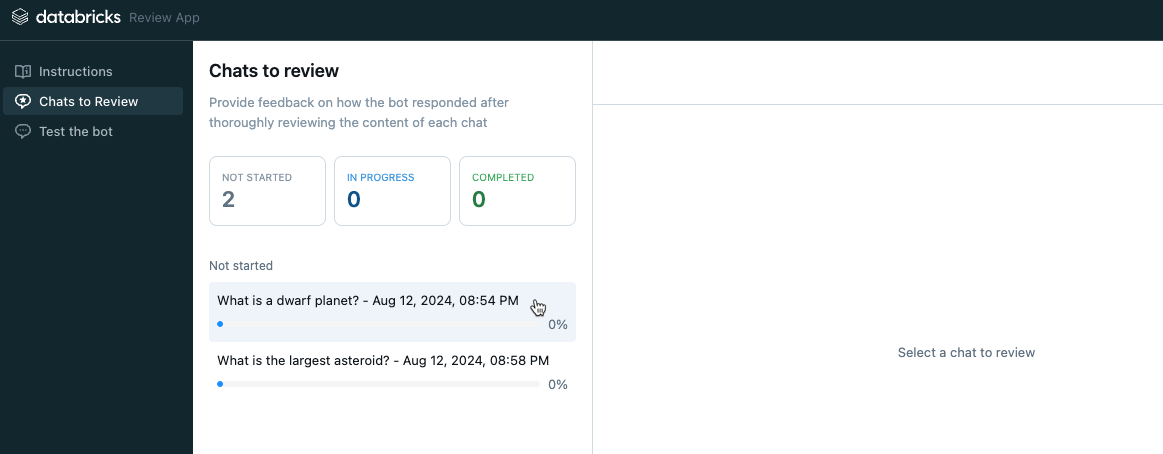

Dans la barre latérale gauche de l’application de révision, sélectionnez Conversations à réviser. Les requêtes activées sont affichées.

Cliquez sur une demande pour l’afficher pour révision.

Vérifiez la demande et la réponse. L’application affiche également les sources utilisées pour référence. Vous pouvez cliquer sur ces éléments pour consulter la référence et fournir des commentaires sur la pertinence de la source.

Pour fournir des commentaires sur la qualité de la réponse, sélectionnez Oui, Non, ou Je ne sais pas.

L’application demande des informations supplémentaires. Cochez les cases appropriées ou tapez vos commentaires dans le champ fourni.

Vous pouvez également modifier la réponse directement pour donner une meilleure réponse. Pour modifier la réponse, cliquez sur Modifier la réponse, apportez vos modifications dans la boîte de dialogue et cliquez sur Enregistrer. Consultez Conversation avec l’application et envoi de révisions pour une vidéo qui montre le processus.

Cliquez sur Terminé pour enregistrer vos retours d’expérience.

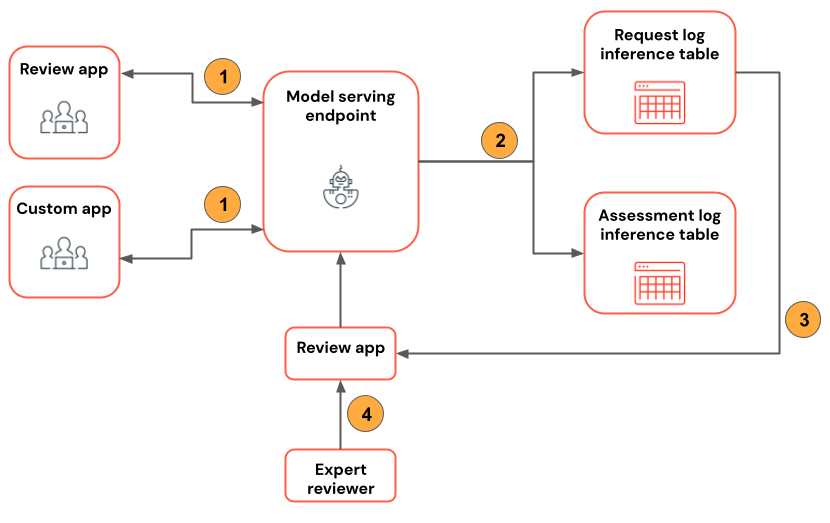

Le diagramme suivant illustre ce flux de travail.

- En utilisant l’application d’évaluation ou une application personnalisée, les évaluateurs conversent avec l’application agentique.

- Toutes les demandes et les réponses sont enregistrées dans des tables d’inférence.

- Le développeur d’applications utilise

enable_trace_reviews([request_id])(oùrequest_idest issu de la table d’inférence<model_name>_payload_request_logs) pour publier des journaux de conversation dans l’application de révision. - En utilisant l’application d’évaluation, l’expert examine les journaux et fournit des commentaires. Les commentaires des experts sont consignés dans les tables d’inférence.

Remarque

Si le pare-feu du Stockage Azure est activé, contactez l’équipe du compte Azure Databricks afin d’activer les tables d’inférence pour vos points de terminaison.

Utiliser mlflow.evaluate() sur la table des logs de demande

Le bloc-notes suivant illustre comment utiliser les journaux de l'application de révision en tant qu'entrée pour un processus d'évaluation à l'aide de mlflow.evaluate().