Confiance et sécurité de DatabricksIQ

Databricks comprend l’importance de vos données et la confiance que vous nous accordez lorsque vous utilisez les services de Databricks. Databricks s’engage à respecter les normes de protection des données les plus élevées et a mis en œuvre des mesures rigoureuses afin de garantir la protection de vos informations.

- Vos données ne sont pas utilisées pour la formation et nos partenaires modèles ne les conservent pas.

- Ni Databricks ni notre partenaire de modèle (Azure OpenAI) n’effectuent l’apprentissage les modèles en utilisant les données des clients. Votre code et votre entrée ne sont pas utilisés pour générer des suggestions affichées pour d’autres clients.

- Les données soumises par Databricks dans ces fonctionnalités ne sont pas conservées par Azure OpenAI, même pour la surveillance des abus. Ces fonctionnalités ont été supprimées de la conservation des données Azure à cet effet.

- Protection contre les sorties dangereuses. Databricks utilise également le filtrage de contenu Azure OpenAI pour protéger les utilisateurs contre le contenu dangereux. En outre, Databricks a réalisé une évaluation approfondie avec des milliers d’interactions utilisateur simulées pour s’assurer que les protections mises en place contre les contenus nuisibles, les jailbreaks, la génération de codes non sécurisés et l’utilisation de contenus protégés par des droits d’auteur de tiers sont efficaces.

- Databricks utilise uniquement les données nécessaires pour fournir le service. Les données sont envoyées uniquement lorsque vous interagissez avec les fonctionnalités d’assistance à l’IA. Databricks envoie votre entrée en langage naturel, les métadonnées de table pertinentes, les erreurs, ainsi que le code d’entrée ou les requêtes pour vous aider à obtenir des résultats plus pertinents pour vos données. Databricks n’envoie pas de données au niveau des lignes.

- Les données sont protégées en transit. Tout le trafic entre Databricks et Azure OpenAI est chiffré en transit avec le chiffrement TLS standard du secteur d’activité.

- Les données de l’UE restent dans l’UE. Pour les espaces de travail de l’Union européenne (UE), les fonctionnalités d’assistance à l’IA utilisent un modèle Azure OpenAI hébergé dans l’UE. Consultez les zones géographiques Azure : Résidence des données et Services désignés Databricks.

Fonctionnalités régies par le paramètre de fonctionnalités d’assistance IA optimisées par le partenaire

L’IA basée sur les partenaires fait référence au service Azure OpenAI. Voici une répartition des fonctionnalités régies par le paramètre de fonctionnalités d’assistance ia optimisées par le partenaire :

| Fonctionnalité | Où le modèle est-il hébergé ? | Contrôlé par le paramètre IA optimisé par le partenaire ? |

|---|---|---|

| Conversation de l’Assistant Databricks | Service Azure OpenAI | Oui |

| Correctif rapide | Service Azure OpenAI | Oui |

| Commentaires de l’UC générés par l’IA | Espaces de travail de profil de sécurité de conformité (CSP) : service Azure OpenAI | Oui, pour tous les espaces de travail CSP. |

| Tableaux de bord IA/BI avec visualisations assistées par IA et espaces Genie associés | Service Azure OpenAI | Oui |

| Genie | Service Azure OpenAI | Oui |

| Saisie semi-automatique de l’Assistant Databricks | Modèle hébergé par Databricks | Non |

| Recherche intelligente | Service Azure OpenAI | Oui |

utiliser un modèle hébergé par Databricks pour l’Assistant Databricks

Découvrez comment utiliser un modèle hébergé par Databricks pour alimenter l’Assistant Databricks. Cette section explique comment elle fonctionne et comment l’utiliser.

Fonctionnement

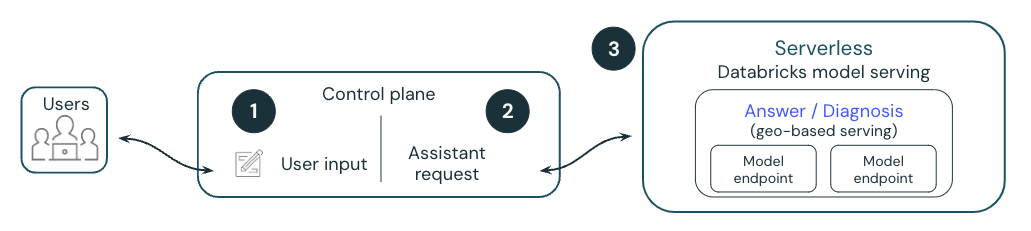

Le diagramme suivant fournit une vue d’ensemble de la façon dont un modèle hébergé par Databricks alimente l’Assistant Databricks.

- Un utilisateur invite l’Assistant Databricks en tapant du code ou une question, en sélectionnant Diagnostiquer l’erreurou en mettant en surbrillance une cellule.

- Databricks attache des métadonnées à une requête et l’envoie à un modèle de grande langue hébergé par Databricks (LLM). Toutes les données sont chiffrées au repos. Les clients peuvent utiliser une clé gérée par le client (CMK).

- La demande de l’utilisateur est envoyée au modèle hébergé par Databricks.

Les modèles hébergés par Databricks utilisent Meta Llama 3.x

L’Assistant Databricks avec des modèles hébergés par Databricks est actuellement créé avec Meta Llama 3. Meta Llama 3 est concédé sous licence sous la licence Meta Llama 3 Community License, Copyright © Meta Platforms, Inc. Tous les droits réservés.

FAQ sur les modèles hébergés par Databricks pour l’Assistant

Puis-je avoir ma propre instance de service de modèle privé ?

Pas à ce moment-là. Cette préversion utilise des points de terminaison de service de modèles managés et sécurisés par Databricks. Les points de terminaison de service de modèles sont sans état, protégés par plusieurs couches d’isolation et mettent en œuvre les contrôles de sécurité suivants pour protéger vos données :

- Chaque demande client à Model Service est logiquement isolée, authentifiée et autorisée.

- Mosaïque AI Model Service chiffre toutes les données au repos (AES-256) et en transit (TLS 1.2+).

Les métadonnées envoyées aux modèles respectent-elles les autorisations du catalogue Unity de l’utilisateur ?

Oui, toutes les données envoyées au modèle respectent les autorisations du catalogue Unity de l’utilisateur. Par exemple, il n’envoie pas de métadonnées relatives aux tables que l’utilisateur n’a pas l’autorisation de voir.

Où sont stockées les données ?

L’historique des conversations de l’Assistant Databricks est stocké dans la base de données du plan de contrôle, ainsi que le notebook. La base de données du plan de contrôle est chiffrée AES-256 bits et les clients qui nécessitent un contrôle sur la clé de chiffrement peuvent utiliser notre fonctionnalité de clé de Customer-Managed.

Note

- Comme d’autres objets d’espace de travail, la période de rétention de l’historique des conversations de l’Assistant Databricks est limitée au cycle de vie de l’objet lui-même. Si un utilisateur supprime le bloc-notes, celui-ci et tout historique de conversation associé est supprimé en 30 jours.

- Si le bloc-notes est partagé avec un autre utilisateur, l’historique des conversations est également visible pour cet utilisateur, sauf s’il est effacé en premier.

- Si le bloc-notes est exporté, l’historique des conversations n’est pas exporté avec celui-ci.

- Si un administrateur a accès au bloc-notes, il peut l’ouvrir et afficher l’historique des conversations.

Puis-je apporter ma propre clé API pour mon modèle ou héberger mes propres modèles ?

Pas à ce moment-là. L’Assistant Databricks est entièrement géré et hébergé par Databricks. La fonctionnalité de l'Assistant dépend fortement des fonctions de gestion de modèle (par exemple, appel de fonction), des performances et de la qualité. Databricks évalue en permanence les nouveaux modèles pour obtenir les meilleures performances et peut mettre à jour le modèle dans les futures versions de cette fonctionnalité.

Qui possède les données de sortie ? Si Assistant génère du code, qui possède cette adresse IP ?

Le client possède son propre résultat.

Refuser l’utilisation de modèles hébergés par Databricks

Pour refuser l’utilisation de modèles hébergés par Databricks :

- Cliquez sur votre nom d’utilisateur dans la barre supérieure de l’espace de travail Databricks.

- Dans le menu, sélectionnez Préversions.

- Désactivez Utiliser l’Assistant avec des modèles hébergés par Databricks.

Pour en savoir plus sur la gestion des préversions, consultez Gérer les préversions Azure Databricks.