Databricks Runtime 7.4 (EoS)

Remarque

La prise en charge de cette version databricks Runtime a pris fin. Pour connaître la date de fin de support, consultez l’historique de fin de support. Pour toutes les versions prises en charge de Databricks Runtime, consultez Notes de publication sur les versions et la compatibilité de Databricks Runtime.

Databricks a publié cette version en novembre 2020.

Les notes de publication suivantes fournissent des informations sur Databricks Runtime 7.4, avec Apache Spark 3.0.

Nouvelles fonctionnalités

Dans cette section :

- Améliorations et fonctionnalités de Delta Lake

- Le chargeur automatique prend désormais en charge la délégation de la configuration des ressources de notification de fichiers aux administrateurs

- Un nouveau privilège

USAGEconfère aux administrateurs un contrôle accru sur les privilèges d’accès aux données - La fusible FUSE est maintenant activée pour les clusters compatibles avec l’accès direct

Améliorations et fonctionnalités de Delta Lake

Cette version fournit les améliorations et fonctionnalités de Delta Lake suivantes :

- La nouvelle API permet à Delta Lake de vérifier que les données ajoutées à une table satisfont à des contraintes

- Une nouvelle API vous permet de restaurer une table Delta vers une version antérieure de la table

- La nouvelle version de démarrage permet de retourner uniquement les dernières modifications dans une source de diffusion en continu Delta Lake

- Stabilité améliorée de

OPTIMIZE

La nouvelle API permet à Delta Lake de vérifier que les données ajoutées à une table satisfont à des contraintes

Delta Lake prend désormais en charge les contraintes CHECK. En cas de spécification, Delta Lake vérifie automatiquement que les données ajoutées à une table satisfont à l’expression spécifiée.

Pour ajouter des contraintes CHECK, utilisez la commande ALTER TABLE ADD CONSTRAINTS. Pour plus d’informations, consultez Contraintes sur Azure Databricks.

Une nouvelle API vous permet de restaurer une table Delta vers une version antérieure de la table

Vous pouvez maintenant restaurer vos tables delta dans des versions antérieures à l’aide de la commande RESTORE:

SQL

RESTORE <table> TO VERSION AS OF n;

RESTORE <table> TO TIMESTAMP AS OF 'yyyy-MM-dd HH:mm:ss';

Python

from delta.tables import DeltaTable

DeltaTable.forName(spark, "table_name").restoreToVersion(n)

DeltaTable.forName(spark, "table_name").restoreToTimestamp('yyyy-MM-dd')

Scala

import io.delta.tables.DeltaTable

DeltaTable.forName(spark, "table_name").restoreToVersion(n)

DeltaTable.forName(spark, "table_name").restoreToTimestamp("yyyy-MM-dd")

RESTORE crée une nouvelle validation qui restaure toutes les modifications apportées à votre table depuis la version que vous souhaitez restaurer. Toutes les données et métadonnées existantes sont restaurées, ce qui comprend le schéma, les contraintes, les ID de transaction de streaming, les métadonnées COPY INTO et la version du protocole de table. Pour plus d’informations, consultez restaurer une table Delta.

La nouvelle version de démarrage permet de retourner uniquement les dernières modifications dans une source de diffusion en continu Delta Lake

Pour retourner uniquement les dernières modifications, spécifiez startingVersion comme latest . Pour plus d’informations, consultez Spécifier la position initiale.

Stabilité améliorée de OPTIMIZE

OPTIMIZE (sans prédicats de partition) peut être mis à l’échelle pour s’exécuter sur des tables avec des dizaines de millions de fichiers de petite taille. Auparavant, le pilote Apache Spark pouvait manquer de mémoire et OPTIMIZE ne s’est pas terminé.OPTIMIZE gère désormais des tables très volumineuses avec des dizaines de millions de fichiers.

Le chargeur automatique prend désormais en charge la délégation de la configuration des ressources de notification de fichiers aux administrateurs

Une nouvelle API Scala permet aux administrateurs de configurer des ressources de notification de fichiers pour le chargeur automatique. Les ingénieurs des données peuvent désormais utiliser leurs flux de chargement automatique avec moins d’autorisations en déléguant la configuration initiale des ressources à leurs administrateurs. Consultez Configurer ou gérer manuellement des ressources de notification de fichier.

Un nouveau privilège USAGE confère aux administrateurs un contrôle accru sur les privilèges d’accès aux données

Pour effectuer une action sur un objet dans une base de données, vous devez maintenant disposer du privilège USAGE sur cette base de données en plus des privilèges requis pour effectuer l’action. Le privilège USAGE est accordé pour une base de données ou un catalogue. Avec l’introduction du privilège USAGE, le propriétaire d’une table ne peut plus décider de le partager unilatéralement avec un autre utilisateur ; l’utilisateur doit également disposer du privilège USAGE sur la base de données contenant la table.

Dans les espaces de travail pour lesquels le contrôle d’accès aux tables est activé, le groupe users a automatiquement le privilège USAGE pour la racine CATALOG .

Pour plus d’informations, consultez privilège d’utilisation.

DBFS FUSE est maintenant activée pour les clusters compatibles avec l’accès direct

Vous pouvez maintenant lire et écrire à partir de DBFS à l’aide de FUSE Mount /dbfs/ lorsque vous utilisez un cluster à haut niveau de concurrence activé pour le relais des informations d’identification. Les montages standard sont pris en charge. Les montages qui requièrent des informations d’identification passthrough ne sont pas pris en charge.

Améliorations

Spark SQL prend en charge IFF et CHARINDEX comme synonymes pour IF etPOSITION

Dans Databricks Runtime IF() est un synonyme de CASE WHEN <cond> THEN <expr1> ELSE <expr2> END

Databricks Runtime prend désormais en charge IFF() comme synonyme de IF()

SELECT IFF(c1 = 1, 'Hello', 'World'), c1 FROM (VALUES (1), (2)) AS T(c1)

=> (Hello, 1)

(World, 2)

CHARINDEX est un nom alternatif pour la fonctionPOSITION. CHARINDEX recherche la position de la première occurrence d’une chaîne dans une autre chaîne avec un index de début facultatif.

VALUES(CHARINDEX('he', 'hello from hell', 2))

=> 12

Plusieurs sorties par cellule activée pour les blocs-notes python par défaut

Databricks Runtime 7,1 a introduit la prise en charge de plusieurs sorties par cellule dans des blocs-notes Python (et de% Python cellules dans des blocs-notes non-Python), mais vous avez besoin d’activer la fonctionnalité pour votre bloc-notes. Cette fonctionnalité est activée par défaut dans Databricks Runtime 7.4. Consultez afficher plusieurs sorties par cellule.

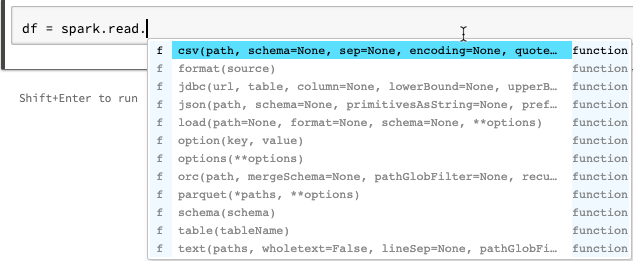

Améliorations de la saisie semi-automatique pour les blocs-notes python

La saisie semi-automatique pour Python affiche des informations de type supplémentaires générées à partir de l’analyse statique du code à l’aide de la bibliothèque Jedi. Vous pouvez appuyer sur la touche Tab pour afficher une liste d’options.

Amélioration des vecteurs de ML Spark display dans la préversion de Spark tableau

Le format display affiche maintenant des étiquettes pour le type de vecteur (Sparse ou dense), la longueur, les index (pour les vecteurs éparss) et les valeurs.

Autres correctifs

- Correction d’un problème de cueillette avec

collections.namedtupledans les blocs-notes. - Correction d’un problème de cueillette avec des classes et des méthodes définies de manière interactive.

- Correction d’un bogue qui provoquait l’échec des appels à

mlflow.start_run()en mode relais ou clusters activés pour le contrôle d’accès aux tables.

Mises à niveau de la bibliothèque

- Bibliothèques Python mises à niveau :

- jedi mise à niveau de la version 0.14.1 vers la version 0.17.2

- koalas mise à niveau de 1.2.0 vers 1.3.0.

- parso mise à niveau de la version 0.5.2 vers la version 0.7.0

- Mise à niveau de plusieurs bibliothèques R installées. Consultez Bibliothèques R installées.

Apache Spark

Databricks Runtime 7.4 comprend Apache Spark 3.0.1. Cette version inclut tous les correctifs et améliorations Spark figurant dans Databricks Runtime 7.3 LTS (EoS) ainsi que les correctifs de bogues et améliorations supplémentaires suivants apportés à Spark :

- [SPARK-33170] [SQL] ajoutez SQL config pour contrôler le comportement d’échec rapide dans FileFormatWriter

- [SPARK-33136] [SQL] correction du paramètre échangé par erreur dans V2WriteCommand.outputResolved

- [SPARK-33134] [SQL] retourne des résultats partiels uniquement pour les objets JSON racine

- [SPARK-33038] [SQL] combiner AQE initial et le plan actuel s...

- [SPARK-33118][SQL] CREATE TEMPORARY TABLE échoue avec la localisation

- [SPARK-33101] [ML] rendre le format LibSVM propager la configuration Hadoop des options DS vers le système de fichiers HDFS sous-jacent

- [SPARK-33035] [SQL] met à jour les entrées obsolètes du mappage d’attributs dans QueryPlan#transformUpWithNewOutput

- [SPARK-33091] [SQL] évitez d’utiliser map au lieu de foreach pour éviter un effet secondaire potentiel aux appelants de OrcUtils.readCatalystSchema

- [Spark-33073] [PYTHON] améliorer la gestion des erreurs sur les pandas pour les échecs de conversion des flèches

- [SPARK-33043] [ML] gérez spark.driver.maxResultSize=0 dans le calcul heuristique RowMatrix

- [SPARK-29358] [SQL] faire en sorte que unionByName remplisse éventuellement des colonnes manquantes avec des valeurs null

- [SPARK-32996] [WEB-UI] gérer les ExecutorMetrics vides dans ExecutorMetricsJsonSerializer

- [SPARK-32585][SQL] Prise en charge de l’énumération scala dans ScalaReflection

- [SPARK-33019] [CORE] Utilisez spark.hadoop.mapreduce.fileoutputcommitter.algorithm.version=1 par défaut

- [SPARK-33018] [SQL] résoudre le problème des statistiques d’estimation si l’enfant a 0 octet

- [SPARK-32901] [CORE] n’alloue pas de mémoire à UnsafeExternalSorter

- [SPARK-33015] [SQL] utilisez millisToDays() dans la règle ComputeCurrentTime

- [SPARK-33015] [SQL] calculez la date actuelle une seule fois

- [SPARK-32999][SQL] Utilise Utils.getSimpleName pour éviter de rencontrer un nom de classe Malformé dans TreeNode

- [SPARK-32659] [SQL] tableau de diffusion au lieu de définir dans InSubqueryExec

- [SPARK-32718][SQL] Suppression des mots clés inutiles pour les unités d’intervalle

- [SPARK-32886] [WEBUI] Correction du lien «non défini» dans l’affichage chronologie de l’événement

- [SPARK-32898] [CORE] résoudre un executorRunTime incorrect lorsque la tâche a été interrompue avant le démarrage réel

- [SPARK-32635] [SQL] ajouter un nouveau cas de test dans le module catalyst

- [SPARK-32930] [CORE] remplacer les méthodes IsFile/IsDirectory déconseillées

- [SPARK-32906] [SQL] les noms de champs Struct ne doivent pas être modifiés après la normalisation des valeurs flottantes

- [SPARK-24994] [SQL] Ajout de l'optimiseur UnwrapCastInBinaryComparison pour simplifier les littéraux intégraux.

- [SPARK-32635][SQL] Correction de la propagation pliable

- [SPARK-32738] [CORE] doit réduire le nombre de threads actifs si une erreur irrécupérable se produit dans

Inbox.process - [SPARK-32900] [CORE] permet à UnsafeExternalSorter de se déborder quand il y a des valeurs null

- [SPARK-32897] [PYTHON] n’affiche pas d’avertissement de désapprobation à SparkSession.builder.getOrCreate

- [SPARK-32715] [CORE] Correction de la fuite de mémoire lors de l’échec du stockage des éléments de diffusion

- [SPARK-32715] [CORE] Correction de la fuite de mémoire lors de l’échec du stockage des éléments de diffusion

- [SPARK-32872] [CORE] Empêcher BytesToBytesMap à MAX_CAPACITY de dépasser le seuil de croissance

- [SPARK-32876] [SQL] modifiez les versions de secours par défaut en 3.0.1 et 2.4.7 dans HiveExternalCatalogVersionsSuite

- [SPARK-32840] [SQL] Une valeur d’intervalle non valide peut se produire comme adhésif avec l’unité

- [SPARK-32819] [SQL] le paramètre ignoreNullability doit être efficace de manière récursive

- [SPARK-32832] [SQL] Utilisation de CaseInsensitiveMap pour les options DataFrameReader/Writer

- [SPARK-32794] [SS] Erreur de cas d’angle rare fixe dans le moteur micro-batch avec des requêtes avec état + pas de données-lots + sources v1

- [SPARK-32813] [SQL] obtient la configuration par défaut du lecteur ParquetSource vectorisé si aucune SparkSession active

- [SPARK-32823] [INTERFACE UTILISATEUR WEB] Correction des ressources d’interface utilisateur principales Reporting

- [SPARK-32824] [CORE] Améliorent le message d’erreur lorsque l’utilisateur oublie le. amount dans une configuration de ressource

- [SPARK-32614] [SQL] n’appliquent pas le traitement des commentaires si «comment» est désactivé pour CSV

- [SPARK-32638] [SQL] corrige les références lors de l’ajout d’alias dans WidenSetOperationTypes

- [SPARK-32810] [SQL] Les sources de données CSV/JSON doivent éviter les chemins d’accès de globbing lors de l’inférence du schéma

- [SPARK-32815] [ML] correction de l’erreur de chargement de la source de données LibSVM sur les chemins de fichier avec des métacaractères glob

- [SPARK-32753] [SQL] copier uniquement les balises dans le nœud sans balise

- [SPARK-32785] [SQL] l’intervalle avec des parties non résolues ne doit pas avoir la valeur null

- [SPARK-32764][SQL] -0,0 doit être égal à 0,0

- [SPARK-32810] [SQL] Les sources de données CSV/JSON doivent éviter les chemins d’accès de globbing lors de l’inférence du schéma

- [SPARK-32779] [SQL] évitez d’utiliser l’API synchronisée de SessionCatalog dans withClient flow, ce qui provoque un interblocage

- [SPARK-32791] [SQL] la mesure de table Non partitionnée ne doit pas avoir de temps de nettoyage de partition dynamique

- [SPARK-32767] [SQL] La jonction de compartiments doit fonctionner si SPARK. SQL. permutation. partitions dépasse le numéro de compartiment

- [SPARK-32788] [SQL] une analyse de table non partitionnée ne doit pas avoir de filtre de partition

- [SPARK-32776] [SS] La limite de streaming ne doit pas être optimisée par PropagateEmptyRelation

- [SPARK-32624] [SQL] correction de la régression dans CodegenContext. addReferenceObj sur les types Scala imbriqués

- [SPARK-32659] [SQL] améliorez le test de nettoyage de DPP sur un type non atomique

- [SPARK-31511] [SQL] rendre les itérateurs BytesToBytesMap sécurisés au thread

- [SPARK-32693] [SQL] compare deux trames avec le même schéma, à l’exception de la propriété nullable

- [SPARK-28612] [SQL] bonne méthode doc de DataFrameWriterV2.replace()

Mises à jour de maintenance

Consultez Mises à jour de maintenance de Databricks Runtime 7.4.

Environnement du système

- Système d’exploitation : Ubuntu 18.04.5 LTS

- Java : Zulu 8.48.0.53-CA-linux64 (build 1.8.0_265-b11)

- Scala : 2.12.10

- Python : 3.7.5

- R : R version 3.6.3 (2020-02-29)

- Delta Lake 0.7.0

Bibliothèques Python installées

| Bibliothèque | Version | Bibliothèque | Version | Bibliothèque | Version |

|---|---|---|---|---|---|

| asn1crypto | 1.3.0 | backcall | 0.1.0 | boto3 | 1.12.0 |

| botocore | 1.15.0 | certifi | 2020.6.20 | cffi | 1.14.0 |

| chardet | 3.0.4 | chiffrement | 2.8 | cycler | 0.10.0 |

| Cython | 0.29.15 | decorator | 4.4.1 | docutils | 0.15.2 |

| entrypoints | 0.3 | idna | 2.8 | ipykernel | 5.1.4 |

| ipython | 7.12.0 | ipython-genutils | 0.2.0 | jedi | 0.17.2 |

| jmespath | 0.10.0 | joblib | 0.14.1 | jupyter-client | 5.3.4 |

| jupyter-core | 4.6.1 | kiwisolver | 1.1.0 | koalas | 1.3.0 |

| matplotlib | 3.1.3 | numpy | 1.18.1 | pandas | 1.0.1 |

| parso | 0.7.0 | patsy | 0.5.1 | pexpect | 4.8.0 |

| pickleshare | 0.7.5 | pip | 20.0.2 | prompt-toolkit | 3.0.3 |

| psycopg2 | 2.8.4 | ptyprocess | 0.6.0 | pyarrow | 1.0.1 |

| pycparser | 2.19 | Pygments | 2.5.2 | PyGObject | 3.26.1 |

| pyOpenSSL | 19.1.0 | pyparsing | 2.4.6 | PySocks | 1.7.1 |

| python-apt | 1.6.5+ubuntu0.3 | python-dateutil | 2.8.1 | pytz | 2019.3 |

| pyzmq | 18.1.1 | requêtes | 2.22.0 | s3transfer | 0.3.3 |

| scikit-learn | 0.22.1 | scipy | 1.4.1 | seaborn | 0.10.0 |

| setuptools | 45.2.0 | six | 1.14.0 | ssh-import-id | 5.7 |

| statsmodels | 0.11.0 | tornado | 6.0.3 | traitlets | 4.3.3 |

| unattended-upgrades | 0.1 | urllib3 | 1.25.8 | virtualenv | 16.7.10 |

| wcwidth | 0.1.8 | wheel | 0.34.2 |

Bibliothèques R installées

Les bibliothèques R sont installées à partir de l’instantané Microsoft CRAN du XX-XX-XXXX.

| Bibliothèque | Version | Bibliothèque | Version | Bibliothèque | Version |

|---|---|---|---|---|---|

| askpass | 1.1 | assertthat | 0.2.1 | backports | 1.1.8 |

| base | 3.6.3 | base64enc | 0.1-3 | BH | 1.72.0-3 |

| bit | 1.1-15.2 | bit64 | 0.9-7 | objet BLOB | 1.2.1 |

| boot | 1.3-25 | brew | 1.0-6 | broom | 0.7.0 |

| callr | 3.4.3 | caret | 6.0-86 | cellranger | 1.1.0 |

| chron | 2.3-55 | class | 7.3-17 | cli | 2.0.2 |

| clipr | 0.7.0 | cluster | 2.1.0 | codetools | 0.2-16 |

| colorspace | 1.4-1 | commonmark | 1.7 | compiler | 3.6.3 |

| config | 0.3 | covr | 3.5.0 | crayon | 1.3.4 |

| crosstalk | 1.1.0.1 | curl | 4.3 | data.table | 1.12.8 |

| jeux de données | 3.6.3 | DBI | 1.1.0 | dbplyr | 1.4.4 |

| desc | 1.2.0 | devtools | 2.3.0 | digest | 0.6.25 |

| dplyr | 0.8.5 | DT | 0.14 | ellipsis | 0.3.1 |

| evaluate | 0.14 | fansi | 0.4.1 | farver | 2.0.3 |

| fastmap | 1.0.1 | forcats | 0.5.0 | foreach | 1.5.0 |

| foreign | 0.8-76 | forge | 0.2.0 | fs | 1.4.2 |

| generics | 0.0.2 | ggplot2 | 3.3.2 | gh | 1.1.0 |

| git2r | 0.27.1 | glmnet | 3.0-2 | globals | 0.12.5 |

| glue | 1.4.1 | gower | 0.2.2 | graphics | 3.6.3 |

| grDevices | 3.6.3 | grid | 3.6.3 | gridExtra | 2.3 |

| gsubfn | 0.7 | gtable | 0.3.0 | haven | 2.3.1 |

| highr | 0,8 | hms | 0.5.3 | htmltools | 0.5.0 |

| htmlwidgets | 1.5.1 | httpuv | 1.5.4 | httr | 1.4.1 |

| hwriter | 1.3.2 | hwriterPlus | 1.0-3 | ini | 0.3.1 |

| ipred | 0.9-9 | isoband | 0.2.2 | iterators | 1.0.12 |

| jsonlite | 1.7.0 | KernSmooth | 2.23-17 | knitr | 1.29 |

| labeling | 0.3 | later | 1.1.0.1 | lattice | 0.20-41 |

| lava | 1.6.7 | lazyeval | 0.2.2 | cycle de vie | 0.2.0 |

| lubridate | 1.7.9 | magrittr | 1.5 | markdown | 1.1 |

| MASS | 7.3-53 | Matrice | 1.2-18 | memoise | 1.1.0 |

| methods | 3.6.3 | mgcv | 1.8-33 | mime | 0.9 |

| ModelMetrics | 1.2.2.2 | modelr | 0.1.8 | munsell | 0.5.0 |

| nlme | 3.1-149 | nnet | 7.3-14 | numDeriv | 2016.8-1.1 |

| openssl | 1.4.2 | parallel | 3.6.3 | pillar | 1.4.6 |

| pkgbuild | 1.1.0 | pkgconfig | 2.0.3 | pkgload | 1.1.0 |

| plogr | 0.2.0 | plyr | 1.8.6 | praise | 1.0.0 |

| prettyunits | 1.1.1 | pROC | 1.16.2 | processx | 3.4.3 |

| prodlim | 2019.11.13 | progress | 1.2.2 | promises | 1.1.1 |

| proto | 1.0.0 | ps | 1.3.3 | purrr | 0.3.4 |

| r2d3 | 0.2.3 | R6 | 2.4.1 | randomForest | 4.6-14 |

| rappdirs | 0.3.1 | rcmdcheck | 1.3.3 | RColorBrewer | 1.1-2 |

| Rcpp | 1.0.5 | readr | 1.3.1 | readxl | 1.3.1 |

| recipes | 0.1.13 | rematch | 1.0.1 | rematch2 | 2.1.2 |

| remotes | 2.1.1 | reprex | 0.3.0 | reshape2 | 1.4.4 |

| rex | 1.2.0 | rjson | 0.2.20 | rlang | 0.4.7 |

| rmarkdown | 2.3 | RODBC | 1.3-16 | roxygen2 | 7.1.1 |

| rpart | 4.1-15 | rprojroot | 1.3-2 | Rserve | 1.8-7 |

| RSQLite | 2.2.0 | rstudioapi | 0.11 | rversions | 2.0.2 |

| rvest | 0.3.5 | scales | 1.1.1 | selectr | 0.4-2 |

| sessioninfo | 1.1.1 | shape | 1.4.4 | shiny | 1.5.0 |

| sourcetools | 0.1.7 | sparklyr | 1.3.1 | SparkR | 3.0.0 |

| spatial | 7.3-11 | splines | 3.6.3 | sqldf | 0.4-11 |

| SQUAREM | 2020.3 | stats | 3.6.3 | stats4 | 3.6.3 |

| stringi | 1.4.6 | stringr | 1.4.0 | survival | 3.2-7 |

| sys | 3.3 | tcltk | 3.6.3 | TeachingDemos | 2,10 |

| testthat | 2.3.2 | tibble | 3.0.3 | tidyr | 1.1.0 |

| tidyselect | 1.1.0 | tidyverse | 1.3.0 | timeDate | 3043.102 |

| tinytex | 0.24 | tools | 3.6.3 | usethis | 1.6.1 |

| utf8 | 1.1.4 | utils | 3.6.3 | uuid | 0.1-4 |

| vctrs | 0.3.1 | viridisLite | 0.3.0 | whisker | 0,4 |

| withr | 2.2.0 | xfun | 0.15 | xml2 | 1.3.2 |

| xopen | 1.0.0 | xtable | 1.8-4 | yaml | 2.2.1 |

Bibliothèques Java et Scala installées (version de cluster Scala 2.12)

| ID de groupe | ID d’artefact | Version |

|---|---|---|

| antlr | antlr | 2.7.7 |

| com.amazonaws | amazon-kinesis-client | 1.12.0 |

| com.amazonaws | aws-java-sdk-autoscaling | 1.11.655 |

| com.amazonaws | aws-java-sdk-cloudformation | 1.11.655 |

| com.amazonaws | aws-java-sdk-cloudfront | 1.11.655 |

| com.amazonaws | aws-java-sdk-cloudhsm | 1.11.655 |

| com.amazonaws | aws-java-sdk-cloudsearch | 1.11.655 |

| com.amazonaws | aws-java-sdk-cloudtrail | 1.11.655 |

| com.amazonaws | aws-java-sdk-cloudwatch | 1.11.655 |

| com.amazonaws | aws-java-sdk-cloudwatchmetrics | 1.11.655 |

| com.amazonaws | aws-java-sdk-codedeploy | 1.11.655 |

| com.amazonaws | aws-java-sdk-cognitoidentity | 1.11.655 |

| com.amazonaws | aws-java-sdk-cognitosync | 1.11.655 |

| com.amazonaws | aws-java-sdk-config | 1.11.655 |

| com.amazonaws | aws-java-sdk-core | 1.11.655 |

| com.amazonaws | aws-java-sdk-datapipeline | 1.11.655 |

| com.amazonaws | aws-java-sdk-directconnect | 1.11.655 |

| com.amazonaws | aws-java-sdk-directory | 1.11.655 |

| com.amazonaws | aws-java-sdk-dynamodb | 1.11.655 |

| com.amazonaws | aws-java-sdk-ec2 | 1.11.655 |

| com.amazonaws | aws-java-sdk-ecs | 1.11.655 |

| com.amazonaws | aws-java-sdk-efs | 1.11.655 |

| com.amazonaws | aws-java-sdk-elasticache | 1.11.655 |

| com.amazonaws | aws-java-sdk-elasticbeanstalk | 1.11.655 |

| com.amazonaws | aws-java-sdk-elasticloadbalancing | 1.11.655 |

| com.amazonaws | aws-java-sdk-elastictranscoder | 1.11.655 |

| com.amazonaws | aws-java-sdk-emr | 1.11.655 |

| com.amazonaws | aws-java-sdk-glacier | 1.11.655 |

| com.amazonaws | aws-java-sdk-iam | 1.11.655 |

| com.amazonaws | aws-java-sdk-importexport | 1.11.655 |

| com.amazonaws | aws-java-sdk-kinesis | 1.11.655 |

| com.amazonaws | aws-java-sdk-kms | 1.11.655 |

| com.amazonaws | aws-java-sdk-lambda | 1.11.655 |

| com.amazonaws | aws-java-sdk-logs | 1.11.655 |

| com.amazonaws | aws-java-sdk-machinelearning | 1.11.655 |

| com.amazonaws | aws-java-sdk-opsworks | 1.11.655 |

| com.amazonaws | aws-java-sdk-rds | 1.11.655 |

| com.amazonaws | aws-java-sdk-redshift | 1.11.655 |

| com.amazonaws | aws-java-sdk-route53 | 1.11.655 |

| com.amazonaws | aws-java-sdk-s3 | 1.11.655 |

| com.amazonaws | aws-java-sdk-ses | 1.11.655 |

| com.amazonaws | aws-java-sdk-simpledb | 1.11.655 |

| com.amazonaws | aws-java-sdk-simpleworkflow | 1.11.655 |

| com.amazonaws | aws-java-sdk-sns | 1.11.655 |

| com.amazonaws | aws-java-sdk-sqs | 1.11.655 |

| com.amazonaws | aws-java-sdk-ssm | 1.11.655 |

| com.amazonaws | aws-java-sdk-storagegateway | 1.11.655 |

| com.amazonaws | aws-java-sdk-sts | 1.11.655 |

| com.amazonaws | aws-java-sdk-support | 1.11.655 |

| com.amazonaws | aws-java-sdk-swf-libraries | 1.11.22 |

| com.amazonaws | aws-java-sdk-workspaces | 1.11.655 |

| com.amazonaws | jmespath-java | 1.11.655 |

| com.chuusai | shapeless_2.12 | 2.3.3 |

| com.clearspring.analytics | flux | 2.9.6 |

| com.databricks | Rserve | 1.8-3 |

| com.databricks | jets3t | 0.7.1-0 |

| com.databricks.scalapb | compilerplugin_2.12 | 0.4.15-10 |

| com.databricks.scalapb | scalapb-runtime_2.12 | 0.4.15-10 |

| com.esotericsoftware | kryo-shaded | 4.0.2 |

| com.esotericsoftware | minlog | 1.3.0 |

| com.fasterxml | classmate | 1.3.4 |

| com.fasterxml.jackson.core | jackson-annotations | 2.10.0 |

| com.fasterxml.jackson.core | jackson-core | 2.10.0 |

| com.fasterxml.jackson.core | jackson-databind | 2.10.0 |

| com.fasterxml.jackson.dataformat | jackson-dataformat-cbor | 2.10.0 |

| com.fasterxml.jackson.datatype | jackson-datatype-joda | 2.10.0 |

| com.fasterxml.jackson.module | jackson-module-paranamer | 2.10.0 |

| com.fasterxml.jackson.module | jackson-module-scala_2.12 | 2.10.0 |

| com.github.ben-manes.caffeine | caffeine | 2.3.4 |

| com.github.fommil | jniloader | 1.1 |

| com.github.fommil.netlib | core | 1.1.2 |

| com.github.fommil.netlib | native_ref-java | 1.1 |

| com.github.fommil.netlib | native_ref-java-natives | 1.1 |

| com.github.fommil.netlib | native_system-java | 1.1 |

| com.github.fommil.netlib | native_system-java-natives | 1.1 |

| com.github.fommil.netlib | netlib-native_ref-linux-x86_64-natives | 1.1 |

| com.github.fommil.netlib | netlib-native_system-linux-x86_64-natives | 1.1 |

| com.github.joshelser | dropwizard-metrics-hadoop-metrics2-reporter | 0.1.2 |

| com.github.luben | zstd-jni | 1.4.4-3 |

| com.github.wendykierp | JTransforms | 3.1 |

| com.google.code.findbugs | jsr305 | 3.0.0 |

| com.google.code.gson | gson | 2.2.4 |

| com.google.flatbuffers | flatbuffers-java | 1.9.0 |

| com.google.guava | guava | 15.0 |

| com.google.protobuf | protobuf-java | 2.6.1 |

| com.h2database | h2 | 1.4.195 |

| com.helger | profiler | 1.1.1 |

| com.jcraft | jsch | 0.1.50 |

| com.jolbox | bonecp | 0.8.0.RELEASE |

| com.lihaoyi | sourcecode_2.12 | 0.1.9 |

| com.microsoft.azure | azure-data-lake-store-sdk | 2.2.8 |

| com.microsoft.sqlserver | mssql-jdbc | 8.2.1.jre8 |

| com.ning | compress-lzf | 1.0.3 |

| com.sun.mail | javax.mail | 1.5.2 |

| com.tdunning | json | 1.8 |

| com.thoughtworks.paranamer | paranamer | 2.8 |

| com.trueaccord.lenses | lenses_2.12 | 0.4.12 |

| com.twitter | chill-java | 0.9.5 |

| com.twitter | chill_2.12 | 0.9.5 |

| com.twitter | util-app_2.12 | 7.1.0 |

| com.twitter | util-core_2.12 | 7.1.0 |

| com.twitter | util-function_2.12 | 7.1.0 |

| com.twitter | util-jvm_2.12 | 7.1.0 |

| com.twitter | util-lint_2.12 | 7.1.0 |

| com.twitter | util-registry_2.12 | 7.1.0 |

| com.twitter | util-stats_2.12 | 7.1.0 |

| com.typesafe | config | 1.2.1 |

| com.typesafe.scala-logging | scala-logging_2.12 | 3.7.2 |

| com.univocity | univocity-parsers | 2.9.0 |

| com.zaxxer | HikariCP | 3.1.0 |

| commons-beanutils | commons-beanutils | 1.9.4 |

| commons-cli | commons-cli | 1.2 |

| commons-codec | commons-codec | 1,10 |

| commons-collections | commons-collections | 3.2.2 |

| commons-configuration | commons-configuration | 1.6 |

| commons-dbcp | commons-dbcp | 1.4 |

| commons-digester | commons-digester | 1.8 |

| commons-fileupload | commons-fileupload | 1.3.3 |

| commons-httpclient | commons-httpclient | 3.1 |

| commons-io | commons-io | 2.4 |

| commons-lang | commons-lang | 2.6 |

| commons-logging | commons-logging | 1.1.3 |

| commons-net | commons-net | 3.1 |

| commons-pool | commons-pool | 1.5.4 |

| info.ganglia.gmetric4j | gmetric4j | 1.0.10 |

| io.airlift | aircompressor | 0.10 |

| io.dropwizard.metrics | metrics-core | 4.1.1 |

| io.dropwizard.metrics | metrics-graphite | 4.1.1 |

| io.dropwizard.metrics | metrics-healthchecks | 4.1.1 |

| io.dropwizard.metrics | metrics-jetty9 | 4.1.1 |

| io.dropwizard.metrics | metrics-jmx | 4.1.1 |

| io.dropwizard.metrics | metrics-json | 4.1.1 |

| io.dropwizard.metrics | metrics-jvm | 4.1.1 |

| io.dropwizard.metrics | metrics-servlets | 4.1.1 |

| io.netty | netty-all | 4.1.47.Final |

| jakarta.annotation | jakarta.annotation-api | 1.3.5 |

| jakarta.validation | jakarta.validation-api | 2.0.2 |

| jakarta.ws.rs | jakarta.ws.rs-api | 2.1.6 |

| javax.activation | activation | 1.1.1 |

| javax.el | javax.el-api | 2.2.4 |

| javax.jdo | jdo-api | 3.0.1 |

| javax.servlet | javax.servlet-api | 3.1.0 |

| javax.servlet.jsp | jsp-api | 2.1 |

| javax.transaction | jta | 1.1 |

| javax.transaction | transaction-api | 1.1 |

| javax.xml.bind | jaxb-api | 2.2.2 |

| javax.xml.stream | stax-api | 1.0-2 |

| javolution | javolution | 5.5.1 |

| jline | jline | 2.14.6 |

| joda-time | joda-time | 2.10.5 |

| log4j | apache-log4j-extras | 1.2.17 |

| log4j | log4j | 1.2.17 |

| net.razorvine | pyrolite | 4.30 |

| net.sf.jpam | jpam | 1.1 |

| net.sf.opencsv | opencsv | 2.3 |

| net.sf.supercsv | super-csv | 2.2.0 |

| net.snowflake | snowflake-ingest-sdk | 0.9.6 |

| net.snowflake | snowflake-jdbc | 3.12.8 |

| net.snowflake | spark-snowflake_2.12 | 2.8.1-spark_3.0 |

| net.sourceforge.f2j | arpack_combined_all | 0.1 |

| org.acplt.remotetea | remotetea-oncrpc | 1.1.2 |

| org.antlr | ST4 | 4.0.4 |

| org.antlr | antlr-runtime | 3.5.2 |

| org.antlr | antlr4-runtime | 4.7.1 |

| org.antlr | stringtemplate | 3.2.1 |

| org.apache.ant | ant | 1.9.2 |

| org.apache.ant | ant-jsch | 1.9.2 |

| org.apache.ant | ant-launcher | 1.9.2 |

| org.apache.arrow | arrow-format | 0.15.1 |

| org.apache.arrow | arrow-memory | 0.15.1 |

| org.apache.arrow | arrow-vector | 0.15.1 |

| org.apache.avro | avro | 1.8.2 |

| org.apache.avro | avro-ipc | 1.8.2 |

| org.apache.avro | avro-mapred-hadoop2 | 1.8.2 |

| org.apache.commons | commons-compress | 1.8.1 |

| org.apache.commons | commons-crypto | 1.0.0 |

| org.apache.commons | commons-lang3 | 3.9 |

| org.apache.commons | commons-math3 | 3.4.1 |

| org.apache.commons | commons-text | 1.6 |

| org.apache.curator | curator-client | 2.7.1 |

| org.apache.curator | curator-framework | 2.7.1 |

| org.apache.curator | curator-recipes | 2.7.1 |

| org.apache.derby | derby | 10.12.1.1 |

| org.apache.directory.api | api-asn1-api | 1.0.0-M20 |

| org.apache.directory.api | api-util | 1.0.0-M20 |

| org.apache.directory.server | apacheds-i18n | 2.0.0-M15 |

| org.apache.directory.server | apacheds-kerberos-codec | 2.0.0-M15 |

| org.apache.hadoop | hadoop-annotations | 2.7.4 |

| org.apache.hadoop | hadoop-auth | 2.7.4 |

| org.apache.hadoop | hadoop-client | 2.7.4 |

| org.apache.hadoop | hadoop-common | 2.7.4 |

| org.apache.hadoop | hadoop-hdfs | 2.7.4 |

| org.apache.hadoop | hadoop-mapreduce-client-app | 2.7.4 |

| org.apache.hadoop | hadoop-mapreduce-client-common | 2.7.4 |

| org.apache.hadoop | hadoop-mapreduce-client-core | 2.7.4 |

| org.apache.hadoop | hadoop-mapreduce-client-jobclient | 2.7.4 |

| org.apache.hadoop | hadoop-mapreduce-client-shuffle | 2.7.4 |

| org.apache.hadoop | hadoop-yarn-api | 2.7.4 |

| org.apache.hadoop | hadoop-yarn-client | 2.7.4 |

| org.apache.hadoop | hadoop-yarn-common | 2.7.4 |

| org.apache.hadoop | hadoop-yarn-server-common | 2.7.4 |

| org.apache.hive | hive-beeline | 2.3.7 |

| org.apache.hive | hive-cli | 2.3.7 |

| org.apache.hive | hive-common | 2.3.7 |

| org.apache.hive | hive-exec-core | 2.3.7 |

| org.apache.hive | hive-jdbc | 2.3.7 |

| org.apache.hive | hive-llap-client | 2.3.7 |

| org.apache.hive | hive-llap-common | 2.3.7 |

| org.apache.hive | hive-metastore | 2.3.7 |

| org.apache.hive | hive-serde | 2.3.7 |

| org.apache.hive | hive-shims | 2.3.7 |

| org.apache.hive | hive-storage-api | 2.7.1 |

| org.apache.hive | hive-vector-code-gen | 2.3.7 |

| org.apache.hive.shims | hive-shims-0.23 | 2.3.7 |

| org.apache.hive.shims | hive-shims-common | 2.3.7 |

| org.apache.hive.shims | hive-shims-scheduler | 2.3.7 |

| org.apache.htrace | htrace-core | 3.1.0-incubating |

| org.apache.httpcomponents | httpclient | 4.5.6 |

| org.apache.httpcomponents | httpcore | 4.4.12 |

| org.apache.ivy | ivy | 2.4.0 |

| org.apache.orc | orc-core | 1.5.10 |

| org.apache.orc | orc-mapreduce | 1.5.10 |

| org.apache.orc | orc-shims | 1.5.10 |

| org.apache.parquet | parquet-column | 1.10.1-databricks6 |

| org.apache.parquet | parquet-common | 1.10.1-databricks6 |

| org.apache.parquet | parquet-encoding | 1.10.1-databricks6 |

| org.apache.parquet | parquet-format | 2.4.0 |

| org.apache.parquet | parquet-hadoop | 1.10.1-databricks6 |

| org.apache.parquet | parquet-jackson | 1.10.1-databricks6 |

| org.apache.thrift | libfb303 | 0.9.3 |

| org.apache.thrift | libthrift | 0.12.0 |

| org.apache.velocity | velocity | 1.5 |

| org.apache.xbean | xbean-asm7-shaded | 4.15 |

| org.apache.yetus | audience-annotations | 0.5.0 |

| org.apache.zookeeper | zookeeper | 3.4.14 |

| org.codehaus.jackson | jackson-core-asl | 1.9.13 |

| org.codehaus.jackson | jackson-jaxrs | 1.9.13 |

| org.codehaus.jackson | jackson-mapper-asl | 1.9.13 |

| org.codehaus.jackson | jackson-xc | 1.9.13 |

| org.codehaus.janino | commons-compiler | 3.0.16 |

| org.codehaus.janino | janino | 3.0.16 |

| org.datanucleus | datanucleus-api-jdo | 4.2.4 |

| org.datanucleus | datanucleus-core | 4.1.17 |

| org.datanucleus | datanucleus-rdbms | 4.1.19 |

| org.datanucleus | javax.jdo | 3.2.0-m3 |

| org.eclipse.jetty | jetty-client | 9.4.18.v20190429 |

| org.eclipse.jetty | jetty-continuation | 9.4.18.v20190429 |

| org.eclipse.jetty | jetty-http | 9.4.18.v20190429 |

| org.eclipse.jetty | jetty-io | 9.4.18.v20190429 |

| org.eclipse.jetty | jetty-jndi | 9.4.18.v20190429 |

| org.eclipse.jetty | jetty-plus | 9.4.18.v20190429 |

| org.eclipse.jetty | jetty-proxy | 9.4.18.v20190429 |

| org.eclipse.jetty | jetty-security | 9.4.18.v20190429 |

| org.eclipse.jetty | jetty-server | 9.4.18.v20190429 |

| org.eclipse.jetty | jetty-servlet | 9.4.18.v20190429 |

| org.eclipse.jetty | jetty-servlets | 9.4.18.v20190429 |

| org.eclipse.jetty | jetty-util | 9.4.18.v20190429 |

| org.eclipse.jetty | jetty-webapp | 9.4.18.v20190429 |

| org.eclipse.jetty | jetty-xml | 9.4.18.v20190429 |

| org.fusesource.leveldbjni | leveldbjni-all | 1.8 |

| org.glassfish.hk2 | hk2-api | 2.6.1 |

| org.glassfish.hk2 | hk2-locator | 2.6.1 |

| org.glassfish.hk2 | hk2-utils | 2.6.1 |

| org.glassfish.hk2 | osgi-resource-locator | 1.0.3 |

| org.glassfish.hk2.external | aopalliance-repackaged | 2.6.1 |

| org.glassfish.hk2.external | jakarta.inject | 2.6.1 |

| org.glassfish.jersey.containers | jersey-container-servlet | 2.30 |

| org.glassfish.jersey.containers | jersey-container-servlet-core | 2.30 |

| org.glassfish.jersey.core | jersey-client | 2.30 |

| org.glassfish.jersey.core | jersey-common | 2.30 |

| org.glassfish.jersey.core | jersey-server | 2.30 |

| org.glassfish.jersey.inject | jersey-hk2 | 2.30 |

| org.glassfish.jersey.media | jersey-media-jaxb | 2.30 |

| org.hibernate.validator | hibernate-validator | 6.1.0.Final |

| org.javassist | javassist | 3.25.0-GA |

| org.jboss.logging | jboss-logging | 3.3.2.Final |

| org.jdbi | jdbi | 2.63.1 |

| org.joda | joda-convert | 1.7 |

| org.jodd | jodd-core | 3.5.2 |

| org.json4s | json4s-ast_2.12 | 3.6.6 |

| org.json4s | json4s-core_2.12 | 3.6.6 |

| org.json4s | json4s-jackson_2.12 | 3.6.6 |

| org.json4s | json4s-scalap_2.12 | 3.6.6 |

| org.lz4 | lz4-java | 1.7.1 |

| org.mariadb.jdbc | mariadb-java-client | 2.1.2 |

| org.objenesis | objenesis | 2.5.1 |

| org.postgresql | postgresql | 42.1.4 |

| org.roaringbitmap | RoaringBitmap | 0.7.45 |

| org.roaringbitmap | shims | 0.7.45 |

| org.rocksdb | rocksdbjni | 6.2.2 |

| org.rosuda.REngine | REngine | 2.1.0 |

| org.scala-lang | scala-compiler_2.12 | 2.12.10 |

| org.scala-lang | scala-library_2.12 | 2.12.10 |

| org.scala-lang | scala-reflect_2.12 | 2.12.10 |

| org.scala-lang.modules | scala-collection-compat_2.12 | 2.1.1 |

| org.scala-lang.modules | scala-parser-combinators_2.12 | 1.1.2 |

| org.scala-lang.modules | scala-xml_2.12 | 1.2.0 |

| org.scala-sbt | test-interface | 1.0 |

| org.scalacheck | scalacheck_2.12 | 1.14.2 |

| org.scalactic | scalactic_2.12 | 3.0.8 |

| org.scalanlp | breeze-macros_2.12 | 1.0 |

| org.scalanlp | breeze_2.12 | 1.0 |

| org.scalatest | scalatest_2.12 | 3.0.8 |

| org.slf4j | jcl-over-slf4j | 1.7.30 |

| org.slf4j | jul-to-slf4j | 1.7.30 |

| org.slf4j | slf4j-api | 1.7.30 |

| org.slf4j | slf4j-log4j12 | 1.7.30 |

| org.spark-project.spark | unused | 1.0.0 |

| org.springframework | spring-core | 4.1.4.RELEASE |

| org.springframework | spring-test | 4.1.4.RELEASE |

| org.threeten | threeten-extra | 1.5.0 |

| org.tukaani | xz | 1.5 |

| org.typelevel | algebra_2.12 | 2.0.0-M2 |

| org.typelevel | cats-kernel_2.12 | 2.0.0-M4 |

| org.typelevel | machinist_2.12 | 0.6.8 |

| org.typelevel | macro-compat_2.12 | 1.1.1 |

| org.typelevel | spire-macros_2.12 | 0.17.0-M1 |

| org.typelevel | spire-platform_2.12 | 0.17.0-M1 |

| org.typelevel | spire-util_2.12 | 0.17.0-M1 |

| org.typelevel | spire_2.12 | 0.17.0-M1 |

| org.xerial | sqlite-jdbc | 3.8.11.2 |

| org.xerial.snappy | snappy-java | 1.1.7.5 |

| org.yaml | snakeyaml | 1.24 |

| oro | oro | 2.0.8 |

| pl.edu.icm | JLargeArrays | 1.5 |

| software.amazon.ion | ion-java | 1.0.2 |

| stax | stax-api | 1.0.1 |

| xmlenc | xmlenc | 0.52 |