Copier les fichiers nouveaux et modifiés selon LastModifiedDate à l’aide de l’outil Copier des données de façon incrémentielle

S’APPLIQUE À :  Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Conseil

Essayez Data Factory dans Microsoft Fabric, une solution d’analyse tout-en-un pour les entreprises. Microsoft Fabric couvre tous les aspects, du déplacement des données à la science des données, en passant par l’analyse en temps réel, l’aide à la décision et la création de rapports. Découvrez comment démarrer un nouvel essai gratuitement !

Dans ce didacticiel, vous utilisez le portail Azure pour créer une fabrique de données. Vous vous servez ensuite de l’outil Copier des données pour créer un pipeline qui copie uniquement et de façon incrémentielle les nouveaux fichiers et les fichiers modifiés du Stockage Blob Azure vers le Stockage Blob Azure. Il utilise LastModifiedDate pour déterminer les fichiers à copier.

Une fois que vous avez suivi les différentes étapes, Azure Data Factory analyse tous les fichiers du magasin source, applique le filtre de fichiers par LastModifiedDateet copie uniquement les fichiers qui ont été créés ou mis à jour depuis la dernière fois dans le magasin de destination. Sachez que, si Data Factory analyse un grand nombre de fichiers, les durées n’en restent pas moins longues. L’analyse des fichiers prend beaucoup de temps, même lorsque la quantité de données copiées est réduite.

Notes

Si vous débutez avec Data Factory, consultez Présentation d’Azure Data Factory.

Dans ce tutoriel, vous allez effectuer les tâches suivantes :

- Créer une fabrique de données.

- Utiliser l’outil Copier les données pour créer un pipeline.

- Surveiller les exécutions de pipeline et d’activité.

Prérequis

- Abonnement Azure : Si vous n’avez pas d’abonnement Azure, créez un compte gratuit avant de commencer.

- Compte Stockage Azure : Utilisez le Stockage Blob comme magasin de données source et récepteur. Si vous n’avez pas de compte stockage Azure, suivez les instructions indiquées dans Créer un compte de stockage.

Créer deux conteneurs dans le stockage d’objets blob

Préparez votre Stockage Blob pour le tutoriel :

Créez un conteneur nommé source. Vous pouvez utiliser différents outils pour effectuer cette tâche, comme l’Explorateur Stockage Azure.

Créez un conteneur nommé destination.

Créer une fabrique de données

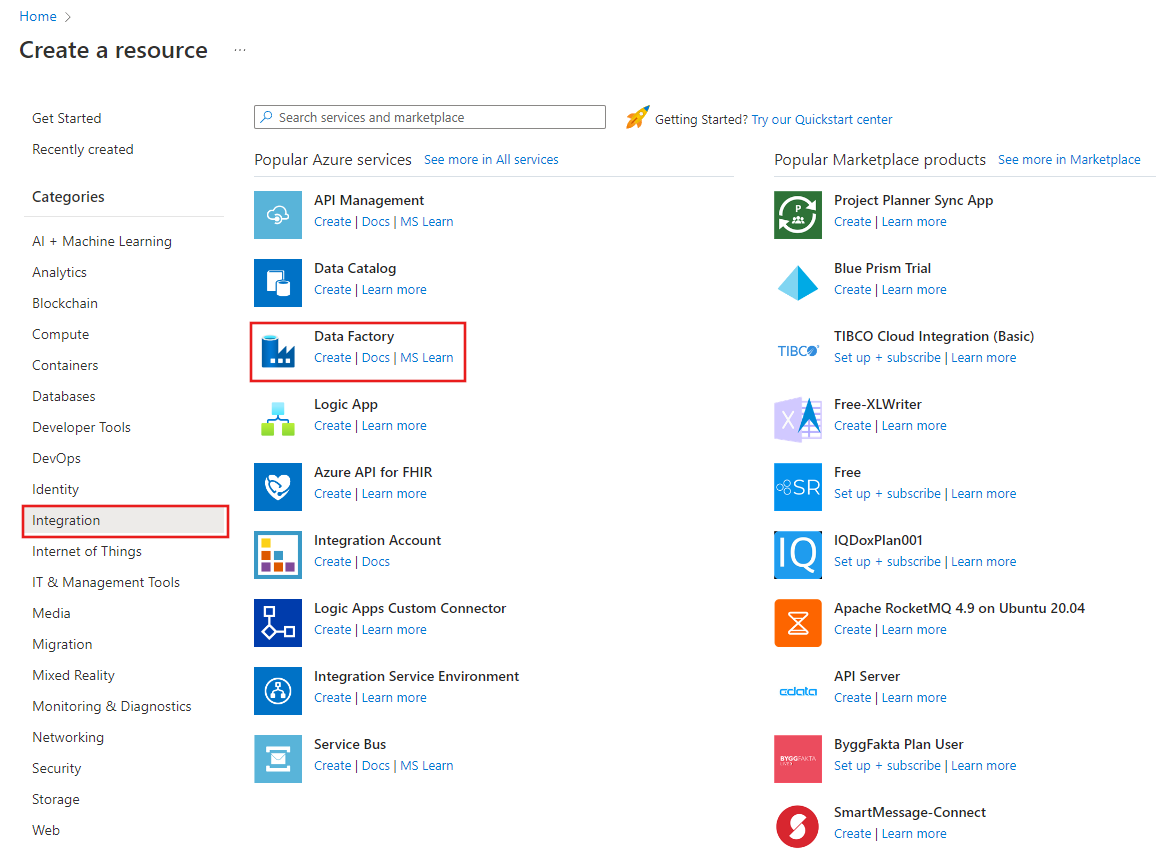

Dans le volet de gauche, sélectionnez Créer une ressource. Sélectionnez Intégration>Data Factory :

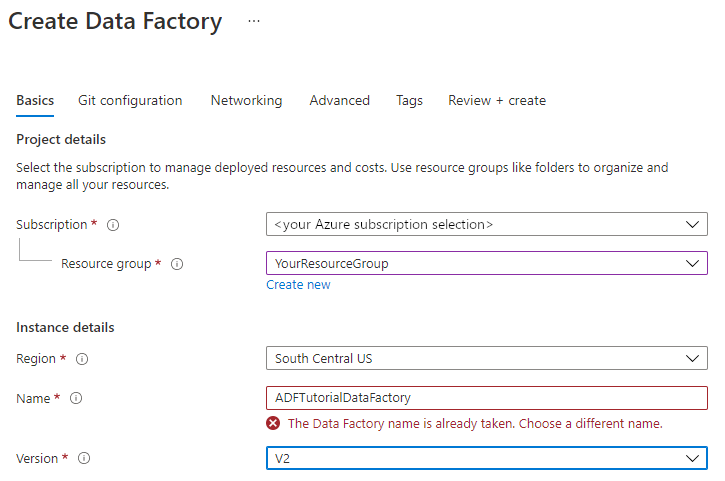

Sur la page Nouvelle fabrique de données, entrez ADFTutorialDataFactory dans le champ Nom.

Le nom de votre fabrique de données doit être un nom global unique. Il est possible que vous receviez ce message d’erreur :

Si vous recevez un message d’erreur concernant la valeur du nom, saisissez un autre nom pour la fabrique de données. Par exemple, utilisez le nom votrenomADFTutorialDataFactory. Pour savoir comment nommer les artefacts Data Factory, voir Data Factory - Règles d’affectation des noms.

Sous Abonnement, sélectionnez l’abonnement Azure dans lequel vous allez créer la fabrique de données.

Sous Groupe de ressources, vous avez deux possibilités :

Sélectionnez Utiliser existant, puis sélectionnez un groupe de ressources existant dans la liste.

Sélectionnez Créer, puis entrez un nom pour le groupe de ressources.

Pour plus d’informations sur les groupes de ressources, consultez Utilisation des groupes de ressources pour gérer vos ressources Azure.

Sous Version, sélectionnez V2.

Sous Emplacement, sélectionnez l’emplacement de la fabrique de données. Seuls les emplacements pris en charge apparaissent dans la liste. Les magasins de données (par exemple, Stockage Azure et SQL Database) et les services de calcul (par exemple, Azure HDInsight) utilisés par votre fabrique de données peuvent se trouver dans d’autres emplacements et régions.

Sélectionnez Create (Créer).

Une fois la fabrique de données créée, la page d’accueil de Data Factory apparaît.

Pour ouvrir l’interface utilisateur d’Azure Data Factory dans un onglet séparé, dans la vignette Ouvrir Azure Data Factory Studio, sélectionnez Ouvrir :

Utiliser l’outil Copier les données pour créer un pipeline

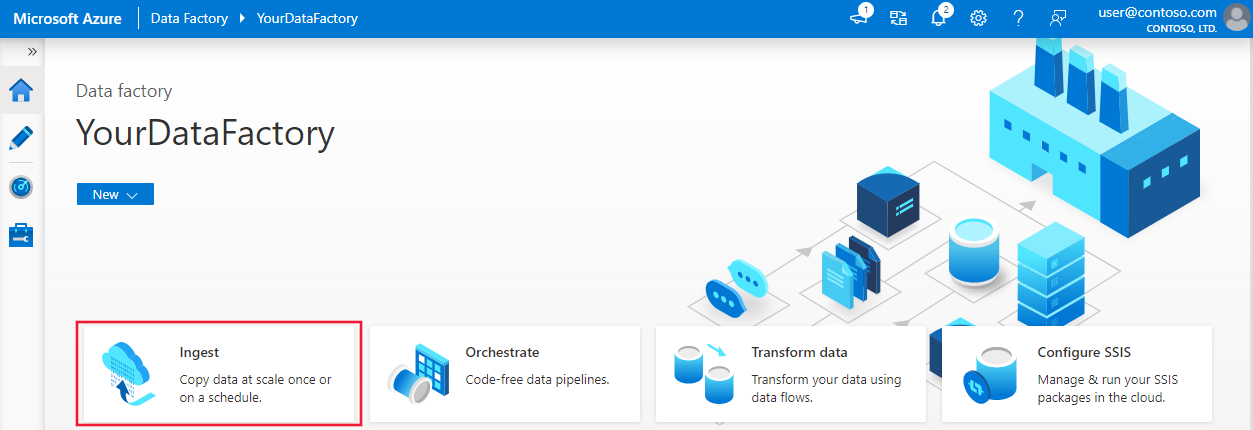

Sur la page d’accueil d’Azure Data Factory, sélectionnez le titre Ingérer pour lancer l’outil Copier des données :

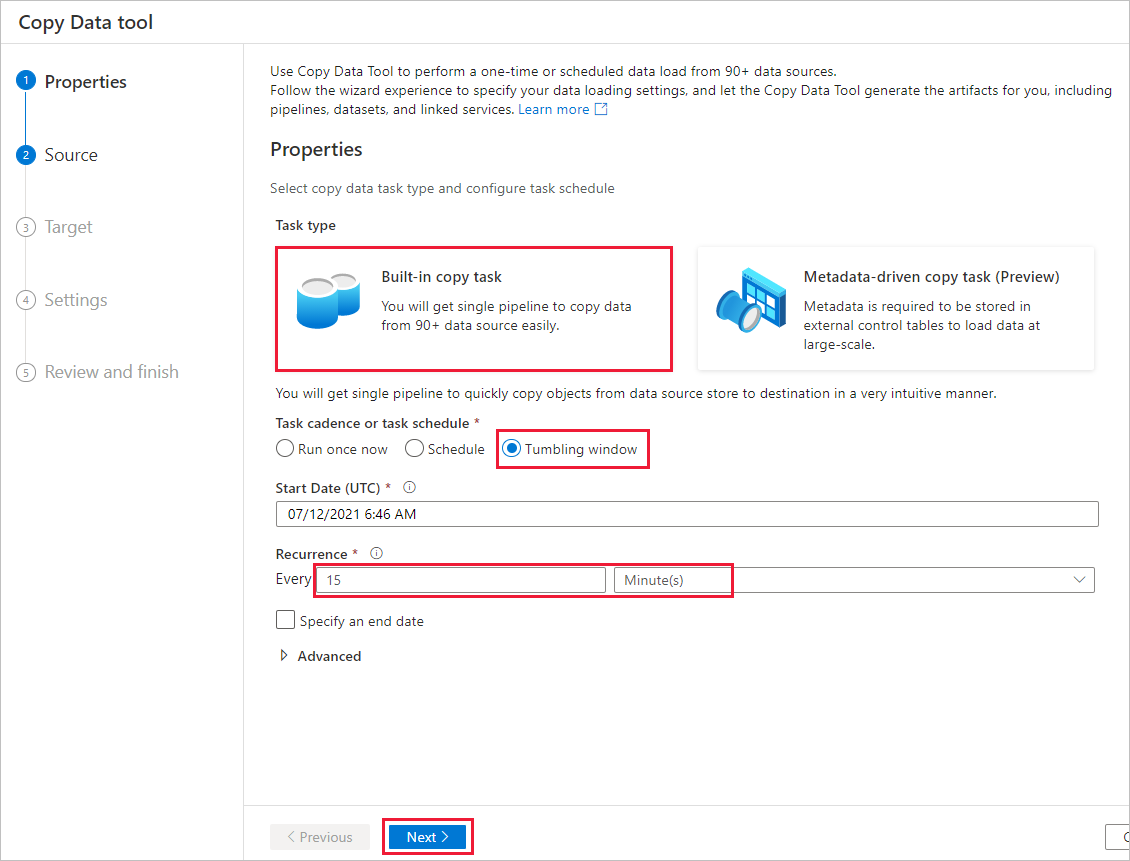

Dans la page Propriétés, effectuez les opérations suivantes :

Sous Type de tâche, sélectionnez Tâche de copie intégrée.

Sous Cadence des tâches ou calendrier des tâches, sélectionnez Fenêtre bascule.

Sous Périodicité, entrez 15 Minute(s) .

Sélectionnez Suivant.

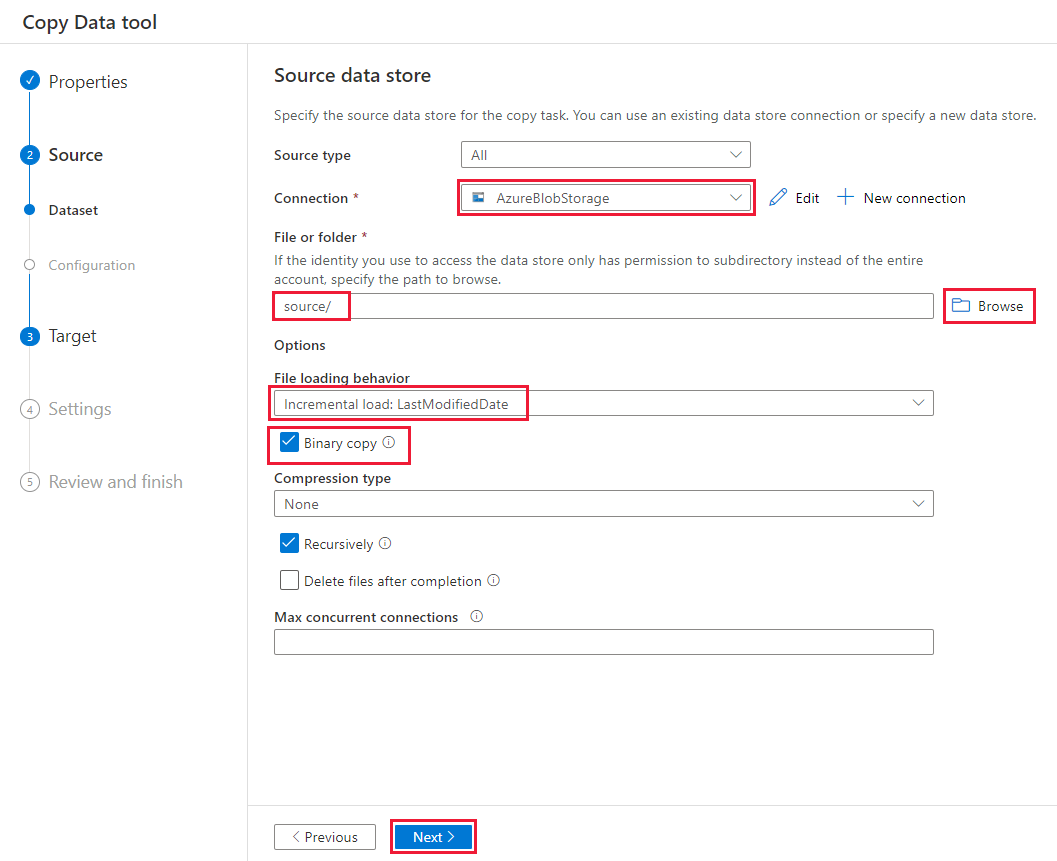

Sur la page Magasin de données source, procédez de la façon suivante :

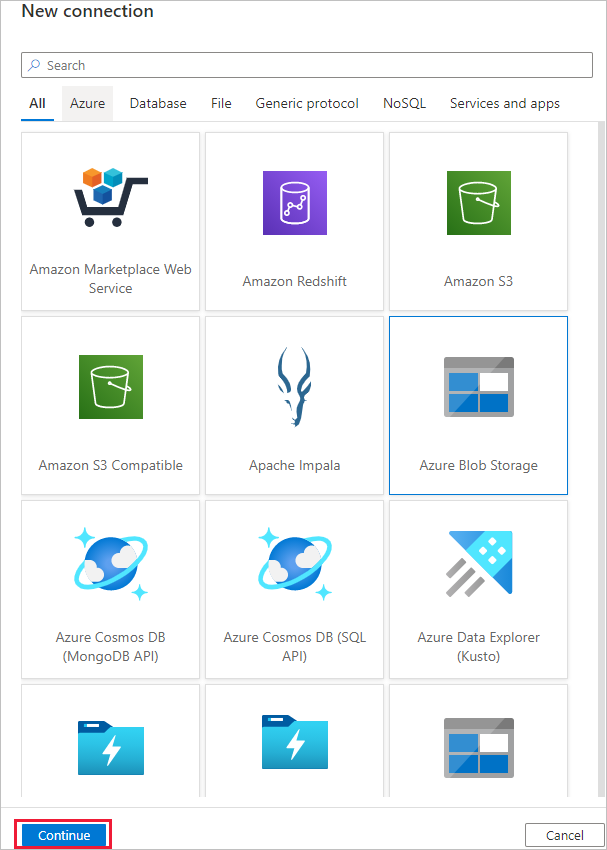

Sélectionnez + Nouvelle connexion pour ajouter une connexion.

Sélectionnez Stockage Blob Azure dans la galerie, puis Continuer :

Dans la page Nouvelle connexion (Stockage Blob Azure) , sélectionnez votre abonnement Azure dans la liste Abonnement Azure et votre compte de stockage dans la liste Nom du compte de stockage. Testez la connexion, puis sélectionnez Créer.

Sélectionnez la nouvelle connexion dans le bloc Connexion.

Dans la section Fichier ou dossier, sélectionnez Parcourir, puis le dossier source, puis OK.

Sous Comportement de chargement de fichier, sélectionnez Chargement incrémentiel : LastModifiedDate, puis Copie binaire.

Sélectionnez Suivant.

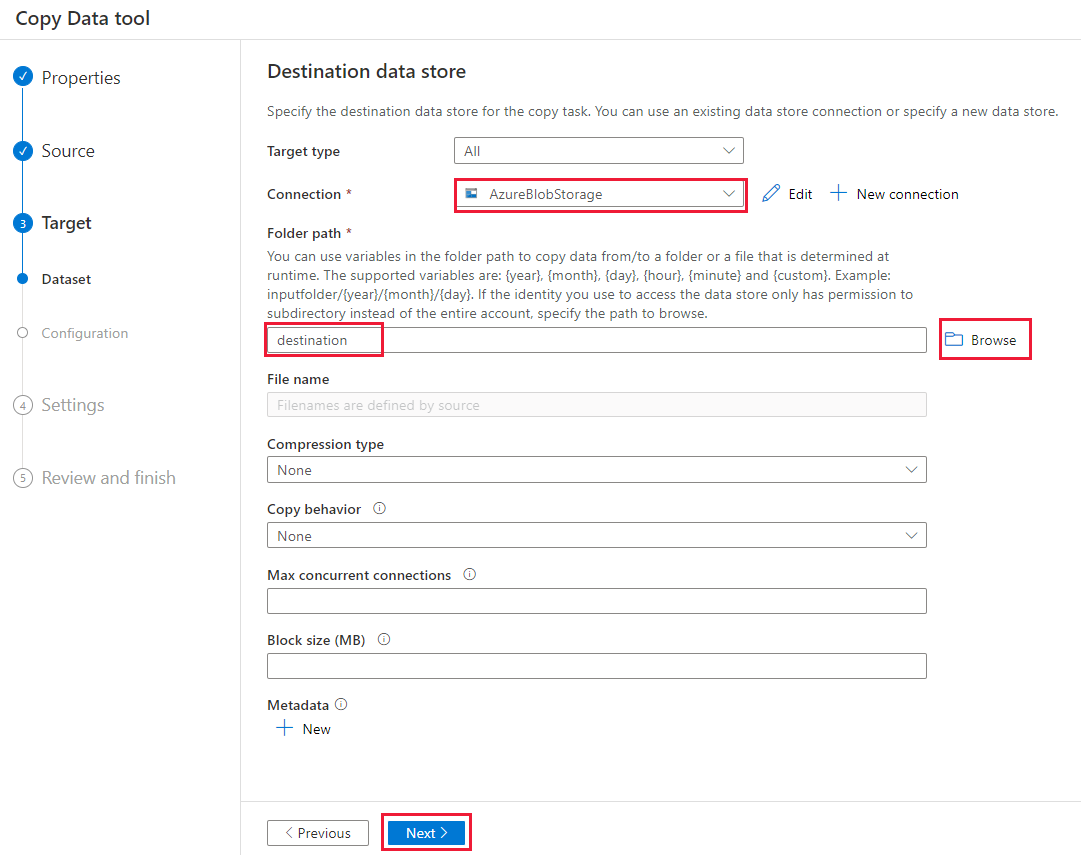

Sur la page Magasin de données de destination, procédez comme suit :

Sélectionnez la connexion AzureBlobStorage que vous avez créée. Il s’agit du même compte de stockage que la banque de données source.

Dans la section Chemin d’accès du dossier, recherchez et sélectionnez le dossier de destination, puis sélectionnez OK.

Sélectionnez Suivant.

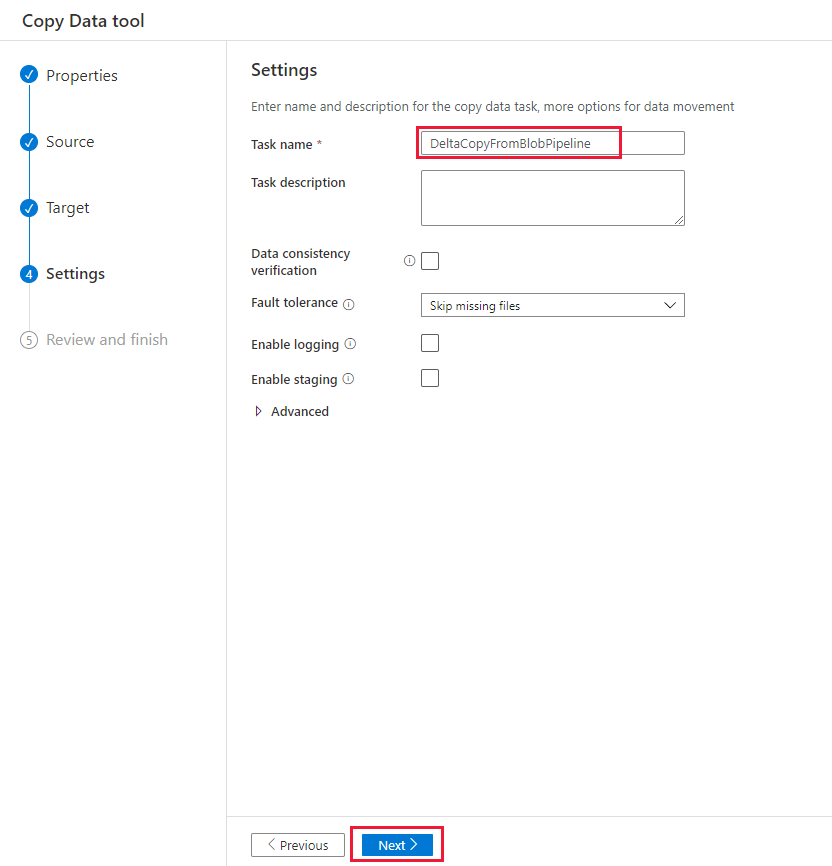

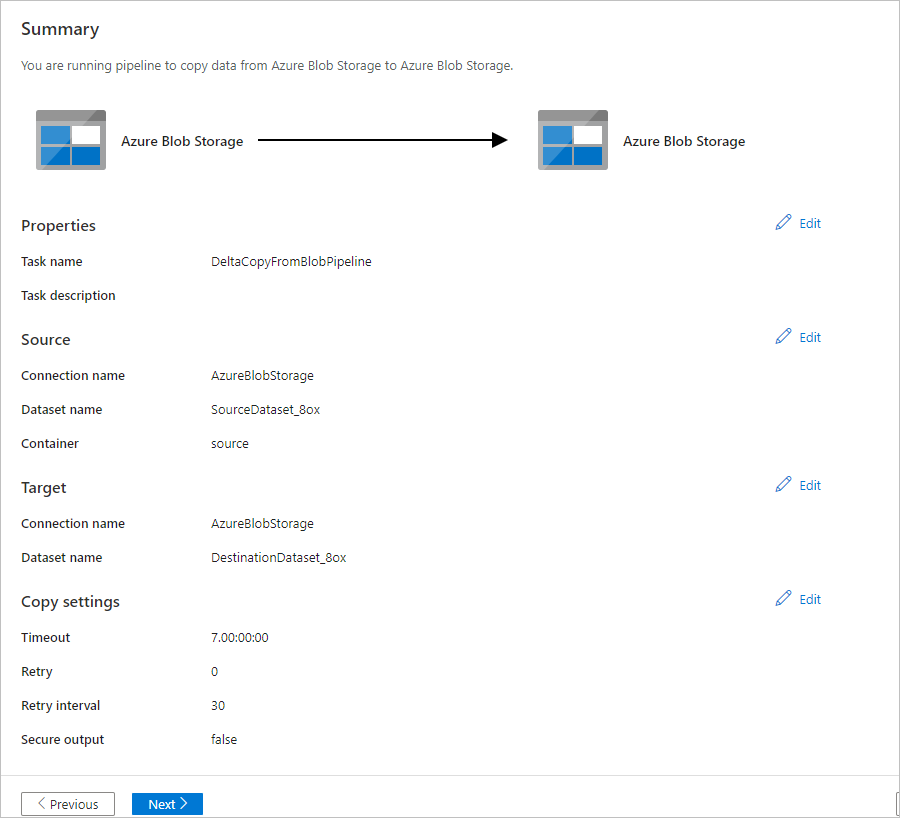

Sur la page Paramètres, sous Nom de la tâche, saisissez DeltaCopyFromBlobPipeline, puis sélectionnez Suivant. Data Factory crée un pipeline portant le nom de tâche spécifié.

Sur la page Résumé, vérifiez les paramètres, puis sélectionnez Suivant.

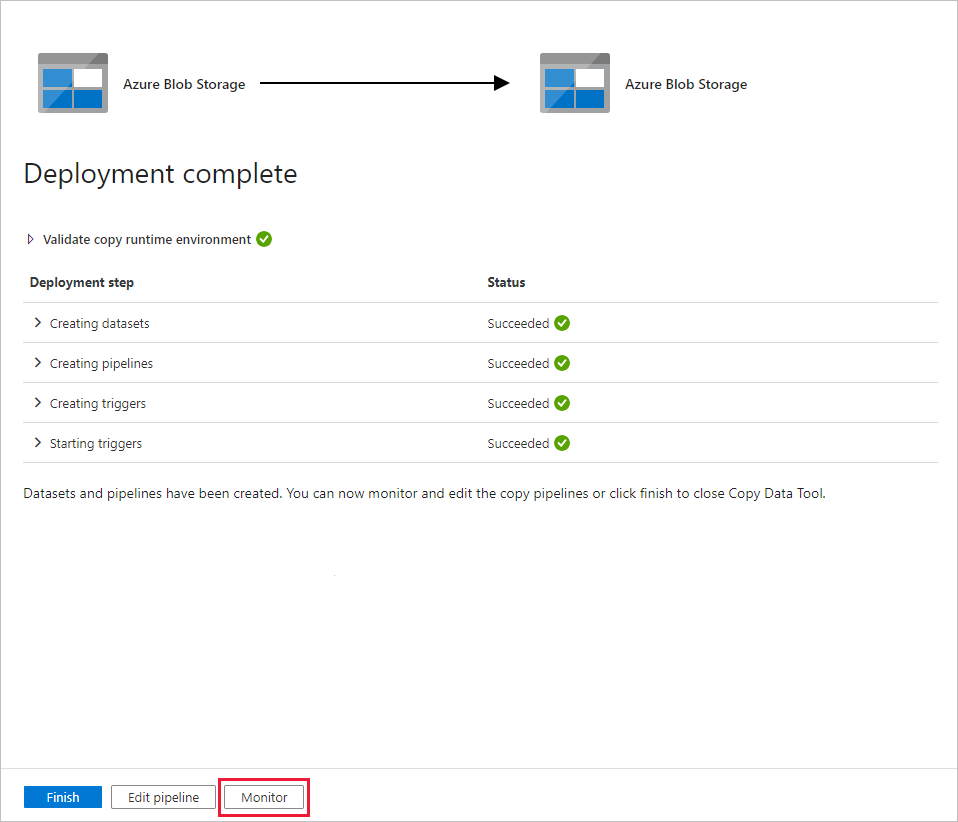

Sur la page Déploiement, sélectionnez Analyse pour analyser le pipeline (tâche).

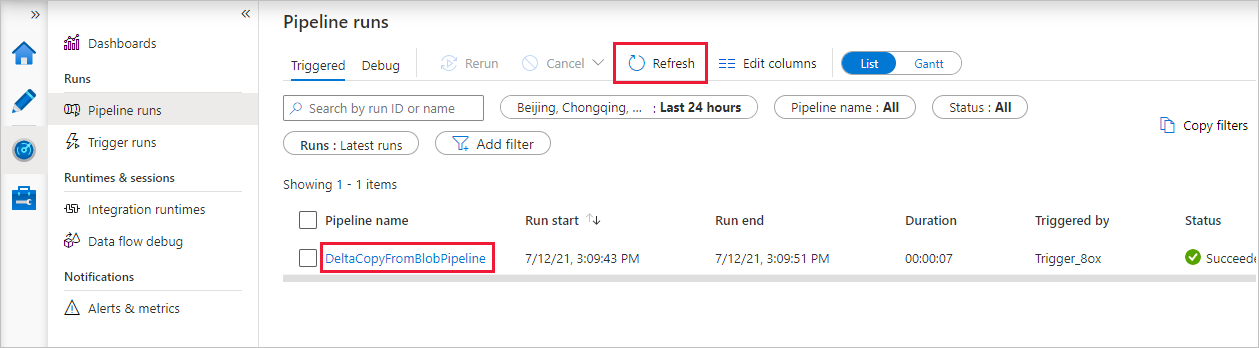

Notez que l’onglet Surveiller sur la gauche est sélectionné automatiquement. L’application bascule vers l’onglet Surveiller. Vous voyez l’état du pipeline. Sélectionnez Actualiser pour actualiser la liste. Sélectionnez le lien qui se trouve sous Nom du pipeline pour afficher les détails de l’exécution d’activité ou réexécuter le pipeline.

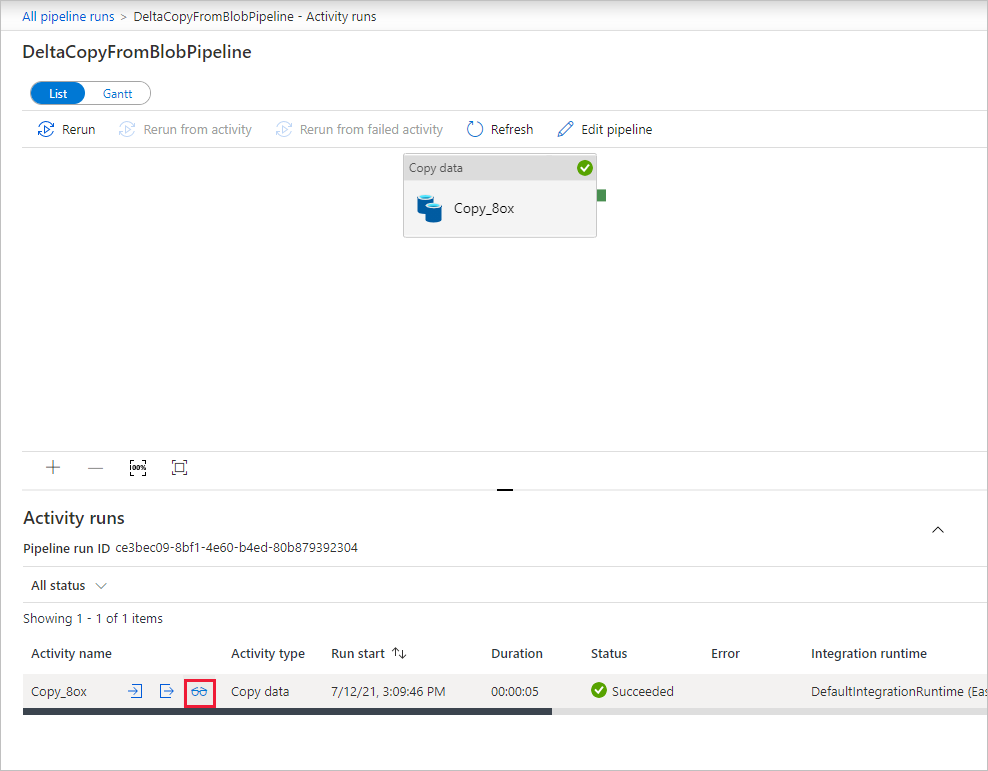

Il n’y a qu’une seule activité (l’activité de copie) dans le pipeline ; vous ne voyez donc qu’une seule entrée. Pour obtenir des détails sur l’opération de copie, dans la page Exécutions d’activités, sélectionnez le lien Détails (icône en forme de lunettes) dans la colonne Nom de l’activité. Pour plus d’informations sur les propriétés, consultez Vue d’ensemble de l’activité de copie.

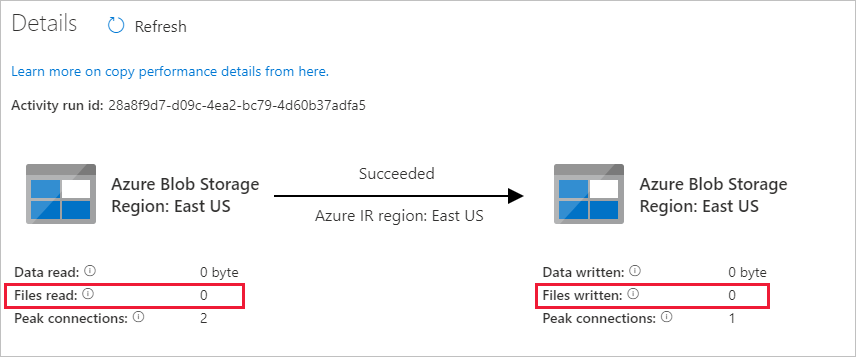

Étant donné qu’il n’existe aucun fichier dans le conteneur source de votre compte de Stockage Blob, vous ne trouverez aucun fichier copié dans le conteneur de destination du compte :

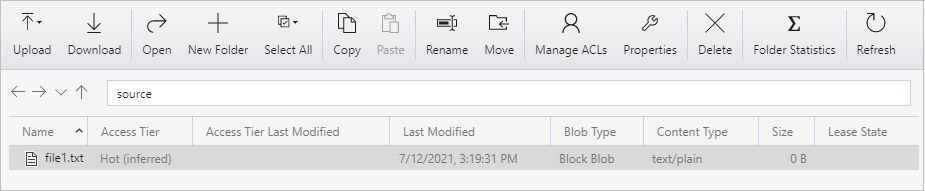

Créez un fichier texte vide et nommez-le file1.txt. Chargez ce fichier texte dans le conteneur source de votre compte de stockage. Vous pouvez utiliser différents outils pour effectuer ces tâches, comme l’Explorateur Stockage Azure.

Pour revenir à la vue Exécutions de pipelines, dans la page Exécutions d’activités, dans le menu de navigation, sélectionnez le lien Toutes les exécutions de pipelines, puis attendez que le même pipeline soit à nouveau déclenché automatiquement.

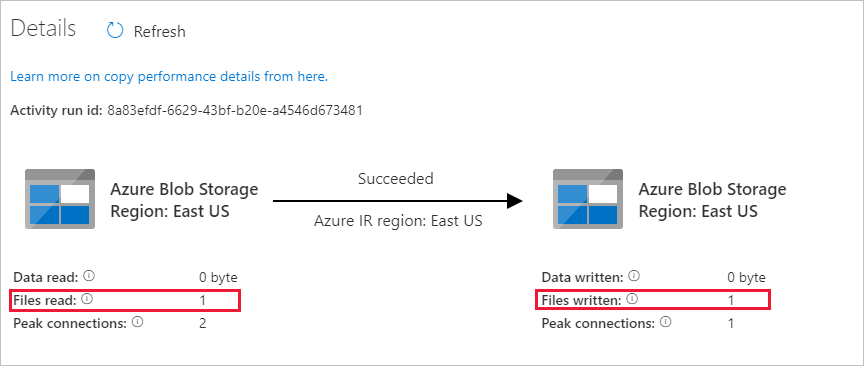

Une fois la deuxième exécution du pipeline terminée, suivez à nouveau la procédure précédente pour consulter les détails de l’exécution d’activité.

Vous constaterez qu’un fichier (file1.txt) a été copié du conteneur source vers le conteneur de destination de votre compte de Stockage Blob :

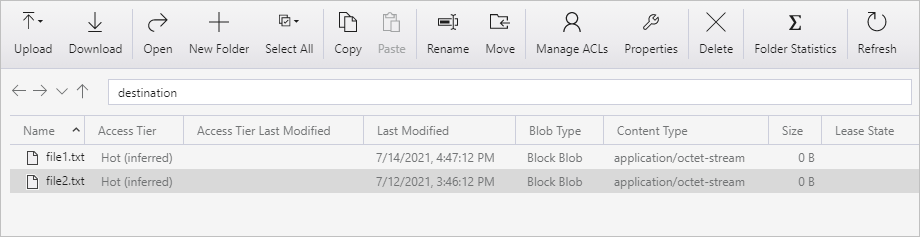

Créez un autre fichier texte vide et nommez-le file2.txt. Chargez ce fichier texte dans le conteneur source de votre compte de Stockage Blob.

Répétez les étapes 11 et 12 pour le deuxième fichier texte. Vous constaterez que seul le nouveau fichier (file2.txt) a été copié du conteneur source vers le conteneur de destination de votre compte de stockage lors de cette exécution de pipeline.

Vous pourrez également vérifier qu’un seul fichier a été copié en analysant les fichiers avec l’Explorateur Stockage Azure :

Contenu connexe

Passez au tutoriel suivant pour apprendre à transformer les données avec un cluster Apache Spark sur Azure :