Copier des données et les transformer toutes les heures avec des paramètres dynamiques

S’APPLIQUE À :  Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Conseil

Essayez Data Factory dans Microsoft Fabric, une solution d’analyse tout-en-un pour les entreprises. Microsoft Fabric couvre tous les aspects, du déplacement des données à la science des données, en passant par l’analyse en temps réel, l’aide à la décision et la création de rapports. Découvrez comment démarrer un nouvel essai gratuitement !

Dans ce scénario, vous souhaitez copier des données d’AWS S3 vers le Stockage Blob Azure et les transformer avec Azure Databricks (avec des paramètres dynamiques dans le script) selon une planification horaire pour 8 heures par jour pendant 30 jours.

Les prix mentionnés dans l’exemple ci-dessous sont hypothétiques et ne sont pas destinés à indiquer avec exactitude les tarifs réels. Les coûts de lecture/écriture et de monitoring ne sont pas affichés, car ils sont généralement négligeables et n’ont pas d’impact significatif sur les coûts globaux. Les exécutions d’activité sont également arrondies au 1 000e le plus proche dans les estimations de la calculatrice de prix.

Reportez-vous à la Calculatrice de tarification Azure pour obtenir des scénarios plus spécifiques et estimer vos coûts futurs d’utilisation du service.

Configuration

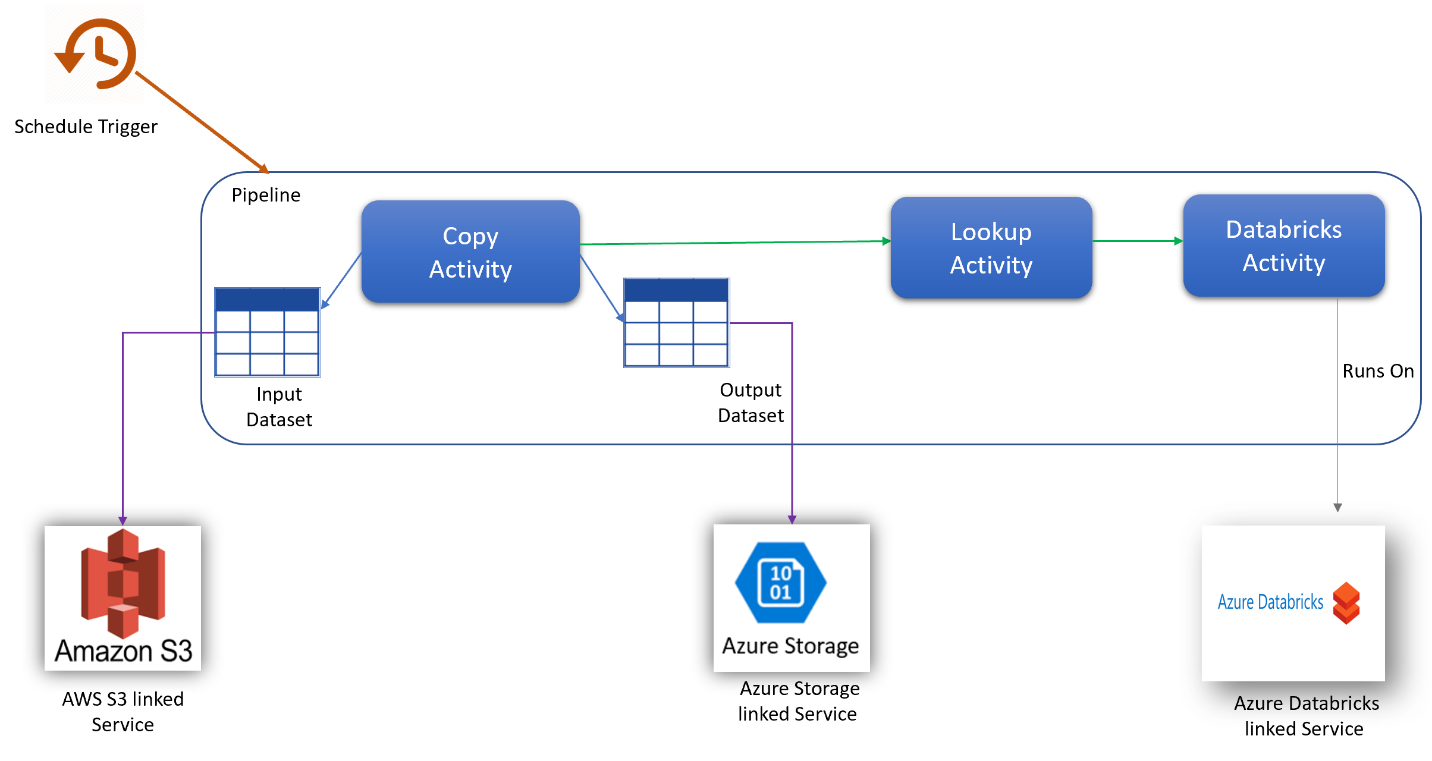

Pour réaliser ce scénario, créez un pipeline avec les éléments suivants :

- Une activité de copie avec un jeu de données d’entrée pour les données à copier à partir d’AWS S3 et un jeu de données de sortie pour les données sur le Stockage Azure.

- Une activité de recherche pour transmettre dynamiquement des paramètres au script de transformation.

- Une activité Azure Databricks pour la transformation de données.

- Un déclencheur de planification pour exécuter le pipeline pendant 8 heures par jour. Lorsque vous souhaitez exécuter un pipeline, vous pouvez le déclencher immédiatement ou le planifier. En plus du pipeline lui-même, chaque instance de déclencheur compte comme une seule exécution d’activité.

Estimation des coûts

| Opérations | Types et unités |

|---|---|

| Exécution d’un pipeline | 4 exécutions d’activité par exécution (1 pour l’exécution du déclencheur, 3 pour les exécutions d’activités) = 960 exécutions d’activité, arrondies à une valeur supérieure puisque la calculatrice autorise uniquement les incréments de 1 000. |

| Copie de données - Hypothèse : heures d’unités d’intégration de données (DIU) par exécution = 10 minutes | 10 minutes/60 minutes * 4 Azure Integration Runtime (paramètre DIU par défaut = 4) Pour plus d’informations sur les unités d’intégration de données et l’optimisation des performances de copie, consultez cet article |

| Exécuter l’activité de recherche - Hypothèse : heures d’activité de pipeline par exécution = 1 minute | 1 minute/60 minutes d’exécution de l’activité de pipeline |

| Exécuter l’activité Databricks - Hypothèse : heures d’exécution par exécution = 10 minutes | 10 minutes/60 minutes d’exécution de l’activité de pipeline externe |

Exemple de tarification : Exemple de calculatrice de prix

Prix total du scénario pour 30 jours : 41,03 $

Contenu connexe

- Exemple de tarification : Copier des données d’AWS S3 vers le Stockage Blob Azure toutes les heures pendant 30 jours

- Exemple de tarification : Copier des données et les transformer toutes les heures avec Azure Databricks pendant 30 jours

- Exemple de tarification : Exécuter des packages SSIS sur le runtime d’intégration Azure-SSIS

- Exemple de tarification : Utilisation du débogage du flux de données de mappage pour une journée de travail normale

- Exemple de tarification : Transformation des données dans le magasin d’objets blob avec des flux de données de mappage

- Exemple de tarification : Intégration de données dans un VNET managé Azure Data Factory

- Exemple de tarif : Obtenir des données delta à partir de SAP ECC via SAP CDC dans les flux de données de mappage