Qualité des données

La qualité des données est une fonction de gestion de l’analytique à l’échelle du cloud. Elle réside dans la zone d’atterrissage de gestion des données et fait partie intégrante de la gouvernance.

Considérations relatives à la qualité des données

La qualité des données est la responsabilité de chaque personne qui crée et consomme des produits de données. Les créateurs doivent respecter les règles globales et les règles du domaine, tandis que les consommateurs doivent signaler toute incohérence dans les données au domaine de données propriétaire au moyen d’une boucle de commentaires.

Étant donné que la qualité des données concerne toutes les données fournies au conseil, le processus commence en principe en haut de l’organisation. Le conseil doit avoir des insights sur la qualité des données fournies à ces derniers.

Même en faisant preuve de proactivité, toutefois, vous devez disposer d’experts en qualité des données capables de nettoyer les compartiments de données à corriger. Évitez d’envoyer ce travail à une équipe centrale et ciblez plutôt le domaine des données, avec des connaissances spécifiques sur celles-ci, pour nettoyer les données.

Métriques de qualité des données

Les métriques de qualité des données sont essentielles à l’évaluation et à l’augmentation de la qualité des produits de données. Au niveau global et au niveau du domaine, vous devez décider de vos métriques de qualité. Au minimum, nous vous recommandons les métriques suivantes :

| Mesures | Définitions de métriques |

|---|---|

| Complétude = % du total des valeurs non nulles + non vides | Mesure la disponibilité des données, les champs non vides du jeu de données et les valeurs par défaut qui ont été modifiées. Par exemple, si un enregistrement inclut 01/01/1900 comme date de naissance, il est très probable que le champ n’a jamais été rempli. |

| Unicité = % des valeurs non dupliquées | Mesure les valeurs distinctes dans une colonne donnée par rapport au nombre de lignes de la table. Par exemple, compte tenu de quatre valeurs de couleur distinctes (rouge, bleu, jaune et vert) dans une table comportant cinq lignes, ce champ est unique à 80 % (ou 4/5). |

| Cohérence = % des données comportant des modèles | Mesure, dans une colonne donnée, la conformité au type ou au format de données attendu, par exemple un champ d’adresse e-mail contenant des adresses e-mail mises en forme ou un champ de nom comportant des valeurs numériques. |

| Validité = % de correspondance à la référence | Mesure la réussite de la correspondance des données à leur ensemble de références du domaine. Par exemple, étant donné un champ de pays/région (conforme aux valeurs de taxonomie) dans un système d’enregistrements transactionnels, la valeur « US of A » n’est pas valide. |

| Précision = % des valeurs inchangées | Mesure la réussite de la reproduction des valeurs prévues sur plusieurs systèmes. Par exemple, si une facture apparaître une référence SKU et un prix étendu qui diffère de la commande d’origine, l’article indiqué est incorrect. |

| Liaison = % des données bien intégrées | Mesure la réussite de l’association avec les informations de référence correspondantes dans un autre système. Par exemple, si une facture fait apparaître une référence SKU ou une description de produit incorrecte, l’article indiqué ne peut pas être lié. |

Profilage des données

Le profilage des données examine les produits de données inscrits dans le catalogue de données et collecte des statistiques et des informations sur ces données. Pour fournir des vues récapitulatives et des tendances sur la qualité des données au fil du temps, stockez ces données dans votre référentiel de métadonnées sur le produit de données.

Les profils de données aident les utilisateurs à répondre à des questions sur les produits de données :

- Ces données peuvent-elles m’aider à résoudre mon problème métier ?

- Les données sont-elles conformes à des normes ou modèles spécifiques ?

- La source de données comporte-t-elle des anomalies et, si oui, lesquelles ?

- Quels sont les défis possibles de l’intégration de ces données dans mon application ?

Les utilisateurs peuvent voir le profil de produit de données à l’aide d’un tableau de bord de création de rapports situé sur leur place de marché des données.

Vous pouvez créer un rapport sur différents éléments :

- Complétivité : indique le pourcentage de données qui ne sont pas vides ou null.

- Unicité : indique le pourcentage de données qui ne sont pas dupliquées.

- Cohérence : indique les données où l’intégrité des données est conservée.

Recommandations relatives à la qualité des données

Pour implémenter le processus de qualité des données, vous devez exploiter la puissance humaine et informatique comme suit :

Utilisez des solutions qui incluent des algorithmes, des règles, du profilage de données et des métriques.

Faites appel à des experts du domaine qui peuvent intervenir si nécessaire pour effectuer l’apprentissage d’un algorithme en raison d’un grand nombre d’erreurs passant par la couche de calcul.

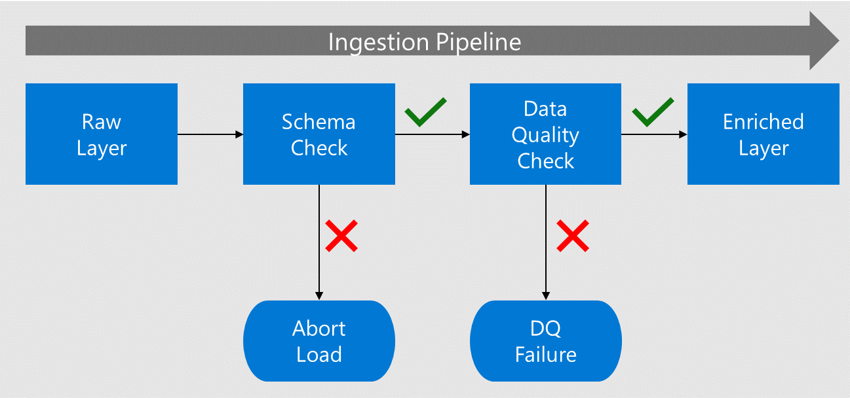

Effectuez une validation dès le début. Les solutions traditionnelles appliquent des contrôles de qualité des données après l’extraction, la transformation et le chargement des données. À ce stade, le produit de données est déjà consommé, et des erreurs apparaissent dans les produits de données en aval. Implémentez plutôt, au fur et à mesure que les données sont ingérées à partir de la source, des contrôles de qualité des données près des sources, et ce, avant que les consommateurs situés en aval n’utilisent les produits de données. En cas d’ingestion par lots à partir du lac de données, effectuez ces vérifications lors du passage des données de l’état brut à l’état enrichi.

Avant que les données ne soient déplacées vers la couche enrichie, leur schéma et leurs colonnes sont vérifiés par rapport aux métadonnées inscrites dans le catalogue de données.

Si les données contiennent des erreurs, la charge est arrêtée et l’équipe d’application de données est avertie de l’échec.

Si les vérifications de schéma et de colonne sont réussies, les données sont chargées dans les couches enrichies avec des types de données conformes.

Avant le passage à la couche enrichie, un processus de qualité des données vérifie la conformité par rapport aux algorithmes et aux règles.

Conseil

Définissez des règles de qualité des données au niveau global et au niveau du domaine. Cela permet à l’entreprise de fixer ses normes pour chaque produit de données créé et aux domaines de données de créer des règles supplémentaires liées à leur domaine.

Solutions de qualité des données

Nous recommandons d’évaluer Microsoft Purview Data Quality comme solution pour évaluer et gérer la qualité des données, ce qui est crucial pour des informations fiables et une prise de décision basée sur l’IA. Il inclut :

- Règles sans code/faible code : Évaluez la qualité des données en utilisant des règles prêtes à l’emploi générées par l’IA.

- Profilage des données alimenté par l’IA : Recommande des colonnes pour le profilage et permet une intervention humaine pour les ajustements.

- Scoring de la qualité des données : Fournit des scores pour les actifs de données, les produits de données et les domaines de gouvernance.

- Alertes de qualité des données : Avertit les propriétaires de données des problèmes de qualité.

Pour plus d'informations, voir Qu'est-ce que la qualité des données ?

Si votre organisation décide d’implémenter Azure Databricks pour manipuler des données, vous devez évaluer les contrôles de qualité des données, les tests, la surveillance et l’application de cette solution. L’utilisation des expectations peut capturer les problèmes de qualité des données à l’ingestion avant qu’ils n’affectent les produits de données enfants associés. Pour plus d’informations, veuillez consulter la section Établir des normes de qualité des données et Gestion de la qualité des données avec Databricks.

Vous pouvez également choisir une solution de qualité des données parmi des partenaires, des options open source et des options personnalisées.

Résumé de la qualité des données

Une mauvaise qualité des données peut avoir de graves conséquences pour une entreprise. Elle risque de conduire des unités commerciales à interpréter des produits de données de différentes façons. Cette mauvaise interprétation peut s’avérer coûteuse pour l’entreprise si les décisions sont basées sur des produits de données dont la qualité des données est inférieure. La résolution des produits de données avec des attributs manquants peut être une tâche coûteuse et peut nécessiter des rechargements complets de données à partir de plusieurs périodes.

Validez la qualité des données dès le début et mettez en place des processus pour répondre de manière proactive à une mauvaise qualité des données. Par exemple, un produit de données ne peut pas être mis en production tant qu’il n’a pas atteint un certain niveau d’exhaustivité.

Vous pouvez utiliser les outils librement. Assurez-vous toutefois qu’ils comprennent les attentes (règles), les métriques de données, le profilage et la possibilité de sécuriser les attentes pour pouvoir implémenter les exigences globales et les exigences propres à chaque domaine.