Comprendre les grands volumes dans Azure NetApp Files

Les volumes dans Azure NetApp Files constituent votre moyen de présenter une haute performance, un stockage économique aux clients de votre stockage en réseau NAS dans le cloud Azure. Les volumes agissent comme systèmes de fichiers indépendants avec leurs propres capacité, nombres de fichiers, listes de contrôle d’accès (ACL), captures instantanées et ID de système de fichiers. Ces qualités fournissent le moyen d’avoir des jeux de données distincts dans des tenants sécurisés individuels.

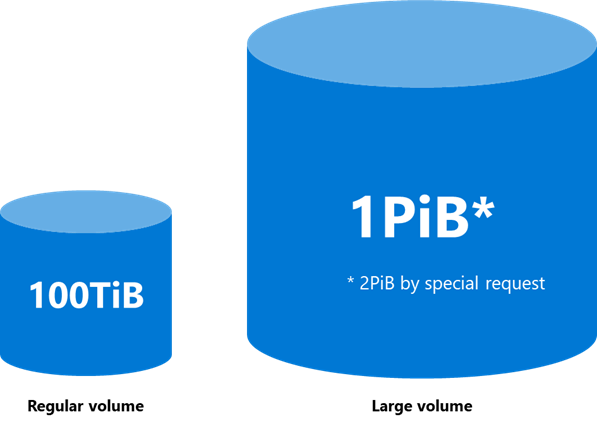

Toutes les ressources ont des limites dans Azure NetApp Files. Les volumes normaux présentent les limites suivantes :

| Type de limite | Limites |

|---|---|

| Capacité |

|

| Nombre de fichiers | 2 147 483 632 |

| Performances |

|

Les grands volumes présentent les limites suivantes :

| Type de limite | Valeurs |

|---|---|

| Capacité |

|

| Nombre de fichiers | 15 938 355 048 |

| Performances |

|

Effet des grands volumes sur le niveau de performance

Dans la plupart des cas, un volume normal peut traiter les besoins en niveau de performance d’une charge de travail de production, en particulier lors du traitement des charges de travail d’une base de données, des partages de fichiers généraux et des charges de travail d’une infrastructure de bureau virtuel (VDI) Azure VMware Service. Lorsque des charges de travail sont lourdes en métadonnées ou nécessitent une mise à l’échelle excédant ce qu’un volume normal peut traiter, un grand volume peut augmenter les besoins en niveau de performance avec un impact minimal sur les coûts.

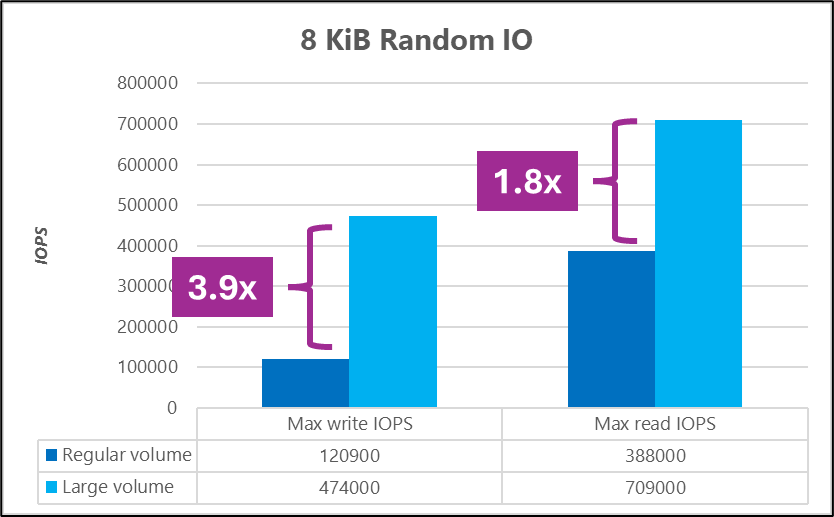

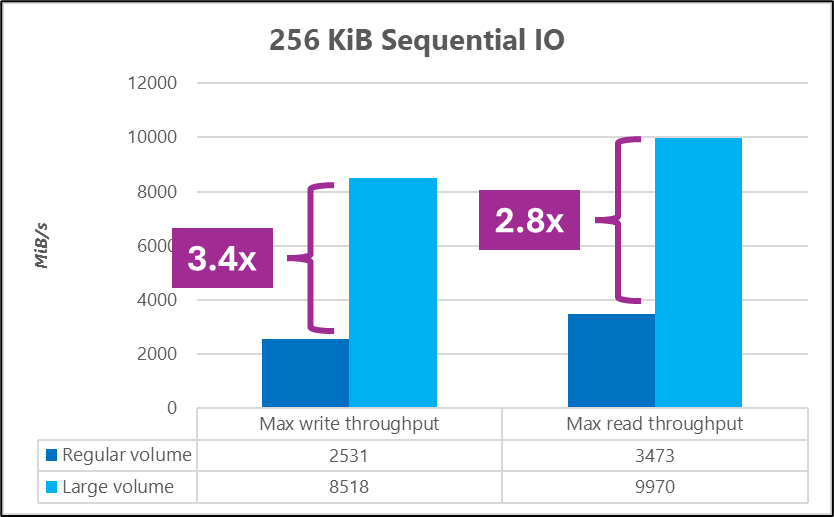

Par exemple, les graphiques suivants montrent qu’un grand volume peut fournir deux à trois fois le niveau de performance à grande échelle d’un volume normal.

Pour découvrir plus d’informations sur les tests du niveau de performance, consultez Tests de niveau de performance de grands volumes pour Linux et Benchmarks des performances des volumes standard pour Linux.

Par exemple, dans des tests de point de référence du secteur utilisant FIO (Testeur d’E/S flexible), un grand volume a atteint un débit et des I/OPS supérieurs à un volume normal.

Cas d’utilisation et types de charge de travail

Les volumes normaux peut traiter la plupart des charges de travail. Une fois la capacité, le nombre de fichier, le niveau de performance ou les limites de mise à l’échelle atteints, de nouveaux volumes doivent être créés. Cette condition ajoute une complexité inutile à une solution.

Les grands volumes permettent aux charges de travail de s’étendre au-delà des limites actuelles des volumes normaux. Le tableau suivant montre des exemples de cas d’utilisation pour chaque type de volume.

| Type de volume | Cas d’utilisation principaux |

|---|---|

| Volumes normaux |

|

| Grands volumes |

|