Passez en revue le modèle de référence réseau de déploiement à deux nœuds sans basculement pour Azure Local

S’applique à : Azure Local 2311.2 et versions ultérieures

Cet article décrit le modèle de référence réseau à deux nœuds avec un seul modèle de référence réseau de commutateur TOR que vous pouvez utiliser pour déployer votre solution Locale Azure. Les informations contenues dans cet article vous aident également à déterminer si cette configuration est viable pour vos besoins de planification de déploiement. Cet article cible les administrateurs informatiques qui déploient et gèrent Azure Local dans leurs centres de données.

Pour plus d’informations sur les autres modèles de réseau, consultez les modèles de déploiement de réseau local Azure.

Scénarios

Les scénarios de ce réseau incluent les laboratoires, les usines, les magasins de détail et les installations gouvernementales.

Considérez ce modèle pour une solution économique qui inclut la tolérance de panne au niveau du système, mais peut tolérer des interruptions de connectivité northbound si le commutateur physique unique échoue ou nécessite une maintenance.

Vous pouvez effectuer un scale-out de ce modèle, mais cela nécessite un temps d’arrêt de la charge de travail pour reconfigurer la connectivité physique du stockage et la reconfiguration du réseau de stockage. Bien que les services SDN L3 soient entièrement pris en charge pour ce modèle, les services de routage tels que BGP doivent être configurés sur l’appareil de pare-feu au-dessus du commutateur TOR s’il ne prend pas en charge les services L3. Les fonctionnalités de sécurité réseau telles que la microsegmentation et la QoS ne nécessitent pas de configuration supplémentaire sur l’appareil de pare-feu, car elles sont implémentées sur le commutateur virtuel.

Composants de connectivité physique

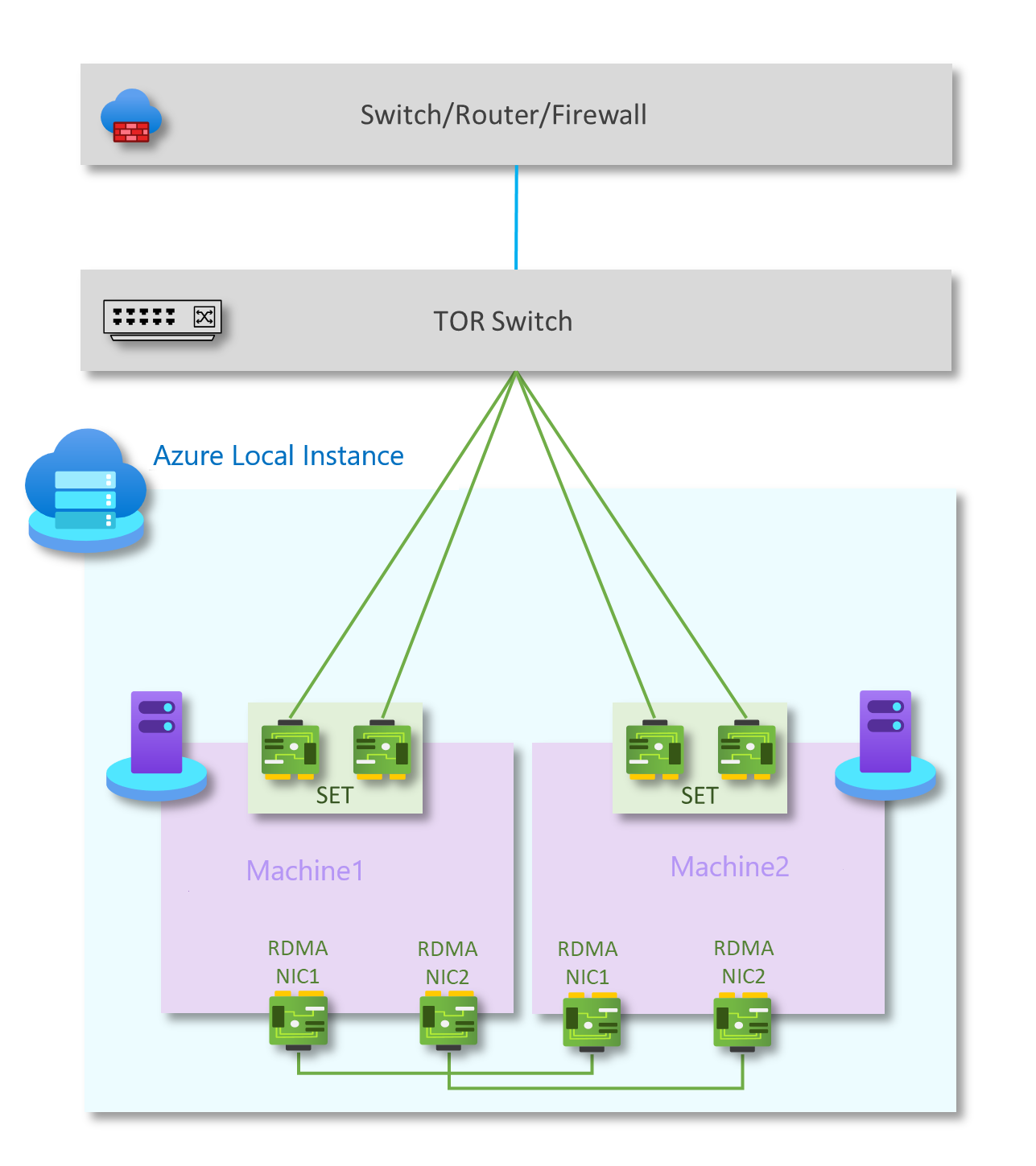

Comme illustré dans le diagramme suivant, ce modèle comporte les composants réseau physiques suivants :

Commutateur TOR unique pour la communication du trafic nord-sud.

Deux ports réseau en équipe pour gérer la gestion et le trafic de calcul, connectés au commutateur L2 sur chaque hôte

Deux cartes réseau RDMA dans une configuration de maillage complet pour le trafic est-ouest pour le stockage. Chaque nœud du système dispose d’une connexion redondante à l’autre nœud du système.

En guise d’option, certaines solutions peuvent utiliser une configuration sans tête sans carte BMC à des fins de sécurité.

| Réseaux | Gestion et calcul | Stockage | BMC |

|---|---|---|---|

| Vitesse de liaison | Au moins 1 Gbit/s. 10 Gbits/s recommandés | Au moins 10 Gbits/s | Vérifier auprès du fabricant du matériel |

| Type d'interface | RJ45, SFP+ ou SFP28 | SFP+ ou SFP28 | RJ45 |

| Ports et agrégation | Deux ports en équipe | Deux ports autonomes | Un port |

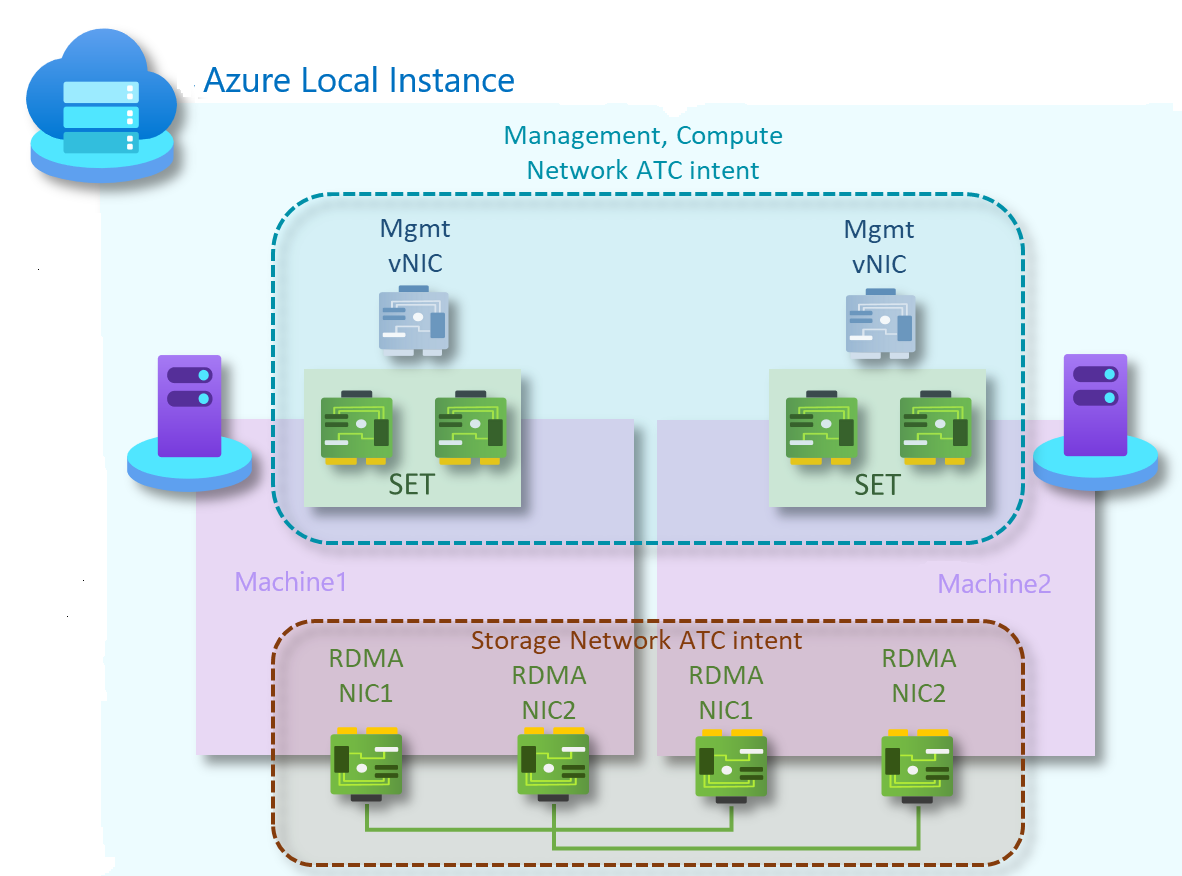

Intentions d’ATC réseau

Pour les modèles sans commutateur de stockage à deux nœuds, deux intentions ATC réseau sont créées. La première pour la gestion et le trafic réseau de calcul, et la seconde pour le trafic de stockage.

Intention de gestion et de calcul

- Type d’intention : gestion et calcul

- Mode intention : mode cluster

- Teaming : Oui. pNIC01 et pNIC02 sont en équipe

- Réseau local virtuel de gestion par défaut : le réseau local virtuel configuré pour les adaptateurs de gestion n’est pas modifié

- PA &Compute VLAN et vNICs : Network ATC est transparent pour les cartes réseau et les réseaux locaux virtuels de machine virtuelle de calcul ou les réseaux virtuels virtuels

Intention de stockage

- Type d’intention : Stockage

- In mode tente : Mode cluster

- Association : pNIC03 et pNIC04 utilisent SMB Multichannel pour fournir une résilience et une agrégation de bande passante

- Réseaux locaux virtuels par défaut :

- 711 pour le réseau de stockage 1

- 712 pour le réseau de stockage 2

- Sous-réseaux par défaut :

- 10.71.1.0/24 pour le réseau de stockage 1

- 10.71.2.0/24 pour le réseau de stockage 2

Pour plus d’informations, consultez Déployer la mise en réseau de l’hôte.

Procédez comme suit pour créer des intentions réseau pour ce modèle de référence :

Démarrez PowerShell en tant qu'administrateur.

Exécutez la commande suivante :

Add-NetIntent -Name <Management_Compute> -Management -Compute -ClusterName <HCI01> -AdapterName <pNIC01, pNIC02> Add-NetIntent -Name <Storage> -Storage -ClusterName <HCI01> -AdapterName <pNIC03, pNIC04>

Composants de connectivité logique

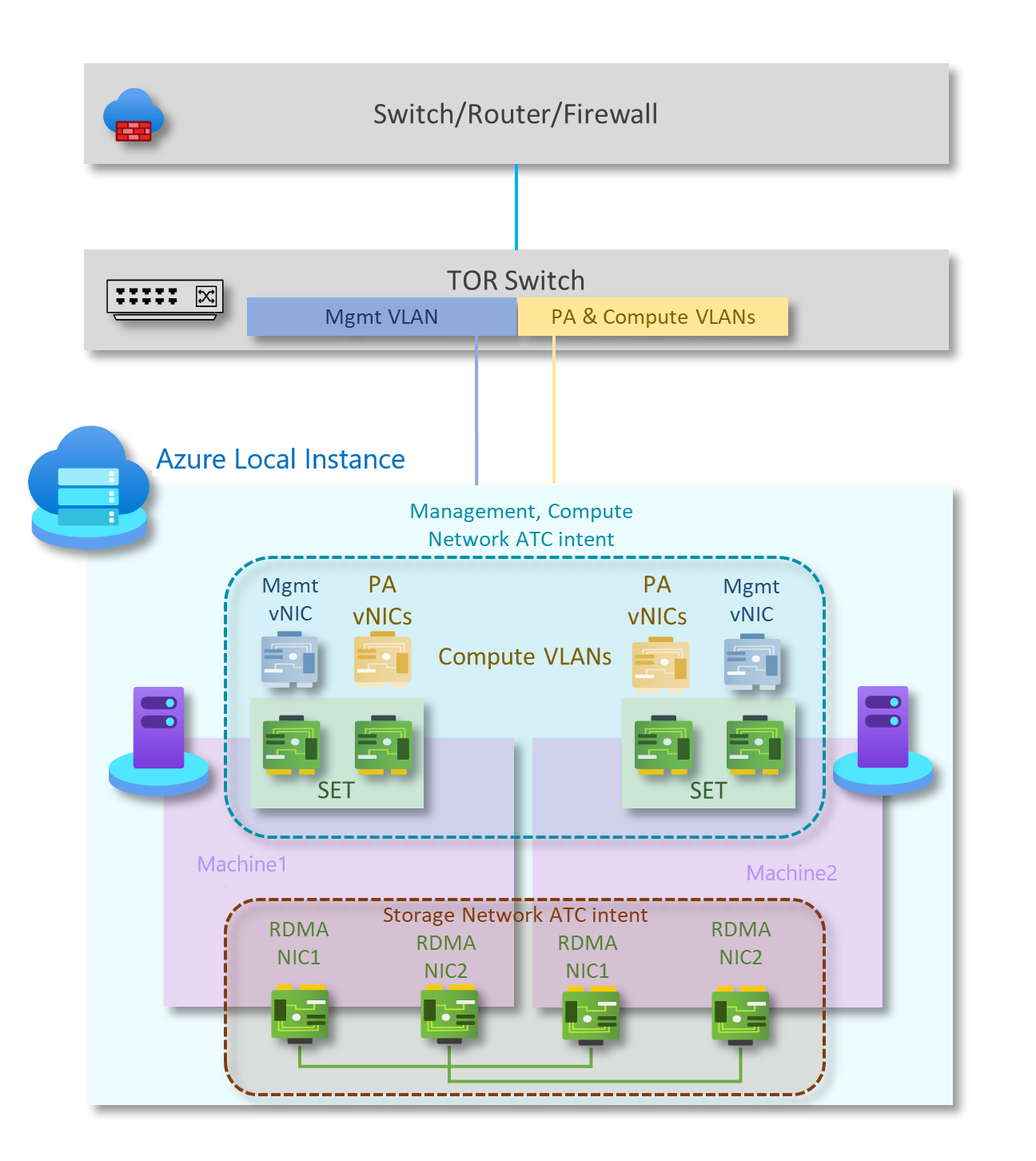

Comme illustré dans le diagramme ci-dessous, ce modèle comporte les composants réseau logiques suivants :

Réseaux locaux virtuels du réseau de stockage

Le trafic basé sur l’intention de stockage se compose de deux réseaux individuels prenant en charge le trafic RDMA. Chaque interface sera dédiée à un réseau de stockage distinct, et les deux peuvent utiliser la même balise VLAN. Ce trafic est destiné uniquement à se déplacer entre les deux nœuds. Le trafic de stockage est un réseau privé sans connectivité à d’autres ressources.

Les adaptateurs de stockage fonctionnent sur différents sous-réseaux IP. Pour activer une configuration sans commutateur, chaque nœud connecté prend en charge un sous-réseau correspondant de son voisin. Chaque réseau de stockage utilise les réseaux locaux virtuels prédéfinis Network ATC par défaut (711 et 712). Toutefois, ces réseaux locaux virtuels peuvent être personnalisés si nécessaire. En outre, si les sous-réseaux par défaut définis par Network ATC (10.71.1.0/24 et 10.71.2.0/24) ne sont pas utilisables, vous êtes responsable de l’attribution de toutes les adresses IP de stockage dans le système.

Pour plus d’informations, consultez la vue d’ensemble de Network ATC.

Réseau OOB

Le réseau OOB (Out of Band) est dédié à la prise en charge de l’interface de gestion de serveur « lights-out » également appelée contrôleur de gestion du tableau de base (BMC). Chaque interface BMC se connecte à un commutateur fourni par le client. La console BMC est utilisée pour automatiser les scénarios de démarrage PXE.

Le réseau de gestion nécessite l’accès à l’interface BMC à l’aide du port UDP (Intelligent Platform Management Interface) 623.

Le réseau OOB est isolé des charges de travail de calcul et est facultatif pour les déploiements non basés sur la solution.

Réseau local virtuel de gestion

Tous les hôtes de calcul physiques nécessitent l’accès au réseau logique de gestion. Pour la planification des adresses IP, chaque hôte de calcul physique doit avoir au moins une adresse IP affectée à partir du réseau logique de gestion.

Un serveur DHCP peut attribuer automatiquement des adresses IP pour le réseau de gestion, ou vous pouvez attribuer manuellement des adresses IP statiques. Lorsque DHCP est la méthode d’attribution IP préférée, nous vous recommandons d’utiliser des réservations DHCP sans expiration.

Le réseau de gestion prend en charge les configurations de réseau local virtuel suivantes :

Réseau local virtuel natif : vous n’êtes pas obligé de fournir des ID de réseau local virtuel. Cela est nécessaire pour les installations basées sur la solution.

VLAN étiqueté : vous fournissez des ID de réseau local virtuel au moment du déploiement.

Le réseau de gestion prend en charge tout le trafic utilisé pour la gestion du cluster, notamment le Bureau à distance, Windows Admin Center et Active Directory.

Pour plus d’informations, consultez Planifier une infrastructure SDN : Gestion et fournisseur HNV.

Réseaux locaux virtuels de calcul

Dans certains scénarios, vous n’avez pas besoin d’utiliser des Réseau virtuel SDN avec l’encapsulation VXLAN (Virtual Extensible LAN). Au lieu de cela, vous pouvez utiliser des réseaux locaux virtuels traditionnels pour isoler vos charges de travail de locataire. Ces réseaux locaux virtuels sont configurés sur le port du commutateur TOR en mode jonction. Lors de la connexion de nouvelles machines virtuelles à ces réseaux locaux virtuels, la balise VLAN correspondante est définie sur la carte réseau virtuelle.

Réseau d’adresse du fournisseur HNV (PA)

Le réseau d’adresses du fournisseur HNV (Hyper-V Network Virtualization) sert de réseau physique sous-jacent pour le trafic client Est/Ouest (interne interne), le trafic du locataire Nord/Sud (interne externe) et pour échanger des informations de peering BGP avec le réseau physique. Ce réseau n’est nécessaire que lorsqu’il est nécessaire de déployer des réseaux virtuels à l’aide de l’encapsulation VXLAN pour une autre couche d’isolation et pour la multilocataire réseau.

Pour plus d’informations, consultez Planifier une infrastructure SDN : Gestion et fournisseur HNV.

Options d’isolement réseau

Les options d’isolation réseau suivantes sont prises en charge :

Réseaux locaux virtuels (IEEE 802.1Q)

Les réseaux locaux virtuels permettent aux appareils qui doivent être conservés séparément pour partager le câblage d’un réseau physique et pourtant être empêchés d’interagir directement entre eux. Ce partage managé génère des gains de simplicité, de sécurité, de gestion du trafic et d’économie. Par exemple, un réseau local virtuel peut être utilisé pour séparer le trafic au sein d’une entreprise en fonction d’utilisateurs individuels ou de groupes d’utilisateurs ou de leurs rôles, ou en fonction des caractéristiques du trafic. De nombreux services d’hébergement Internet utilisent des réseaux locaux virtuels pour séparer les zones privées les unes des autres, ce qui permet aux serveurs de chaque client d’être regroupés dans un seul segment réseau, quel que soit l’emplacement des serveurs individuels dans le centre de données. Certaines précautions sont nécessaires pour empêcher le trafic « s’échapper » d’un réseau local virtuel donné, un exploit appelé tronçon de réseau local virtuel.

Pour plus d’informations, consultez Comprendre l’utilisation des réseaux virtuels et des réseaux locaux virtuels.

Stratégies d’accès réseau et microsegmentation par défaut

Les stratégies d’accès réseau par défaut garantissent que toutes les machines virtuelles de votre cluster Azure Stack HCI sont sécurisées par défaut contre les menaces externes. Avec ces stratégies, nous allons bloquer l’accès entrant à une machine virtuelle par défaut, tout en offrant la possibilité d’activer des ports entrants sélectifs et de sécuriser ainsi les machines virtuelles contre les attaques externes. Cette application est disponible via des outils de gestion tels que Windows Admin Center.

La microsegmentation implique la création de stratégies réseau granulaires entre les applications et les services. Cela réduit essentiellement le périmètre de sécurité à une clôture autour de chaque application ou machine virtuelle. Cette clôture permet uniquement la communication nécessaire entre les niveaux d’application ou d’autres limites logiques, ce qui rend extrêmement difficile pour les cyberthreats de se propager ultérieurement d’un système à un autre. La microsegmentation isole en toute sécurité les réseaux les uns des autres et réduit la surface d’attaque totale d’un incident de sécurité réseau.

Les stratégies d’accès réseau et les microsegmentations par défaut sont réalisées en tant que règles de pare-feu avec état à cinq tuples (préfixe d’adresse source, port source, préfixe d’adresse de destination, port de destination et protocole) sur les clusters Azure Stack HCI. Les règles de pare-feu sont également appelées groupes de sécurité réseau (NSG). Ces stratégies sont appliquées au port vSwitch de chaque machine virtuelle. Les stratégies sont envoyées via la couche de gestion et le contrôleur de réseau SDN les distribue à tous les hôtes applicables. Ces stratégies sont disponibles pour les machines virtuelles sur des réseaux locaux virtuels traditionnels et sur des réseaux de superposition SDN.

Pour plus d’informations, consultez Qu’est-ce que le Pare-feu du centre de données ?.

QoS pour les cartes réseau de machine virtuelle

Vous pouvez configurer la qualité de service (QoS) d’une carte réseau de machine virtuelle pour limiter la bande passante sur une interface virtuelle afin d’empêcher qu’une machine virtuelle à trafic élevé ne soit en concurrence avec d’autres trafics réseau de machines virtuelles. Vous pouvez également configurer QoS pour réserver une quantité spécifique de bande passante pour une machine virtuelle afin de vous assurer que la machine virtuelle peut envoyer du trafic indépendamment d’un autre trafic sur le réseau. Cela peut être appliqué aux machines virtuelles attachées à des réseaux locaux virtuels traditionnels, ainsi qu’aux machines virtuelles attachées à des réseaux de superposition SDN.

Pour plus d’informations, consultez Configurer QoS pour une carte réseau de machine virtuelle.

Réseaux virtuels

La virtualisation du réseau fournit des réseaux virtuels à des machines virtuelles similaires à la façon dont la virtualisation de serveur (hyperviseur) fournit des machines virtuelles au système d’exploitation. La virtualisation du réseau dissocie les réseaux virtuels de l’infrastructure réseau physique et supprime les contraintes de l’attribution d’adresses IP virtuelles et de VLAN et hiérarchique de l’approvisionnement de machines virtuelles. Cette flexibilité vous permet de passer facilement aux clouds IaaS (Infrastructure-as-a-Service) et est efficace pour les hôtes et les administrateurs de centre de données de gérer leur infrastructure, et de gérer l’isolation multilocataire, les exigences de sécurité et les adresses IP des machines virtuelles qui se chevauchent.

Pour plus d’informations, consultez Virtualisation de réseau Hyper-V.

Options des services de mise en réseau L3

Les options de service réseau L3 suivantes sont disponibles :

Peering de réseau virtuel

Le peering de réseaux virtuels vous permet de connecter deux réseaux virtuels de manière transparente. Une fois le peering établi, à des fins de connectivité, les réseaux virtuels apparaissent sous la forme d’un seul réseau. Voici quelques-uns des avantages du peering de réseaux virtuels :

- Le trafic entre les machines virtuelles des réseaux virtuels appairés est routé via l’infrastructure principale via des adresses IP privées uniquement. La communication entre les réseaux virtuels ne nécessite pas d’Internet public ou de passerelles.

- Connexion à latence faible et haut débit entre les ressources de différents réseaux virtuels.

- Possibilité pour les ressources d’un réseau virtuel de communiquer avec celles d’un autre réseau virtuel.

- Aucun temps d’arrêt pour les ressources des réseaux virtuels au moment de la création du peering.

Pour en savoir plus, consultez Peering de réseaux virtuels.

Équilibreur de charge logiciel SDN

Les fournisseurs de services cloud (CSP) et les entreprises qui déploient un SDN (Software Defined Networking) peuvent utiliser Software Load Balancer (SLB) pour distribuer uniformément le trafic réseau client entre les ressources de réseau virtuel. L’équilibrage de charge logicielle (SLB) permet à plusieurs serveurs d’héberger une même charge de travail, ce qui assure une disponibilité et une scalabilité de haut niveau. Il est également utilisé pour fournir des services NAT (Network Address Translation) entrants pour l’accès entrant aux machines virtuelles et les services NAT sortants pour la connectivité sortante.

À l’aide de SLB, vous pouvez effectuer un scale-out de vos fonctionnalités d’équilibrage de charge à l’aide de machines virtuelles SLB sur les mêmes serveurs de calcul Hyper-V que ceux que vous utilisez pour vos autres charges de travail de machine virtuelle. SLB prend en charge la création et la suppression rapides des points de terminaison d’équilibrage de charge selon les besoins des opérations CSP. En outre, SLB prend en charge des dizaines de gigaoctets par cluster, fournit un modèle d’approvisionnement simple, et est facile à effectuer un scale-out et à un scale-in. SLB utilise le Border Gateway Protocol pour publier des adresses IP virtuelles sur le réseau physique.

Pour plus d’informations, consultez Qu’est-ce que SLB pour SDN ?

Passerelles VPN SDN

La passerelle SDN est un routeur compatible BGP (Software-based Border Gateway Protocol) conçu pour les fournisseurs de services cloud et les entreprises qui hébergent des réseaux virtuels mutualisés à l’aide de la virtualisation de réseau Hyper-V (HNV). Vous pouvez utiliser la passerelle RAS pour router le trafic réseau entre un réseau virtuel et un autre réseau, qu’il soit local ou distant.

La passerelle SDN peut être utilisée pour :

créer des connexions IPsec de site à site sécurisées entre des réseaux virtuels SDN et des réseaux clients externes sur Internet.

créer des connexions de l’encapsulation de routage générique (GRE) entre les réseaux virtuels SDN et les réseaux externes. La différence entre les connexions site à site et les connexions GRE est que cette dernière n’est pas une connexion chiffrée.

Pour plus d’informations sur les scénarios de connectivité GRE, consultez Tunneling GRE dans Windows Server.

Créez des connexions de couche 3 (L3) entre les réseaux virtuels SDN et les réseaux externes. Dans ce cas, la passerelle SDN agit simplement comme un routeur entre votre réseau virtuel et le réseau externe.

La passerelle SDN nécessite le contrôleur de réseau SDN. Le contrôleur de réseau effectue le déploiement de pools de passerelles, configure les connexions de locataire sur chaque passerelle et bascule les flux de trafic réseau vers une passerelle de secours en cas d’échec d’une passerelle.

Les passerelles utilisent Border Gateway Protocol pour publier des points de terminaison GRE et établir des connexions point à point. Le déploiement SDN crée un pool de passerelles par défaut qui prend en charge tous les types de connexion. Dans ce pool, vous pouvez spécifier le nombre de passerelles réservées en mode veille en cas d’échec d’une passerelle active.

Pour plus d’informations, consultez Qu’est-ce que la passerelle RAS pour SDN ?

Étapes suivantes

En savoir plus sur le modèle réseau sans commutateur de stockage à deux nœuds, deux commutateurs