Évaluation des applications d’IA générative

Important

Les éléments marqués (préversion) dans cet article sont actuellement en préversion publique. Cette préversion est fournie sans contrat de niveau de service, nous la déconseillons dans des charges de travail de production. Certaines fonctionnalités peuvent être limitées ou non prises en charge. Pour plus d’informations, consultez Conditions d’Utilisation Supplémentaires relatives aux Évaluations Microsoft Azure.

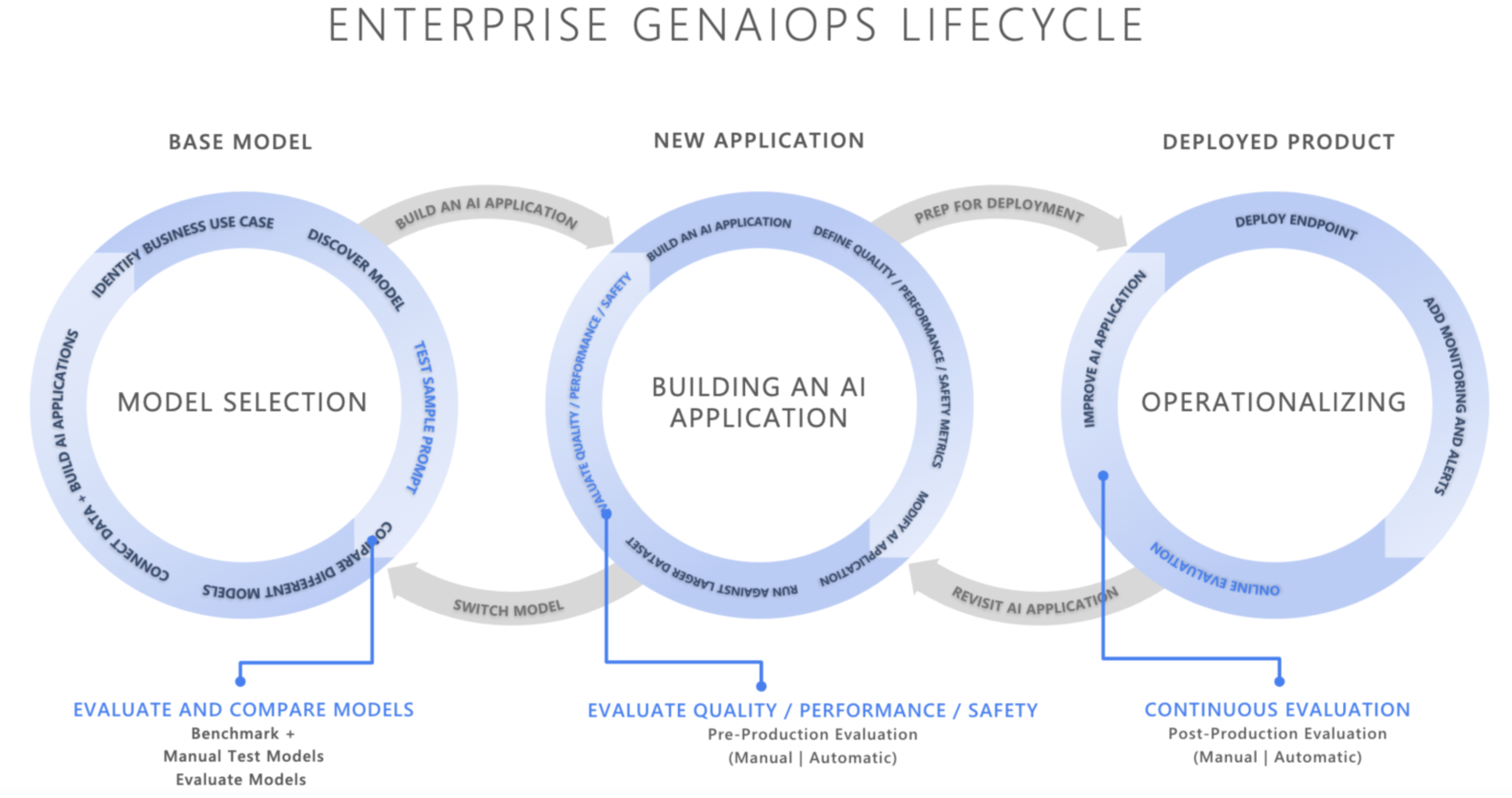

Dans le paysage en évolution rapide de l’intelligence artificielle, l’intégration d’opérations d’IA générative (GenAIOps) transforme la façon dont les organisations développent et déploient des applications d’IA. Étant donné que les entreprises s’appuient de plus en plus sur l’IA pour améliorer leur prise de décision et l’expérience client et stimuler l’innovation, l’importance d’un cadre d’évaluation solide est indéniable. L’évaluation est un composant essentiel du cycle de vie de l’IA générative pour renforcer la confiance dans les applications centrées sur l’IA. Si elles ne sont pas conçues avec soin, ces applications peuvent produire des sorties fabriquées et non fondées sur le contexte, non pertinentes ou incohérentes, entraînant une mauvaise expérience client, ou pire, perpétuant des stéréotypes sociétaux, promouvant la désinformation, exposant les organisations à des attaques malveillantes, ou un large éventail d’autres impacts négatifs.

Les programmes d’évaluation sont des outils utiles pour évaluer la fréquence et la gravité des risques liés au contenu ou des comportements indésirables dans les réponses de l’IA. L’exécution d’évaluations itératives et systématiques avec les programmes d’évaluation appropriés peut aider les équipes à mesurer et à résoudre les problèmes potentiels de qualité ou de sécurité tout au long du cycle de vie du développement de l’IA, à partir de la sélection initiale du modèle par le biais d’une surveillance post-production. Évaluation dans la production du cycle de vie GenAI Ops.

En comprenant et en implémentant des stratégies d’évaluation efficaces à chaque phase, les organisations peuvent s’assurer que leurs solutions d’IA répondent non seulement aux attentes initiales, mais aussi qu’elles s’adaptent et prospèrent dans des environnements réels. Examinons comment l’évaluation s’inscrit dans les trois phases critiques du cycle de vie de l’IA.

Sélection du modèle de base

La première phase du cycle de vie de l’IA implique la sélection d’un modèle de base approprié. Les modèles d’IA générative varient largement en termes de fonctionnalités, de forces et de limitations. Il est donc essentiel d’identifier le modèle le mieux adapté à votre cas d’utilisation spécifique. Lors de l’évaluation du modèle de base, vous allez « parcourir » différents modèles pour les comparer en testant leurs sorties en fonction d’un ensemble de critères pertinents pour votre application.

Les éléments clés à prendre en compte à cette phase sont notamment les suivants :

- Exactitude/qualité : Comment le modèle génère-t-il des réponses pertinentes et cohérentes ?

- Performances sur des tâches spécifiques : le modèle peut-il gérer le type d’invites et de contenu requis pour votre cas d’utilisation ? Quels sont sa latence et son coût ?

- Biais et considérations éthiques : le modèle produit-il des sorties susceptibles de perpétuer ou de promouvoir des stéréotypes nuisibles ?

- Risque et sécurité : existe-t-il des risques pour le modèle qui génère du contenu non sécurisé ou malveillant ?

Vous pouvez explorer les benchmarks Azure AI Foundry pour évaluer et comparer des modèles sur des jeux de données disponibles publiquement, tout en régénérant également les résultats des benchmarks sur vos propres données. Vous pouvez également évaluer l’un des nombreux modèles d’IA générative de base via le Kit de développement logiciel (SDK) d’évaluation d’Azure AI comme démontré. Consultez Évaluer l’échantillon de points de terminaison du modèle pour plus d’informations.

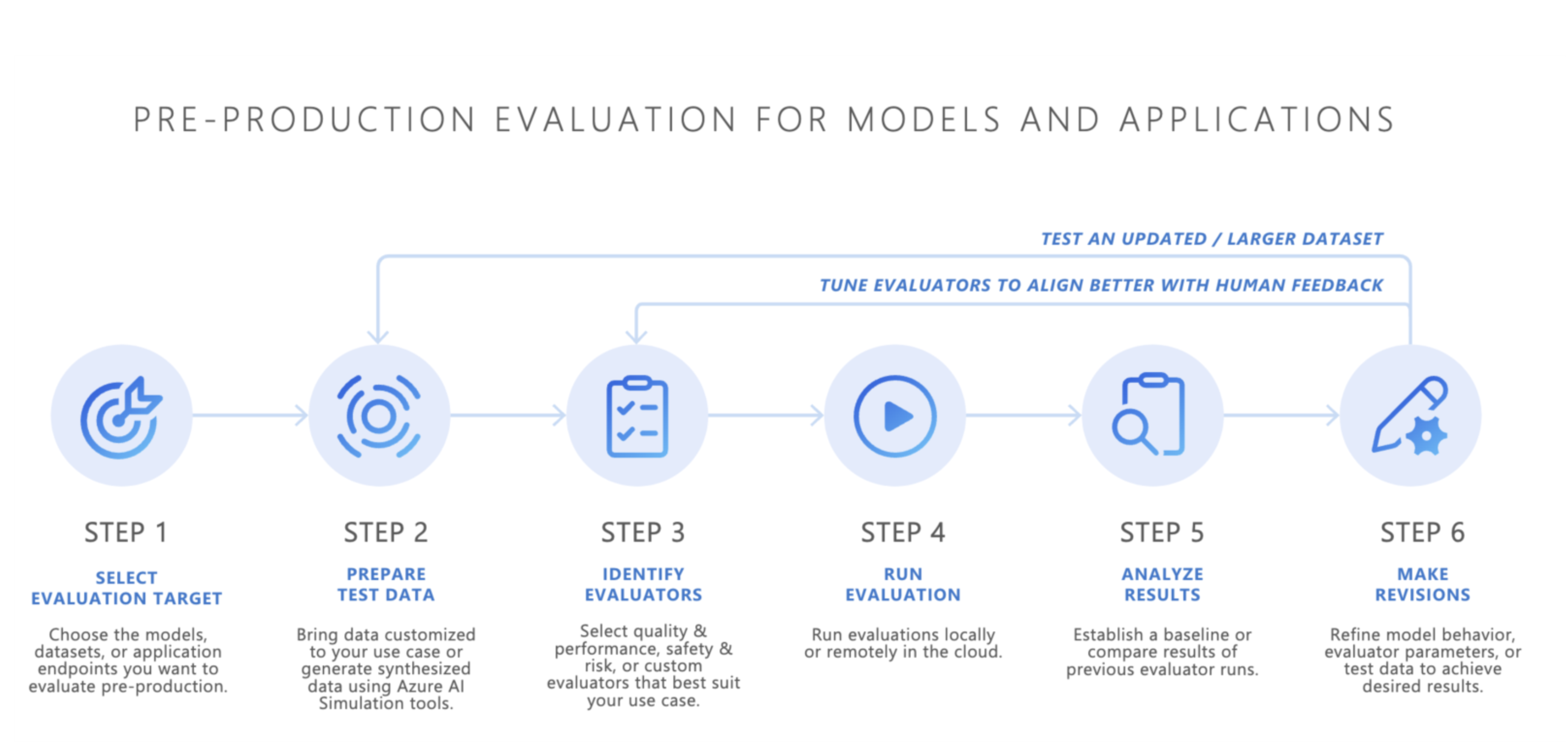

Évaluation de préproduction

Après avoir sélectionné un modèle de base, l’étape suivante consiste à développer une application IA, telle qu’un chatbot alimenté par l’IA, une application de génération augmentée de récupération (RAG), une application d’IA agentique ou tout autre outil d’IA générative. Après le développement, l’évaluation de préproduction commence. Avant de déployer l’application dans un environnement de production, des tests rigoureux sont essentiels pour garantir que le modèle est vraiment prêt pour une utilisation concrète.

L’évaluation en préproduction implique les éléments suivants :

- Test avec des jeux de données d’évaluation : ces jeux de données simulent des interactions utilisateur réalistes pour garantir que l’application d’IA s’exécute comme prévu.

- Identification des cas de périphérie : recherche de scénarios où la qualité de réponse de l’application d’IA peut dégrader ou produire des sorties indésirables.

- Évaluation de la robustesse : s’assurer que le modèle peut gérer une plage de variations d’entrées sans baisse significative de la qualité ou de la sécurité.

- Mesure des métriques clés : les métriques telles que le fondement, la pertinence et la sécurité de la réponse sont évaluées pour confirmer l’aptitude à la production.

La phase de préproduction agit comme un contrôle qualité final, ce qui réduit le risque de déploiement d’une application d’IA qui ne répond pas aux normes de performances ou de sécurité souhaitées.

- Apportez vos propres données : vous pouvez évaluer vos applications d’IA en préproduction à l’aide de vos propres données d’évaluation avec les programmes d’évaluation pris en charge par Azure AI Foundry ou le Kit de développement logiciel (SDK) d’évaluation Azure AI, notamment la qualité de génération, la sécurité ou les programmes d’évaluation personnalisés, et afficher les résultats via le portail Azure AI Foundry.

- Simulateurs : si vous n’avez pas de données d’évaluation (données de test), les simulateurs du Kit de développement logiciel (SDK) d’évaluation Azure AI peuvent vous aider en générant des requêtes adversaires ou liées à des rubriques. Ces simulateurs testent la réponse du modèle à des requêtes appropriées à la situation ou similaires à des attaques (cas de périphérie).

- Le simulateur adversaire injecte des requêtes qui imitent les menaces de sécurité potentielles ou tentent de jailbreaker, ce qui permet d’identifier les limitations et de préparer le modèle pour des conditions inattendues.

- Les simulateurs appropriés au contexte génèrent des conversations classiques et pertinentes auxquelles vous vous attendriez de la part des utilisateurs afin de tester la qualité des réponses.

Vous pouvez également utiliser le widget d’évaluation d’Azure AI Foundry pour tester vos applications d’IA générative.

Une fois que les résultats sont satisfaisants, l’application d’IA peut être déployée en production.

Surveillance post-production

Après le déploiement, l’application d’IA entre dans la phase d’évaluation post-production, également appelée évaluation en ligne ou surveillance. Lors de cette phase, le modèle est intégré dans un produit réel et répond aux demandes des utilisateurs. La supervision garantit que le modèle continue de se comporter comme prévu et s’adapte aux modifications apportées au comportement ou au contenu de l’utilisateur.

- Suivi continu des performances : mesure régulièrement la réponse de l’application d’IA à l’aide de métriques clés pour garantir une qualité de sortie cohérente.

- Réponse aux incidents : réponse rapide aux sorties dangereuses, discriminatoires ou inappropriées qui peuvent survenir pendant l’utilisation réelle.

En surveillant en continu le comportement de l’application d’IA en production, vous pouvez maintenir des expériences utilisateur de haute qualité et résoudre rapidement les problèmes qui se posent.

Conclusion

GenAIOps permet d’établir un processus fiable et reproductible pour gérer les applications d’IA générative tout au long de leur cycle de vie. L’évaluation joue un rôle essentiel à chaque phase, de la sélection du modèle de base, par le biais de tests de préproduction, à la surveillance post-production continue. En mesurant et en ciblant systématiquement les risques et en affinant les systèmes d’IA à chaque étape, les équipes peuvent créer des solutions d’IA générative qui ne sont pas seulement puissantes, mais aussi fiables et sécurisées pour une utilisation réelle.

Aide-mémoire :

| Objectif | Process | Paramètres |

|---|---|---|

| Que cherchez-vous à évaluer ? | Identifier ou créer des programmes d’évaluation pertinents | - Qualité et performances (Exemple de notebook de qualité et performances) - Sécurité (Exemple de notebook de sécurité) - Personnalisé (Exemple de notebook personnalisé) |

| Quelles données devez-vous utiliser ? | Charger ou générer un jeu de données pertinent | Simulateur générique pour mesurer la qualité et les performances (Exemple de notebook de simulateur générique) - Simulateur adversaire pour mesurer la sécurité (Exemple de notebook de simulateur adversaire) |

| Quelles sont les ressources qui devraient mener l’évaluation ? | Exécuter l’évaluation | – Exécution locale – Exécution à distance du cloud |

| Quelles ont été les performances de mon modèle/application ? | Analyse des résultats | Afficher les scores agrégés, afficher les détails, les détails du score, comparer les exécutions d’évaluation |

| Quelles sont les améliorations à apporter ? | Apporter des modifications aux modèles, aux applications ou aux programmes d’évaluation | – Si les résultats de l’évaluation ne se sont pas alignés sur les commentaires humains, ajustez votre programme d’évaluation. – Si les résultats de l’évaluation sont alignés sur les commentaires humains, mais ne respectaient pas les seuils de qualité/sécurité, appliquez des atténuations ciblées. |

Contenu connexe

- Évaluer vos applications IA générative via le terrain de jeu

- Évaluer vos applications d’IA générative avec le Kit de développement logiciel (SDK) ou le portail Azure AI Foundry

- Métriques d’évaluation et de surveillance pour l’IA générative

- Note de transparence pour les évaluations de sécurité d’Azure AI Foundry