Mesures d’évaluation

Votre jeu de données est divisé en deux parties : un jeu pour l’entraînement et un jeu pour le test. Le jeu d’entraînement est utilisé pour entraîner le modèle, tandis que le jeu de tests est utilisé comme test pour le modèle après l’entraînement pour calculer les performances et l’évaluation du modèle. Le jeu de tests n’est pas introduit dans le modèle par le biais du processus de formation pour s’assurer que le modèle est testé sur de nouvelles données.

L’évaluation du modèle est déclenchée automatiquement une fois l’entraînement effectué. Le processus d’évaluation commence par l’utilisation du modèle entraîné pour prédire les classes définies par l’utilisateur pour les documents du jeu de test. Il les compare aux étiquettes de données fournies (ce qui établit une base de référence de confiance). Les résultats sont retournés pour pouvoir examiner les performances du modèle. Pour l’évaluation, la classification de texte personnalisée utilise les métriques suivantes :

Précision : mesure la précision/justesse de votre modèle. Il s’agit du rapport entre les positifs correctement identifiés (vrais positifs) et tous les positifs identifiés. La métrique de précision révèle le nombre de classes prédites qui sont correctement étiquetées.

Precision = #True_Positive / (#True_Positive + #False_Positive)Rappel : mesure la capacité du modèle à prédire les classes positives réelles. Il s’agit du rapport entre les vrais positifs prédits et ce qui a été réellement étiqueté. La métrique de rappel révèle le nombre de classes prédites correctes.

Recall = #True_Positive / (#True_Positive + #False_Negatives)Score F1 : le score F1 est une fonction de précision et de rappel. Il est nécessaire quand vous recherchez l’équilibre entre précision et rappel.

F1 Score = 2 * Precision * Recall / (Precision + Recall)

Notes

La précision, le rappel et le score F1 sont calculés séparément pour chaque classe (évaluation au niveau de la classe) et collectivement pour le modèle (évaluation au niveau du modèle).

Métriques d’évaluation au niveau du modèle et au niveau de la classe

Les définitions de la précision, du rappel et de l’évaluation sont les mêmes pour les évaluations au niveau de la classe et au niveau du modèle. Toutefois, le nombre de vrais positifs, de faux positifset de faux négatifs diffère, comme indiqué dans l’exemple suivant.

Les sections ci-dessous utilisent l’exemple de jeu de données suivant :

| Document | Classes réelles | Classes prédites |

|---|---|---|

| 1 | action, comedy | comedy |

| 2 | action | action |

| 3 | romance | romance |

| 4 | romance, comedy | romance |

| 5 | comedy | action |

Évaluation au niveau de la classe pour la classe action

| Clé | Count | Explication |

|---|---|---|

| Vrai positif | 1 | Le document 2 a été correctement classé dans action. |

| Faux positif | 1 | Le document 5 a été classé par erreur dans action. |

| Faux négatif | 1 | Le document 1 n’a pas été classé dans action, mais aurait dû l’être. |

Précision = #True_Positive / (#True_Positive + #False_Positive) = 1 / (1 + 1) = 0.5

Rappel = #True_Positive / (#True_Positive + #False_Negatives) = 1 / (1 + 1) = 0.5

Score F1 = 2 * Precision * Recall / (Precision + Recall) = (2 * 0.5 * 0.5) / (0.5 + 0.5) = 0.5

Évaluation au niveau de la classe pour la classe comedy

| Clé | Count | Explication |

|---|---|---|

| Vrai positif | 1 | Le document 1 a été correctement classé dans comedy. |

| Faux positif | 0 | Aucun document n’a été classé par erreur dans comedy. |

| Faux négatif | 2 | Les documents 5 et 4 n’ont pas été classés dans comedy, mais ils auraient dû l’être. |

Précision = #True_Positive / (#True_Positive + #False_Positive) = 1 / (1 + 0) = 1

Rappel = #True_Positive / (#True_Positive + #False_Negatives) = 1 / (1 + 2) = 0.33

Score F1 = 2 * Precision * Recall / (Precision + Recall) = (2 * 1 * 0.67) / (1 + 0.67) = 0.80

Évaluation au niveau du modèle pour le modèle collectif

| Clé | Count | Explication |

|---|---|---|

| Vrai positif | 4 | La prédiction pour les documents 1, 2, 3 et 4 a donné des classes correctes. |

| Faux positif | 1 | La prédiction pour le document 5 a donné une classe incorrecte. |

| Faux négatif | 2 | La prédiction pour les documents 1 et 4 n’a pas donné toutes les classes correctes. |

Précision = #True_Positive / (#True_Positive + #False_Positive) = 4 / (4 + 1) = 0.8

Rappel = #True_Positive / (#True_Positive + #False_Negatives) = 4 / (4 + 2) = 0.67

Score F1 = 2 * Precision * Recall / (Precision + Recall) = (2 * 0.8 * 0.67) / (0.8 + 0.67) = 0.73

Notes

Pour les modèles de classification à une seule étiquette, le nombre de faux négatifs et de faux positifs est toujours égal. Les modèles de classification à une seule étiquette personnalisée prédisent toujours une classe pour chaque document. Si la prédiction n’est pas correcte, le nombre de faux positifs de la classe prédite augmente de 1 et celui des faux négatifs de la classe réelle augmente de 1, le nombre total de faux positifs et de faux négatifs pour le modèle est toujours égal. Ce n’est pas le cas de la classification multi-étiquette, car l’échec de la prédiction de l’une des classes d’un document est considéré comme un faux négatif.

Interprétation des métriques d’évaluation au niveau de la classe

Que signifie réellement avoir une précision élevée ou un rappel élevé pour une classe donnée ?

| Rappel | Precision | Interprétation |

|---|---|---|

| Élevé | Élevé | Cette classe est parfaitement gérée par le modèle. |

| Faible | Élevé | Le modèle ne peut pas toujours prédire cette classe, mais quand il le fait, le niveau de confiance est élevé. Cette classe est peut-être sous-représentée dans le jeu de données : essayez d’équilibrer la répartition de vos données. |

| Élevé | Faible | Le modèle prédit cette classe correctement, mais son niveau de confiance est faible. Cette classe est peut-être sur-représentée dans le jeu de données : essayez d’équilibrer la répartition de vos données. |

| Faible | Faible | Cette classe est mal gérée par le modèle où elle n’est généralement pas prédite et, quand elle l’est, le niveau de confiance n’est pas élevé. |

Les modèles de classification de texte personnalisée sont censés avoir à la fois des faux négatifs et des faux positifs. Pensez à la façon dont ces faux négatifs et positifs affectent l’ensemble du système, et réfléchissez soigneusement aux scénarios dans lesquels le modèle ignore les prédictions correctes et reconnaît les prédictions incorrectes. Selon votre scénario, la précision ou le rappel peuvent être plus appropriés pour évaluer les performances de votre modèle.

Par exemple, si votre scénario implique le traitement de tickets de support technique, la prédiction de la mauvaise classe peut entraîner le transfert d’un ticket au mauvais service ou à la mauvaise équipe. Dans cet exemple, vous devez rendre votre système plus sensible aux faux positifs et valoriser la précision dans l’évaluation.

Autre exemple : si votre scénario implique de catégoriser les e-mails dans « important » ou « spam », une mauvaise prédiction peut vous faire manquer un e-mail utile s’il est étiqueté comme « spam ». Toutefois, si un e-mail de spam est étiqueté comme important, vous pouvez l’ignorer. Dans cet exemple, vous devez rendre votre système plus sensible aux faux négatifs et valoriser le rappel dans l’évaluation.

Si vous voulez optimiser votre modèle pour des scénarios d’usage général, ou quand la précision et le rappel sont tous deux importants, vous pouvez utiliser le score F1. Les scores d’évaluation dépendent de votre scénario et de vos critères d’acceptation. Il n’y a pas de métrique absolue qui fonctionne pour tous les scénarios.

Assistance

Après avoir formé votre modèle, vous verrez des conseils et des recommandations sur la façon d’améliorer le modèle. Il est recommandé d’avoir un modèle couvrant tous les points de la section conseils.

Le jeu d’entraînement contient suffisamment de données : lorsqu’un type de classe a moins de 15 instances étiquetées dans les données d’apprentissage, il peut entraîner une précision inférieure en raison du fait que le modèle n’est pas correctement formé sur ces cas.

Tous les types de classe sont présents dans le jeu de tests : lorsque les données de test manquent d’instances étiquetées pour un type de classe, les performances de test du modèle peuvent devenir moins complètes en raison de scénarios non testés.

Les types de classe sont équilibrés dans les jeux d’apprentissage et de test : lorsque le biais d’échantillonnage provoque une représentation inexacte de la fréquence d’un type de classe, il peut entraîner une précision inférieure en raison du modèle qui s’attend à ce que ce type de classe se produise trop souvent ou trop peu.

Les types de classe sont distribués uniformément entre les jeux d’apprentissage et de test : lorsque le mélange de types de classe ne correspond pas entre les jeux d’entraînement et de test, il peut entraîner une précision de test inférieure en raison de l’apprentissage du modèle différemment de la façon dont il est testé.

Les types de classe dans le jeu d’entraînement sont clairement distincts : lorsque les données d’apprentissage sont similaires pour plusieurs types de classe, cela peut entraîner une précision inférieure, car les types de classe peuvent être fréquemment mal classés les uns comme les autres.

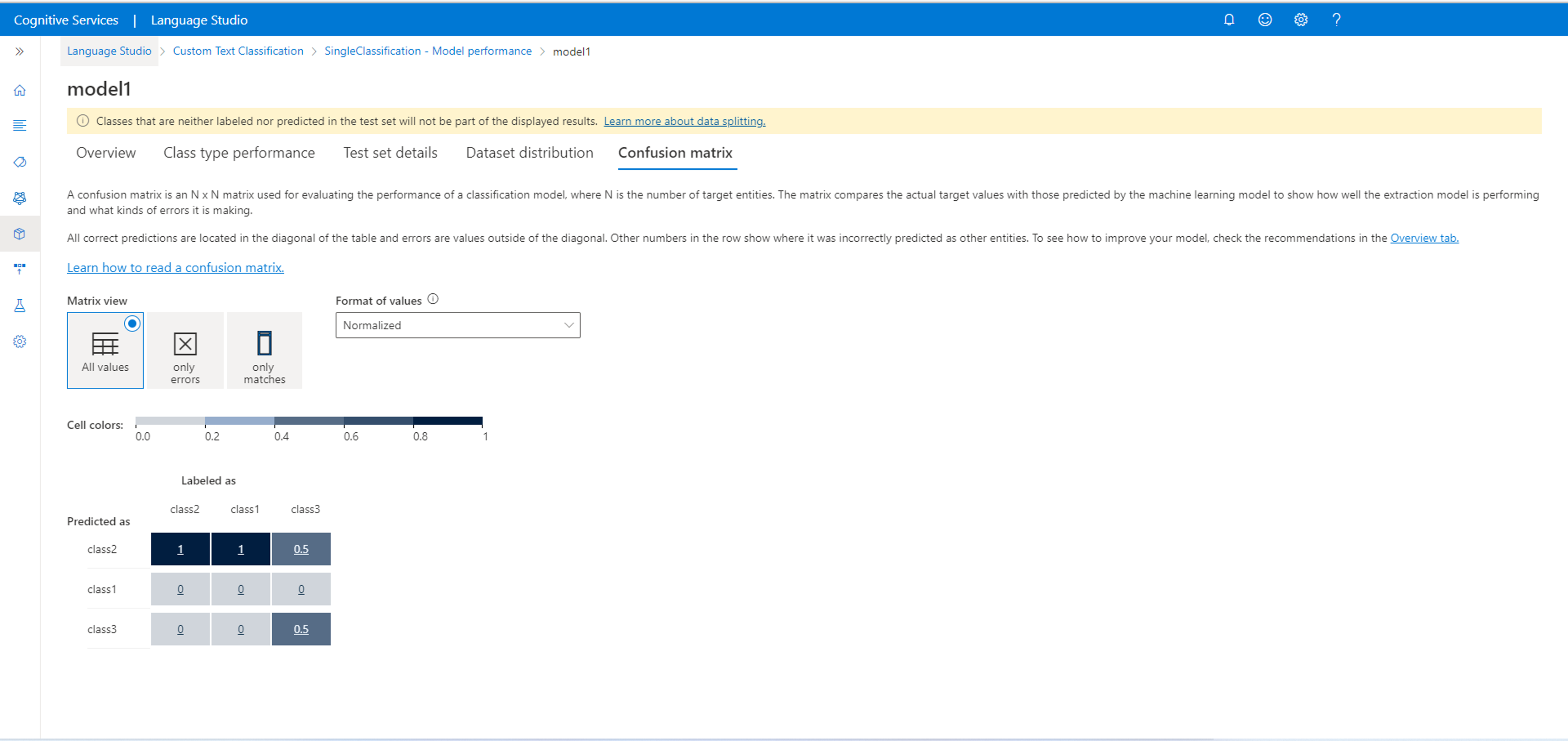

Matrice de confusion

Important

La matrice de confusion n’est pas disponible pour les projets de classification multi-étiquette. Une matrice de confusion est une matrice N x N utilisée pour l’évaluation des performances du modèle, où N est le nombre de classes. La matrice compare les étiquettes attendues aux étiquettes prédites par le modèle. Cela donne une vue holistique du niveau de performance du modèle et des genres d’erreur qu’il commet.

Vous pouvez utiliser la matrice de confusion pour identifier les classes trop proches les unes des autres et qui sont souvent mal interprétées (ambiguïté). Dans ce cas, songez à fusionner ces classes. Si ce n’est pas possible, envisagez d’étiqueter davantage de documents avec les deux classes pour permettre au modèle de les différencier.

Toutes les prédictions correctes se trouvent dans la diagonale de la table. Il est donc aisé d’inspecter visuellement la table pour détecter les erreurs de prédiction, car elles seront représentées par des valeurs en dehors de la diagonale.

Vous pouvez calculer les métriques d’évaluation au niveau de la classe et au niveau du modèle à partir de la matrice de confusion :

- Les valeurs de la diagonale sont les valeurs correspondant aux vrais positifs de chaque classe.

- La somme des valeurs des lignes de classe (à l’exception de la diagonale) correspond au faux positif du modèle.

- La somme des valeurs dans les colonnes de classe (à l’exception de la diagonale) est le faux négatif du modèle.

De même,

- Le vrai positif du modèle correspond à la somme des vrais positifs de toutes les classes.

- Le faux positif du modèle correspond à la somme des faux positifs de toutes les classes.

- Le faux négatif du modèle correspond à la somme des faux négatifs de toutes les classes.