Extension du stockage sur Azure Stack Hub

Cet article fournit des informations sur l’infrastructure de stockage Azure Stack Hub, ce qui vous aidera à déterminer comment intégrer Azure Stack Hub dans votre environnement réseau existant. Après avoir décrit de manière générale l’extension de votre centre de données, l’article présente deux scénarios différents. Vous pouvez vous connecter à un serveur de stockage de fichiers Windows. Vous pouvez également vous connecter à un serveur ISCSI Windows.

Présentation de l’extension du stockage sur Azure Stack Hub

Il existe des scénarios dans lesquels le fait de placer vos données dans le cloud public ne suffit pas. Imaginons que vous ayez une charge de travail de base de données virtualisée qui nécessite beaucoup de ressources système et qui soit sensible aux latences. Supposons que le temps d’aller-retour vers le cloud public affecte les performances de la charge de travail de base de données. Peut-être que des données locales, stockées sur un serveur de fichiers, un NAS ou une baie de stockage iSCSI, doivent être accessibles aux charges de travail locales et résider localement pour répondre aux objectifs de réglementation ou de conformité. Il s’agit simplement de deux des scénarios dans lesquels les données sont conservées localement, ce qui est important pour de nombreuses organisations.

Alors, pourquoi ne pas simplement héberger ces données dans des comptes de stockage sur Azure Stack Hub ou sur des serveurs de fichiers virtualisés s’exécutant sur le système Azure Stack Hub ? Contrairement à Azure, le stockage Azure Stack Hub est limité. La capacité dont vous disposez pour votre utilisation dépend entièrement de la capacité par nœud que vous avez choisi d’acheter, en plus du nombre de nœuds que vous avez. De plus, dans la mesure où Azure Stack Hub est une solution hyperconvergée, si vous souhaitez augmenter votre capacité de stockage pour répondre aux besoins d’utilisation, vous devez également augmenter l’empreinte de calcul en ajoutant des nœuds. Cela peut entraîner des coûts prohibitifs, en particulier si le besoin de capacité supplémentaire concerne le stockage d’archivage froid, qui peut être ajouté à faible coût en dehors du système Azure Stack Hub.

Ce qui vous amène au scénario que vous allez aborder ci-dessous. Comment connecter des systèmes Azure Stack Hub, des charges de travail virtualisées s’exécutant sur Azure Stack Hub, de manière simple et efficace, à des systèmes de stockage en dehors d’Azure Stack Hub, accessibles via le réseau.

Conception pour étendre le stockage

Le diagramme illustre un scénario, où une seule machine virtuelle, exécutant une charge de travail, se connecte et utilise le stockage externe (à la machine virtuelle et Azure Stack Hub lui-même), à des fins de lecture/écriture de données, etc. Pour cet article, vous allez vous concentrer sur la récupération simple des fichiers, mais vous pouvez développer cet exemple pour des scénarios plus complexes, tels que le stockage distant des fichiers de base de données.

Dans le schéma, vous voyez que la machine virtuelle sur le système Azure Stack Hub a été déployée avec plusieurs cartes réseau. En termes de redondance, mais également en tant que bonne pratique de stockage, il est important de disposer de plusieurs chemins entre la cible et la destination. Lorsque les choses deviennent plus complexes, les machines virtuelles Azure Stack Hub doivent avoir des adresses IP publiques et privées, comme dans Azure. Si le stockage externe doit atteindre la machine virtuelle, il peut le faire par le biais de l’adresse IP publique, car les adresses IP privées sont principalement utilisées dans les systèmes Azure Stack Hub, au sein de réseaux virtuels et de sous-réseaux. Le stockage externe ne serait pas en mesure de communiquer avec l’espace d’adressage IP privé de la machine virtuelle, sauf s’il passe à travers un réseau VPN de site à site pour entrer dans réseau virtuel lui-même. Ainsi, pour cet exemple, nous allons nous concentrer sur la communication via l’espace d’adressage IP public. Une chose à noter avec l’espace d’adressage IP public dans le schéma est qu’il existe 2 sous-réseaux de pool d’adresses IP publiques différents. Par défaut, Azure Stack Hub nécessite un seul pool pour les adresses IP publiques, mais il peut être nécessaire d’en ajouter un autre pour proposer un routage redondant. Il n’est cependant pas possible pour le moment de sélectionner une adresse IP à partir d’un pool spécifique : vous pouvez donc vous retrouver avec des machines virtuelles avec des adresses IP publiques du même pool sur plusieurs cartes réseau virtuelles.

Dans le cadre de cette présentation, nous allons supposer que le routage entre les appareils en périphérie et le stockage externe est pris en charge, et que le trafic peut traverser le réseau de manière appropriée. Pour cet exemple, peu importe si le segment principal est 1 GbE, 10 GbE, 25 GbE ou encore plus rapide ; il est cependant important de prendre en compte dans la planification de votre intégration les besoins en termes de performances de toutes les applications qui accèdent à ce stockage externe.

Se connecter à une cible iSCSI Windows Server

Dans ce scénario, vous allez déployer et configurer une machine virtuelle Windows Server 2019 sur Azure Stack Hub et la préparer pour la connexion à une cible iSCSI externe, qui exécute également Windows Server 2019. Là où c’est approprié, nous allons activer des fonctionnalités clés comme MPIO, afin d’optimiser les performances et la connectivité entre la machine virtuelle et le stockage externe.

Déployer la machine virtuelle Windows Server 2019 sur Azure Stack Hub

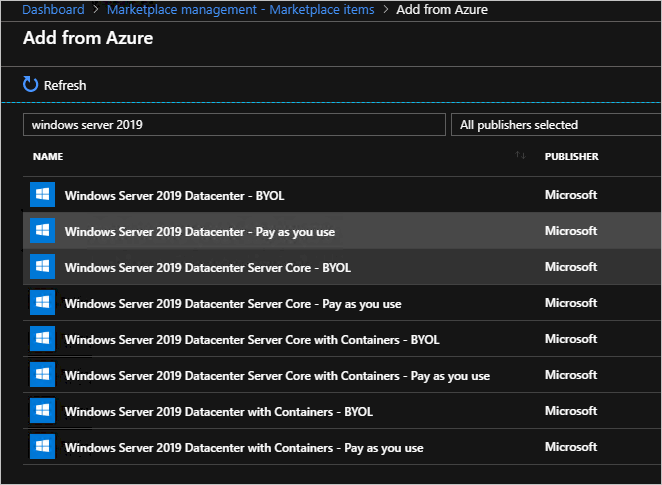

À partir de votre portail d’administration Azure Stack Hub, en supposant que ce système a été inscrit correctement et qu’il est connecté à la Place de marché, sélectionnez Gestion de la Place de marché puis, en supposant que vous n’avez pas encore d’image Windows Server 2019, sélectionnez Ajouter à partir d’Azure puis recherchez Windows Server 2019 et ajoutez l’image Windows Server 2019 Datacenter.

Le téléchargement d’une image Windows Server 2019 peut prendre un certain temps.

Une fois que vous disposez d’une image Windows Server 2019 dans votre environnement Azure Stack Hub, connectez-vous au portail utilisateur d’Azure Stack Hub.

Une fois que vous êtes connecté au portail utilisateur Azure Stack Hub, vérifiez que vous disposez d’un abonnement à une offre, ce qui vous permet de provisionner des ressources IaaS (calcul, stockage et réseau).

Une fois que vous disposez d’un abonnement, revenez dans le tableau de bord du portail utilisateur Azure Stack Hub, sélectionnez Créer une ressource, Calcul, puis l’élément de galerie Windows Server 2019 Datacenter.

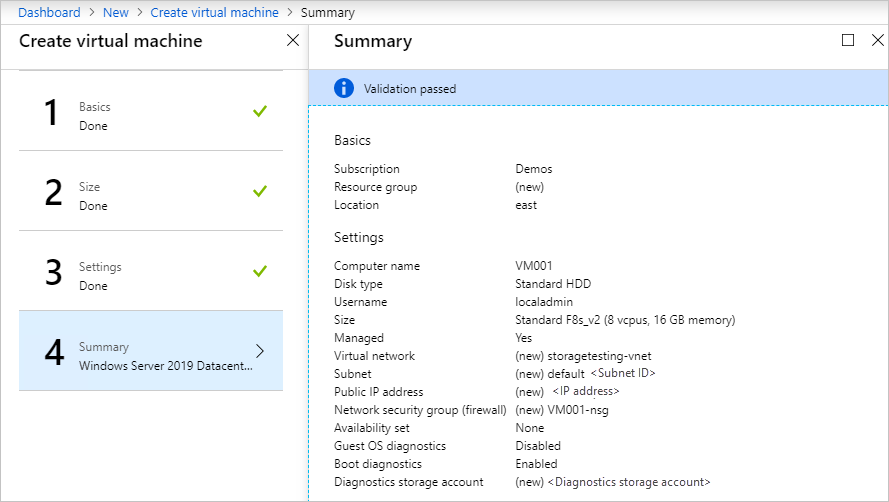

Dans le panneau De base, renseignez les informations comme suit :

a. Nom : VM001

b. Nom d’utilisateur : localadmin

c. Mot de passe et Confirmer le mot de passe : <mot de passe de votre choix>

d. Abonnement : <abonnement de votre choix, avec des ressources de calcul/stockage/réseau>.

e. Groupe de ressources : storagetesting (créer)

f. Sélectionnez OK.

Dans le panneau Choisir une taille, sélectionnez Standard_F8s_v2 puis Sélectionner.

Dans le panneau Paramètres, sélectionnez le réseau virtuel, puis dans le panneau Créer un réseau virtuel, ajustez l’espace d’adressage pour qu’il soit défini sur 10.10.10.0/23 et mettez à jour la plage d’adresses de sous-réseau pour qu’elle soit définie sur 10.10.10.0/24, puis sélectionnez OK.

Sélectionnez l’adresse IP publique puis, dans le panneau Créer une adresse IP publique, sélectionnez la case d’option Statique.

Dans la liste déroulante Sélectionner des ports entrants publics, sélectionnez RDP (3389).

Conservez les autres valeurs par défaut et sélectionnez Ok.

Lisez le résumé, attendez la validation, puis sélectionnez OK pour commencer le déploiement. Le déploiement doit se terminer en environ 10 minutes.

Une fois le déploiement terminé, sous Ressource, sélectionnez le nom de la machine virtuelle, VM001, pour accéder ouvrir Vue d’ensemble.

Sous Nom DNS, sélectionnez Configurer, spécifiez une étiquette de nom DNS, vm001, sélectionnez Enregistrer, puis sélectionnez VM001.

Sur le côté droit du panneau Présentation, sélectionnez storagetesting-vnet/default sous le texte de réseau virtuel/sous-réseau.

Dans le panneau storagetesting-vnet, sélectionnez Sous-réseaux puis + Sous-réseau puis, dans le nouveau panneau Ajouter un sous-réseau, entrez les informations suivantes et sélectionnez OK :

a. Nom : subnet2

b. Plage d’adresses (bloc CIDR) : 10.10.11.0/24

c. Groupe de sécurité réseau : Aucun

d. Table de routage : Aucun

Une fois que c’est enregistré, sélectionnez VM001.

Dans le volet gauche du panneau Vue d’ensemble, sélectionnez Réseau.

Sélectionnez Attacher une interface réseau, puis sélectionnez Créer une interface réseau.

Dans le panneau Créer l’interface réseau, entrez les informations suivantes.

a. Nom : vm001nic2

b. Sous-réseau : vérifiez que le sous-réseau est 10.10.11.0/24

c. Groupe de sécurité réseau : VM001-nsg

d. Groupe de ressources : storagetesting

Une fois l’interface attachée, sélectionnez VM001, puis Arrêter pour arrêter la machine virtuelle.

Une fois la machine virtuelle arrêtée (désallouée), sur le côté gauche du panneau Vue d’ensemble, sélectionnez Réseau, Attacher l’interface réseau, vm001nic2, puis OK. La carte réseau supplémentaire sera ajoutée à la machine virtuelle dans quelques instants.

Toujours dans le panneau Réseau, sélectionnez l’onglet vm001nic2, puis sélectionnez Interface réseau : vm001nic2.

Dans le panneau de l’interface vm001nic, sélectionnez Configurations IP, puis dans le centre du panneau, sélectionnez ipconfig1.

Dans le panneau Paramètres ipconfig1, sélectionnez Activé pour l’adresse IP publique et sélectionnez Configurer les paramètres requis, Créer, puis entrez vm001nic2pip comme nom, sélectionnez Statique et OK, puis Enregistrer.

Une fois l’enregistrement réussi, revenez au panneau Présentation de VM001, puis sélectionnez Démarrer pour démarrer la machine virtuelle Windows Server 2019 configurée.

Une fois la machine démarrée, établissez une session RDP dans VM001.

Une fois connecté à l’intérieur de la machine virtuelle, ouvrez CMD (en tant qu’administrateur) et entrez nom d’hôte pour récupérer le nom d’ordinateur du système d’exploitation. Il doit correspondre à VM001. Prenez en note pour plus tard.

Configurer une deuxième carte réseau sur la machine virtuelle Windows Server 2019 sur Azure Stack Hub

Par défaut, Azure Stack Hub affecte une passerelle par défaut à la première (principale) interface réseau attachée à la machine virtuelle. Azure Stack Hub n’affecte pas de passerelle par défaut aux interfaces réseau additionnelles (secondaires) attachées à une machine virtuelle. Par conséquent, vous ne pouvez pas communiquer avec les ressources hors du sous-réseau dans lequel se trouve, par défaut, une interface réseau secondaire. Toutefois, les interfaces réseau secondaires peuvent communiquer avec les ressources hors de leur sous-réseau. Ceci dit, les étapes à suivre pour permettre cette communication sont différentes d’un système d’exploitation à un autre.

Si vous n’avez pas encore de connexion ouverte, établissez une connexion RDP dans VM001.

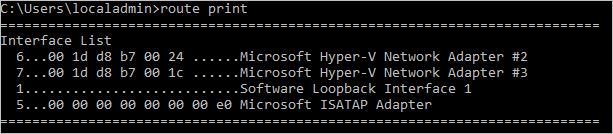

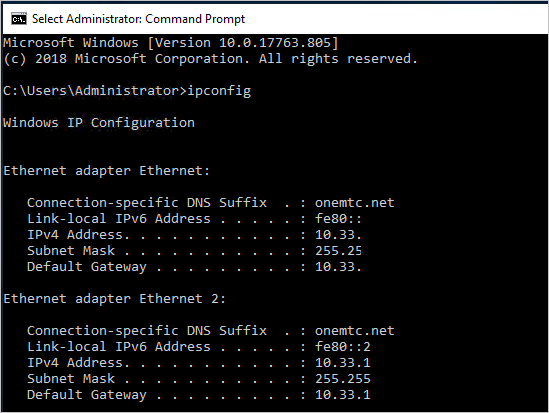

Ouvrez CMD en tant qu’administrateur et exécutez route print, qui doit retourner les deux interfaces (cartes réseau Hyper-V) à l’intérieur de cette machine virtuelle.

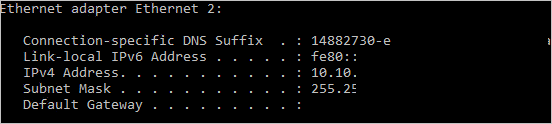

Exécutez maintenant ipconfig pour voir quelle adresse IP est affectée à l’interface réseau secondaire. Dans cet exemple, l’adresse 10.10.11.4 est affectée à l’interface 6. Aucune adresse de passerelle par défaut n’est retournée pour l’interface réseau secondaire.

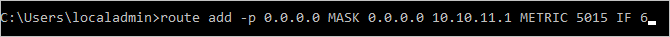

Pour router le trafic destiné aux adresses en dehors du sous-réseau de l’interface réseau secondaire vers la passerelle du sous-réseau, exécutez la commande suivante à partir de CMD : .

route add -p 0.0.0.0 MASK 0.0.0.0 <ipaddress> METRIC 5015 IF <interface><ipaddress>est l’adresse .1 du sous-réseau actuel et<interface>est le numéro d’interface.

Pour vérifier que la route ajoutée se trouve dans la table de routage, entrez la commande route print.

Vous pouvez également vérifier la communication sortante en exécutant une commande ping :

ping 8.8.8.8 -S 10.10.11.4

L’indicateur-Svous permet de spécifier une adresse source : dans le cas présent, 10.10.11.4 est l’adresse IP de la carte réseau qui a maintenant une passerelle par défaut.Fermez CMD.

Configurer la cible iSCSI Windows Server 2019

Dans le cadre de ce scénario, vous allez vérifier une configuration où la cible iSCSI Windows Server 2019 est une machine virtuelle s’exécutant sur Hyper-V, en dehors de l’environnement Azure Stack Hub. Cette machine virtuelle est configurée avec 8 processeurs virtuels, un fichier VHDX unique et, plus important encore, deux cartes réseau virtuelles. Dans un scénario idéal, ces cartes réseau ont des sous-réseaux routables différents, mais dans cette vérification, les cartes réseau se trouvent sur le même sous-réseau.

Pour votre serveur cible iSCSI, il peut s’agir de Windows Server 2016 ou 2019, physique ou virtuel, s’exécutant sur Hyper-V, VMware ou sur une autre appliance de votre choix, comme un SAN iSCSI physique dédié. Le point important ici est la connectivité à l’intérieur et à l’extérieur du système Azure Stack Hub. Il est toutefois préférable de disposer de plusieurs chemins entre la source et la destination, car cela fournit une redondance supplémentaire et permet d’utiliser des fonctionnalités plus avancées pour augmenter les performances, comme MPIO.

Je vous encourage à mettre à jour votre cible iSCSI Windows Server 2019 avec les dernières mises à jour cumulatives et les derniers correctifs, en effectuant si nécessaire un redémarrage avant de procéder à la configuration des partages de fichiers.

Une fois que vous avez effectué la mise à jour et le redémarrage, vous pouvez configurer ce serveur comme cible iSCSI.

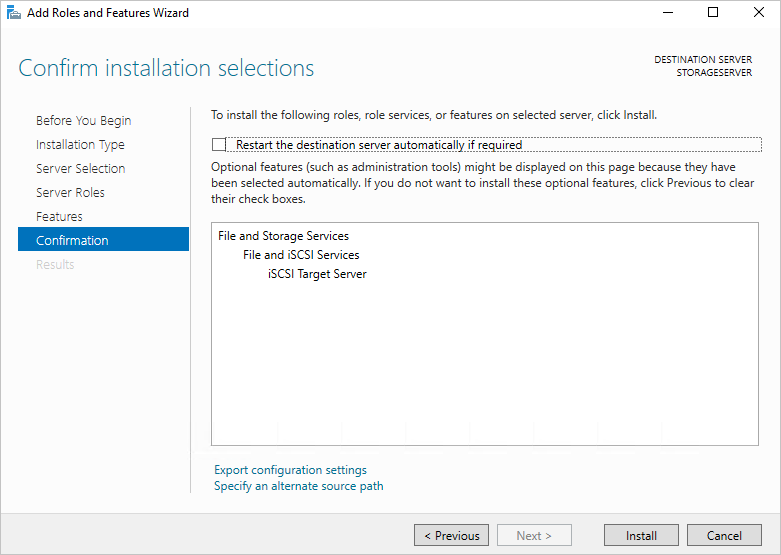

Ouvrez Gestionnaire de serveur et sélectionnez Gérer, puis Ajouter des rôles et des fonctionnalités.

Une fois l’opération effectuée, sélectionnez Suivant, sélectionnez Installation basée sur un rôle ou une fonctionnalité, puis effectuez les sélections jusqu’à atteindre la page Sélectionner des rôles de serveurs.

Développez Services de fichiers et de stockage, développez Services de fichiers et iSCSI, cochez la case Serveur cible iSCSI, acceptez les invites pour ajouter de nouvelles fonctionnalités, puis continuez jusqu’à la fin.

Quand vous avez terminé, fermez le Gestionnaire de serveur.

Ouvrez l’Explorateur de fichiers, accédez à C:\ et créez un dossier appelé iSCSI.

Rouvrez le Gestionnaire de serveur et sélectionnez Services de fichiers et de stockage dans le menu de gauche.

Sélectionnez iSCSI, puis le lien Pour créer un disque virtuel iSCSI, démarrez l’Assistant Nouveau disque virtuel iSCSI dans le volet droit. Sélectionnez-le. Un Assistant apparaît.

Dans la page Sélectionner l’emplacement du disque virtuel iSCSI, sélectionnez la case d’option Taper un chemin personnalisé, puis accédez à votre C:\iSCSI et sélectionnez Suivant.

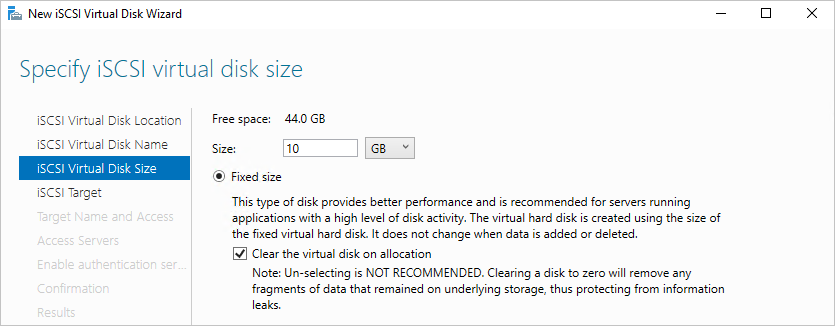

Donnez au disque virtuel iSCSI le nom iSCSIdisk1 et éventuellement une description, puis sélectionnez Suivant.

Définissez la taille du disque virtuel sur 10 Go, sélectionnez Taille fixe, puis Suivant.

Dans la mesure où il s’agit d’une nouvelle cible, sélectionnez Nouvelle cible iSCSI, puis sélectionnez Suivant.

Dans la page Indiquer le nom de la cible, entrez CIBLE1, puis sélectionnez Suivant.

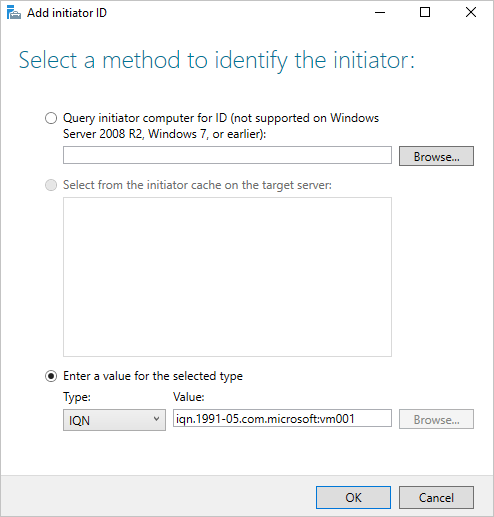

Dans la page Indiquer les serveurs d’accès, sélectionnez Ajouter. Cela entraîne l’ouverture d’une boîte de dialogue qui permet d’entrer des initiateurs spécifiques autorisés à se connecter à la cible iSCSI.

Dans la fenêtre Ajouter l’ID d’initiateur, sélectionnez Entrez une valeur pour le type sélectionné puis, sous Type, vérifiez que IQN est sélectionné dans le menu déroulant. Entrez iqn.1991-05.com.microsoft:<computername> où <computername> est le nom de l’ordinateur VM001, puis sélectionnez Suivant.

Dans la page Activer l’authentification, laissez les zones vides, puis sélectionnez Suivant.

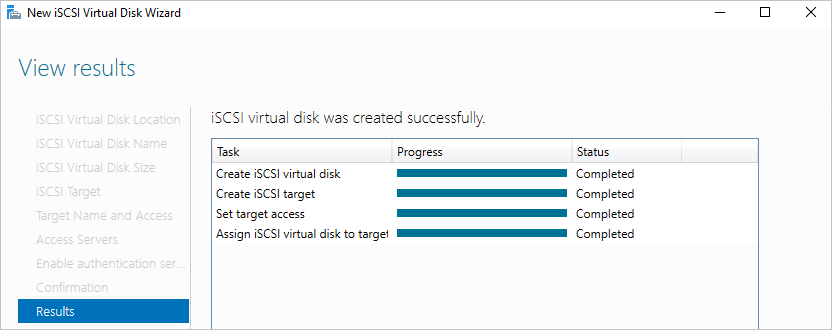

Confirmez vos choix, sélectionnez Créer, puis fermez la fenêtre. Vous devez voir votre disque virtuel iSCSI créé dans le Gestionnaire de serveur.

Configurer l’initiateur iSCSI Windows Server 2019 et MPIO

Pour configurer l’initiateur iSCSI, reconnectez-vous au portail utilisateur Azure Stack Hub sur votre système Azure Stack Hub, puis accédez au panneau Vue d’ensemble de VM001.

Établissez une connexion RDP à VM001. Une fois la connexion effectuée, ouvrez le Gestionnaire de serveur.

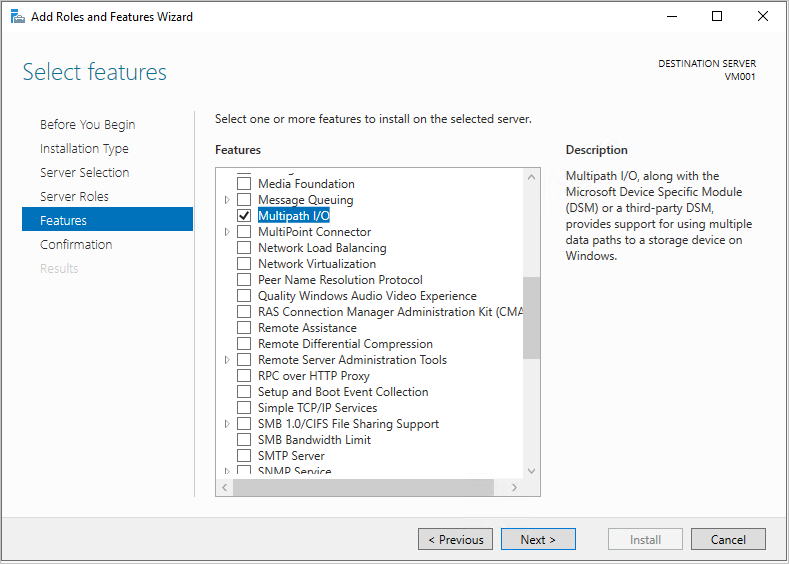

Sélectionnez Ajouter des rôles et des fonctionnalités, puis acceptez les valeurs par défaut jusqu’à ce que vous atteigniez la page Fonctionnalités.

Dans la page Fonctionnalités, ajoutez MPIO (Multipath I/O), puis sélectionnez Suivant.

Cochez la case Redémarrer automatiquement le serveur de destination, si nécessaire et sélectionnez Installer, puis Fermer. Un redémarrage est probablement nécessaire. Une fois effectué, reconnectez-vous à VM001.

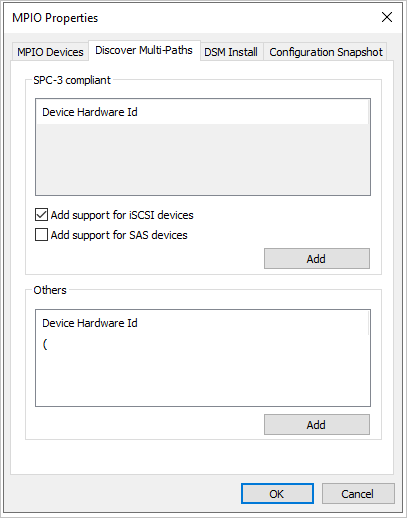

De retour dans Gestionnaire de serveur, attendez la fin de l’installation du MPIO, sélectionnez fermer, Outils, puis MPIO.

Sélectionnez l’onglet Découvrir plusieurs chemins, cochez la case pour Ajouter la prise en charge des périphériques iSCSI, sélectionnez Ajouter, puis sélectionnez Oui pour redémarrer VM001. Si vous ne voyez pas de fenêtre, sélectionnez OK, puis redémarrez manuellement.

Une fois le redémarrage effectué, établissez une nouvelle connexion RDP à VM001.

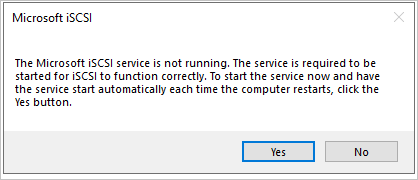

Une fois la connexion effectuée, ouvrez Gestionnaire de serveur, sélectionnez Outils, puis Initiateur iSCSI.

Quand une fenêtre iSCSI Microsoft apparaît, sélectionnez Oui pour autoriser le service iSCSI à s’exécuter par défaut.

Dans la fenêtre Propriétés de l’initiateur iSCSI, sélectionnez l’onglet Découverte.

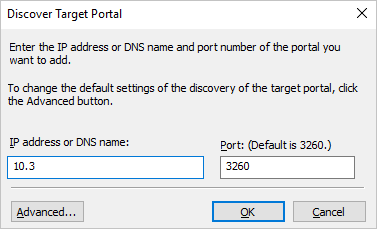

Vous allez maintenant ajouter 2 cibles, donc sélectionnez d’abord le bouton Découvrir un portail.

Entrez la première adresse IP de votre serveur cible iSCSI, puis sélectionnez Avancé.

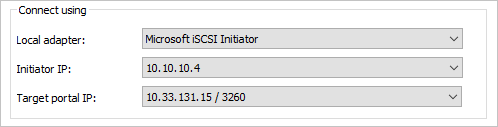

Dans la fenêtreParamètres avancés, sélectionnez les options suivantes, puis sélectionnez OK.

a. Adaptateur local : Initiateur Microsoft iSCSI.

b. Adresse IP de l’initiateur : 10.10.10.4.

De retour dans la fenêtre Découvrir le portail cible, sélectionnez OK.

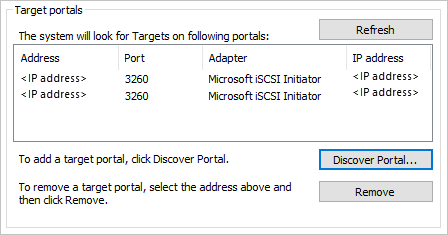

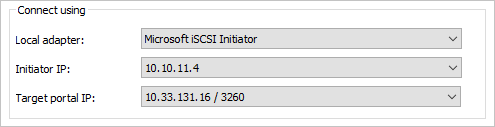

Répétez le processus avec ce qui suit :

a. Adresse IP : votre deuxième adresse IP cible iSCSI.

b. Adaptateur local : Initiateur Microsoft iSCSI.

c. Adresse IP de l’initiateur : 10.10.11.4.

Les portails cibles doivent ressembler à ce qui suit, avec vos propres adresses IP cibles iSCSI sous la colonne Adresse.

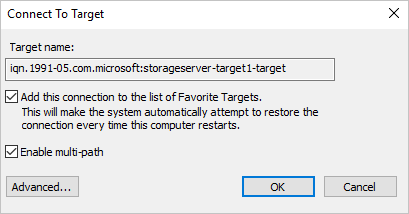

De retour sous l’onglet Cibles, sélectionnez votre cible iSCSI au milieu de la fenêtre, puis sélectionnez Se connecter.

Dans la fenêtre Se connecter à la cible, cochez la case Activer la prise en charge de plusieurs chemins d’accès, puis sélectionnez Avancé.

Entrez les informations suivantes et sélectionnez OK puis, dans la fenêtre Se connecter à la cible, sélectionnez OK.

a. Adaptateur local : Initiateur Microsoft iSCSI.

b. Adresse IP de l’initiateur : 10.10.10.4.

c. IP du portail cible : <IP de votre première cible iSCSI / 3260>.

Répétez le processus pour la deuxième combinaison initiateur/cible.

a. Adaptateur local : Initiateur Microsoft iSCSI.

b. Adresse IP de l’initiateur : 10.10.11.4.

c. IP du portail cible : <IP de votre deuxième cible iSCSI / 3260>.

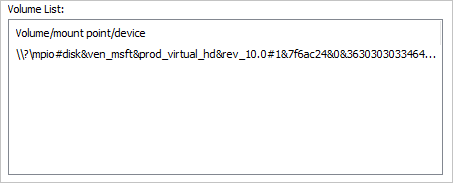

Sélectionnez l’onglet Volumes et périphériques, puis Configuration automatique, un volume MPIO doit vous être présenté :

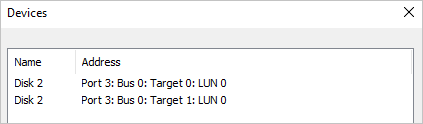

De retour sous l’onglet Cibles, sélectionnez Périphériques. Vous devez voir 2 connexions au disque dur virtuel iSCSI que vous avez créé précédemment.

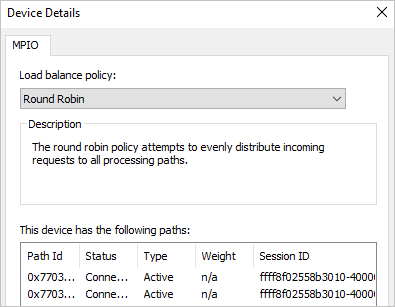

Sélectionnez le bouton MPIO pour voir des informations supplémentaires sur les chemins et la stratégie d’équilibrage de charge.

Sélectionnez OK trois fois pour quitter les fenêtres et l’initiateur iSCSI.

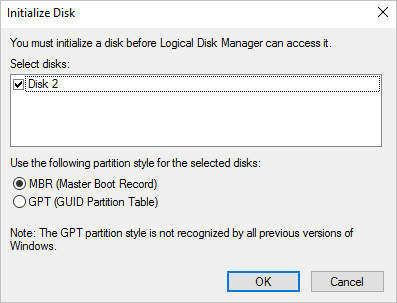

Ouvrez Gestion des disques (diskmgmt.msc) : une fenêtre Initialiser le disque doit apparaître.

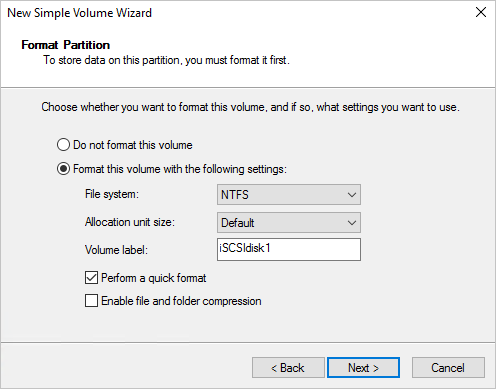

Sélectionnez OK pour accepter les valeurs par défaut, faites défiler l’affichage jusqu’au nouveau disque, cliquez avec le bouton droit sur celui-ci, puis sélectionnez Nouveau volume simple

Suivez les étapes de l’Assistant en acceptant les valeurs par défaut. Remplacez l’étiquette de volume par iSCSIdisk1, puis sélectionnez Terminer.

Le lecteur est ensuite formaté et présenté avec une lettre de lecteur.

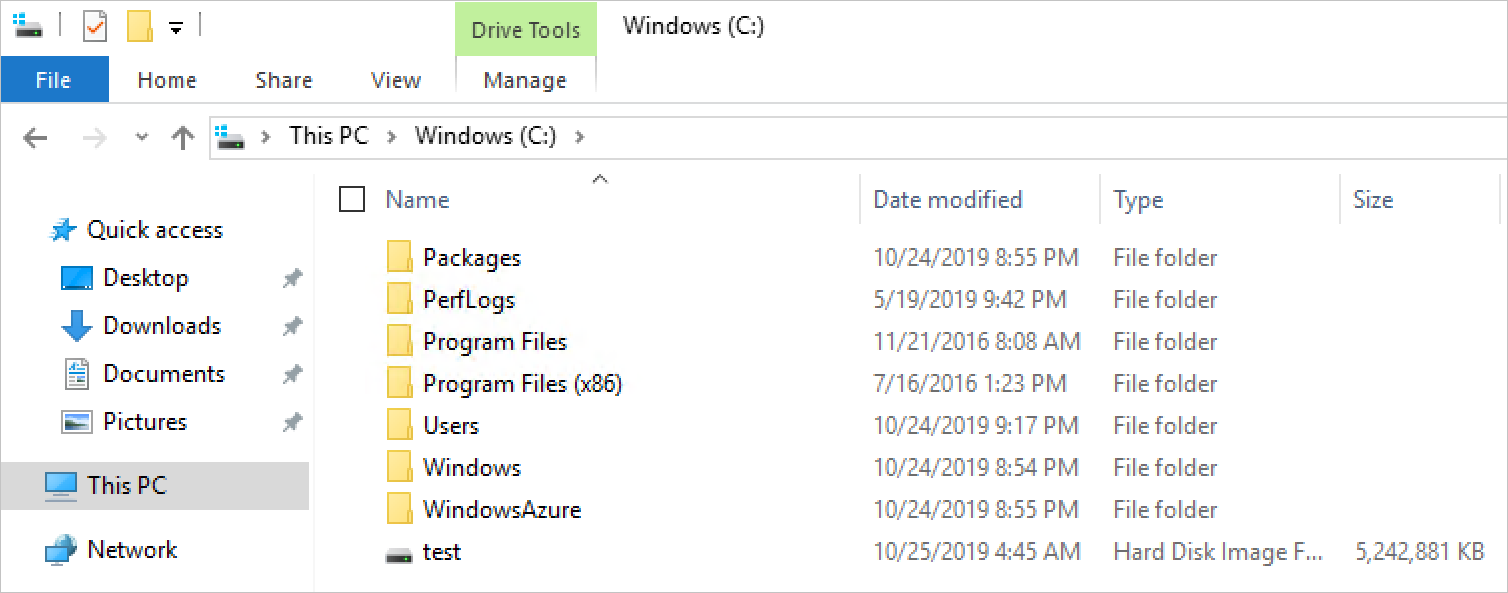

Ouvrez l’Explorateur de fichiers, puis sélectionnez Ce PC pour voir votre nouveau lecteur attaché à VM001.

Test de la connectivité du stockage externe

Pour vérifier la communication et effectuer un test rudimentaire de copie de fichier, connectez-vous d’abord au portail utilisateur Azure Stack Hub sur votre système Azure Stack Hub, puis accédez au panneau Vue d’ensemble pour VM001

Sélectionnez Se connecter pour établir une connexion RDP à VM001.

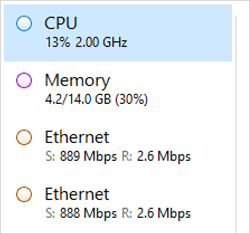

Ouvrez Gestionnaire des tâches, sélectionnez l’onglet Performances, puis alignez la fenêtre sur le côté droit de la session RDP.

Ouvrez Windows PowerShell ISE en tant qu’administrateur, et ancrez-le à gauche de la session RDP. À droite d’ISE, fermez le volet Commandes, puis sélectionnez le bouton Script pour développer le volet de script blanc en haut de la fenêtre d’ISE.

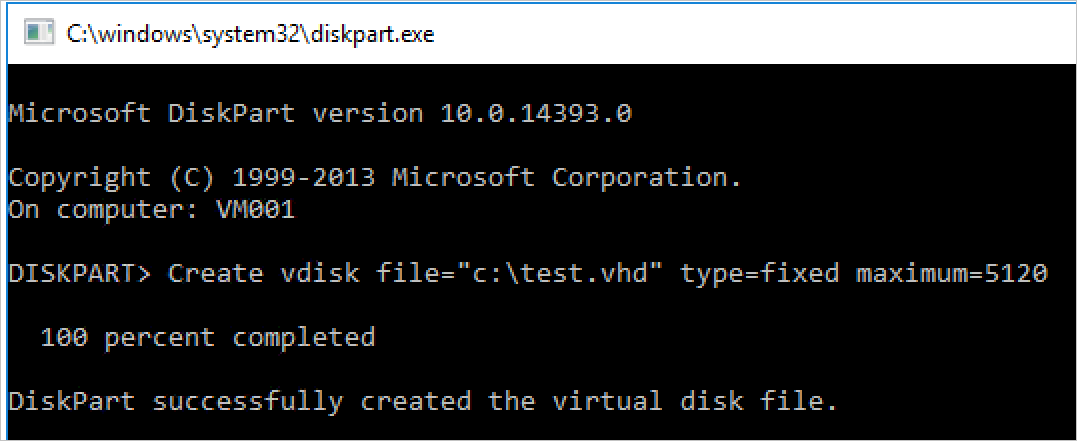

Dans cette machine virtuelle, il n’existe aucun module PowerShell natif pour créer un disque dur virtuel à utiliser comme gros fichier pour tester le transfert de fichiers vers la cible iSCSI. Dans ce cas, nous allons exécuter DiskPart pour créer un fichier VHD. Dans ISE, exécutez ce qui suit :

Start-Process DiskpartUne nouvelle fenêtre CMD s’ouvre. Entrez ceci :

**Create vdisk file="c:\\test.vhd" type=fixed maximum=5120**

- L’exécution de cette opération va prendre quelques instants. Une fois l’opération effectuée, pour vérifier la création, ouvrez l’Explorateur de fichiers et accédez à C:\ : vous devez normalement voir le nouveau fichier test.vhd avec une taille de 5 Go.

Fermez la fenêtre CMD et revenez à l’environnement ISE, puis entrez la commande suivante dans la fenêtre de script. Remplacez F:\ par la lettre du lecteur cible iSCSI qui a été appliquée.

Copy-Item "C:\\test.vhd" -Destination "F:\\"Sélectionnez la ligne dans la fenêtre de script, puis appuyez sur F8 pour l’exécuter.

Pendant que la commande s’exécute, examinez les deux cartes réseau et observez le transfert de données qui a lieu entre celles-ci dans VM001. Notez également que chaque carte réseau doit partager la charge de manière égale.

Ce scénario a été conçu pour mettre en évidence la connectivité entre une charge de travail exécutée sur Azure Stack Hub et une baie de stockage externe, dans le cas présent, une cible iSCSI Windows Server. Il n’a pas été conçu pour être un test de performances ni pour refléter les étapes à suivre si vous utilisez une autre appliance basée sur iSCSI. Toutefois, il met en évidence certaines des considérations principales à prendre en compte durant le déploiement de charges de travail sur Azure Stack Hub ainsi que durant la connexion aux systèmes de stockage externes à l’environnement Azure Stack Hub.

Étapes suivantes

Différences et considérations relatives aux réseaux Azure Stack Hub