Se connecter à Azure AI Services depuis des workflows standard dans Azure Logic Apps

S’applique à : Azure Logic Apps (Standard)

Pour intégrer des données et des services d’entreprise à des technologies IA, vous pouvez utiliser les connecteurs intégrés Azure OpenAI et Recherche Azure AI dans les workflows d’application logique Standard automatisés. Ces connecteurs prennent en charge plusieurs types d’authentification, tels que les clés API, Microsoft Entra ID et les identités managées. Ils peuvent aussi se connecter aux points de terminaison Azure OpenAI Service et Recherche Azure AI derrière des pare-feux afin que vos workflows se connectent en toute sécurité à vos ressources IA dans Azure.

Ce guide offre une vue d’ensemble et des exemples permettant d’utiliser les opérations du connecteur Azure OpenAI et Recherche Azure AI dans votre workflow.

Pourquoi utiliser Azure Logic Apps avec des services IA ?

En règle générale, la création de solutions IA implique plusieurs étapes clés et nécessite quelques blocs de développement. D’abord, vous devez disposer d’un pipeline d’ingestion dynamique et d’une interface de conversation instantanée qui peuvent communiquer avec de grands modèles de langage (LLM) et des bases de données vectorielles.

Conseil

Pour en savoir plus, vous pouvez poser ces questions à Azure Copilot :

- Qu’est-ce qu’un pipeline d’ingestion dynamique dans l’IA ?

- Qu’est-ce qu’une base de données vectorielle dans l’IA?

Pour rechercher Azure Copilot, dans la barre d’outils du Portail Azure, sélectionnez Copilot.

Vous pouvez assembler différents composants, non seulement pour effectuer l’ingestion des données, mais également pour fournir un back-end robuste pour l’interface de conversation instantanée. Ce back-end facilite la saisie d’invites et génère des réponses fiables pendant les interactions. Toutefois, la création de code pour manager et contrôler tous ces éléments peut s’avérer difficile, ce qui est le cas pour la plupart des solutions.

Azure Logic Apps offre une approche avec peu de code et simplifie la gestion du back-end en fournissant des connecteurs prédéfinis que vous utilisez comme blocs de développement pour simplifier le processus de back-end. Cette approche vous permet de vous concentrer sur l’approvisionnement de vos données et de vous assurer que les résultats de la recherche fournissent des informations pertinentes et actuelles. Avec ces connecteurs IA, votre workflow agit comme un moteur d’orchestration qui transfère les données entre les services IA et d’autres composants que vous souhaitez intégrer.

Pour plus d’informations, consultez les ressources suivantes :

- Présentation des grands modèles de langage

- Guide d’utilisation de grands modèles de langage

- Qu’est-ce qu’une base de données vectorielle ?

Référence technique du connecteur

Azure OpenAI

Azure OpenAI Service fournit un accès aux modèles de langage de OpenAI, dont les modèles GPT-4, GPT-4 Turbo avec Vision, GPT-3.5-Turbo et les modèles d’incorporation. Avec le connecteur Azure OpenAI, votre workflow peut se connecter à Azure OpenAI Service et obtenir des incorporations OpenAI pour vos données ou générer des complétions de conversation.

Conseil

Pour en savoir plus, vous pouvez poser ces questions à Azure Copilot :

- Qu’est-ce qu’une incorporation dans l’IA ?

- Qu’est-ce qu’une complétion de conversation dans l’IA ?

Pour rechercher Azure Copilot, dans la barre d’outils du Portail Azure, sélectionnez Copilot.

| Application logique | Environnement | Version du connecteur |

|---|---|---|

| Standard | Azure Logic Apps monolocataire et App Service Environment v3 (plans Windows uniquement) | Connecteur intégré, qui apparaît dans la galerie de connecteurs sous Runtime>dans l’application et qui est basé sur un fournisseur de services. Le connecteur intégré peut accéder directement aux réseaux virtuels Azure sans passerelle de données locale. Pour plus d’informations, consultez Référence du connecteur intégré Azure OpenAI. |

Recherche Azure AI

Recherche Azure AI est une plateforme pour la récupération d’informations basée sur l’IA qui aide les développeurs à créer des expériences de recherche enrichies et des applications IA génératives en combinant de grands modèles de langage avec des données d’entreprise. Avec le connecteur Recherche Azure AI, votre workflow peut se connecter à Recherche Azure AI pour indexer des documents et effectuer des recherches vectorielles sur vos données.

| Application logique | Environnement | Version du connecteur |

|---|---|---|

| Standard | Azure Logic Apps monolocataire et App Service Environment v3 (plans Windows uniquement) | Connecteur intégré, qui apparaît dans la galerie de connecteurs sous Runtime>dans l’application et qui est basé sur un fournisseur de services. Le connecteur intégré peut accéder directement aux réseaux virtuels Azure sans passerelle de données locale. Pour plus d’informations, consultez Référence du connecteur intégré de Recherche Azure AI. |

Authentification

Les deux connecteurs IA prennent en charge plusieurs méthodes d’authentification avec votre point de terminaison de service IA. Ces options fournissent une authentification robuste qui répond à la plupart des besoins des clients. Les deux connecteurs IA peuvent également se connecter directement aux services Azure OpenAI et Recherche Azure AI à l’intérieur de réseaux virtuels.

La liste suivante décrit ces options. Toutes nécessitent que vous fournissiez le point de terminaison de service.

| Type d'authentification | Description |

|---|---|

| Authentification basée sur une clé | Fournissez la clé API ou l’administrateur généré par le service IA. |

| Microsoft Entra ID, anciennement Azure Active Directory | Fournissez des informations comme votre locataire Entra, votre ID client et votre mot de passe pour l’authentification en tant qu’utilisateur Entra. |

| Identité gérée | Après avoir activé l’authentification d’identité managée sur votre service IA et votre ressource d’application logique, vous pouvez utiliser cette identité pour authentifier l’accès au connecteur. |

Pour plus d’informations, consultez les ressources suivantes :

- Authentifier les requêtes auprès des services Azure AI

- Qu’est-ce que Microsoft Entra ID ?

- Que sont les identités managées pour les ressources Azure ?

- Authentifiez l’accès et les connexions aux ressources Azure avec des identités managées dans Azure Logic Apps

Ajoutez une action Azure OpenAI ou Recherche Azure AI à votre workflow

Actuellement, les connecteurs intégrés pour Azure OpenAI et Recherche Azure AI fournissent uniquement des actions, et non des déclencheurs. Vous pouvez démarrer votre workflow avec n’importe quel déclencheur adapté à votre scénario ou vos besoins, puis suivre ces étapes générales pour ajouter des actions pour Azure OpenAI, Recherche Azure AI et d’autres opérations.

Scénarios

Les scénarios suivants décrivent seulement deux des nombreuses façons dont vous pouvez utiliser les opérations de connecteur IA dans vos workflows :

Créez une base de connaissances pour vos données d’entreprise

Azure Logic Apps fournit plus de 1 000 connecteurs managés par Microsoft et des connecteurs intégrés exécutés en mode natif pour que votre workflow se connecte en toute sécurité avec presque n’importe quelle source de données, comme SharePoint, Oracle DB, Salesforce, OneDrive, Dropbox, SAP, IBM, etc. Chaque connecteur fournit des opérations, qui incluent des déclencheurs, des actions ou les deux, à utiliser dans votre workflow.

Par exemple, vous pouvez choisir parmi de nombreux types de déclencheurs pour que votre workflow automatisé s’exécute selon une planification ou en fonction d’événements spécifiques, tels que le chargement de nouveaux documents sur un site SharePoint. Avec autant d’opérations au choix, vous pouvez créer une base de connaissances et créer facilement un pipeline d’ingestion de documents à l’aide d’incorporations vectorielles pour ces documents dans Recherche Azure AI.

Pour plus d’informations, consultez les ressources suivantes :

- Vecteurs dans Recherche Azure AI

- Que sont les incorporations ?

- Comprendre les incorporations dans Azure OpenAI

Générez des achèvements

Un workflow Azure Logic Apps peut accepter l’entrée, tandis que Azure OpenAI Service peut effectuer des opérations d’achèvement. Ces fonctionnalités signifient que votre workflow peut ingérer des questions en temps réel, générer des réponses sur vos données ou envoyer des réponses automatisées à l’aide de Azure OpenAI. Vous pouvez immédiatement renvoyer les réponses au client ou à un workflow d’approbation pour la vérification.

Pour plus d’informations, consultez les ressources suivantes :

Exemple de scénario avec exemple de code : ingérer des données et créer des interactions de conversation instantanée

Cet exemple montre comment utiliser les connecteurs Azure OpenAI et Recherche Azure AI pour décomposer la logique back-end pour ingérer des données et mener des conversations simples dans deux workflows clés. Pour des performances plus rapides, créez des workflows sans état qui, par défaut, n’enregistrent et ne stockent pas l’historique à chaque exécution.

Exemple de code

Créez une conversation à l’aide de données ingérées

Prérequis

Consultez les conditions requises pour l’exemple de code.

Les valeurs de paramètre inter-environnement suivantes sont également utilisées par les opérations de workflow dans cet exemple :

| Nom du paramètre | Description |

|---|---|

| aisearch_admin_key | La clé d'administration de Recherche Azure AI |

| aisearch_endpoint | L’URL du point de terminaison de l’exemple Recherche Azure AI |

| aisearch_index_name | L’index à utiliser pour l’exemple Recherche Azure AI |

| openapi_api_key | La clé API pour Azure OpenAI |

| openai_deployment_id | L’ID de déploiement de l’exemple Azure OpenAI |

| openai_endpoint | L’URL du point de terminaison de l’exemple Azure OpenAI |

| tokenize_function_url | L’URL d’une fonction Azure personnalisée qui traite par lots et tokenise des données, requise pour que Azure OpenAI crée correctement des incorporations pour cet exemple. Pour plus d’informations sur cette fonction, consultez l’exemple de code pour « Créez une conversation à l’aide de données ingérées ». |

Vidéo : découvrez comment créer des applications IA à l’aide d’applications logiques

Découvrez comment compiler des applications IA à l’aide d’applications logiques

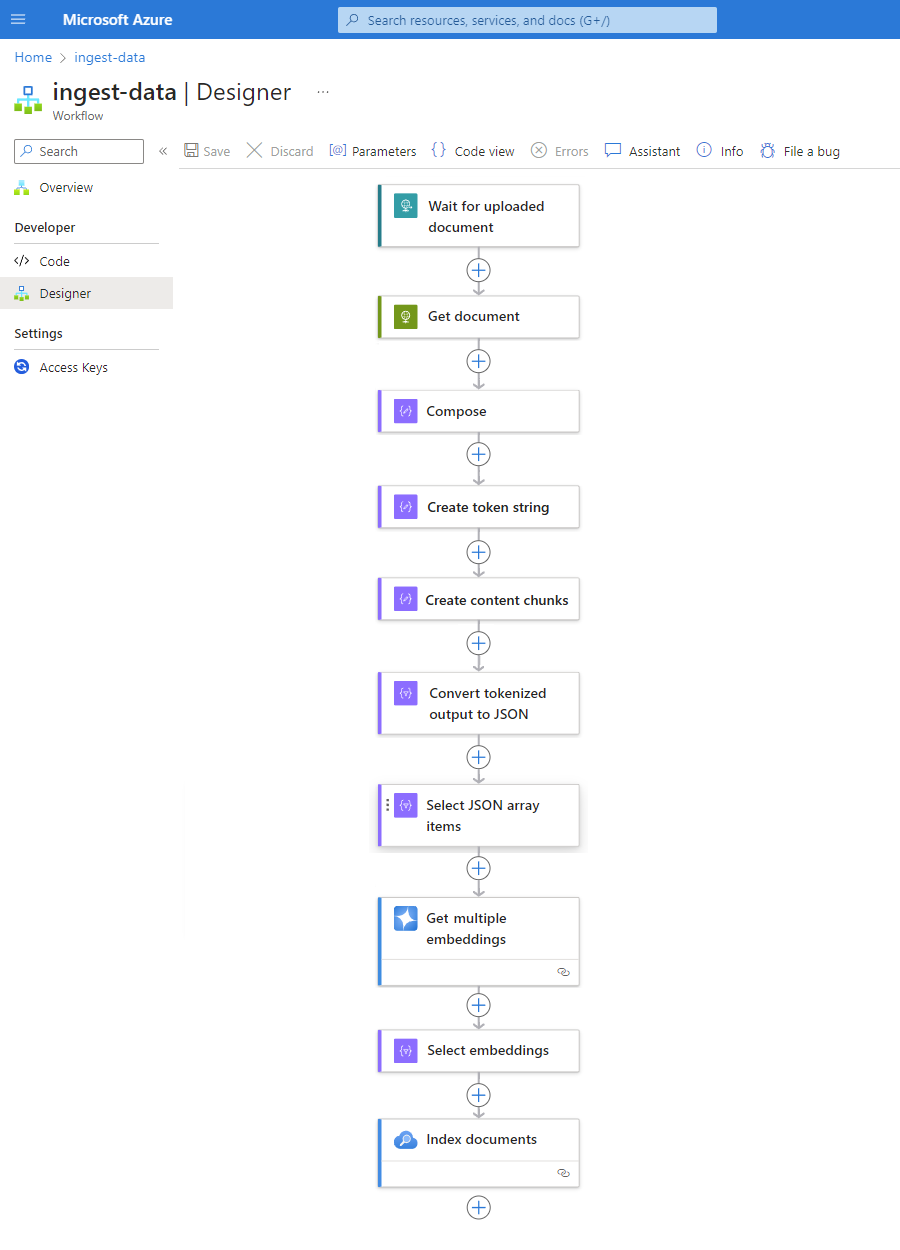

Ingérez un workflow de données

Pour économiser du temps et de l’énergie lorsque vous générez un pipeline d’ingestion, implémentez le modèle suivant avec n’importe quelle source de données. Ce modèle encapsule tous les avantages actuellement proposés par les workflows Standard dans l’application à locataire unique Azure Logic Apps.

Chaque étape de ce modèle garantit que l’IA extrait en toute transparence toutes les informations cruciales de vos fichiers de données. S’il s’exécute en tant que workflow sans état, ce modèle offre également des performances plus rapides. Cette approche simplifie non seulement l’aspect du codage, mais garantit également que vos workflows ont des processus d’authentification, de supervision et de déploiement efficaces en place.

| Step | Task | Opération sous-jacente | Description |

|---|---|---|---|

| 1 | Recherchez de nouvelles données. | Quand une requête HTTP arrive | Un déclencheur qui interroge ou attend que de nouvelles données arrivent, soit en fonction d’une périodicité planifiée, soit en réponse à des événements spécifiques respectivement. Un tel événement peut être un nouveau fichier chargé dans un système de stockage spécifique, tel que SharePoint, OneDrive ou Stockage Blob Azure. Dans cet exemple, l’opération de déclenchement de la Requête attend une requête HTTP ou HTTPS envoyée à partir d’un autre point de terminaison. La requête inclut l’URL d’un nouveau document chargé. |

| 2 | Obtenez les données. | HTTP | Une action HTTP qui récupère le document chargé à l’aide de l’URL du fichier de sortie du déclencheur. |

| 3 | Composez les détails du document. | Composer. | Une action Opérations de données qui concatène différents éléments. Cet exemple concatène des informations clé-valeur sur le document. |

| 4 | Créer une chaîne de jeton. | Analyser un document | Action Opérations de données qui produit une chaîne de jetons à l’aide de la sortie de l’action Composer. |

| 5 | Créer des blocs de contenu. | Bloc de texte | Action Opérations de données qui fractionne la chaîne de jeton, en fonction du nombre de caractères ou de jetons par bloc de contenu. |

| 6 | Convertissez des données tokenisées en JSON. | Analyser JSON | Une action Opérations de données qui convertit les blocs de chaînes de jetons en tableau JSON. |

| 7 | Sélectionnez des éléments de tableau JSON. | Select | Une action Opérations de données qui sélectionne plusieurs éléments dans le tableau JSON. |

| 8 | Générez les incorporations. | Obtenez plusieurs incorporations | Une action Azure OpenAI qui crée des incorporations pour chaque élément de tableau JSON. |

| 9 | Sélectionnez des incorporations et d’autres informations. | Select | Une action Opérations de données qui sélectionne les incorporations et d’autres informations de document. |

| 10 | Indexez les données. | Indexez les documents | Une action Recherche Azure AI qui indexe les données en fonction de chaque incorporation sélectionnée. |

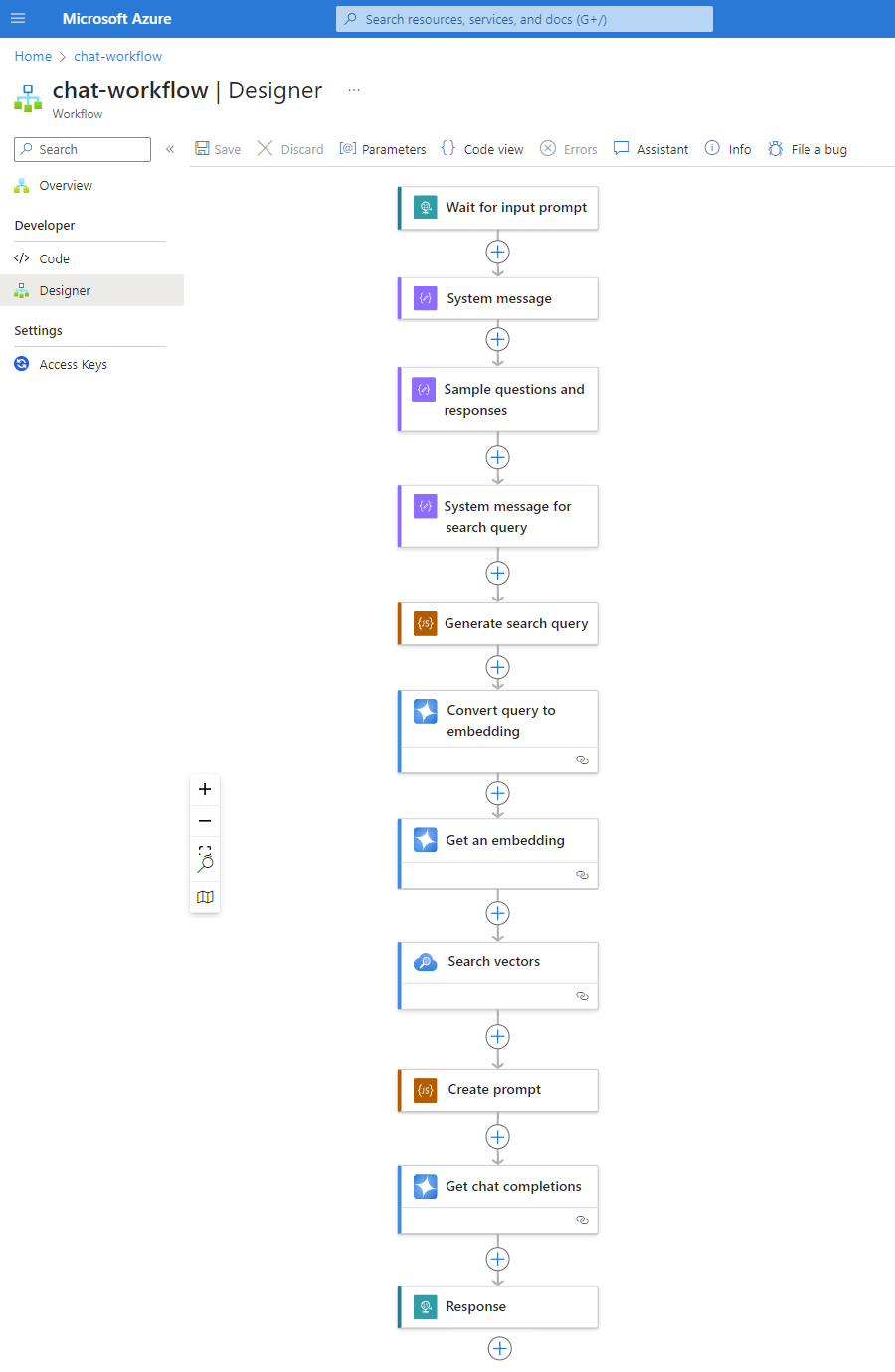

Workflow de conversation

À mesure que vos bases de données vectorielles ingèrent des données, assurez-vous qu’elles sont facilement recherchables pour qu’en cas de question d’un utilisateur, le workflow de l’application logique back-end puisse traiter l’invite et générer une réponse fiable.

Le modèle suivant n’est qu’un exemple qui montre à quoi un workflow de conversation peut ressembler :

| Step | Task | Opération sous-jacente | Description |

|---|---|---|---|

| 1 | Attendez l’invite d’entrée. | Quand une requête HTTP arrive | Un déclencheur qui interroge ou attend que de nouvelles données arrivent, soit en fonction d’une périodicité planifiée, soit en réponse à des événements spécifiques respectivement. Dans cet exemple, le déclencheur Requête attend et capture la question du client. |

| 2 | Message système d’entrée pour le modèle. | Composer. | Une action Opérations de données qui fournit une entrée pour entraîner le modèle. |

| 3 | Exemples de questions et réponses d’entrée. | Composer. | Une action Opérations de données qui fournit des exemples de questions client et des rôles associés pour entraîner le modèle. |

| 4 | Message système d’entrée pour la requête de recherche. | Composer. | Une action Opérations de données qui fournit une requête de recherche pour entraîner le modèle. |

| 5 | Générez une requête de recherche. | Exécuter du code JavaScript | Une action Code inclus qui utilise JavaScript pour créer une requête de recherche pour le magasin de vecteurs, en fonction des sorties des actions Composer précédentes. |

| 6 | Convertissez la requête en incorporation. | Obtenez des complétions de conversation | Une action Azure OpenAI qui se connecte à l’API d’achèvement de conversation, ce qui garantit des réponses fiables dans les conversations. Dans cet exemple, l’action accepte les requêtes de recherche et les rôles comme entrée dans le modèle et retourne des incorporations vectorielles en tant que sortie. |

| 7 | Obtenez une incorporation. | Obtenez une incorporation | Une action Azure OpenAI qui obtient un seul vecteur incorporé. |

| 8 | Recherchez la base de données vectorielle. | Vecteurs de recherche | Une action Recherche Azure AI qui exécute des recherches dans le magasin vectoriel. |

| 9 | Créez une invite. | Exécuter du code JavaScript | Une action Code inclus qui utilise JavaScript pour générer des invites. |

| 10 | Effectuez une complétion de conversation. | Obtenez des complétions de conversation | Une action Azure OpenAI qui se connecte à l’API d’achèvement de conversation, ce qui garantit des réponses fiables dans les conversations. Dans cet exemple, l’action accepte les invites et les rôles comme entrée dans le modèle et retourne des réponses générées par un modèle en tant que sortie. |

| 11 | Retournez une réponse. | Response | Une action de Requête qui retourne les résultats à l’appelant lorsque vous utilisez le déclencheur de Requête. |

Voir aussi

Les connecteurs Azure OpenAI et Recherche Azure AI sont maintenant en disponibilité généraleConnecteurs Azure OpenAI et Recherche AI pour Azure Logic Apps (Standard)