Afficher les rapports d’analyse dans l’Assistant Expérimentation de base de données

Remarque

Cet outil a été mis hors service le 15 décembre 2024. Nous avons cessé de prendre en charge cet outil pour tous les problèmes qui se produisent et n’émettrons pas de correctifs de bogues ou de mises à jour supplémentaires.

Après avoir utilisé l’Assistant d'Expérimentation de base de données (DEA) pour créer un rapport d’analyse, vous pouvez consulter le rapport pour obtenir des aperçus des performances en fonction du test A/B que vous avez effectué.

Ouvrir un rapport d’analyse existant

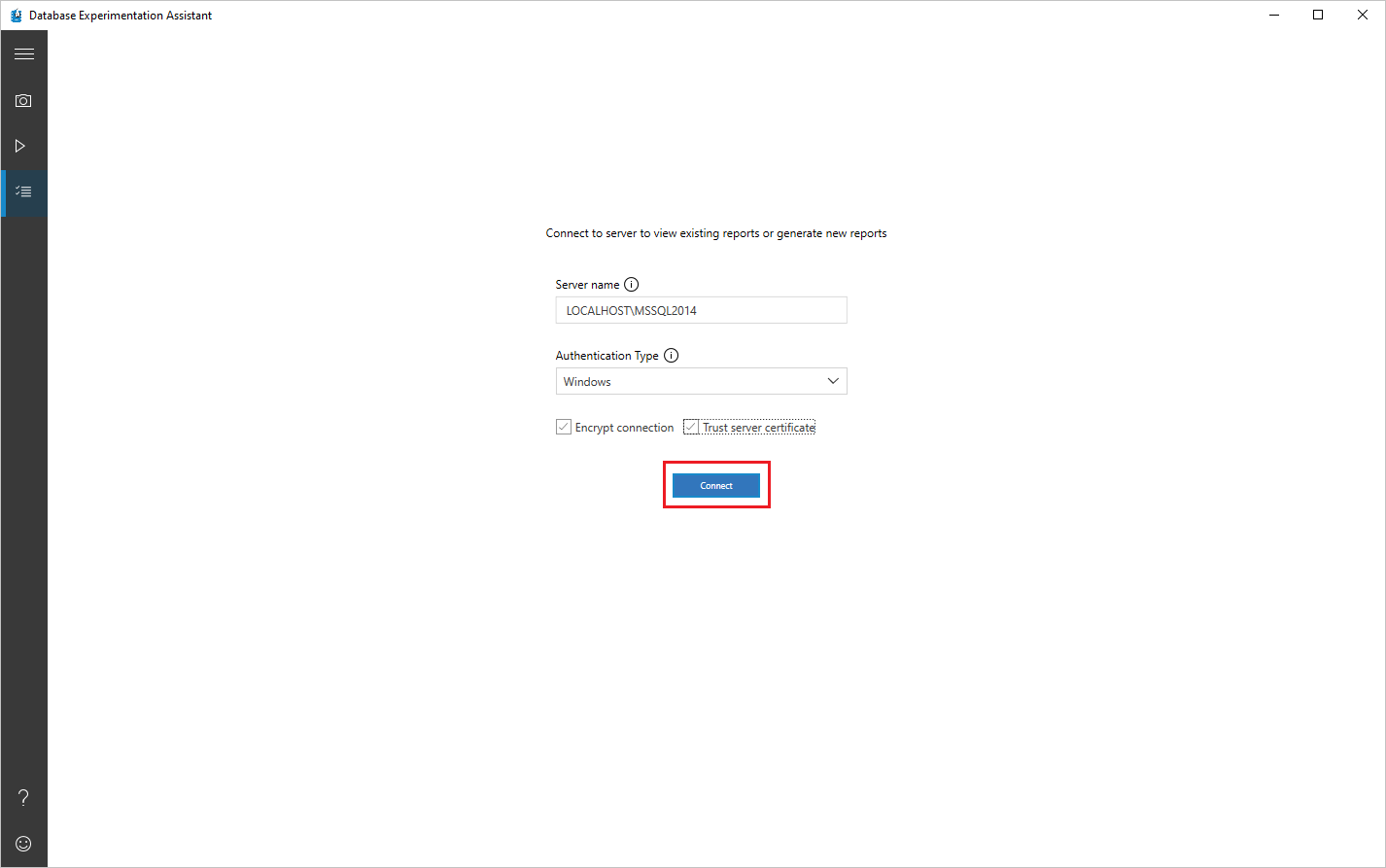

Dans DEA, sélectionnez l’icône de liste, spécifiez le nom du serveur et le type d’authentification, sélectionnez ou désélectionnez les cases Chiffrer la connexion et Faire confiance au certificat du serveur selon votre cas, puis sélectionnez Connecter.

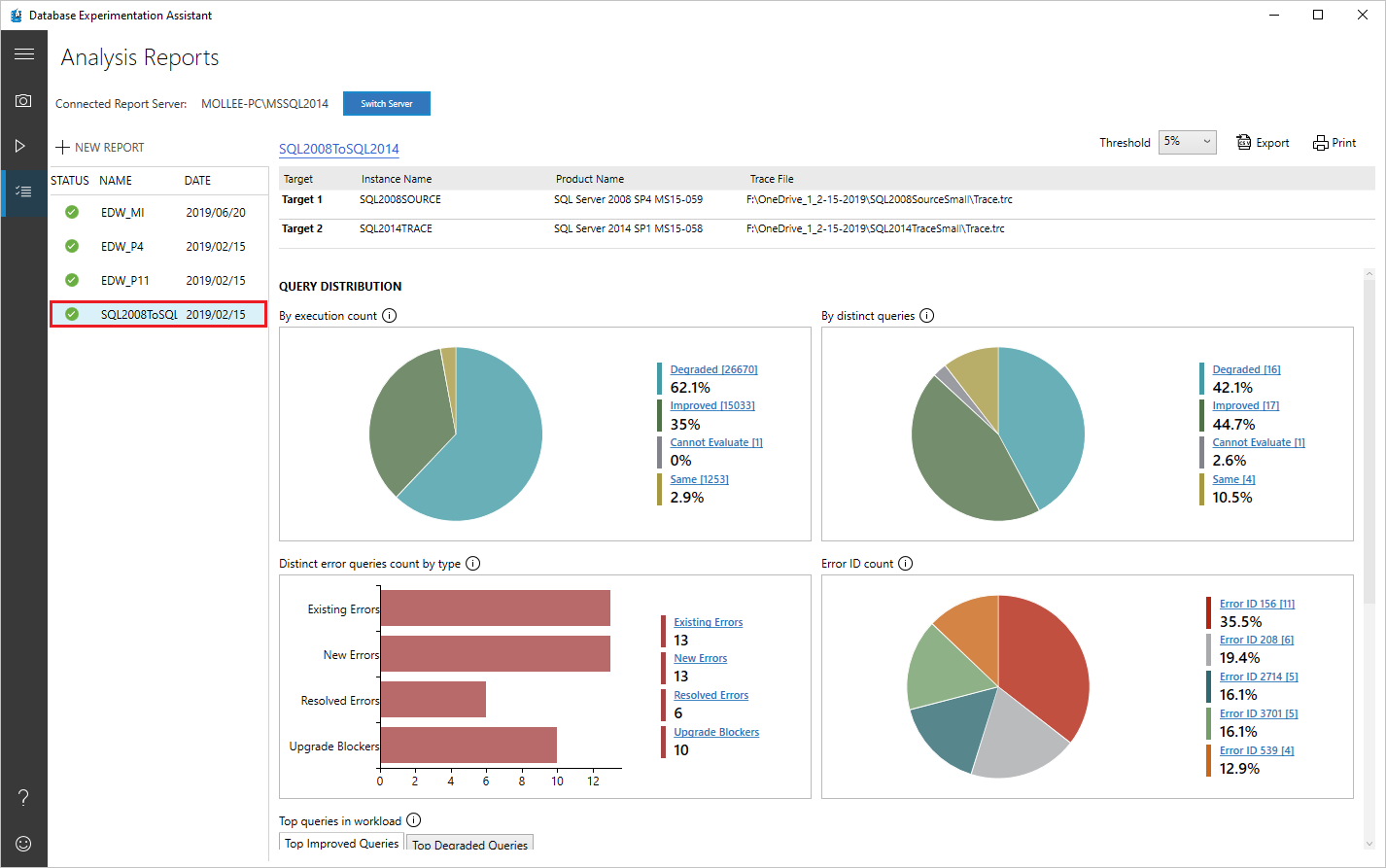

Dans l’écran Rapports d’analyse, sur le côté gauche, sélectionnez l’entrée du rapport que vous souhaitez afficher.

Afficher et comprendre le rapport d’analyse

Cette section vous guide tout au long du rapport d’analyse.

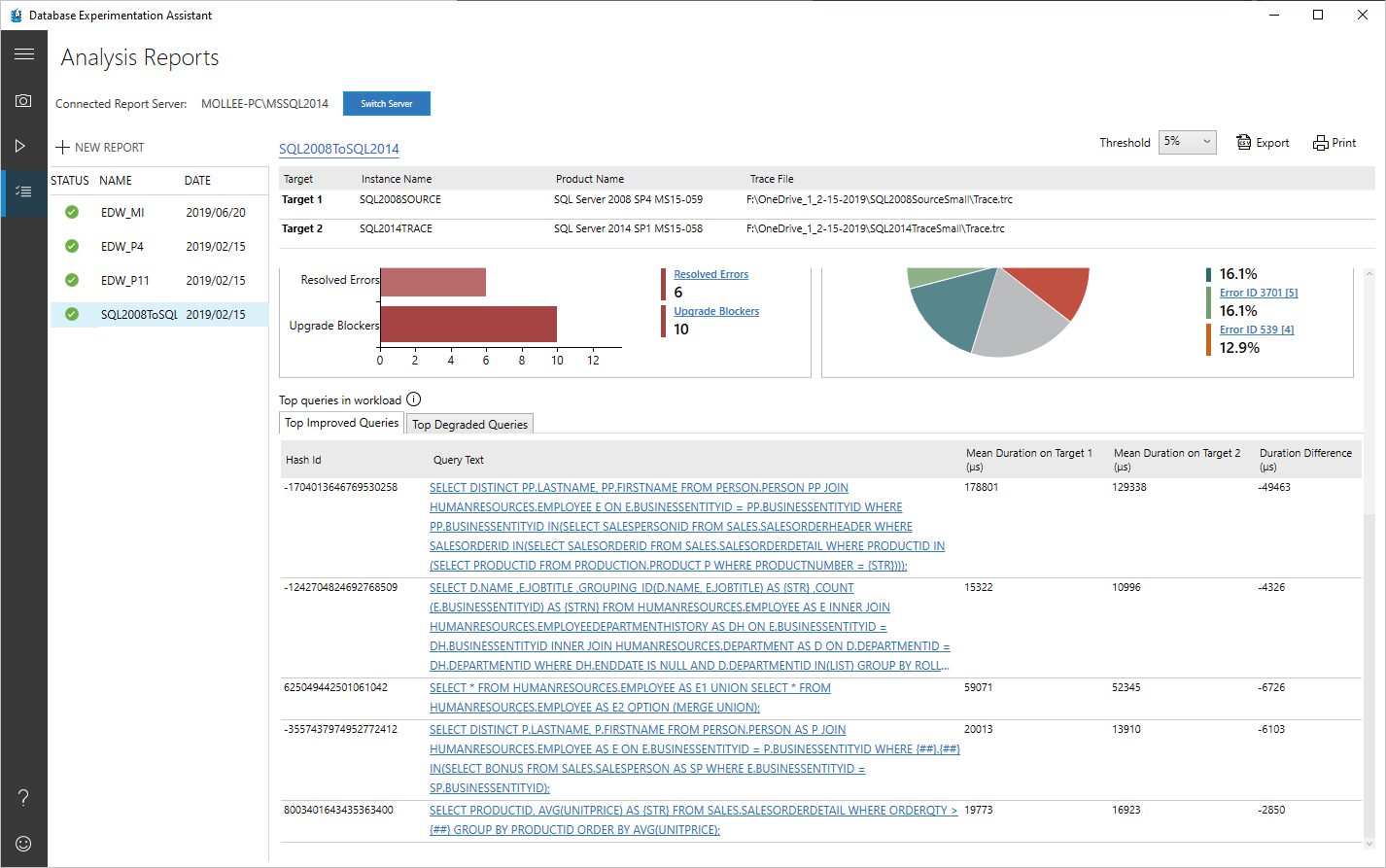

Sur la première page de votre rapport, des informations sur la version et les informations de build pour les serveurs cibles sur lesquels l’expérience a été exécutée s’affichent. Le seuil vous permet d’ajuster la sensibilité ou la tolérance de votre analyse de test A/B. Par défaut, le seuil est défini à 5%; toute amélioration des performances >= 5% est classée comme « Amélioré ». La liste déroulante vous permet d’évaluer le rapport avec des seuils de performances différents.

Vous pouvez exporter les données du rapport vers un fichier au format CSV en sélectionnant Exporter bouton. Sur n’importe quelle page du rapport d’analyse, vous pouvez sélectionner imprimer pour imprimer ce qui est visible à l’écran à ce moment-là.

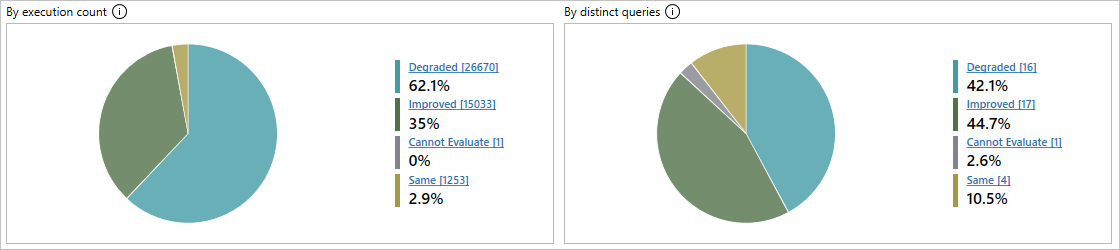

Distribution des requêtes

Sélectionnez différentes tranches des graphiques en secteurs pour afficher uniquement les requêtes qui appartiennent à cette catégorie.

- détérioré: requêtes ayant des performances inférieures sur la cible 2 par rapport à la cible 1.

- Erreurs: requêtes qui ont montré des erreurs au moins une fois sur au moins une des cibles.

- Amélioré: Requêtes ayant obtenu de meilleurs résultats sur la cible 2 que sur la cible 1.

- Impossible d’évaluer: requêtes dont la taille d’échantillon était trop petite pour l’analyse statistique. Pour l’analyse des tests A/B, DEA nécessite que les mêmes requêtes aient au moins 15 exécutions sur chaque cible.

- même: requêtes qui n’ont aucune différence statistique entre la cible 1 et la cible 2.

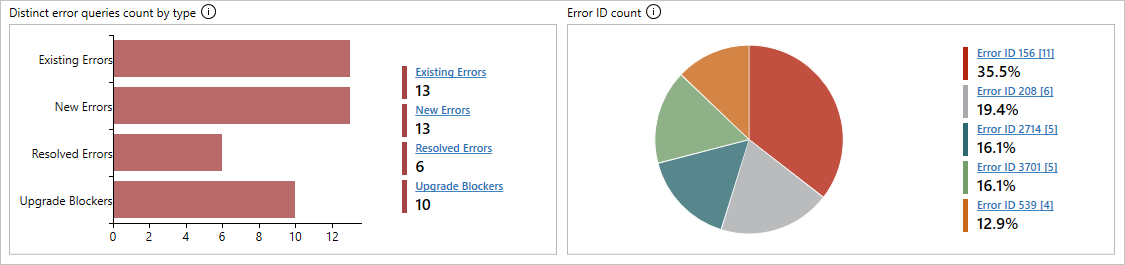

Les requêtes d’erreur, le cas échéant, sont affichées dans des graphiques distincts ; un graphique à barres classifie les erreurs par type et un graphique en secteurs classifie les erreurs par ID d’erreur.

Il existe quatre types d’erreurs possibles :

- erreurs existantes: erreurs qui existent à la fois sur la cible 1 et la cible 2.

- nouvelles erreurs: erreurs nouvelles sur la cible 2.

- erreurs résolues: erreurs qui existent sur la cible 1, mais qui sont résolues sur la cible 2.

- bloqueurs de mise à niveau: erreurs qui bloquent la mise à niveau vers le serveur cible.

La sélection d'une barre ou d'une section de secteurs dans les graphiques explore la catégorie et affiche les métriques de performance, même pour la catégorie Ne peut pas évaluer.

En outre, le tableau de bord affiche les cinq premières requêtes améliorées et détériorées pour fournir une vue d’ensemble rapide des performances.

Analyse détaillée des requêtes individuelles

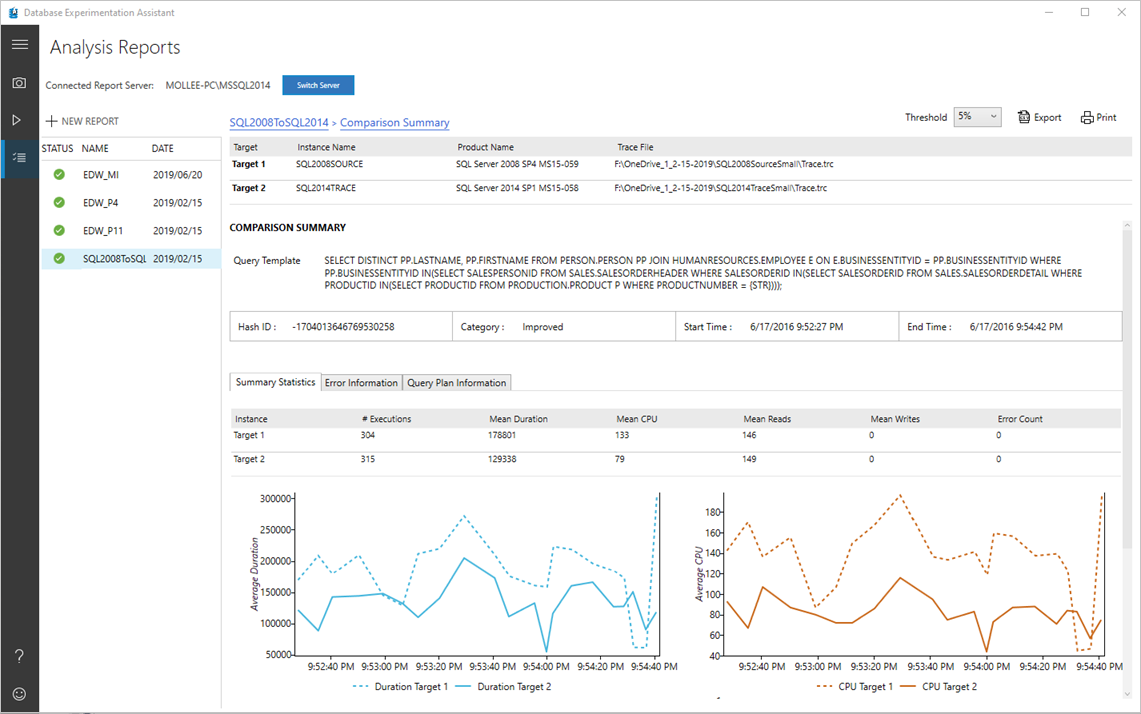

Vous pouvez sélectionner des liens de modèle de requête pour obtenir des informations plus détaillées sur des requêtes spécifiques.

Sélectionnez une requête spécifique pour ouvrir le résumé de comparaison associé.

Vous trouverez des statistiques récapitulatives pour cette requête, telles que le nombre d’exécutions, la durée moyenne, l’UC moyenne, les lectures/écritures moyennes et le nombre d’erreurs. Si la requête est une requête d’erreur, l’onglet Informations d’erreur affiche plus de détails sur l’erreur. Sous l’onglet Informations sur le plan de requête, vous trouverez des informations sur les plans de requête utilisés pour la requête sur la cible 1 et la cible 2.

Remarque

Si vous analysez des fichiers d'événements étendus (.XEL), les informations relatives au plan de requête ne sont pas collectées pour limiter la pression sur la mémoire de l'ordinateur de l'utilisateur.