Utilisation d’Azure Machine Learning Notebook sur Spark

Important

Azure HDInsight sur AKS a été mis hors service le 31 janvier 2025. Découvrez-en plus avec cette annonce.

Vous devez migrer vos charges de travail vers Microsoft Fabric ou un produit Azure équivalent pour éviter l’arrêt brusque de vos charges de travail.

Important

Cette fonctionnalité est actuellement en préversion. Les Conditions d’utilisation supplémentaires pour les préversions Microsoft Azure incluent des termes juridiques supplémentaires qui s’appliquent aux fonctionnalités Azure en version bêta, en préversion ou qui ne sont pas encore publiées en disponibilité générale. Pour plus d’informations sur cette préversion spécifique, consultez informations sur Azure HDInsight sur AKS en préversion. Pour des questions ou des suggestions de fonctionnalités, envoyez une demande sur AskHDInsight avec les détails et suivez-nous pour plus de mises à jour sur Communauté Azure HDInsight.

Le Machine Learning est une technologie croissante, qui permet aux ordinateurs d’apprendre automatiquement à partir de données passées. Le Machine Learning utilise différents algorithmes pour créer des modèles mathématiques et effectuer des prédictions à l’aide de données ou d’informations historiques. Nous avons un modèle défini jusqu’à certains paramètres et l’apprentissage est l’exécution d’un programme informatique pour optimiser les paramètres du modèle à l’aide des données d’entraînement ou de l’expérience. Le modèle peut être prédictif pour effectuer des prédictions à l’avenir, ou descriptif pour acquérir des connaissances à partir de données.

Le carnet du tutoriel suivant montre un exemple d'entraînement de modèles d'apprentissage automatique sur des données tabulaires. Vous pouvez importer ce notebook et l’exécuter vous-même.

Charger le fichier CSV dans votre stockage

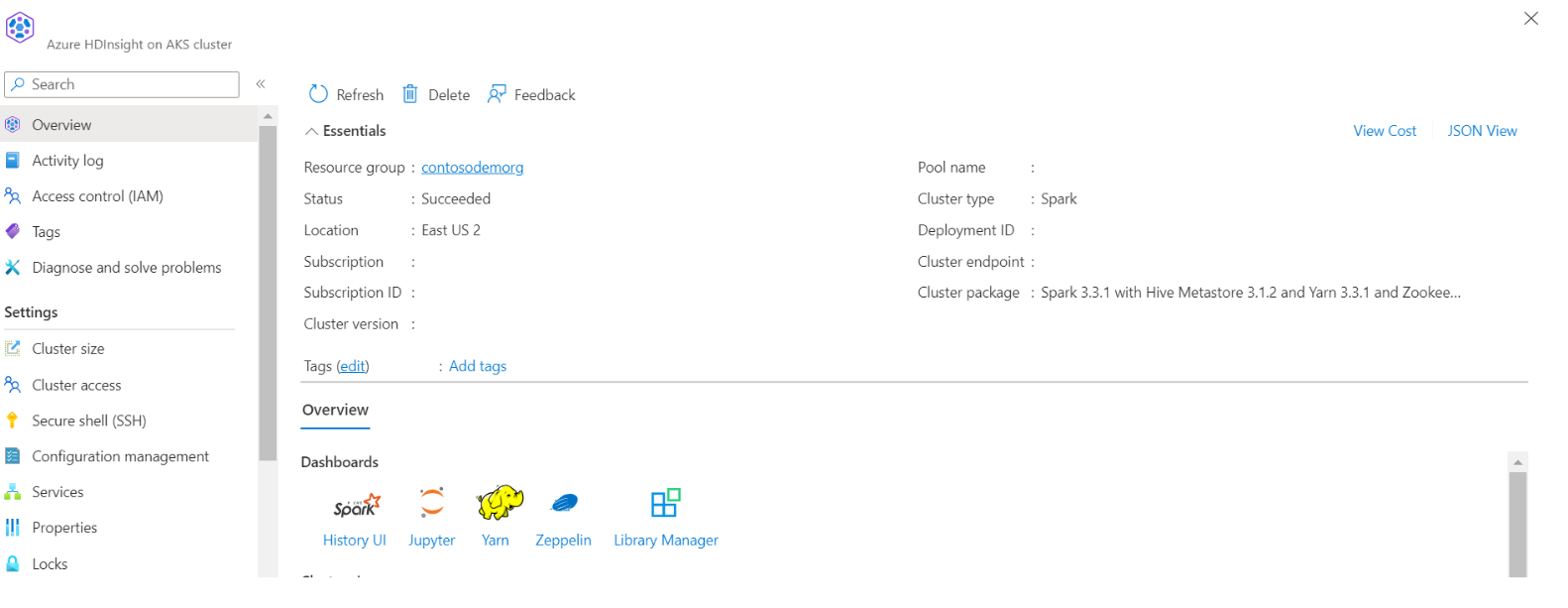

Rechercher votre nom de stockage et de conteneur dans la vue JSON du portail

Accédez à votre dossier de base>de stockage HDI principal>dossier de base> charger le CSV

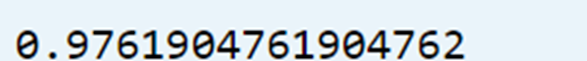

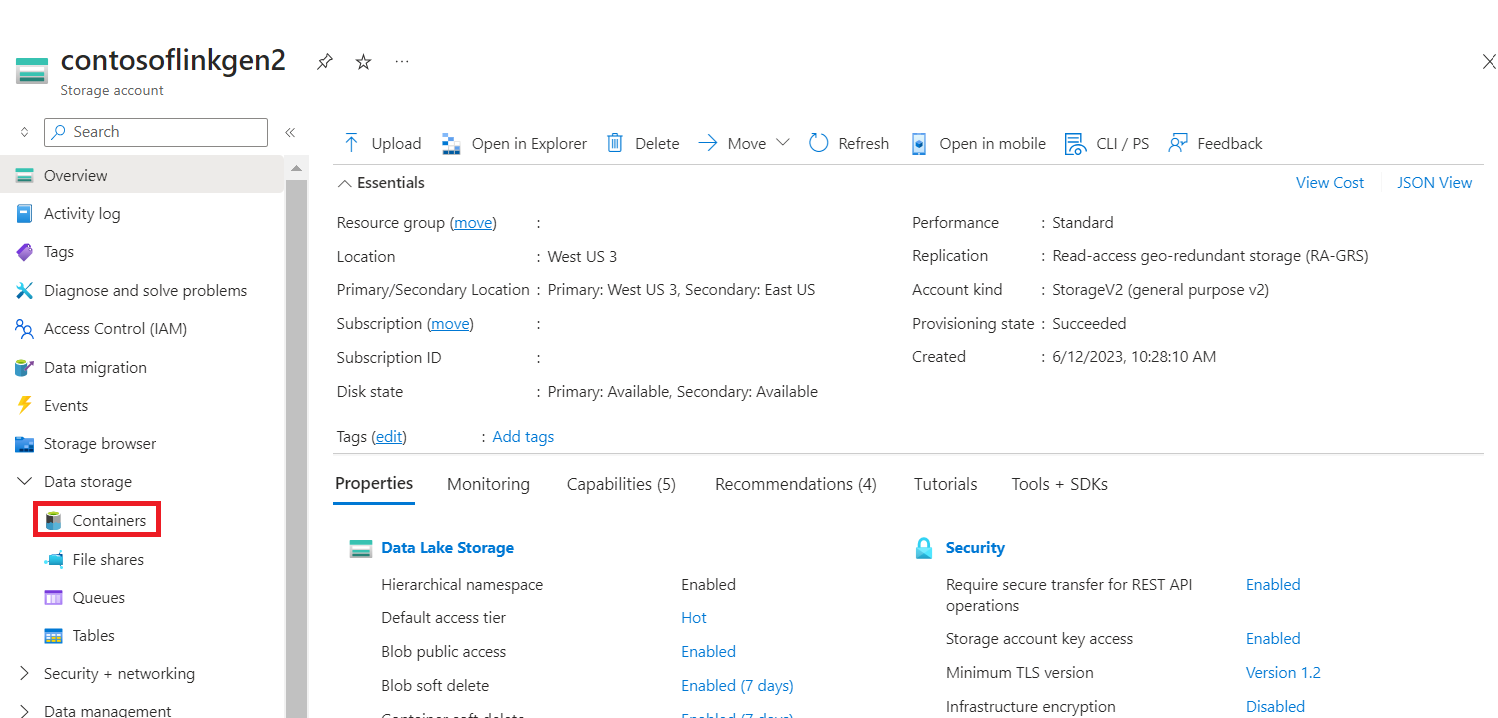

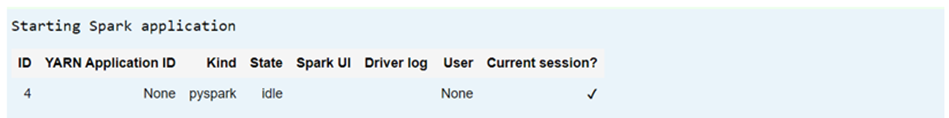

Connectez-vous à votre cluster et ouvrez le bloc-notes Jupyter

Importer des bibliothèques MLlib Spark pour créer le pipeline

import pyspark from pyspark.ml import Pipeline, PipelineModel from pyspark.ml.classification import LogisticRegression from pyspark.ml.feature import VectorAssembler, StringIndexer, IndexToString

Lire le fichier CSV dans un dataframe Spark

df = spark.read.("abfss:///iris_csv.csv",inferSchema=True,header=True)Fractionner les données pour l’entraînement et les tests

iris_train, iris_test = df.randomSplit([0.7, 0.3], seed=123)Créer le pipeline et entraîner le modèle

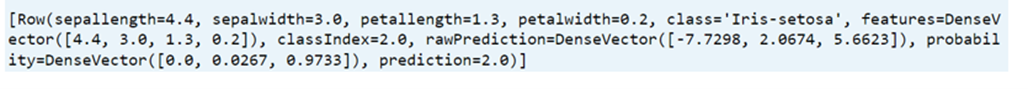

assembler = VectorAssembler(inputCols=['sepallength', 'sepalwidth', 'petallength', 'petalwidth'],outputCol="features",handleInvalid="skip") indexer = StringIndexer(inputCol="class", outputCol="classIndex", handleInvalid="skip") classifier = LogisticRegression(featuresCol="features", labelCol="classIndex", maxIter=10, regParam=0.01) pipeline = Pipeline(stages=[assembler,indexer,classifier]) model = pipeline.fit(iris_train) # Create a test `dataframe` with predictions from the trained model test_model = model.transform(iris_test) # Taking an output from the test dataframe with predictions test_model.take(1)

Évaluer la précision du modèle

import pyspark.ml.evaluation as ev evaluator = ev.MulticlassClassificationEvaluator(labelCol='classIndex') print(evaluator.evaluate(test_model,{evaluator.metricName: 'accuracy'}))