Ajouter une source Kafka Confluent à un Eventstream

Cet article vous montre comment ajouter une source Confluent Kafka à un Eventstream.

Confluent Cloud Kafka est une plateforme de diffusion en continu offrant de puissantes fonctionnalités de diffusion en continu et de traitement des données à l’aide d’Apache Kafka. Grâce à l’intégration de Confluent Cloud Kafka en tant que source au sein de votre Eventstreams, vous pouvez traiter en toute transparence les flux de données en temps réel avant de les router vers plusieurs destinations au sein de Fabric.

Remarque

Cette source n'est pas prise en charge dans les régions suivantes de votre espace de travail : Ouest US3, Suisse Ouest.

Prérequis

- Accès à un espace de travail en mode licence de capacité Fabric ou en mode licence d’évaluation avec des autorisations Collaborateur ou supérieures.

- Un cluster Kafka Cloud Confluent et une clé API.

- Votre cluster Confluent Cloud Kafka doit être accessible publiquement et non derrière un pare-feu ou sécurisé dans un réseau virtuel.

- Créez un eventstream, si vous n’en avez pas déjà.

Lancer l’assistant Sélectionner une source de données

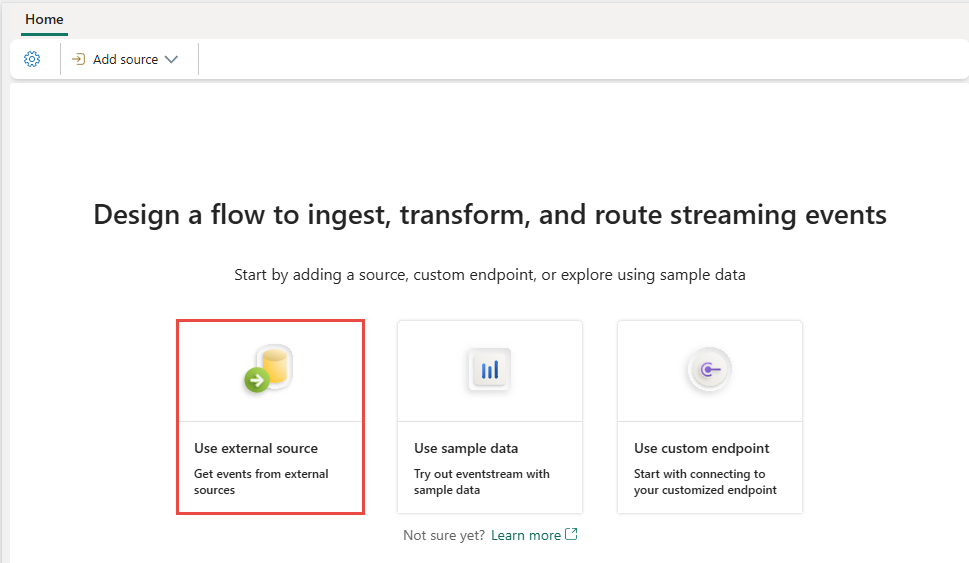

Si vous n’avez pas encore ajouté de source à votre flux d’événements, sélectionnez la vignette Utiliser une source externe.

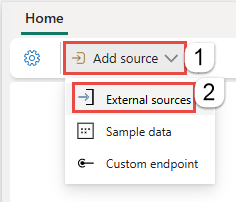

Si vous ajoutez la source à un flux d’événements déjà publié, basculez vers le mode Édition, sélectionnez Ajouter une source dans le ruban, puis sélectionnez Sources externes.

Configurer Confluent Kafka et s’y connecter

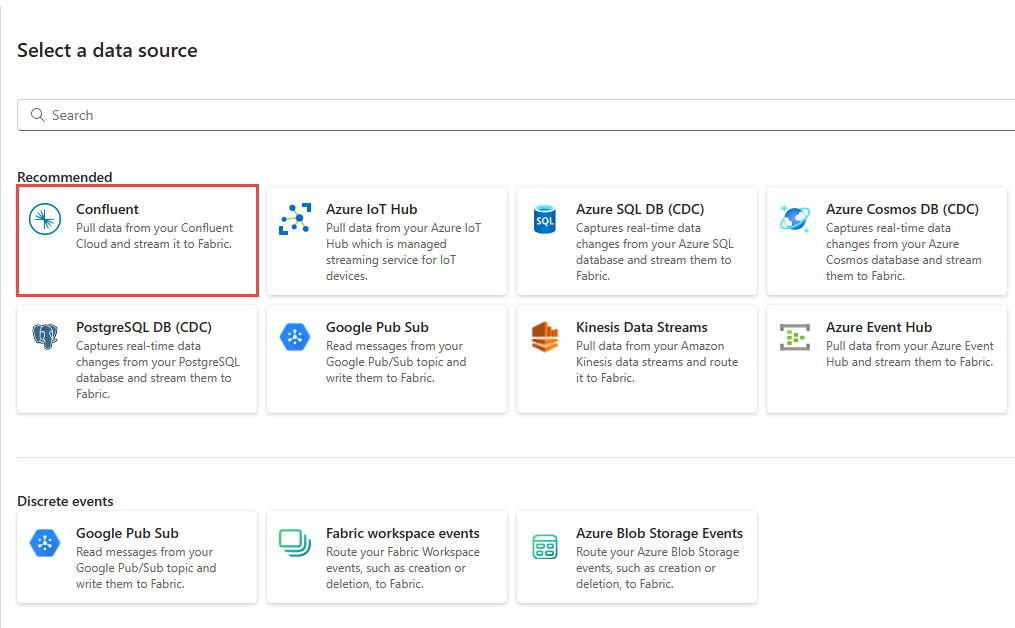

Dans la page Sélectionner une source de données, sélectionnez Confluent.

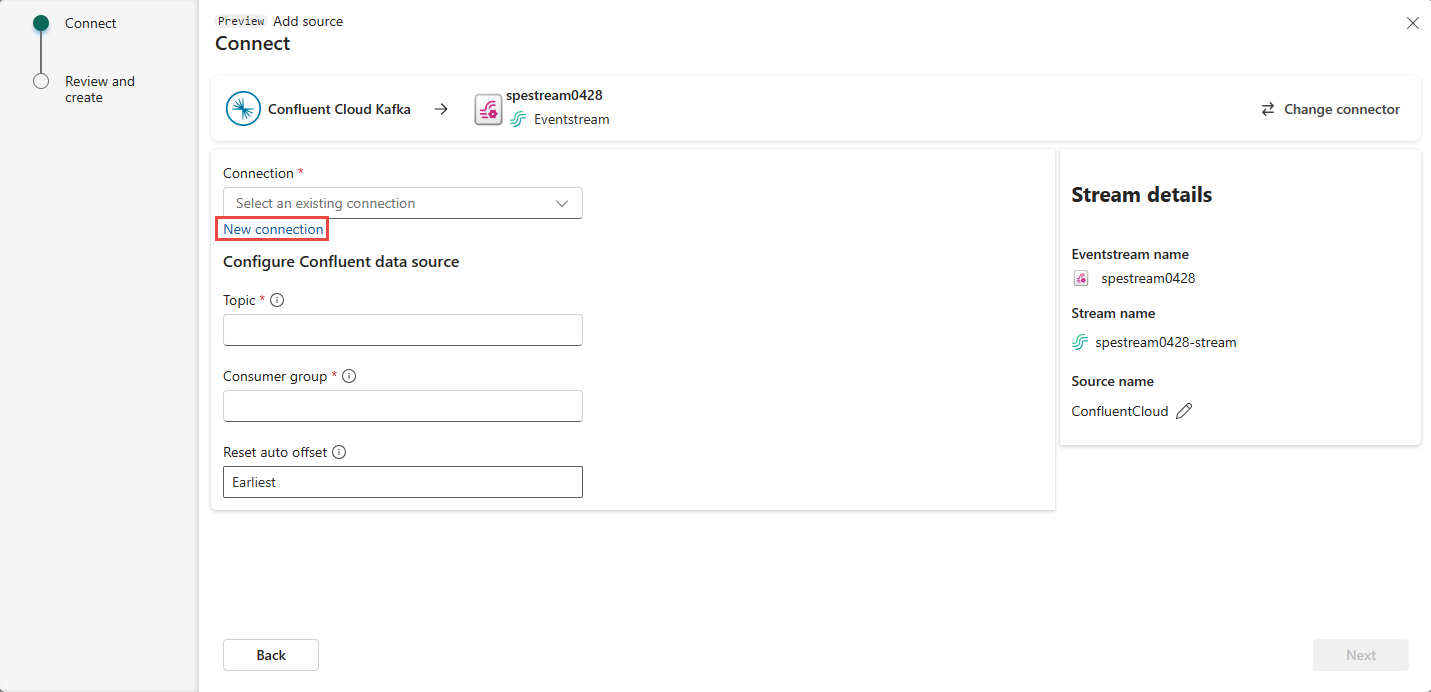

Pour créer une connexion à la source Confluent Cloud Kafka, sélectionnez Nouvelle connexion.

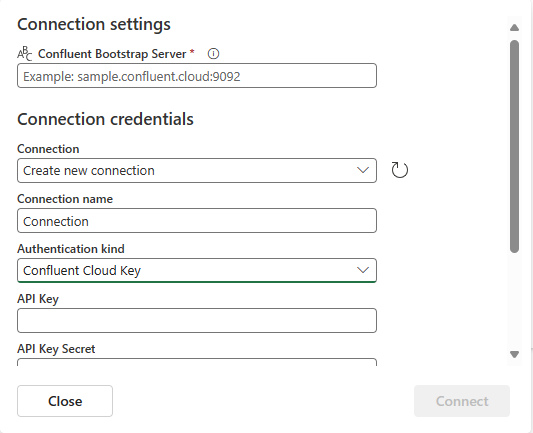

Dans la section paramètres de Connecter ion, saisissez Confluent Bootstrap Server. Accédez à votre page d’accueil Confluent Cloud, sélectionnez Paramètres du groupement, puis copiez l’adresse sur votre serveur Bootstrap.

Dans la section identifiants de connexion, si vous disposez d’une connexion existante au cluster Confluent, sélectionnez-la dans la liste déroulante pour Connexion. Dans le cas contraire, procédez ainsi :

- Dans le champ Nom de la connexion, saisissez un nom pour la connexion.

- Pour le type d’authentification, vérifiez que la clé cloud Confluent est sélectionnée.

- Pour la clé API et le secret de clé API :

Accédez à votre cloud Confluent.

Sélectionnez Clés API dans le menu latéral.

Sélectionnez le bouton Ajouter clé pour créer une clé API.

Copiez la clé API et Secret.

Collez ces valeurs dans les champs Clé API et Clé secrète API.

Sélectionnez Se connecter.

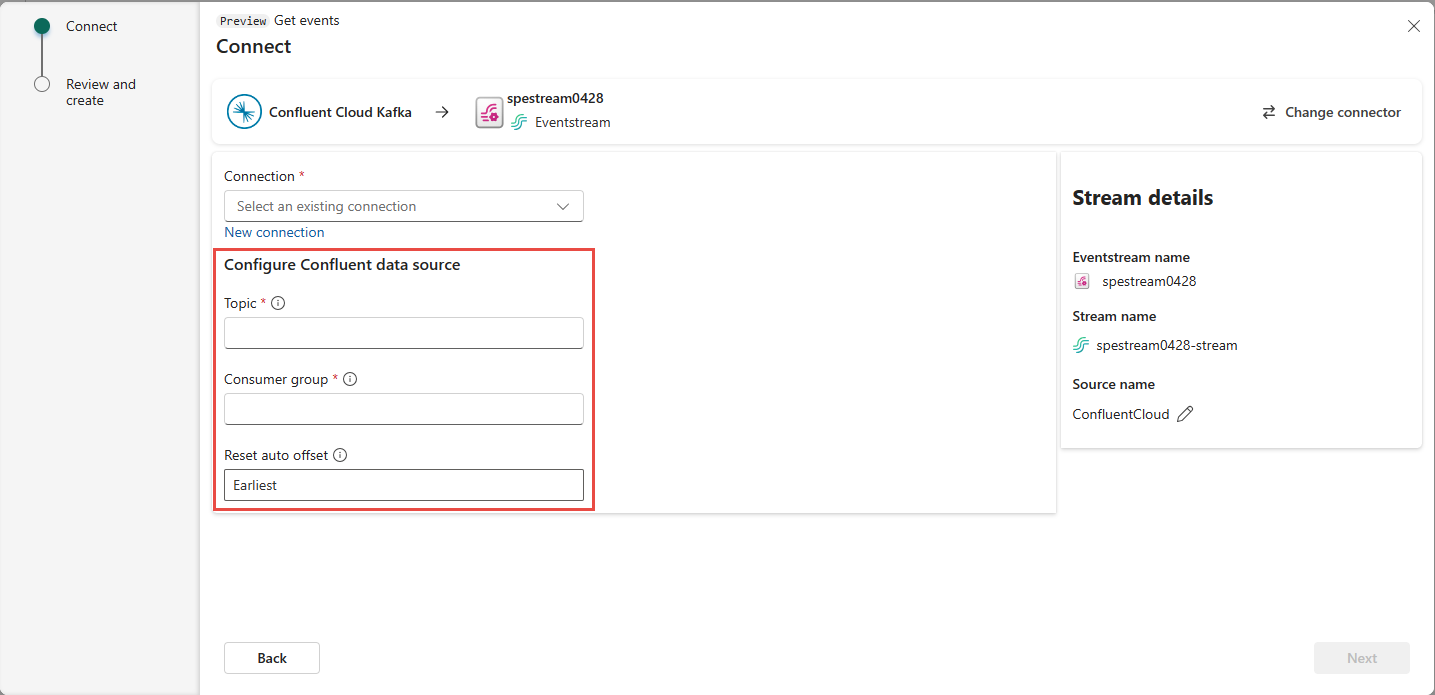

Faites défiler pour afficher la section Configurer la source de données Confluent sur la page. Entrez les informations pour terminer la configuration de la source de données Confluent.

- Pour Sujet, saisissez un nom de sujet à partir de votre cloud Confluent. Vous pouvez créer ou gérer votre sujet dans la console Cloud Confluent.

- Dans le champ Groupe de consommateurs, saisissez un groupe de consommateurs de votre cloud Confluent. Il vous fournit le groupe de consommateurs dédié pour obtenir les événements à partir du cluster Confluent Cloud.

- Pour le paramètre Réinitialiser le décalage automatique, sélectionnez l’une des valeurs suivantes :

Plus tôt : les données les plus anciennes disponibles à partir de votre cluster Confluent

Dernière version : les données disponibles les plus récentes

Aucun : ne définissez pas automatiquement le décalage.

Cliquez sur Suivant. Dans l’écran Vérifier et créer, passez en revue le résumé, puis sélectionnez Ajouter.

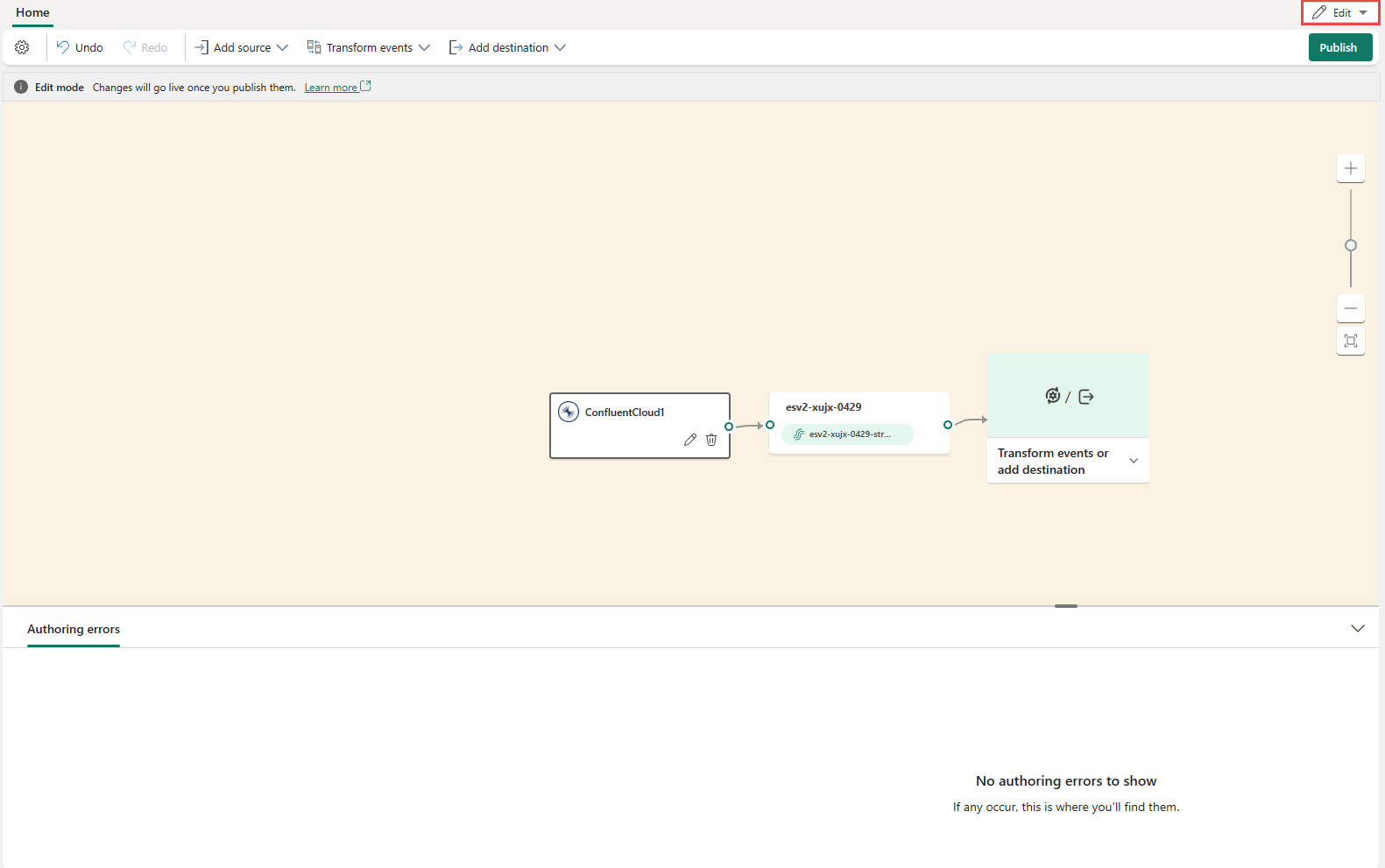

Vous voyez que la source Confluent Cloud Kafka est ajoutée à votre Eventstream sur l’espace en mode Édition. Pour implémenter cette source Confluent Cloud Kafka nouvellement ajoutée, sélectionnez Publier sur le ruban.

Une fois ces étapes terminées, la source Kafka du cloud Confluent est disponible pour la visualisation en affichage direct.

Limites

- Confluent Kafka avec des formats JSON et Avro, à l’aide du registre de schémas, n’est actuellement pas pris en charge.

- Le décodage des données de Confluent Kafka à l’aide du Registre de schémas Confluent n’est actuellement pas pris en charge.

Remarque

Le nombre maximal de sources et de destinations pour un flux d’événements est de 11.

Contenu connexe

Autres connecteurs :

- Flux de données Amazon Kinesis

- Azure Cosmos DB

- Azure Event Hubs

- Azure IoT Hub

- Capture des changements de données (CDC) de la base de données Azure SQL

- Point de terminaison personnalisé

- Google Cloud Pub/Sub

- CDC de la base de données MySQL

- CDC de la base de données PostgreSQL

- Exemples de données

- Événements de Stockage Blob Azure

- Événement d’espace de travail Fabric