Guide pratique pour évaluer des modèles dans Azure AI Foundry

Important

Les éléments marqués (préversion) dans cet article sont actuellement en préversion publique. Cette préversion est fournie sans contrat de niveau de service, nous la déconseillons dans des charges de travail de production. Certaines fonctionnalités peuvent être limitées ou non prises en charge. Pour plus d’informations, consultez Conditions d’Utilisation Supplémentaires relatives aux Évaluations Microsoft Azure.

Dans cet article, vous allez apprendre à comparer des benchmarks sur des modèles et des jeux de données, à l’aide de l’outil Benchmarks de modèles dans le portail Azure AI Foundry. Vous apprendrez également à analyser les résultats de benchmarking et à effectuer du benchmarking avec vos données. Le benchmarking peut vous aider à prendre des décisions éclairées sur les modèles qui répondent aux exigences de votre application ou cas d’utilisation particulier.

Prérequis

Un abonnement Azure avec un moyen de paiement valide. Les abonnements Azure gratuits ou d’essai ne fonctionnent pas. Si vous ne disposez pas d’un abonnement Azure, commencez par créer un compte Azure payant.

Accéder aux Benchmarks de modèle via le catalogue de modèles

Azure AI prend en charge le benchmarking des modèles pour les modèles sélectionnés qui sont populaires et les plus fréquemment utilisés. Suivez ces étapes pour utiliser des résultats de benchmarking détaillés afin de comparer et sélectionner des modèles directement dans le catalogue de modèles Azure AI Foundry :

- Connectez-vous à Azure AI Foundry.

- Si vous n’êtes pas déjà dans votre projet, sélectionnez-le.

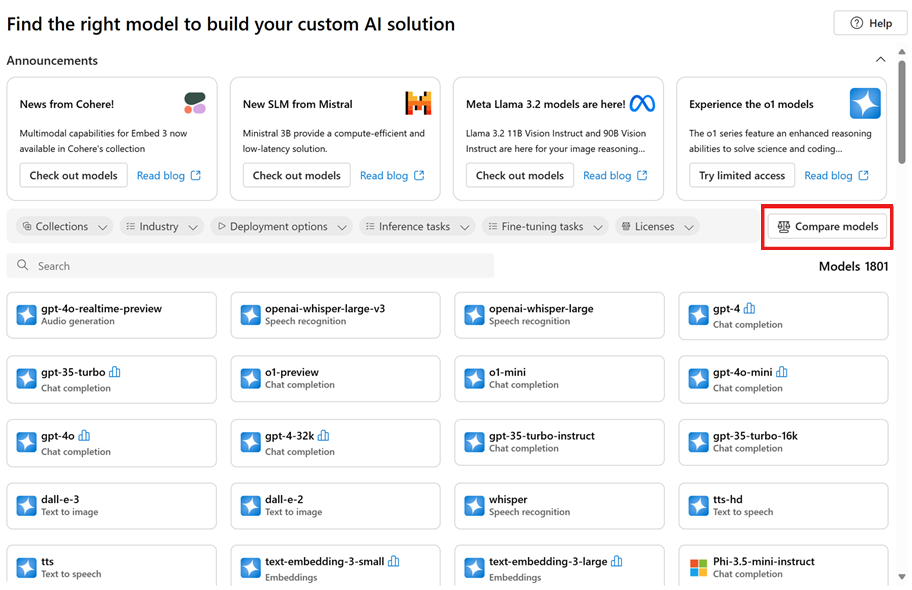

- Sélectionnez Catalogue de modèles dans le volet de navigation gauche.

Sélectionnez le modèle qui vous intéresse. Par exemple, sélectionnez gpt-4o. Cette action ouvre la page de vue d’ensemble du modèle.

Conseil

Dans le catalogue de modèles, vous pouvez afficher les modèles qui ont un benchmarking disponible à l’aide du filtre Collections et en sélectionnant Résultats du benchmark. Ces modèles ont une icône Benchmarks qui ressemble à un histogramme.

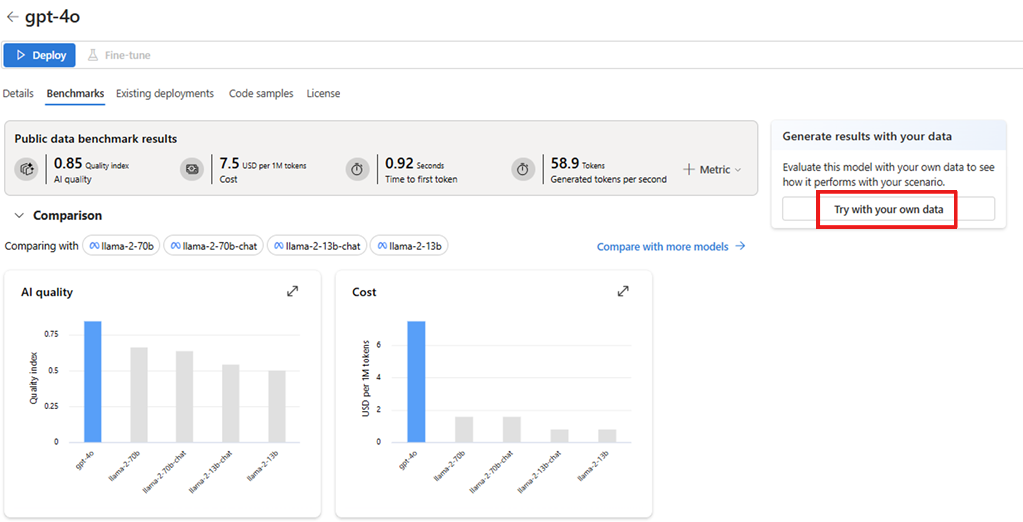

Accédez à l’onglet Benchmarks pour vérifier les résultats du benchmark pour le modèle.

Revenez à la page d’accueil du catalogue de modèles.

Sélectionnez Comparer les modèles sur la page d’accueil du catalogue de modèles pour explorer les modèles avec prise en charge du benchmark, afficher leurs métriques et analyser les compromis entre différents modèles. Cette analyse peut vous aider à choisir le modèle qui répond le mieux à vos besoins.

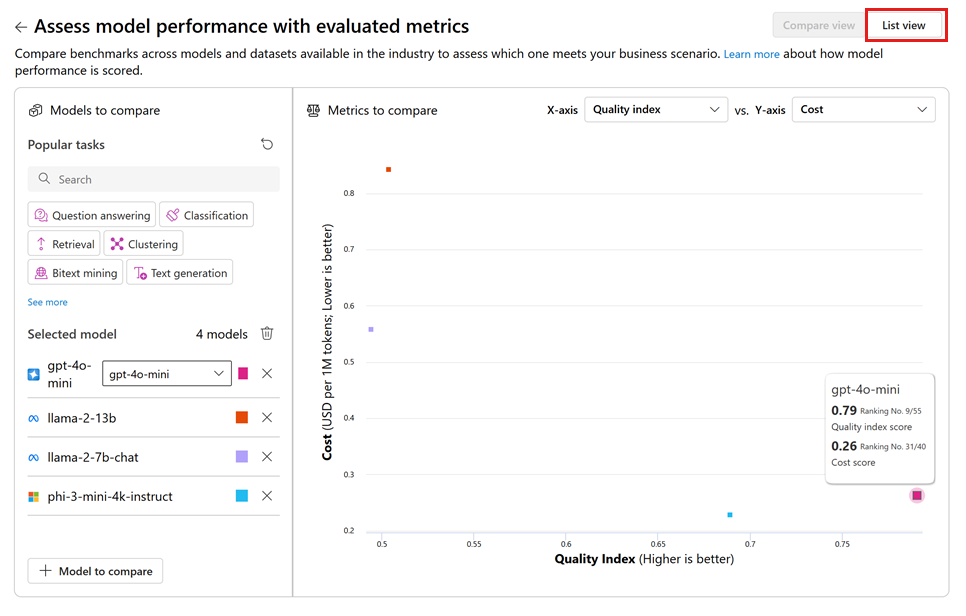

Sélectionnez les tâches souhaitées et spécifiez les dimensions pertinentes, telles que la Qualité de l’IA par rapport au Coût, afin d’évaluer les compromis entre les différents modèles.

Vous pouvez basculer vers le mode Liste pour accéder à des résultats plus détaillés pour chaque modèle.

Analyser les résultats du benchmark

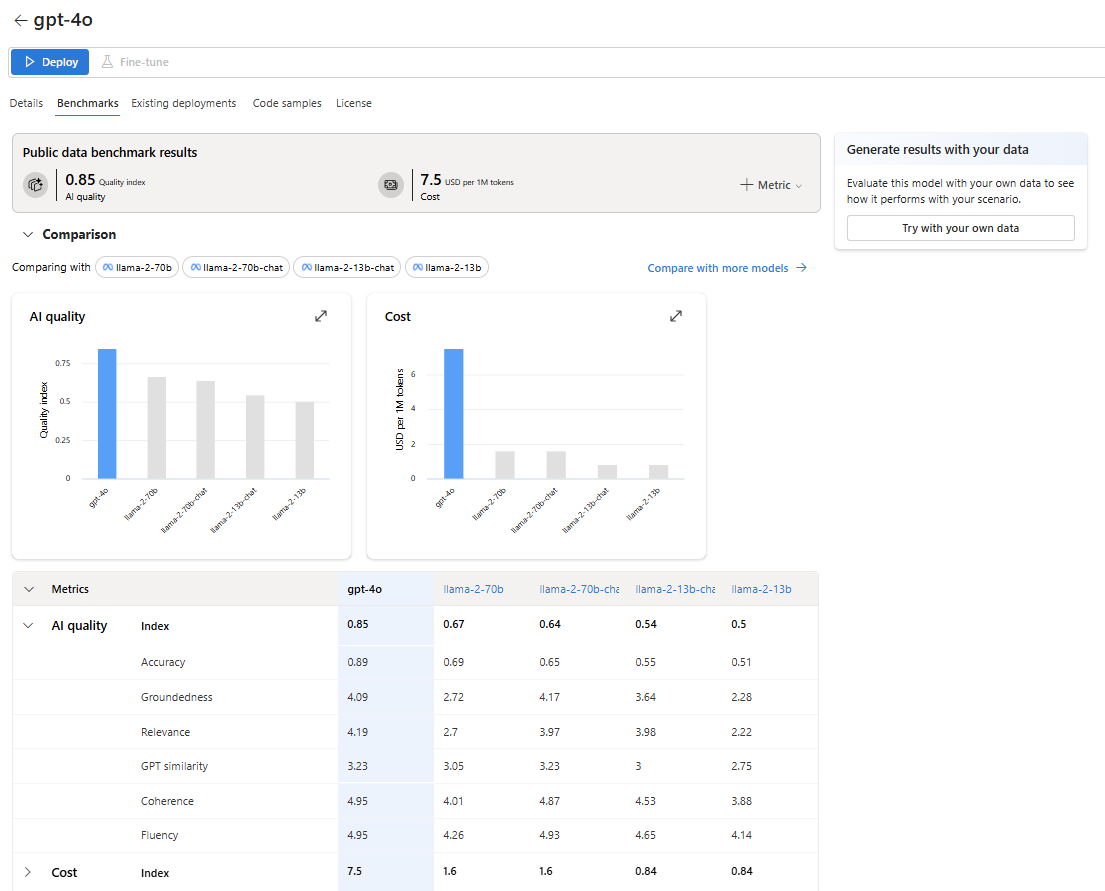

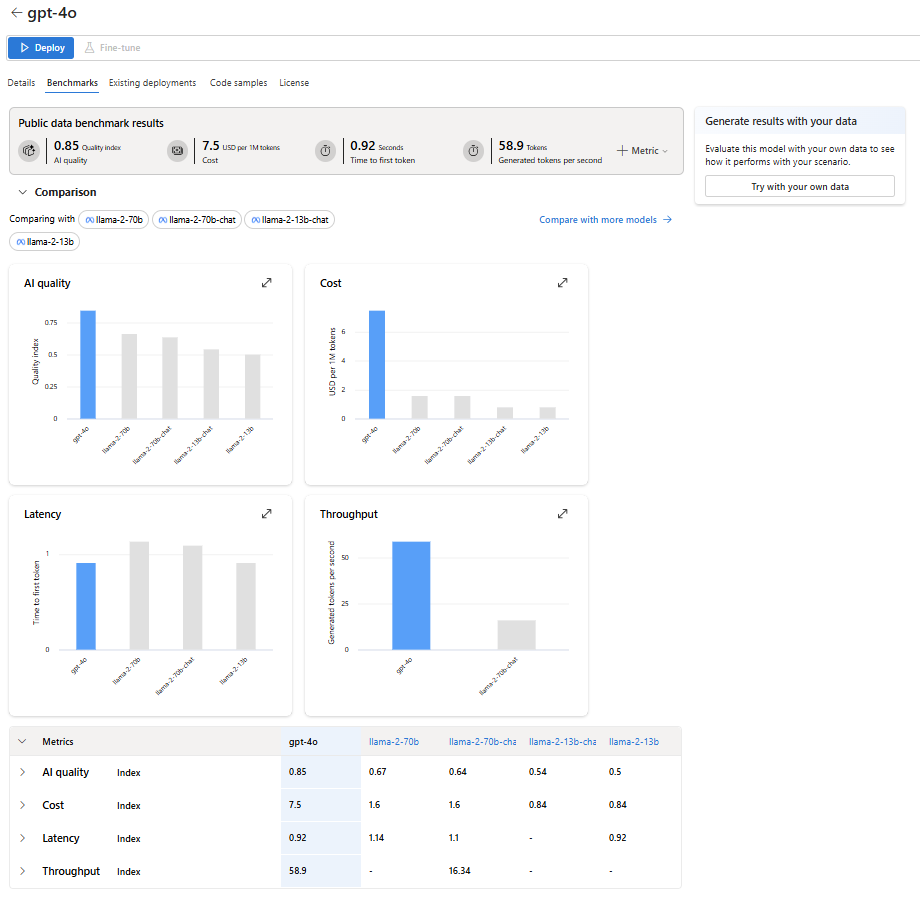

Lorsque vous êtes dans l’onglet « Benchmarks » pour un modèle spécifique, vous pouvez collecter des informations détaillées pour mieux comprendre et interpréter les résultats du benchmark, notamment :

Scores d’agrégation de haut niveau : ces scores pour la qualité de l’IA, le coût, la latence et le débit donnent un aperçu rapide des performances du modèle.

Graphiques comparés : ces graphiques affichent la position relative du modèle par rapport aux modèles connexes.

Tableau de comparaison des métriques : ce tableau présente des résultats détaillés pour chaque métrique.

Par défaut, Azure AI Foundry affiche un indice moyen sur différentes métriques et jeux de données pour fournir une vue d’ensemble générale des performances du modèle.

Pour accéder aux résultats du benchmark pour une métrique et un jeu de données spécifiques :

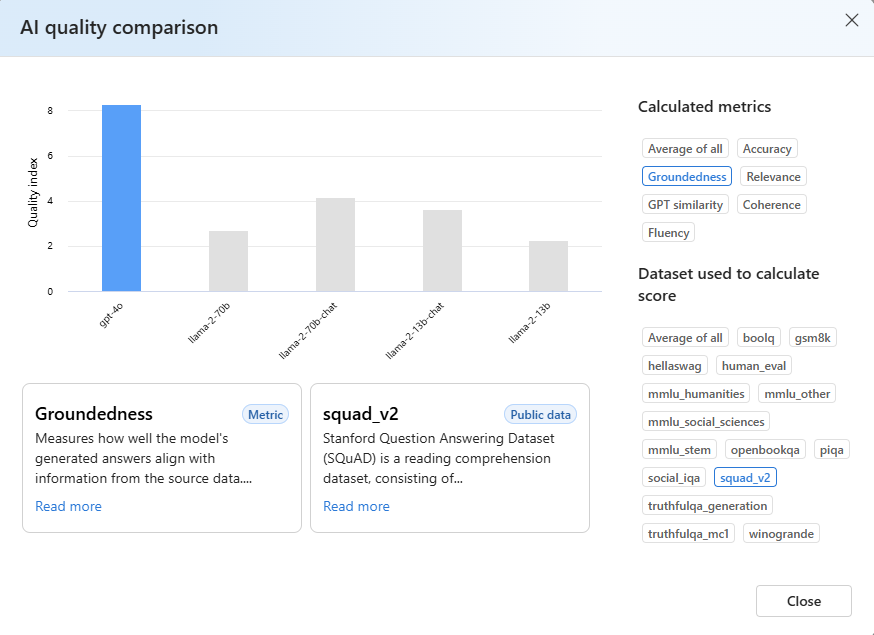

Sélectionnez le bouton Développer sur le graphique. La fenêtre contextuelle du graphique de comparaison révèle des informations détaillées et offre une plus grande flexibilité pour la comparaison.

Sélectionnez la métrique qui vous intéresse et choisissez différents jeux de données, en fonction de votre scénario spécifique. Pour obtenir des définitions plus détaillées des métriques et des descriptions des jeux de données publics utilisés pour calculer les résultats, sélectionnez En savoir plus.

Évaluer les résultats du benchmark avec vos données

Les sections précédentes ont montré les résultats de benchmark calculés par Microsoft, à l’aide de jeux de données publics. Toutefois, vous pouvez essayer de régénérer le même ensemble de métriques avec vos données.

Revenez à l’onglet Benchmarks de la carte du modèle.

Sélectionnez Essayer avec vos propres données pour évaluer le modèle avec vos données. L’évaluation sur vos données vous aide à voir comment le modèle s’exécute dans vos scénarios particuliers.