Mise à niveau de Modèles GitHub vers l’inférence de modèle Azure AI

Si vous souhaitez développer une application d’IA générative, vous pouvez utiliser des Modèles GitHub pour rechercher et expérimenter gratuitement des modèles IA. L’utilisation de l’API gratuite et le terrain de jeu sont limités en débit par les requêtes par minute, les requêtes par jour, les jetons par requête et les requêtes simultanées. En cas de limitation du débit, vous devrez attendre la réinitialisation de la limite de débit atteinte avant de pouvoir effectuer d’autres requêtes.

Une fois prêt pour passer votre application en production, vous pouvez mettre à jour votre expérience en déployant une ressource Azure AI Services dans un abonnement Azure et commencer à utiliser le service d’inférence de modèle Azure AI. Vous n’avez pas besoin de modifier quoi que ce soit d’autre dans votre code.

L’article suivant explique comment bien démarrer à partir de Modèles GitHub et déployer une ressource Azure AI Services avec l’inférence de modèle Azure AI.

Prérequis

Pour terminer ce tutoriel, vous avez besoin de ce qui suit :

- Un compte GitHub avec accès aux Modèles GitHub.

- Un abonnement Azure. Si vous n’en avez pas, il vous sera demandé d’en créer un ou de mettre à jour votre compte Azure vers un compte avec paiement au fur et à mesure lorsque vous êtes prêt à déployer votre modèle vers la production.

Mise à niveau vers l’inférence de modèle Azure AI

Les limites de débit pour le terrain de jeu et l’utilisation gratuite de l’API sont destinées à vous aider à expérimenter des modèles et à développer votre application IA. Une fois que vous êtes prêt à passer votre application en production, utilisez une clé et un point de terminaison à partir d’un compte Azure payant. Vous n’avez pas besoin de modifier quoi que ce soit d’autre dans votre code.

Pour obtenir la clé et le point de terminaison :

Accédez à Modèles GitHub et sélectionnez le modèle qui vous intéresse.

Dans le terrain de jeu de votre modèle, sélectionnez Obtenir la clé API.

Sélectionnez Obtenir la clé de production.

Si vous n’avez pas de compte Azure, sélectionnez Créer mon compte et suivez les étapes pour en créer un.

Si vous avez un compte Azure, sélectionnez Se reconnecter.

Si votre compte existant est gratuit, vous devez d’abord mettre à niveau vers un plan avec paiement au fur et à mesure. Après votre mise à niveau, revenez au terrain de jeu, puis sélectionnez Obtenir la clé API à nouveau, puis connectez-vous à l’aide de votre compte mis à niveau.

Une fois connecté à votre compte Azure, vous êtes dirigé vers Azure AI Studio > GitHub. Le chargement des détails de votre modèle initial dans AI Studio peut prendre une ou deux minutes.

La page est chargée avec les détails de votre modèle. Sélectionnez le bouton Déployer pour déployer le modèle sur votre compte.

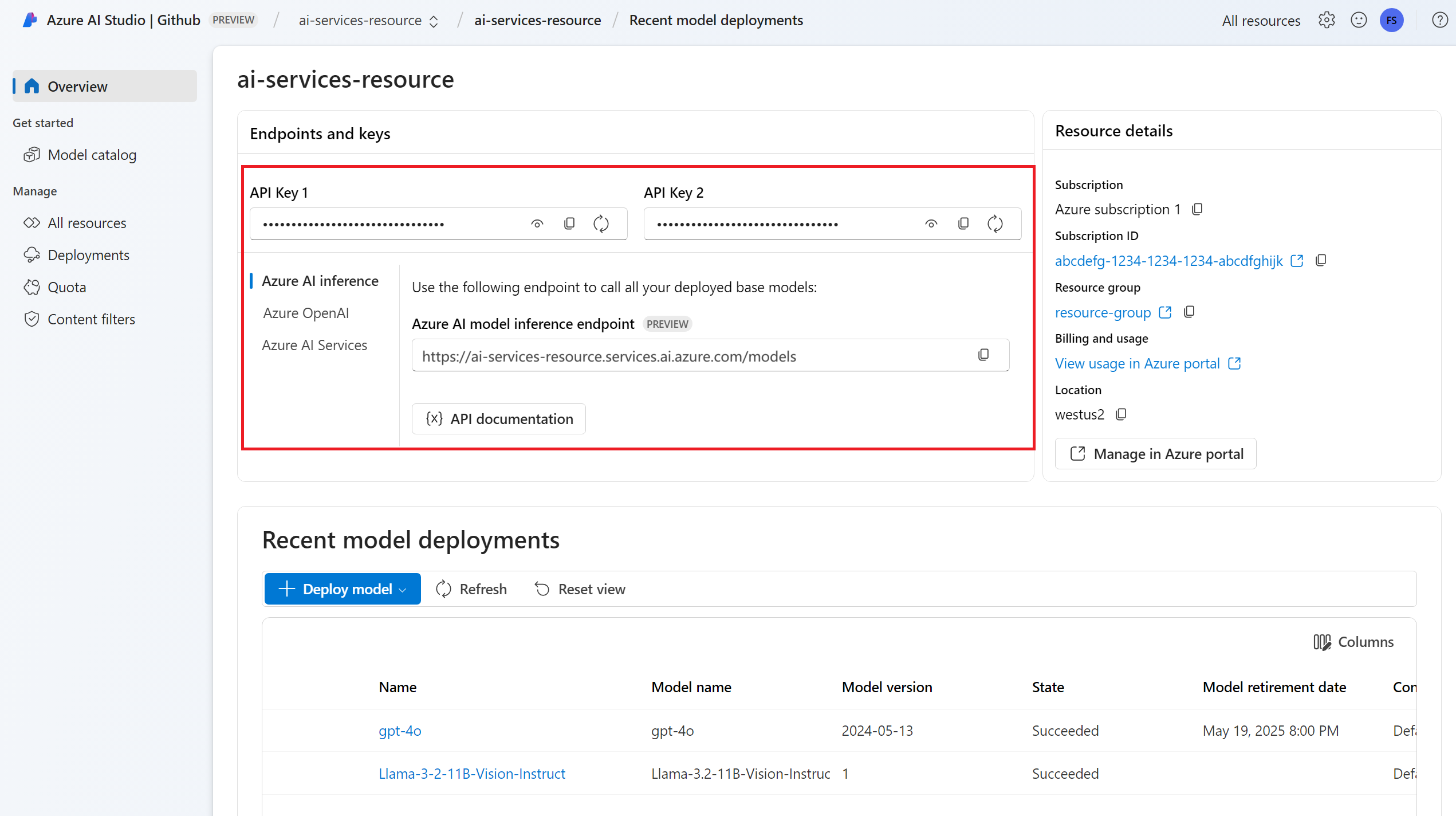

Une fois déployé, le point de terminaison et la clé API de votre modèle s’affichent dans la Vue d’ensemble. Utilisez ces valeurs dans votre code pour utiliser le modèle dans votre environnement de production.

À ce stade, le modèle sélectionné est prêt à l’emploi.

Mise à niveau de votre code pour utiliser le nouveau point de terminaison

Une fois votre ressource Azure AI Services configurée, vous pouvez commencer à l’utiliser à partir de votre code. Pour utiliser la ressource Azure AI Services, vous avez besoin de l’URL et de la clé du point de terminaison, qui sont disponibles dans la section Vue d’ensemble :

Vous pouvez utiliser l’un des Kits de développement logiciel (SDK) pris en charge pour obtenir des prédictions à partir du point de terminaison. Les Kits de développement logiciel (SDK) suivants sont officiellement pris en charge :

- Kit de développement logiciel (SDK) OpenAI

- SDK Azure OpenAI

- Kit de développement logiciel (SDK) Inférence Azure AI

Consultez la section Kits de développement logiciel (SDK) et langages pris en charge pour découvrir plus de détails et des exemples. L’exemple suivant montre comment utiliser le Kit de développement logiciel (SDK) d’inférence de modèle Azure AI avec le modèle nouvellement déployé :

Installez le package azure-ai-inference à l’aide de votre gestionnaire de package, par exemple pip :

pip install azure-ai-inference>=1.0.0b5

Avertissement

La ressource Azure AI Services nécessite la version azure-ai-inference>=1.0.0b5 de Python.

Vous pouvez ensuite utiliser le package pour consommer le modèle. L’exemple suivant montre comment créer un client pour consommer les complétions de conversation :

import os

from azure.ai.inference import ChatCompletionsClient

from azure.core.credentials import AzureKeyCredential

model = ChatCompletionsClient(

endpoint="https://<resource>.services.ai.azure.com/models",

credential=AzureKeyCredential(os.environ["AZUREAI_ENDPOINT_KEY"]),

)

Découvrez nos exemples, et lisez la documentation de référence API pour vous lancer.

Générez votre première saisie semi-automatique de conversation :

from azure.ai.inference.models import SystemMessage, UserMessage

response = client.complete(

messages=[

SystemMessage(content="You are a helpful assistant."),

UserMessage(content="Explain Riemann's conjecture in 1 paragraph"),

],

model="mistral-large"

)

print(response.choices[0].message.content)

Utilisez le paramètre model="<deployment-name> pour acheminer votre requête vers ce déploiement. Les déploiements fonctionnent en tant qu’alias d’un modèle donné sous certaines configurations. Consultez la page sur le concept de Routage pour découvrir comment Azure AI Services achemine des déploiements.

Important

Contrairement aux modèles GitHub où tous les modèles sont déjà configurés, la ressource Azure AI Services vous permet de contrôler les modèles disponibles dans votre point de terminaison et sous quelle configuration. Ajoutez autant de modèles que vous envisagez d’utiliser avant de les indiquer dans le paramètre model. Découvrez comment ajouter d’autres modèles à votre ressource.

Explorer des fonctionnalités supplémentaires

L’inférence de modèle Azure AI prend en charge d’autres fonctionnalités non disponibles dans Modèles GitHub, notamment :

- Explorez le catalogue de modèles pour voir d’autres modèles non disponibles dans Modèles GitHub.

- Configurer le filtrage de contenu.

- Configurer la limitation de débit (pour des modèles spécifiques).

- Explorez des références SKU de déploiement supplémentaires (pour des modèles spécifiques).

- Configurer une mise en réseau privée.

Rencontrez-vous des problèmes ?

Consultez la section FAQ pour découvrir davantage d’aide en ligne.

Étapes suivantes

- Explorez le catalogue de modèles dans Azure AI Studio.

- Ajoutez d’autres modèles à votre point de terminaison.