Tietojen muuntaminen Apache Sparkin ja kyselyn avulla SQL:llä

Tässä oppaassa teet:

Lataa tiedot OneLakeen OneLake-resurssienhallinnan avulla.

Käytä Fabric-muistikirjaa tietojen lukemiseen OneLakessa ja takaisin kirjoittamiseen takaisin Delta-taulukkona.

Analysoi ja muunna tietoja Sparkin avulla Fabric-muistikirjalla.

Tee kysely yhdestä tietojen kopiosta OneLakessa SQL:llä.

Edellytykset

Ennen kuin aloitat, sinun täytyy:

Lataa ja asenna OneLake-tiedostonhallinta.

Luo työtila Lakehouse-kohteen avulla.

Lataa WideWorldImportersDW-tietojoukko. Azure-tallennus Explorerin avulla voit muodostaa yhteyden

https://fabrictutorialdata.blob.core.windows.net/sampledata/WideWorldImportersDW/csv/full/dimension_citycsv-tiedostojoukkoon ja ladata sen. Voit myös käyttää omia CSV-tietojasi ja päivittää tiedot tarpeen mukaan.

Muistiinpano

Luo, lataa tai luo delta-parquet-tietojen pikakuvake aina suoraan Lakehousen Taulukot-osiossa . Älä aseta taulukoita alikansioiden sisään Taulukot-osion alla, sillä lakehouse ei tunnista sitä taulukoksi ja luokittele sitä tunnistamattomaksi.

Tietojen lataaminen, lukeminen, analysoiminen ja kyseleminen

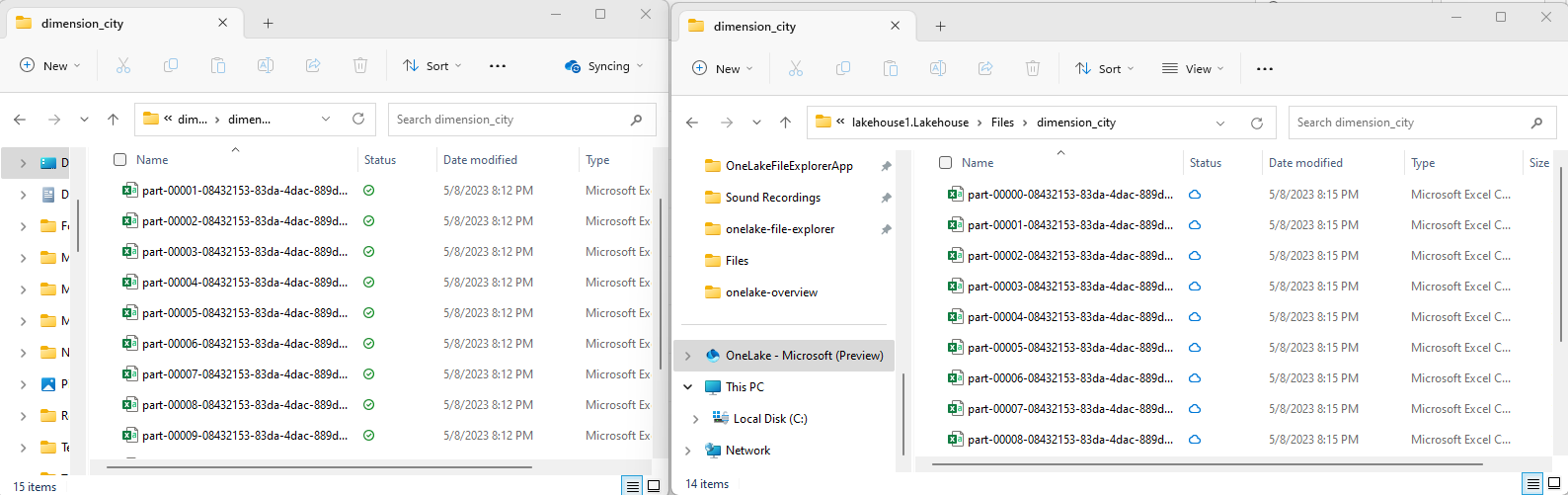

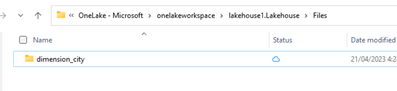

Siirry OneLake-tiedostonhallinnassa Lakehouse-sijaintiin ja luo hakemiston

/Filesalla alihakemisto nimeltädimension_city.

Kopioi CSV-mallitiedostot OneLake-hakemistoon

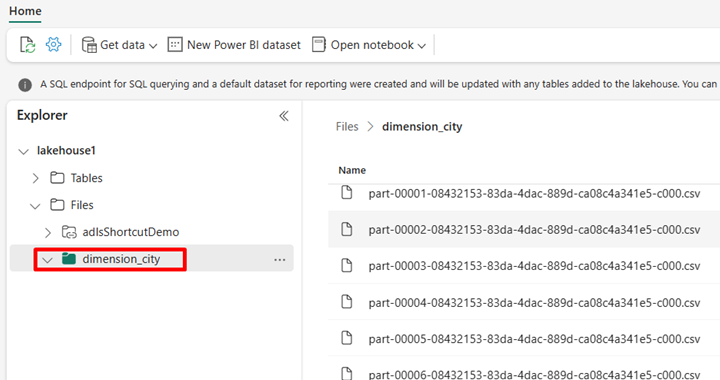

/Files/dimension_cityOneLake-resurssienhallinnan avulla.Siirry Lakehouse-tallennustilaan Power BI -palvelussa ja tarkastele tiedostojasi.

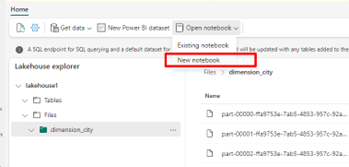

Valitse Avaa muistikirja, sitten Uusi muistikirja luodaksesi muistikirjan.

Muunna CSV-tiedostot Fabric-muistikirjan avulla Delta-muotoon. Seuraava koodikatkelman lukee käyttäjän luoman hakemiston

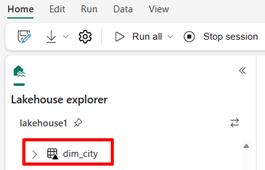

/Files/dimension_citytiedot ja muuntaa ne Delta-taulukoksidim_city.import os from pyspark.sql.types import * for filename in os.listdir("/lakehouse/default/Files/<replace with your folder path>"): df=spark.read.format('csv').options(header="true",inferSchema="true").load("abfss://<replace with workspace name>@onelake.dfs.fabric.microsoft.com/<replace with item name>.Lakehouse/Files/<folder name>/"+filename,on_bad_lines="skip") df.write.mode("overwrite").format("delta").save("Tables/<name of delta table>")Jos haluat nähdä uuden taulukkosi, päivitä näkymä hakemistosta

/Tables.

Kysely taulukossa SparkSQL:n avulla samassa Fabric-muistikirjassa.

%%sql SELECT * from <replace with item name>.dim_city LIMIT 10;Muokkaa Delta-taulukkoa lisäämällä uusi sarake nimeltä newColumn tietotyypin kokonaisluvulla. Määritä tämän juuri lisätyn sarakkeen kaikkien tietueiden arvoksi 9.

%%sql ALTER TABLE <replace with item name>.dim_city ADD COLUMN newColumn int; UPDATE <replace with item name>.dim_city SET newColumn = 9; SELECT City,newColumn FROM <replace with item name>.dim_city LIMIT 10;Voit käyttää mitä tahansa OneLaken Delta-taulukkoa myös SQL-analytiikan päätepisteen kautta. SQL-analytiikan päätepiste viittaa samaan fyysiseen kopioon OneLaken Delta-taulukosta ja tarjoaa T-SQL-käyttökokemuksen. Valitse SQL-analytiikan päätepiste Lakehouse1:lle ja valitse sitten Uusi SQL-kysely, jos haluat tehdä taulukon kyselyn T-SQL:n avulla.

SELECT TOP (100) * FROM [<replace with item name>].[dbo].[dim_city];