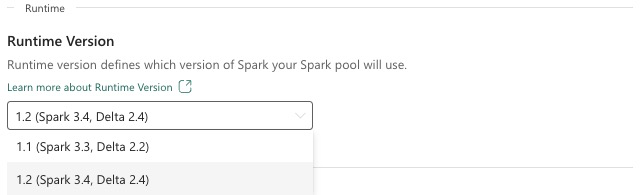

Fabric Runtime 1.2 (GA)

Microsoft Fabric Runtime on Azuren integroitu Apache Sparkiin perustuva ympäristö, joka mahdollistaa tietotekniikan ja datatieteen kokemusten suorittamisen ja hallinnan. Tämä asiakirja kattaa Runtime 1.2 -komponentit ja -versiot.

Runtime 1.2:n tärkeimpiä osia ovat seuraavat:

- Apache Spark 3.4.1

- Käyttöjärjestelmä: Mariner 2.0

- Java: 11

- Skalaa: 2.12.17

- Python: 3.10

- Delta Lake: 2.4.0

- R: 4.2.2

Vihje

Käytä aina tuotantokuormituksessa viimeisintä GA-suorituspalveluversiota, joka on tällä hetkellä Runtime 1.3.

Microsoft Fabric Runtime 1.2 sisältää kokoelman oletustason paketteja, mukaan lukien täydellisen Anaconda-asennuksen ja usein käytetyt kirjastot Java/Scalalle, Pythonille ja R:lle. Nämä kirjastot sisällytetään automaattisesti, kun käytät muistikirjoja tai töitä Microsoft Fabric -ympäristössä. Katso täydellinen kirjastoluettelo dokumentaatiosta. Microsoft Fabric julkaisee säännöllisesti Runtime 1.2:n ylläpitopäivitykset, jotka tarjoavat virheenkorjauksia, suorituskyvyn parannuksia ja suojauskorjauksia. Pysyminen ajan tasalla takaa optimaalisen suorituskyvyn ja luotettavuuden tietojenkäsittelytehtävissäsi.

Spark Release 3.4.1:n uudet ominaisuudet ja parannukset

Apache Spark 3.4.0 on 3.x-rivin viides julkaisuversio. Tämä avoimen lähdekoodin yhteisön vetämä julkaisu on ratkaissut yli 2 600 Jira-lippua. Se esittelee Python-asiakasohjelman Spark Connectille, parantaa jäsennettyä suoratoistoa asynkronisen edistymisen seurannalla ja Pythonin tilallisella käsittelyllä. Se laajentaa Pandas-ohjelmointirajapinnan kattavuutta NumPy-syötetuella ja helpottaa siirtymistä perinteisistä tietovarastoista ANSI-vaatimustenmukaisuuden ja uusien sisäänrakennettujen funktioiden avulla. Se myös parantaa kehityksen tuottavuutta ja virheenkorjausta muistiprofiloinnin avulla. Lisäksi Runtime 1.2 perustuu Apache Spark 3.4.1:een, joka on vakauteen liittyvien korjausten ylläpitojulkaisu.

Tärkeimmät tiedot

Lue tietyn Apache Spark -version julkaisuhuomautusten koko versio spark 3.4.0 - ja Spark 3.4.1 -sivuilla.

Uusia mukautettuja kyselyoptimointia

Samanaikaisten kirjoitusten tuki Sparkissä

404-virheen kohtaaminen sanomassa "Toiminto epäonnistui: Määritettyä polkua ei ole" on yleinen ongelma suoritettaessa rinnakkaisia tietojen lisäystä samaan taulukkoon SQL INSERT INTO -kyselyn avulla. Tämä virhe voi johtaa tietojen menettämiseen. Uusi toimintomme, Tiedostotulosteiden vahvistusalgoritmi, ratkaisee tämän ongelman, jotta asiakkaat voivat suorittaa rinnakkaisen tietojen lisäämisen saumattomasti.

Jos haluat käyttää tätä ominaisuutta, ota käyttöön spark.sql.enable.concurrentWrites ominaisuusmerkintä, joka on käytössä oletusarvoisesti alkaen Runtime 1.2:sta (Spark 3.4). Tämä ominaisuus on käytettävissä myös muissa Spark 3 -versioissa, mutta se ei ole käytössä oletusarvoisesti. Tämä ominaisuus ei tue LISÄÄ OVERWRITE -kyselyiden rinnakkaista suorittamista, kun kukin samanaikainen työ korvaa tiedot saman taulukon eri osioissa dynaamisesti. Tätä varten Spark tarjoaa vaihtoehtoisen ominaisuuden, joka voidaan aktivoida määrittämällä spark.sql.sources.partitionOverwriteMode asetus dynaamiseksi.

Älykkäät lukuja, jotka ohittavat epäonnistuneiden töiden tiedostot

Kun taulukkotyön lisääminen epäonnistuu nykyisessä Spark-vahvistusjärjestelmässä, mutta jotkin tehtävät onnistuvat, onnistuneiden tehtävien luomat tiedostot ovat samanaikaisesti epäonnistuneen työn tiedostojen kanssa. Tämä rinnakkaiselo voi aiheuttaa hämmennystä käyttäjille, sillä on haastavaa erottaa onnistuneet ja epäonnistuneet työt. Lisäksi kun yksi työ lukee taulukosta ja toinen lisää tietoja samanaikaisesti samaan taulukkoon, lukutyö saattaa käyttää sitomattomia tietoja. Jos kirjoitustyö epäonnistuu, lukutyössä voidaan käsitellä virheellisiä tietoja.

- spark.sql.auto.cleanup.enabled merkintä ohjaa uutta ominaisuuttamme ja käsittelee tätä ongelmaa. Kun se on käytössä, Spark ohittaa automaattisesti lukutiedostot, joita ei ole otettu käyttöön, kun se suorittaa spark.read tai valitsee kyselyjä taulukosta. Ennen tämän ominaisuuden käyttöönottoa kirjoitetut tiedostot luetaan edelleen tavalliseen tapaan.

Näkyvät muutokset ovat seuraavat:

- Kaikki tiedostot sisältävät nyt tunnisteen

tid-{jobID}tiedostonimissään. - Sen sijaan, että merkinnän

_successpitäisi yleensä luoda tulossijaintiin onnistuneen työn valmistuttua, luodaan uusi_committed_{jobID}merkki. Tämä merkki liittää onnistuneet työtunnukset tiettyihin tiedostonimiin. - Otimme käyttöön uuden SQL-komennon, jota käyttäjät voivat suorittaa säännöllisesti tallennustilan hallintaan ja sitomattomien tiedostojen puhdistamiseen. Tämän komennon syntaksi on seuraava:

- Voit tyhjentää tietyn hakemiston:

CLEANUP ('/path/to/dir') [RETAIN number HOURS]; - Tietyn taulukon puhdistaminen:

CLEANUP [db_name.]table_name [RETAIN number HOURS];Tässä syntaksissa se edustaa sijainnin URI-osoitetta,path/to/dirjossa tarvitaan puhdistusta, janumberon kaksinkertainen tyyppiarvo, joka edustaa säilytysaikaa. Oletuspidätysaika on seitsemän päivää.

- Voit tyhjentää tietyn hakemiston:

- Olemme ottaneet käyttöön uuden määritysvaihtoehdon nimeltä

spark.sql.deleteUncommittedFilesWhileListing, jonka oletusarvo onfalse. Tämän asetuksen ottaminen käyttöön aiheuttaa sitomattomien tiedostojen automaattisen poistamisen lukemisen aikana, mutta tämä skenaario saattaa hidastaa lukutoimintoja. On suositeltavaa suorittaa puhdistuskomento manuaalisesti, kun klusteri on käyttämättömänä tämän lipun käyttöönoton sijaan.

Siirto-opas Runtime 1.1:stä Runtime 1.2:een

Kun siirryt Apache Spark 3.3:n tarjoamasta Runtime 1.1:stä Runtime 1.2:een, jonka voimanlähteenä on Apache Spark 3.4, tarkista virallinen siirto-opas.

Delta Lake 2.4:n uudet ominaisuudet ja parannukset

Delta Lake on avoimen lähdekoodin projekti , jonka avulla voidaan rakentaa Lakehouse-arkkitehtuuri Data Lake -tallennustilojen päälle. Delta Lake tarjoaa ACID-tapahtumia, skaalattavia metatietojen käsittelyä sekä ilmoittaa virtautus - ja erätietojen käsittelyn aiemmin luotujen Data Lake -tallennustilojen päälle.

Tarkemmin sanottuna Delta Lake tarjoaa:

- ACID-tapahtumat Sparkissä: Sarjoitettava eristystaso varmistaa, että lukijat eivät koskaan näe epäjohdonmukaisia tietoja.

- Skaalattavat metatietojen käsittely: käsittelee Sparkin hajautetun käsittelytehon avulla kaikki petatavumittakaavan taulukoiden metatiedot, jolloin miljardeja tiedostoja on helppo käsitellä.

- Virtauttaminen ja erän yhdistäminen: Delta Lake -järven taulukko on erätaulukko ja virtautettava lähde ja pesuallas. Virtautettavien tietojen käyttö, erä historiarajoituksen täyttö, vuorovaikutteiset kyselyt toimivat kaikki heti.

- Rakenteen pakottaminen: Käsittelee rakennevariaatioita automaattisesti estääkseen virheellisten tietueiden lisäämisen käsittelyn aikana.

- Aikamatkustus: Tietojen versiointi mahdollistaa myös käyttöönotot, täydet historialliset seurantaketjut ja toistettavissa olevat koneoppimiskokeilut.

- Päivityslisäykset ja poistamiset: Tukee yhdistämis-, päivitys- ja poistotoimintoja monimutkaisten käyttötapausten, kuten muutostietojen tallentamisen, hitaasti muuttuvan dimension (SCD) toimintojen ja virtautettavien päivityslisäysten mahdollistamiseksi.

Lue Delta Lake 2.4:n julkaisutiedot koko versio.

Java-, Scala- ja Python-kirjastojen oletustason paketit

Luettelo kaikista Javan, Scala:n, Pythonin ja niiden versioiden oletustason paketeista on julkaisutiedoissa.