Escalado del chat de Azure OpenAI para .NET mediante RAG con Azure Container Apps

Obtenga información sobre cómo agregar equilibrio de carga a la aplicación para ampliar la aplicación de chat más allá de los límites de cuota de modelo y token del servicio OpenAI de Azure. Este enfoque usa Azure Container Apps para crear tres puntos de conexión de Azure OpenAI y un contenedor principal para dirigir el tráfico entrante a uno de los tres puntos de conexión.

En este artículo debe implementar dos ejemplos independientes:

Aplicación de chat

Si aún no ha implementado la aplicación de chat, espere hasta que se implemente el ejemplo del equilibrador de carga.

Si ya ha implementado la aplicación de chat una vez, cambie la variable de entorno para admitir un punto de conexión personalizado para el equilibrador de carga y vuelva a implementarla.

La aplicación de chat está disponible en estos idiomas:

Aplicación del equilibrador de carga

Nota:

En este artículo se usan una o varias plantillas de IA de aplicaciones como base para los ejemplos e instrucciones en el artículo. Las plantillas de aplicación de IA proporcionan implementaciones de referencia bien mantenidas que son fáciles de implementar. Ayudan a garantizar un punto de partida de alta calidad para las aplicaciones de inteligencia artificial.

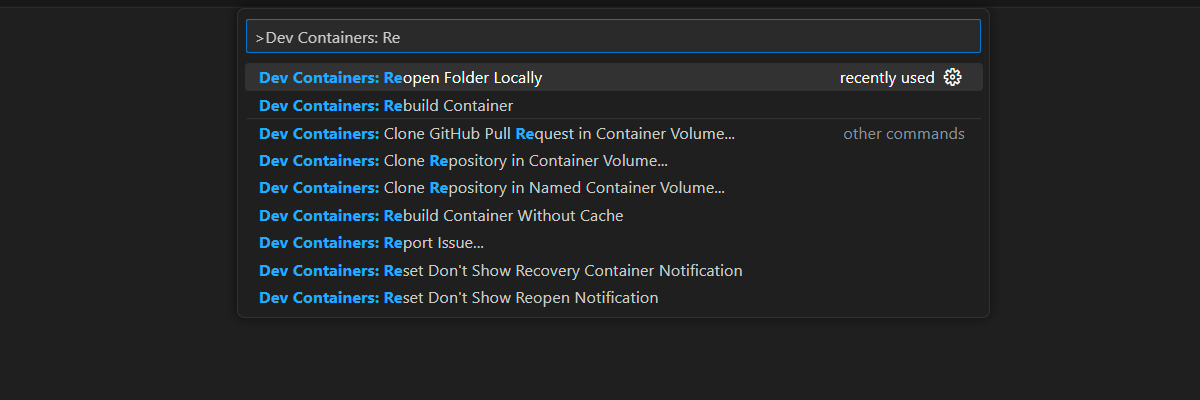

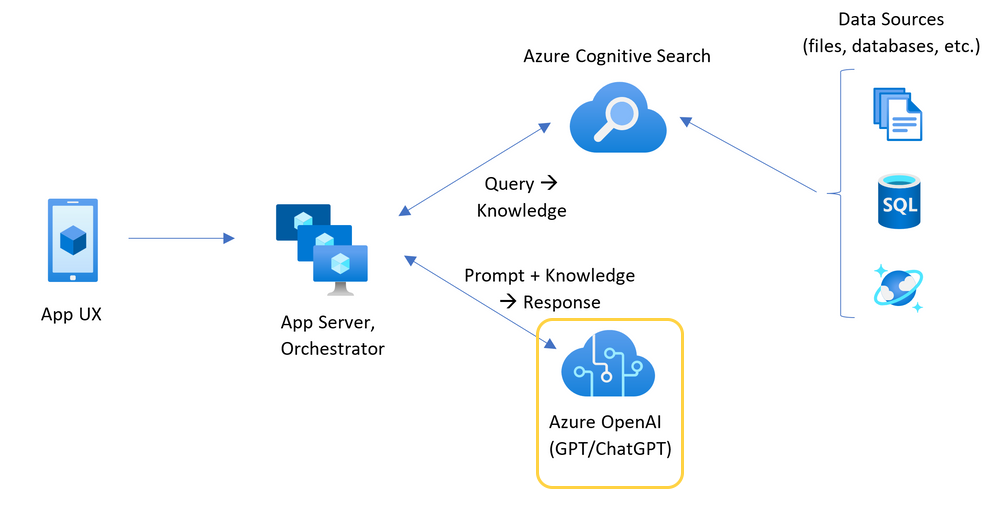

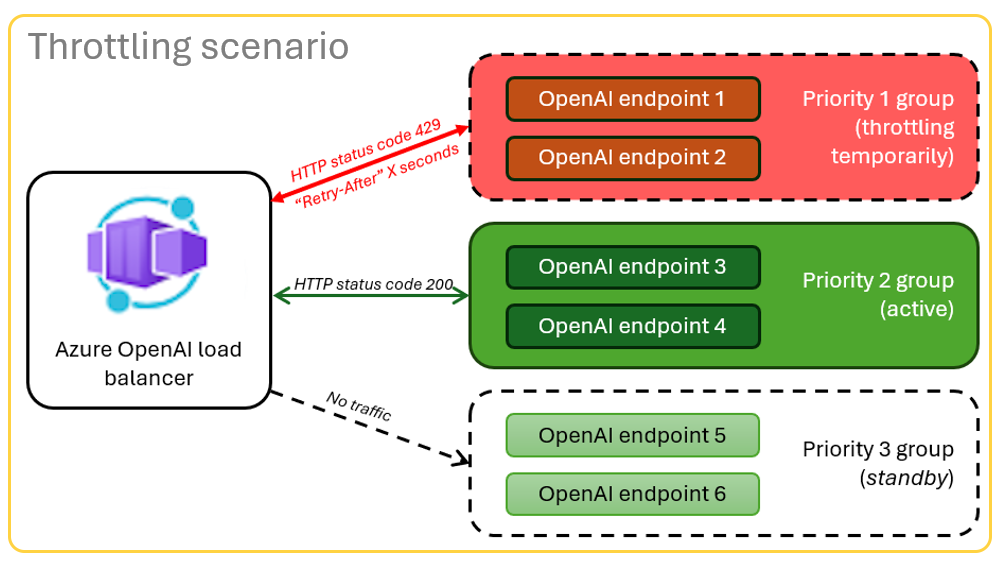

Arquitectura para el equilibrio de carga de Azure OpenAI con Azure Container Apps

Dado que el recurso de Azure OpenAI tiene límites específicos de cuota de tokens y modelos, una aplicación de chat que usa un único recurso de Azure OpenAI es propenso a tener errores de conversación debido a esos límites.

Para usar la aplicación de chat sin alcanzar esos límites, use una solución de carga equilibrada con Container Apps. Esta solución expone sin problemas un único punto de conexión de Container Apps al servidor de aplicaciones de chat.

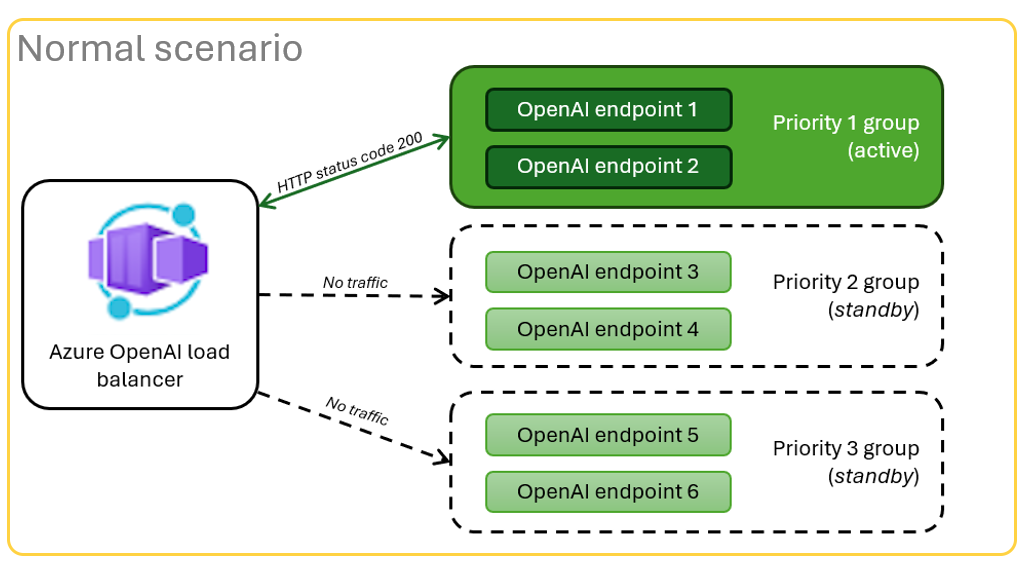

La aplicación contenedora se encuentra delante de un conjunto de recursos de Azure OpenAI. La aplicación Container resuelve dos escenarios: normal y limitado. Durante un escenario normal donde está disponible la cuota de tokens y modelos, el recurso de Azure OpenAI devuelve un valor de 200 a través de Container App y App Server.

Cuando un recurso está en un escenario limitado, por ejemplo, debido a los límites de cuota, la aplicación Container puede reintentar un recurso de Azure OpenAI diferente inmediatamente para completar la solicitud de aplicación de chat original.

Requisitos previos

Suscripción de Azure. Cree una de forma gratuita.

Acceso concedido a Azure OpenAI en la suscripción de Azure que quiera.

Actualmente, solo la aplicación concede acceso a este servicio. Debe solicitar acceso a Azure OpenAI.

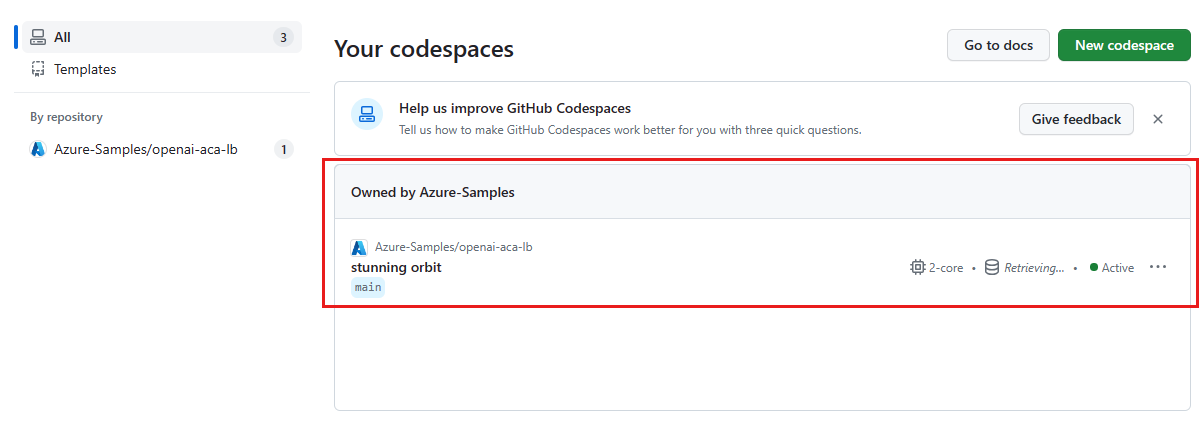

Los contenedores de desarrollo están disponibles para ambos ejemplos, con todas las dependencias necesarias para completar este artículo. Puede ejecutar los contenedores de desarrollo en GitHub Codespaces (en un explorador) o localmente mediante Visual Studio Code.

- Solo se requiere una cuenta de GitHub para usar CodeSpaces

Abre la aplicación de ejemplo del equilibrador de carga de Container Apps

GitHub Codespaces ejecuta un contenedor de desarrollo administrado por GitHub con Visual Studio Code para la web como interfaz de usuario. Para obtener el entorno de desarrollo más sencillo, utilice Codespaces de GitHub de modo que tenga las herramientas y dependencias de desarrollador correctas preinstaladas para completar este artículo.

Importante

Todas las cuentas de GitHub pueden usar GitHub Codespaces durante hasta 60 horas gratuitas cada mes con dos instancias principales. Para obtener más información, consulte Almacenamiento y horas de núcleo incluidas mensualmente en GitHub Codespaces.

Implementación del equilibrador de carga de Azure Container Apps

Inicie sesión en la CLI para desarrolladores de Azure para proporcionar autenticación a los pasos de aprovisionamiento e implementación:

azd auth login --use-device-codeEstablezca una variable de entorno para usar la autenticación de la CLI de Azure en el paso posterior al aprovisionamiento:

azd config set auth.useAzCliAuth "true"Implemente la aplicación del equilibrador de carga:

azd upSeleccione una suscripción y una región para la implementación. No tienen que ser la misma suscripción y región que la aplicación de chat.

Espere a que finalice la implementación antes de continuar.

Obtener el extremo de implementación

Use el siguiente comando para mostrar el punto de conexión implementado para la aplicación contenedora:

azd env get-valuesCopie el valor

CONTAINER_APP_URL. Lo usas en la siguiente sección.

Reimplementación de la aplicación de chat con el punto de chat del Load Balancer

Estos ejemplos se completan en el ejemplo de aplicación de chat.

Abre el contenedor de desarrollo de la app de chat usando una de las siguientes opciones.

Lenguaje GitHub Codespaces Visual Studio Code .NET JavaScript Python Inicie sesión en la CLI para desarrolladores de Azure (

AZD):azd auth loginFinalice las instrucciones de inicio de sesión.

Cree un entorno

AZDcon un nombre tal comochat-app:azd env new <name>Agregue la siguiente variable de entorno, que indica al back-end de la aplicación de chat que use una dirección URL personalizada para las solicitudes de Azure OpenAI:

azd env set OPENAI_HOST azure_customAgregue la siguiente variable de entorno. Sustituya

<CONTAINER_APP_URL>por la dirección URL de la sección anterior. Esta acción indica al back-end de la aplicación de chat cuál es el valor de la dirección URL personalizada para la solicitud de Azure OpenAI.azd env set AZURE_OPENAI_CUSTOM_URL <CONTAINER_APP_URL>Implemente la aplicación de chat:

azd up

Ahora puede usar la aplicación de mensajería con la confianza de que está diseñada para escalar entre muchos usuarios sin agotar su cuota.

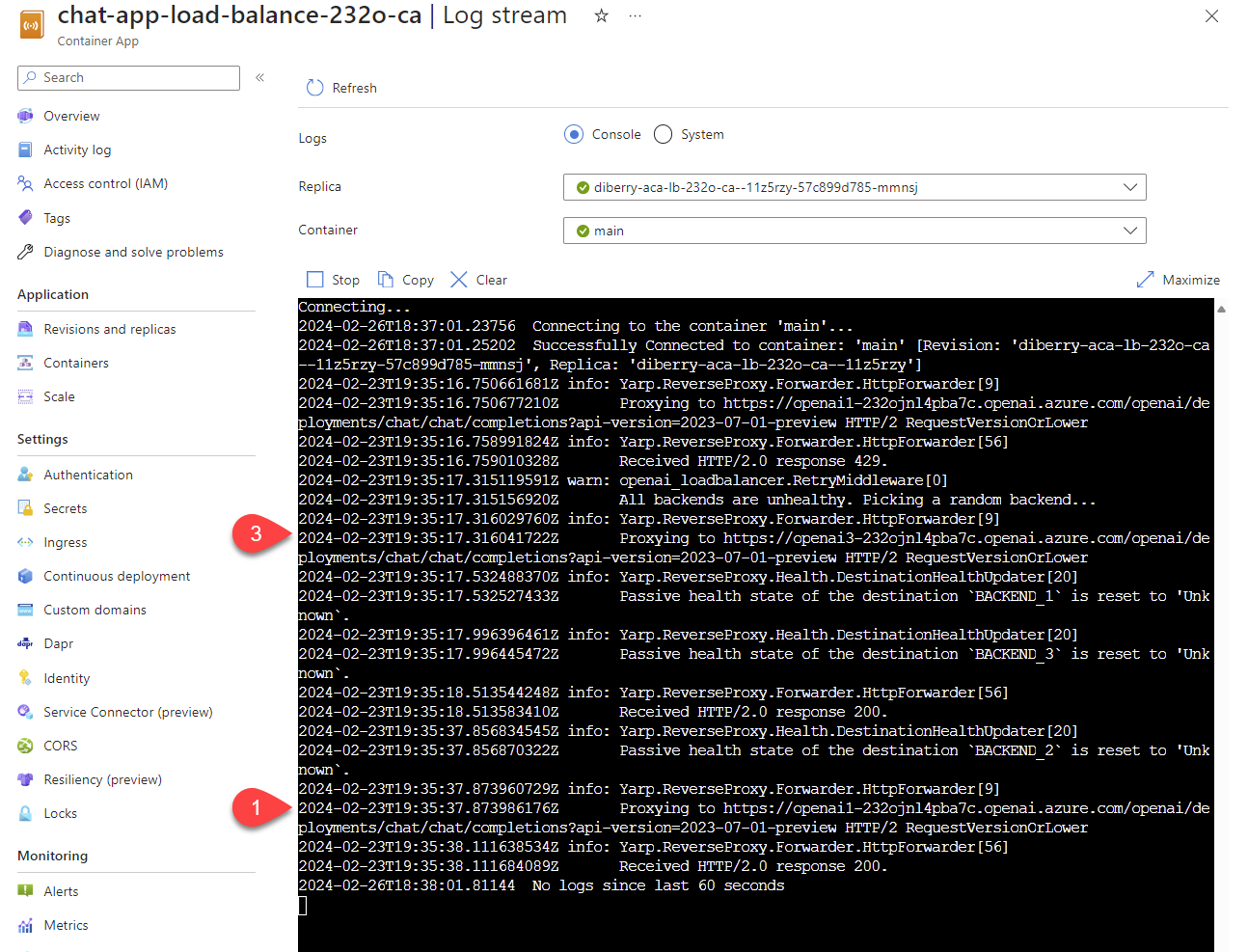

Transmitir registros para ver los resultados del equilibrador de carga

En Azure Portal, busque el grupo de recursos.

En la lista de recursos del grupo, seleccione el recurso Azure Container Apps.

Seleccione Supervisión>Flujo de registro para ver el registro.

Use la aplicación de chat para generar tráfico en el registro.

Busque los registros, que hacen referencia a los recursos de Azure OpenAI. Cada uno de los tres recursos tiene su identidad numérica en el comentario de registro que comienza con

Proxying to https://openai3, donde3indica el tercer recurso de Azure OpenAI.

Cuando el equilibrador de carga recibe el estado de que la solicitud supera la cuota, el equilibrador de carga gira automáticamente a otro recurso.

Configuración de la cuota de TPM

De forma predeterminada, cada una de las instancias de Azure OpenAI del Load Balancer se implementará con una capacidad de 30 000 TPM (tokens por minuto). Puedes usar la aplicación de chat con la confianza de que se ha creado para escalar horizontalmente entre muchos usuarios sin quedarse sin cuota. Cambie este valor cuando:

- Obtiene errores de capacidad de implementación: menor que ese valor.

- Necesita una capacidad más alta: aumente el valor.

Use el siguiente comando para cambiar el valor:

azd env set OPENAI_CAPACITY 50Vuelva a implementar el Load Balancer:

azd up

Limpieza de recursos

Cuando haya terminado con la aplicación de chat y el equilibrador de carga, limpie los recursos. Los recursos Azure creados en este artículo se facturan a su suscripción Azure. Si no espera necesitar estos recursos en el futuro, elimínelos para evitar incurrir en más gastos.

Limpieza de los recursos de la aplicación de chat

Vuelva al artículo de la aplicación de chat para limpiar esos recursos:

Limpieza de los recursos del equilibrador de carga

Ejecute el siguiente comando de la Azure Developer CLI para eliminar los recursos de Azure y eliminar el código de origen:

azd down --purge --force

Los interruptores proporcionan:

purge: Los recursos eliminados se eliminan inmediatamente, permitiéndole reutilizar los tokens del servicio Azure OpenAI por minuto.-

force: la eliminación se produce de forma silenciosa, sin necesidad de consentimiento del usuario.

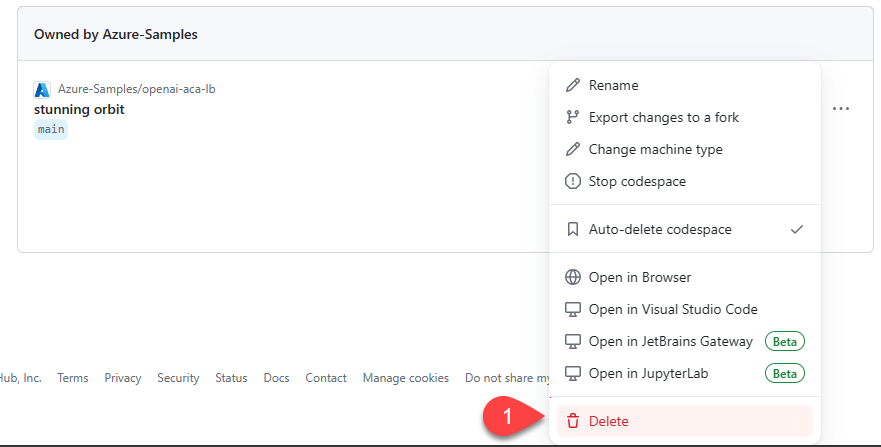

Limpieza de GitHub Codespaces y Visual Studio Code

La eliminación del entorno de GitHub Codespaces garantiza que pueda maximizar la cantidad de derechos de horas gratuitas por núcleo que obtiene para su cuenta.

Importante

Para obtener más información sobre los derechos de la cuenta de GitHub, consulte Almacenamiento y horas de núcleo incluidas mensualmente en GitHub Codespaces.

Inicie sesión en el panel de GitHub Codespaces.

Busque los codespaces que se ejecutan actualmente a partir del repositorio de GitHub azure-samples/openai-aca-lb.

Abra el menú contextual del espacio de código y seleccione Eliminar.

Obtener ayuda

Si tiene problemas para implementar el Load Balancer de Azure API Management, agregue el problema en la página web del repositorio Problemas.

Código de ejemplo

Entre los ejemplos usados en este artículo se incluyen:

Paso siguiente

- Utilizar Azure Load Testing para hacer pruebas de carga en tu aplicación de chat