Obtención de la aplicación y del contexto de usuario final para alertas de IA

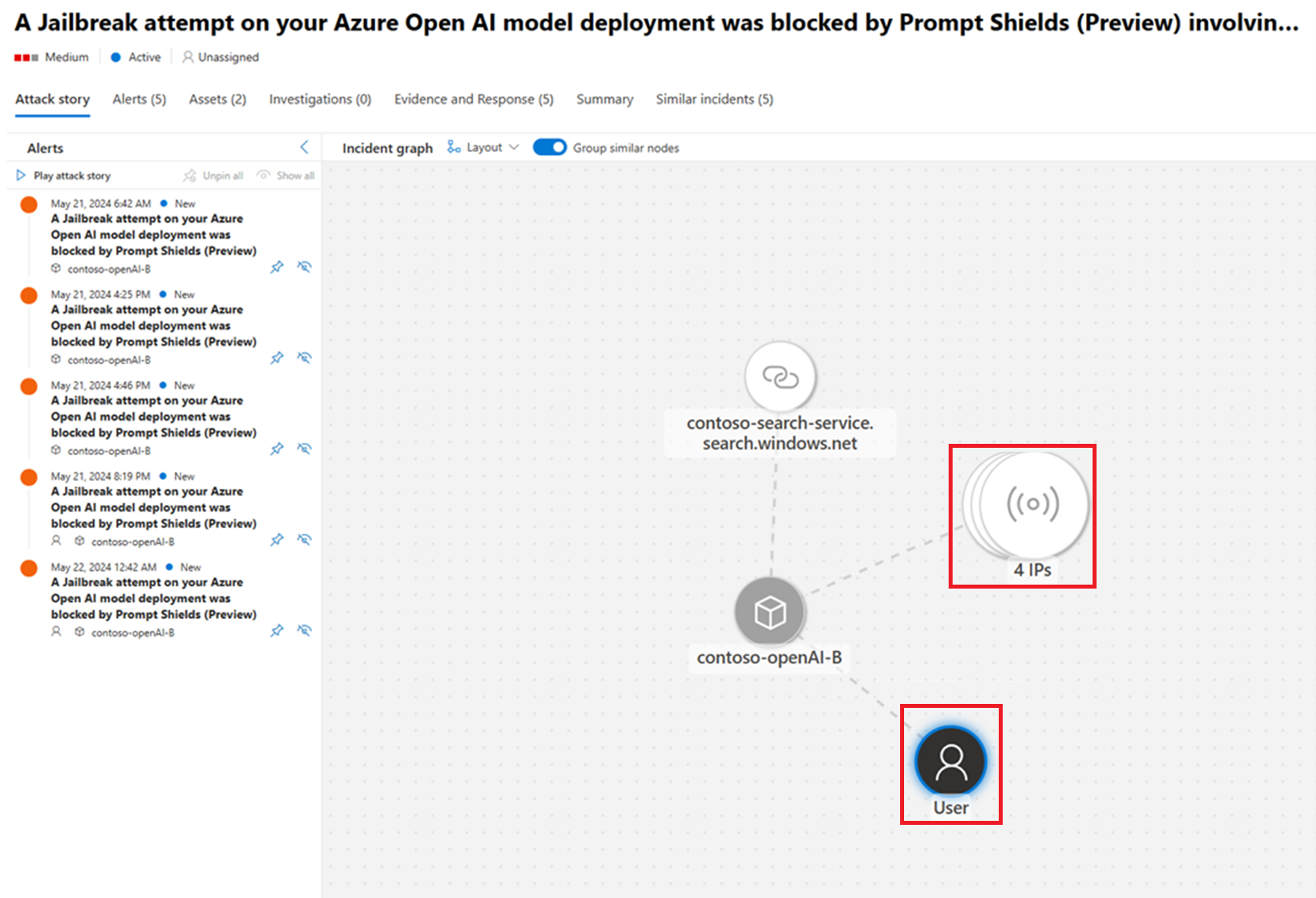

La protección contra amenazas de Microsoft Defender for Cloud para cargas de trabajo de inteligencia artificial permite mejorar la capacidad de acción y el valor de seguridad de las alertas de IA generadas al proporcionar tanto el contexto de usuario final como de la aplicación.

En la mayoría de los casos, los escenarios que aprovechan los servicios de IA se crean como parte de una aplicación, por lo que las llamadas a la API del servicio de IA se originan desde una aplicación web, una instancia de proceso o una puerta de enlace de IA. Esta configuración de la arquitectura introduce complejidad debido a la falta de contexto a la hora de investigar las solicitudes de IA para determinar la aplicación empresarial o el usuario final implicado.

Defender for Cloud, junto con Azure AI, permite agregar parámetros a las llamadas a la API de Azure AI para propagar el contexto crítico del usuario final o de la aplicación a las alertas de IA de Defender for Cloud. Esto, a su vez, conduce a una evaluación de prioridades y resultados más eficaces. Por ejemplo, al agregar una dirección IP o identidad de usuario final, puede bloquear ese usuario o correlacionar incidentes y alertas por ese usuario. Al agregar contexto de aplicación, puede priorizar o determinar si el comportamiento sospechoso podría considerarse estándar para esa aplicación en la organización.

Requisitos previos

Léalo en Información general: protección contra amenazas de la IA.

Habilite la protección contra amenazas para cargas de trabajo de inteligencia artificial (versión preliminar) en una aplicación de IA, con Azure OpenAI como modelo subyacente, directamente a través de Azure OpenAI Service. Tenga en cuenta que esta característica no se admite actualmente al aprovechar los modelos consumidos mediante la API de inferencia de modelos de Azure AI.

Adición de parámetros de seguridad a la llamada de Azure OpenAI

Para recibir alertas de seguridad de inteligencia artificial con más contexto, puede agregar cualquiera o todos los parámetros de ejemplo siguientes UserSecurityContext a las llamadas API de Azure OpenAI.

Todos los campos del UserSecurityContext son opcionales.

Para el contexto del usuario final, se recomienda pasar los campos EndUserId y SourceIP como mínimo. Los campos EndUserId y SourceIP proporcionan a los analistas del centro de operaciones de seguridad (SOC) la capacidad de investigar incidentes de seguridad que implican recursos de inteligencia artificial y aplicaciones de IA generativas.

Para el contexto de la aplicación, simplemente pase el campo applicationName, como una cadena simple.

Si se ha escrito mal el nombre de un campo, la llamada a la API de Azure OpenAI se realizará correctamente. El esquema de UserSecurityContext no requiere validación para pasar por el campo de usuario de Azure OpenAI. Los desarrolladores de aplicaciones deben asegurarse de que se pasa un JSON válido en todas las solicitudes realizadas por la aplicación a Azure OpenAI.

Esquema UserSecurityContext

El esquema exacto se puede encontrar en la documentación de referencia de la API de REST de Azure OpenAI.

El objeto de contexto de seguridad de usuario forma parte del cuerpo de la solicitud de la API de finalización del chat.

Esta característica no se admite actualmente al aprovechar los modelos implementados mediante la API de inferencia de modelos de Azure AI.

Disponibilidad

| Origen | Compatibilidad con versiones | Comentarios |

|---|---|---|

| API de REST de Azure OpenAI | versión 2025-01-01 | - |

| SDK de .NET para Azure | v2.2.0-beta.1 (2025-02-07) o posterior | - |

| SDK de Python de Azure | v1.61.1 o posterior | La compatibilidad se proporciona anexando al objeto "extra_body" |

| Azure JS/SDK de Node | v4.83.0 o posterior | La compatibilidad se proporciona anexando al objeto "extra_body" |

| SDK de Go de Azure | v0.7.2 o posterior | - |