Ejemplo de precios: copia de datos y transformación con Azure Databricks

SE APLICA A:  Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Sugerencia

Pruebe Data Factory en Microsoft Fabric, una solución de análisis todo en uno para empresas. Microsoft Fabric abarca todo, desde el movimiento de datos hasta la ciencia de datos, el análisis en tiempo real, la inteligencia empresarial y los informes. Obtenga información sobre cómo iniciar una nueva evaluación gratuita.

En este escenario, quiere copiar datos de AWS S3 a Azure Blob Storage y transformarlos con Azure Databricks en una programación por hora durante 8 horas al día durante 30 días.

Los precios que se usan en el ejemplo siguiente son hipotéticos y no pretenden reflejar precios reales. Los costes de lectura y escritura, y de supervisión no se muestran, ya que normalmente son insignificantes y no afectan a los costes generales de manera significativa. Además, las ejecuciones de actividad se redondean al millar más cercano en las estimaciones de la calculadora de precios.

Nota:

Este presupuesto es solo para los costes de Azure Data Factory implicados. Azure Databricks también incurrirá en costes en este escenario, pero puede calcular mediante la Calculadora de precios de Azure.

Vea la calculadora de precios de Azure para conocer escenarios más específicos y para calcular los futuros costos de uso del servicio.

Configuración

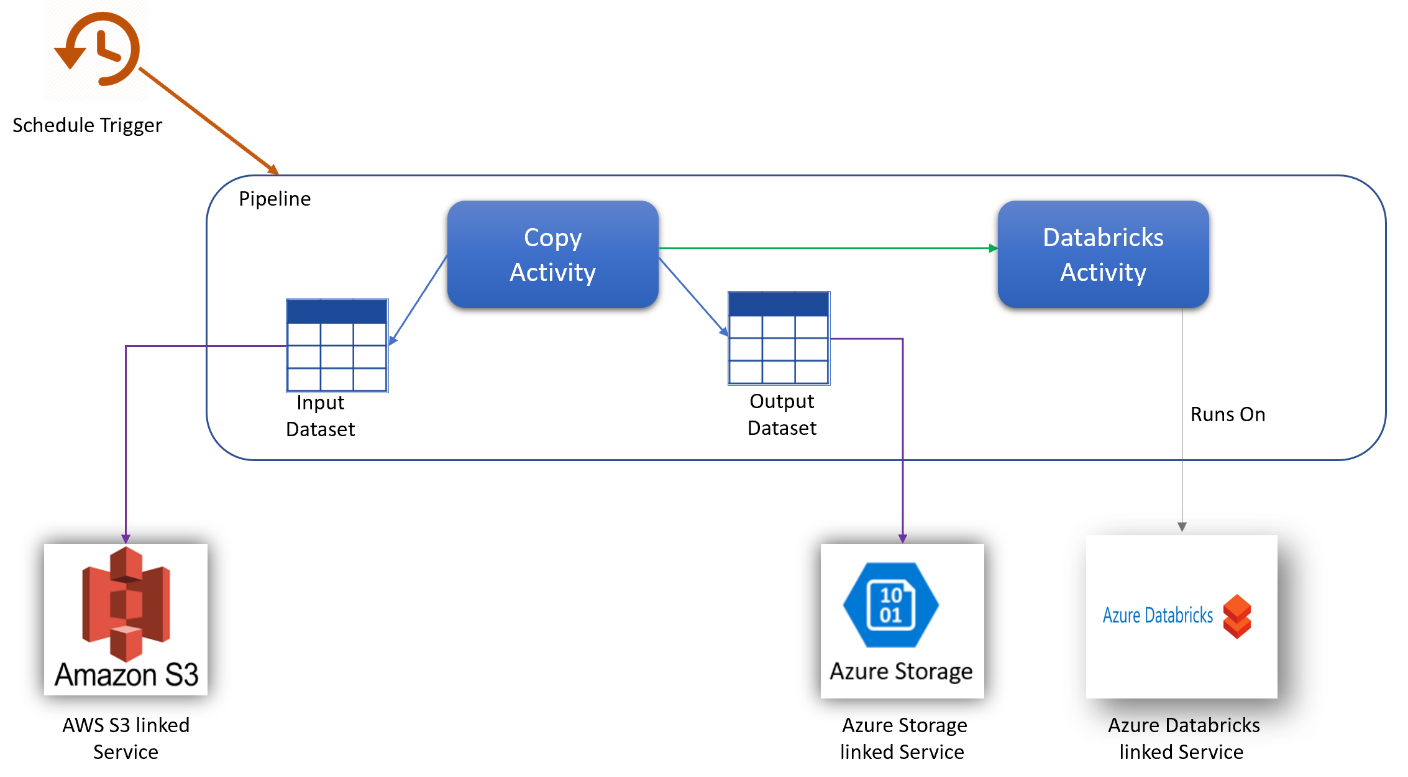

Para lograr el escenario, es preciso crear una canalización con los siguientes elementos:

- Una actividad de copia con un conjunto de datos de entrada para los datos que desea copiar desde AWS S3 y un conjunto de datos de salida para los datos del almacenamiento de Azure.

- Una actividad de Azure Databricks para la transformación de datos.

- Un desencadenador de programación para ejecutar la canalización cada hora. Cuando quiera ejecutar una canalización, puede desencadenarla inmediatamente o programarla. Además de la canalización en sí, cada instancia de desencadenador cuenta como una sola ejecución de actividad.

Estimación de costes

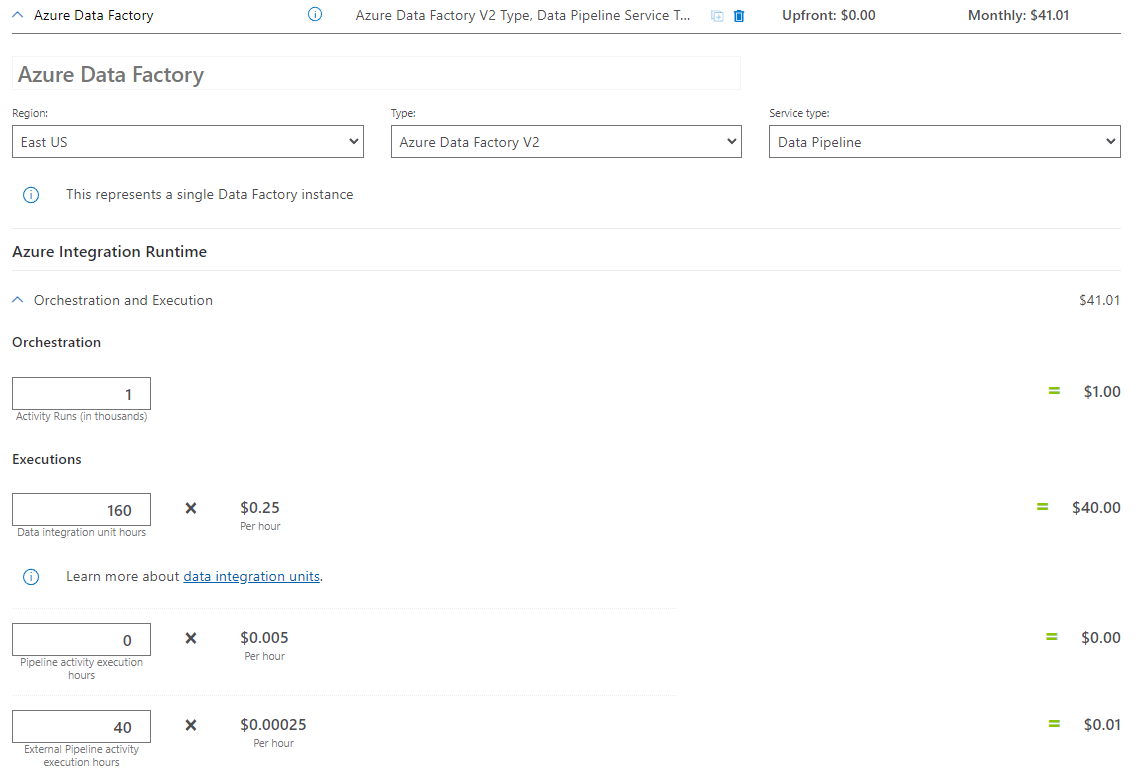

| Operaciones | Tipos y unidades |

|---|---|

| Ejecución de la canalización | Tres ejecuciones de actividad por ejecución (una para la ejecución de desencadenador y dos para ejecuciones de actividad) = 720 ejecuciones de actividad redondeadas al alza, ya que la calculadora solo permite incrementos de 1000. |

| Suposición de copia de datos: horas de DIU por ejecución = 10 min | 10 min / 60 min * 4 Azure Integration Runtime (valor predeterminado de DIU = 4). Para obtener más información sobre las unidades de integración de datos y la optimización del rendimiento de la copia, vea este artículo. |

| Suposición de la ejecución de actividad de Databricks: horas de ejecución externa por ejecución = 10 min | Ejecución de la actividad de canalización externa de 10 min / 60 min |

Ejemplo de calculadora de precios

Precio total del escenario durante 30 días: 41,01 USD

Contenido relacionado

- Ejemplo de precios: copia de datos de AWS S3 a Azure Blob Storage por hora durante 30 días

- Ejemplo de precios: copia de datos y transformación con parámetros dinámicos por hora durante 30 días

- Ejemplo de precios: Ejecución de paquetes SSIS en el entorno de ejecución de integración de Azure-SSIS

- Ejemplo de precios: Uso de la depuración de flujo de datos de asignación para una jornada normal

- Ejemplo de precios: transformación de datos del almacén de blobs con flujos de datos de asignación

- Ejemplo de precios: integración de datos en una red virtual administrada de Azure Data Factory

- Ejemplo de precios: obtención de datos diferenciales de SAP ECC mediante SAP CDC en flujos de datos de asignación