Importación de DAG mediante Azure Blob Storage

Nota:

Esta característica está en versión preliminar pública. El Administrador de orquestación de flujo de trabajo cuenta con la tecnología de Apache Airflow.

En este artículo se muestran instrucciones paso a paso sobre cómo importar grafos acíclicos dirigidos (DAG) en el Administrador de orquestación de flujo de trabajo mediante Azure Blob Storage.

Requisitos previos

- Suscripción de Azure: Si no tiene una suscripción a Azure, cree una cuenta gratuita de Azure antes de empezar.

- Azure Data Factory: cree o seleccione una instancia de Data Factory existente en la región donde se admite la versión preliminar del Administrador de orquestación de flujo de trabajo.

- Cuenta de Azure Storage: si no tiene una cuenta de almacenamiento de Azure, consulte Creación de una cuenta de Azure Storage para crear una. Asegúrese de que la cuenta de almacenamiento solo permita el acceso desde las redes seleccionadas.

Durante la versión preliminar no se admite Blob Storage detrás de las redes virtuales. La configuración de Azure Key Vault en storageLinkedServices no se admite para importar DAG.

Importación de DAG

Copie Sample Apache Airflow v2.x DAG o Sample Apache Airflow v1.10 DAG en función del entorno de Airflow que haya configurado. Pegue el contenido en un nuevo archivo con el nombre tutorial.py.

Cargue el archivo tutorial.py en Blob Storage. Para obtener más información, consulte Cargar un archivo en un blob.

Nota:

Tiene que seleccionar una ruta de acceso de directorio de una cuenta de Blob Storage que contenga carpetas denominadas dags y plugins para importarlos en el entorno de Airflow. Los complementos no son obligatorios. También puede tener un contenedor denominado dags y cargar todos los archivos de Airflow en él.

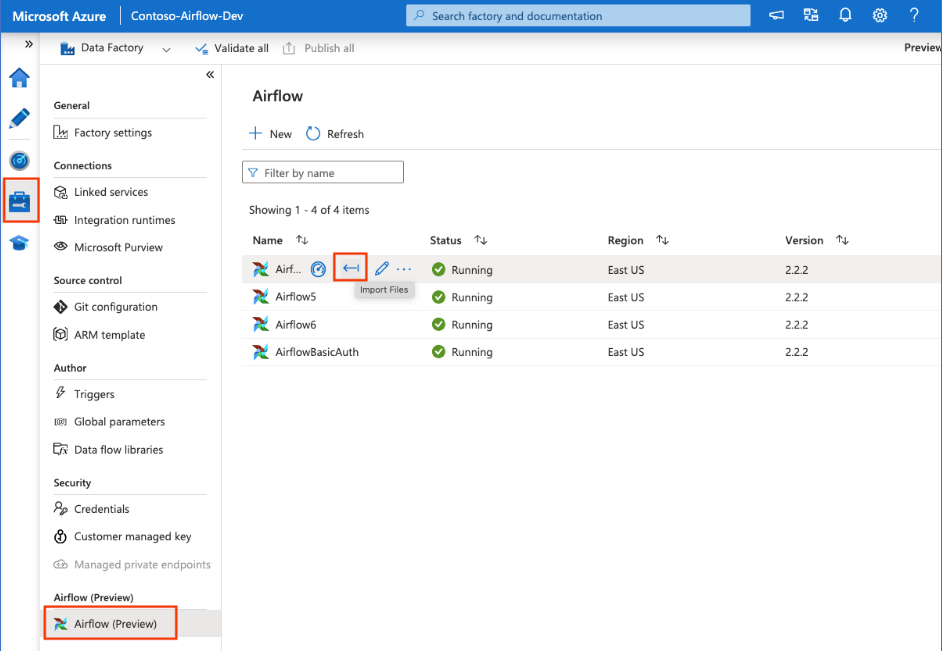

En el centro Administrar, seleccione Airflow de Apache. Después, mantenga el puntero sobre el entorno de Airflow creado anteriormente y seleccione Importar archivos para importar todos los DAG y dependencias en el entorno de Airflow.

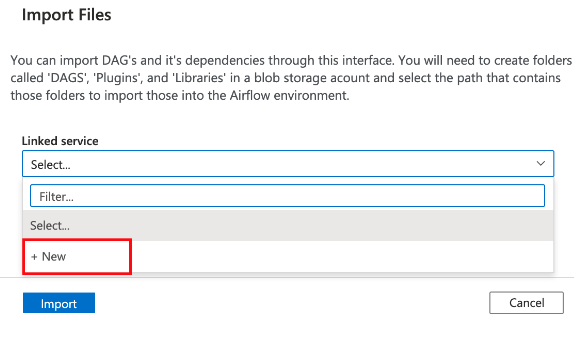

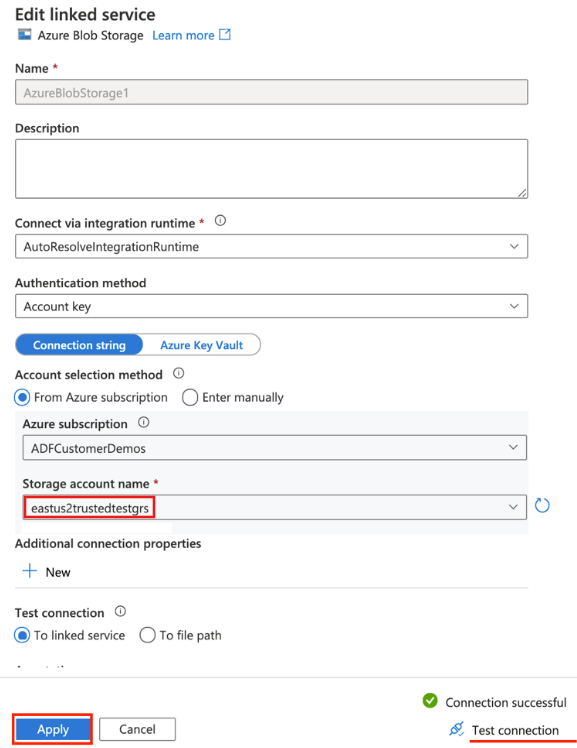

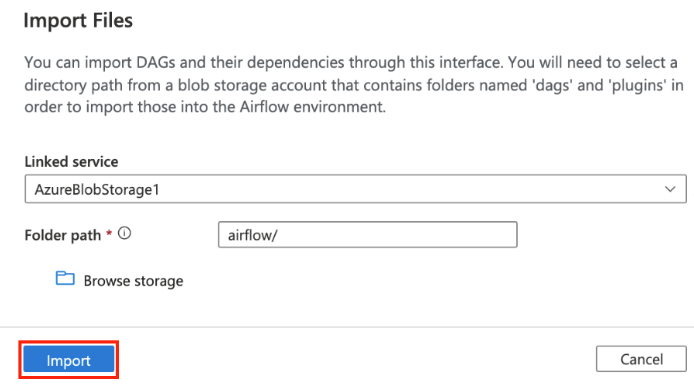

Cree un servicio vinculado a la cuenta de almacenamiento accesible mencionada en la sección Requisito previo. También puede usar uno existente si los tiene.

Use la cuenta de almacenamiento donde cargó el DAG. (Compruebe la sección Requisitos previos). Pruebe la conexión y seleccione Crear.

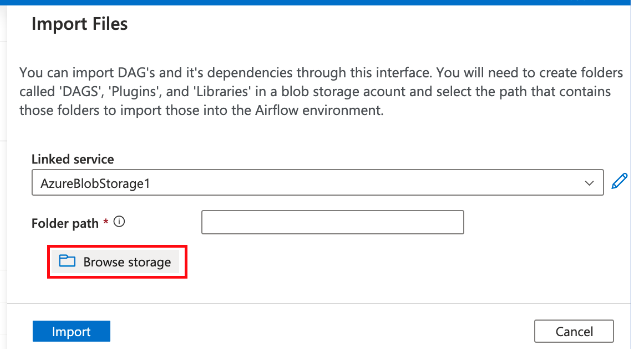

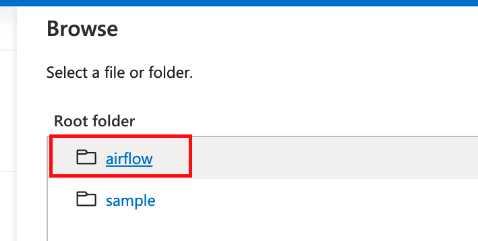

Busque y seleccione airflow si usa la dirección URL de SAS de ejemplo. También puede seleccionar la carpeta que contiene la carpeta dags con archivos DAG.

Nota:

Puede importar DAG y sus dependencias mediante esta interfaz. Tiene que seleccionar una ruta de acceso de directorio de una cuenta de Blob Storage que contenga carpetas denominadas dags y plugins para importarlos en el entorno de Airflow. Los complementos no son obligatorios.

Seleccione Importar para importar archivos.

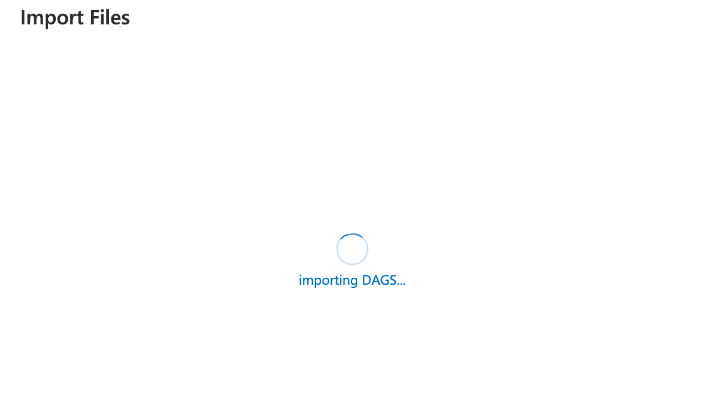

La importación de DAG puede tardar un par de minutos durante la versión preliminar. Puede usar el centro de notificaciones (icono de campana en la interfaz de usuario de Data Factory) para realizar un seguimiento de las actualizaciones del estado de la importación.