En esta solución se muestra cómo lograr el escalado entre clústeres de cargas de trabajo implementadas en una infraestructura híbrida. Esta solución se logra aplicando las funcionalidades de escalabilidad y administración de los servicios habilitados para Azure Arc en clústeres locales de Azure.

Architecture

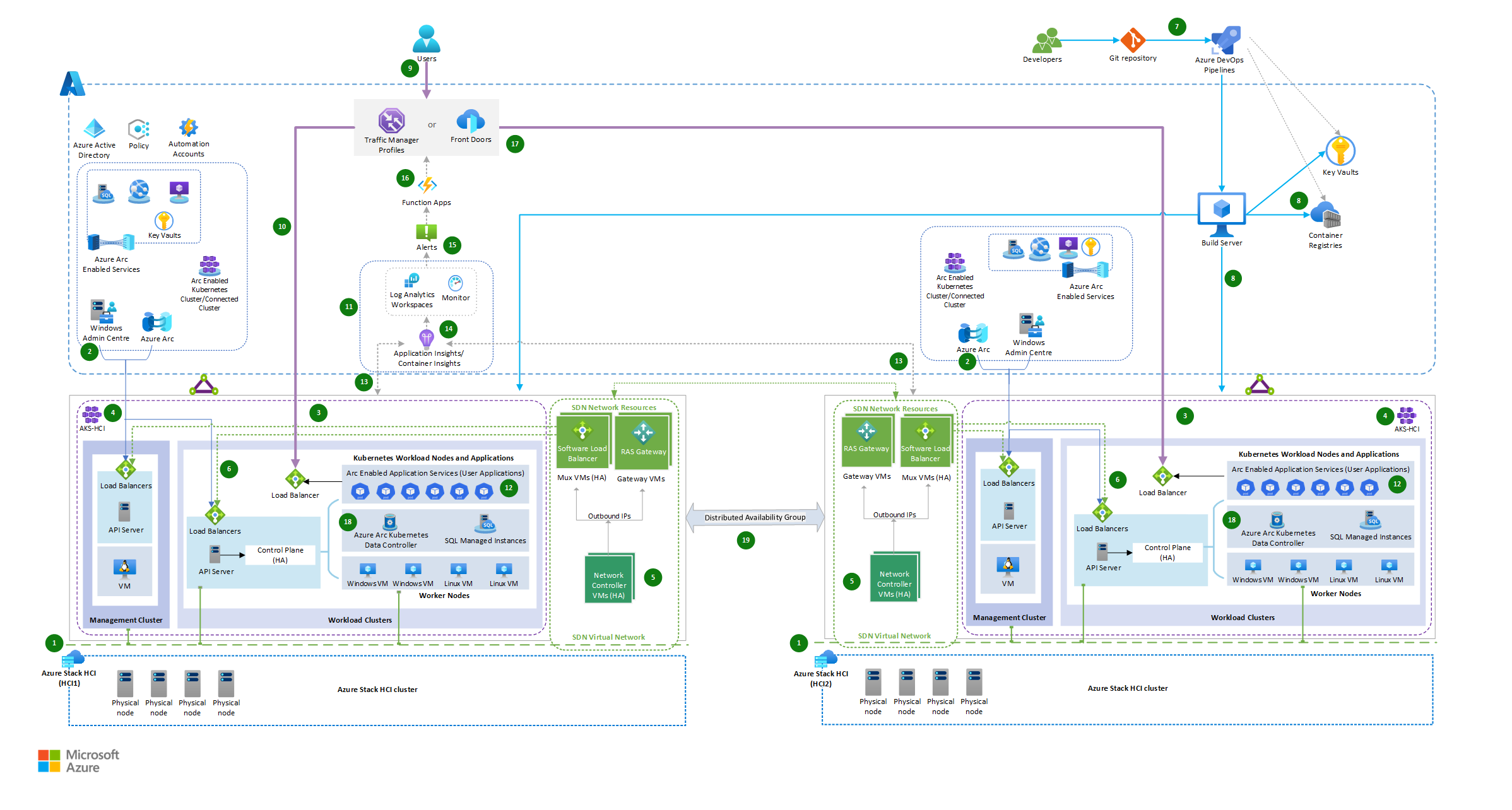

La arquitectura muestra la implementación de soluciones híbridas mediante servicios habilitados para Azure Arc en Azure Local, Azure Pipelines y la integración de un equilibrador de carga global y una aplicación de funciones de Azure.

Descargue un archivo Visio de esta arquitectura.

Flujo de trabajo

La arquitectura consta de los siguientes pasos:

Dos instancias de Azure Local se configuran en dos ubicaciones diferentes: Azure Local actúa como infraestructura local principal.

Las instancias locales de Azure se conectan a Azure a través de SD-WAN y se administran a través de Azure Arc y Windows Admin Center. Como resultado, puede ampliar las funcionalidades de Azure a la infraestructura local y usar herramientas y servicios de administración de Azure para administrar y supervisar la infraestructura y la carga de trabajo locales.

azure Kubernetes Service (AKS), implementado en Azure Local, se componen del clúster de administración (host de AKS) y de los clústeres de carga de trabajo (también conocidos como clústeres de destino) donde se implementan aplicaciones en contenedor. Consulte arquitectura de línea de base de Azure Kubernetes Service (AKS) para AKS en Azure Local.

El host de Azure Kubernetes Service en azure Local y el clúster de cargas de trabajo se implementa mediante módulos de PowerShell de AksHci. Consulte Uso de PowerShell para configurar Kubernetes en clústeres de Azure Local y Windows Server.

La virtualización de los recursos de red se implementa aplicando las funcionalidades de SDN de la instancia local de Azure. Implementa los recursos de infraestructura de red de SDN necesarios, como máquinas virtuales Mux de Software Load Balancer, máquinas virtuales de puerta de enlace RAS y controladores de red para lograr una mayor disponibilidad de red. Consulte Redes definidas por software (SDN) en Azure Local y Windows Server.

La infraestructura de AKS y las máquinas virtuales de carga de trabajo se implementan en una red virtual de SDN con equilibrio de carga híbrido logrado a través de SDN Software Load Balancer (SLB). Consulte el Implementación de redes definidas por software (SDN) de Microsoft con AKS en Azure Local.

Azure Pipelines implementa las aplicaciones de front-end con las mismas versiones de las aplicaciones en contenedor implementadas en ambos entornos locales de Azure Local.

Las bases de datos se hospedan en instancias administradas de SQL habilitadas para Arc implementadas en el entorno híbrido de AKS.

Un desarrollador empaqueta sus aplicaciones como contenedor para implementarse en clústeres híbridos de AKS mediante manifiestos de Kubernetes y módulos de PowerShell de AksHci y automatiza las tareas de implementación a través de Azure Pipelines.

Una solicitud de cliente a la aplicación se dirige mediante un servicio global de equilibrador de carga, como Azure Front Door o Azure Traffic Manager, que enruta la solicitud al punto de conexión de servicio adecuado mediante un método de enrutamiento de tráfico ponderado. En función del porcentaje ponderado asignado, el tráfico se distribuye a los servicios implementados en los dos clústeres híbridos de AKS en Stack HCI.

Traffic Manager y Azure Front Door son opciones viables para abordar las funcionalidades globales de equilibrio de carga debido a la presencia de clústeres en varias regiones. La selección entre Azure Front Door y Traffic Manager depende de varios factores y la decisión de recomendar una sobre la otra requiere una consideración cuidadosa. Estas son algunas razones para considerar diferentes servicios de equilibrio de carga:

- Si las aplicaciones accesibles desde Internet usan HTTPS, Azure Front Door es la opción preferible. Por lo general, Traffic Manager no es la opción principal en estas instancias. Aunque puede haber excepciones, los escenarios específicos quedan fuera del ámbito de este análisis.

- Si el objetivo principal es un equilibrio de carga global eficaz, Traffic Manager podría ser suficiente. Si también necesita optimización de distribución de contenido, seguridad de la capa de aplicación y funcionalidades de enrutamiento más avanzadas, Azure Front Door podría ser una mejor opción.

- Traffic Manager es más sencillo de configurar y se centra principalmente en el equilibrio de carga. Azure Front Door ofrece más características pero puede tener una curva de aprendizaje más pronunciada.

- Considere el tipo de aplicación. Si está más centrado en la Web y necesita optimizaciones como el almacenamiento en caché y la terminación SSL, Azure Front Door podría ser beneficioso.

- Con respecto al enrutamiento basado en DNS, la complejidad se reduce al tratar con el equilibrio de carga en el nivel de aplicación. Sin embargo, es fundamental tener en cuenta que confiar únicamente en el enrutamiento basado en DNS puede provocar un mayor tiempo de inactividad durante un error, lo que podría afectar negativamente a los acuerdos de nivel de servicio (SLA) de las aplicaciones. La decisión entre Azure Front Door y Traffic Manager debe tener en cuenta el Acuerdo de Nivel de Servicio de la solución DNS y si la aplicación puede adaptarse a los distintos tiempos de conmutación por error entre las dos opciones.

Las aplicaciones de carga de trabajo implementadas se supervisan para la carga mediante servicios habilitados para Azure Arc, Azure Monitor y área de trabajo de Log Analytics.

En condiciones de carga normales, la solicitud de cliente se enruta a la instancia de la aplicación hospedada localmente en el entorno del clúster principal.

Las cargas de trabajo de clúster de AKS habilitadas para Arc están diseñadas para escalar horizontalmente a varias instancias mediante el escalado automático integrado, que se escala o reduce verticalmente de forma automática el número de nodos del clúster de AKS implementado en función de la demanda.

Container Insights está habilitado para capturar diagnósticos y supervisar el rendimiento de la carga de trabajo en el clúster de Kubernetes hospedado en Azure Local.

Cuando hay un aumento del tráfico y el clúster de cargas de trabajo alcanza su número máximo de nodos sin más opciones de escalado de pods, genera una alerta para desencadenar una aplicación de funciones de Azure.

Se configura una regla de alerta para supervisar el resultado de una consulta de Kusto personalizada, que comprueba el número máximo de nodos y el porcentaje de preparación del pod de las tablas KubeNodeInventory y KubePodInventory de Azure Monitor. Consulte Creación de alertas de registro desde Container Insights.

La supervisión de Kubernetes también se puede realizar mediante reglas de alerta preconfiguradas desde Kubernetes Container Insights. También puede aplicar las reglas de métricas KubePodNotReady o KubeHpaMaxedOut de Container Insights para configurar las condiciones de las reglas de alerta. Consulte Reglas de alertas de métricas en Container Insights (versión preliminar) e invoque Azure Function App a través del grupo de acciones de la alerta.

Azure Function App administra dinámicamente las reglas de enrutamiento de tráfico ponderadas en función de la condición del clúster principal y redirige el tráfico al clúster.

- Puede usar Azure Function para calcular el porcentaje de tráfico que se debe redirigir en función de los límites de umbral predefinidos de la preparación del clúster y las condiciones de tráfico. Si lo hace, puede ayudarle a adaptarse a los cambios rápidamente, automatizar tareas, escalar recursos de forma eficaz y ahorrar dinero.

- Azure Function ayuda a administrar las reglas de enrutamiento de tráfico dinámicamente. Esta funcionalidad garantiza una alta disponibilidad, escalabilidad y rendimiento, y proporciona una experiencia de usuario sin problemas incluso durante los escenarios de tráfico máximo y conmutación por error. Por ejemplo, la distribución inicial del tráfico comienza por dirigir el 100 % del tráfico al clúster principal cuando funciona bien y es capaz de controlar la carga. Cuando el clúster principal está casi lleno o experimenta una degradación del rendimiento, puede ajustar las reglas de enrutamiento del tráfico dentro de Azure Function. Al hacerlo, se redirige parte del tráfico de solo lectura al clúster secundario.

Las instancias de aplicación que se ejecutan en ambos entornos de clúster se conectan a los servicios de datos, como instancias administradas de SQL habilitadas para Arc, localmente dentro de sus respectivos clústeres.

La sincronización de datos entre los clústeres de Arc SQL Managed Instances se rige por el grupo de conmutación por error de Azure, que a su vez usa los grupos de disponibilidad distribuidos. La sincronización entre clústeres puede ser sincrónica o asincrónica. Consulte SQL Managed Instance habilitado para Azure Arc.

En general, este flujo de trabajo implica compilar e implementar aplicaciones, equilibrio de carga, administración del tráfico, escalado automático y sincronización de datos en varios entornos de clúster. Esta configuración permite escalar la infraestructura horizontalmente entre clústeres en dos centros de datos o ubicaciones diferentes, lo que proporciona seguridad, redundancia, flexibilidad y uso eficaz de los recursos.

Componentes

Azure Front Door es un equilibrador de carga de capa 7. En esta arquitectura, enruta las solicitudes HTTP a las aplicaciones web implementadas en el clúster de Stack HCI. También puede usar un firewall de aplicación web (WAF) con Azure Front Door que proteja la aplicación de vulnerabilidades de seguridad y otras vulnerabilidades comunes, y una solución de Content Delivery Network (CDN) en este diseño para reducir la latencia y mejorar el tiempo de carga del contenido almacenándolo en caché en las ubicaciones perimetrales.

Traffic Manager es un equilibrador de carga de tráfico basado en DNS y una opción viable de equilibrio de carga. Úselo para controlar la distribución del tráfico de las aplicaciones a los puntos de conexión del servicio en diferentes centros de datos. Aquí le explicamos cómo funciona la configuración de Traffic Manager:

- Configure Traffic Manager, una solución global de equilibrio de carga en Azure, para distribuir el tráfico entrante entre las instancias locales de Azure. Traffic Manager puede configurarse para usar diferentes métodos de equilibrio de carga, como el rendimiento, la conmutación por error o el round-robin ponderado, en función de los requisitos.

- Cree puntos de conexión de Traffic Manager que correspondan a los puntos de conexión de las cargas de trabajo implementadas en instancias locales de Azure. Esto permite a Traffic Manager dirigir el tráfico al punto de conexión adecuado. En este escenario, dirija el tráfico en función del método de equilibrio de carga de enrutamiento ponderado.

- En función de las directivas de escalado calculadas a través de una función de Azure, cuando se necesita una capacidad adicional o alta disponibilidad, Traffic Manager puede enrutar dinámicamente el tráfico a otras instancias en función de las reglas de enrutamiento y sus porcentajes ponderados.

Application Insights recopila datos de telemetría de varios componentes implementados en esta solución híbrida. Proporciona información y análisis que se pueden usar para identificar problemas, optimizar el rendimiento y mejorar la experiencia del usuario.

Azure Functions actúa como orquestador para la distribución del tráfico. Supervisa las condiciones de preparación de cada clúster, evaluando factores como el uso de recursos, la latencia y el estado. Basándose en esta evaluación, la aplicación de funciones decide hacia dónde dirigir el tráfico entrante.

Azure Local es una solución de clúster de infraestructura hiperconvergida (HCI) que hospeda cargas de trabajo virtualizadas de Windows y Linux y su almacenamiento en un entorno híbrido que combina la infraestructura local con los servicios de Azure.

- La solución usa Arc-Enabled Azure Kubernetes Service en Azure Local para hospedar la aplicación web o las API, Arc-Enabled servidores de Azurey Arc-Enabled Data Services en ambos entornos.

Azure DevOps Services actúa como la base de esta estrategia de implementación de soluciones híbridas, lo que proporciona la automatización y la orquestación necesarias para simplificar todo el ciclo de vida de entrega de software. Permite a los equipos de desarrollo centrarse en ofrecer código de alta calidad, mientras que la canalización se encarga de crear, probar e implementar aplicaciones.

Para implementar un clúster de AKS en Azure Local, puede configurar un servidor de compilación en Azure Pipelines. El servidor de compilación es responsable de ejecutar el proceso de implementación.

a. Cree una máquina virtual (VM) dentro de Azure o una máquina virtual desde el entorno de Stack HCI. O bien, use una máquina virtual local existente como servidor de compilación si tiene conectividad de red con las infraestructuras híbridas.

b. Instale las herramientas necesarias en el servidor de compilación, como Git, la CLI de Azure y los módulos de Azure PowerShell.

c. Configure la autenticación en Azure mediante la configuración de entidades de servicio o mediante identidades administradas.

Azure Pipelines es un servicio que proporciona CI/CD y administra las definiciones y agentes de compilación y versión hospedados. La canalización de desarrollo puede usar varios repositorios de código, incluidos GitHub, Bitbucket, Dropbox, OneDrive y Azure Repos.

Azure Monitor recopila datos de telemetría y supervisa el rendimiento de los clústeres y las cargas de trabajo. También le permite configurar alertas para desencadenar una función de Azure o notificar a un administrador si algún clúster se vuelve incorrecto o si se superan los umbrales predefinidos. Puede usar Azure Automation o Azure Logic Apps para automatizar las acciones de escalado en función de los datos de supervisión.

Azure Policy actúa como un aplicador de gobernanza y cumplimiento, lo que garantiza que los clústeres de Stack HCI y los recursos de SDN asociados funcionan dentro de las directrices y estándares definidos. Estos son algunos ejemplos para mejorar la seguridad del entorno mediante Azure Policy:

- Aplicación del complemento de Container Insight

- Instalación de extensiones esenciales en clústeres de Stack HCI

- Aplicación del etiquetado de recursos

- Control de acceso basado en directivas

- Directivas relacionadas con redes y supervisión

Azure Container Registry es un servicio privado administrado del registro de Docker en Azure. Utilice Container Registry para almacenar imágenes de Docker privadas, que se implementan en el clúster.

Azure Arc amplía los servicios de Azure a entornos locales, lo que permite a las organizaciones beneficiarse de las funcionalidades de la nube, a la vez que mantiene la información confidencial dentro de su propia infraestructura.

Container Insights es una solución de supervisión y observabilidad proporcionada por Azure Monitor que permite obtener información sobre el rendimiento y el estado de los contenedores que se ejecutan en clústeres de AKS. Con Azure Arc habilitado para AKS, puede ampliar las funcionalidades de Container Insights para supervisar y administrar los clústeres de AKS que se ejecutan fuera de Azure, como para entornos locales o multinube.

SQL Managed Instances habilitado para Arc es un servicio de datos de Azure SQL que se puede crear en la infraestructura de Stack HCI y administrar mediante Azure Arc.

Azure Key Vault le permite almacenar y administrar de forma segura claves criptográficas, secretos y certificados. Aunque Azure Key Vault es principalmente un servicio en la nube, también se puede usar con implementaciones locales de Azure para almacenar y administrar información confidencial de forma segura en el entorno local.

Infraestructura de SDN. En una implementación híbrida de AKS en Azure Local, el equilibrio de carga se logra mediante el SDN de Equilibrador de carga de software (SLB). SLB administra la infraestructura y las aplicaciones de AKS-HCI dentro de la red virtual de SDN (redes definidas por software), incluidos los recursos de infraestructura de red de SDN necesarios, como las máquinas virtuales del equilibrador de carga Mux, las máquinas virtuales de puerta de enlace y los controladores de red.

Este es un desglose de los componentes implicados:

- Software Load Balancer (SLB): SLB es un componente clave de la infraestructura de AKS-HCI que proporciona funcionalidades de equilibrio de carga para distribuir el tráfico de red a las aplicaciones que se ejecutan en el clúster. Funciona en la capa de transporte (nivel 4) y dirige el tráfico en función de las reglas configuradas.

- Máquinas virtuales del equilibrador de carga Mux: las máquinas virtuales del equilibrador de carga Mux son máquinas virtuales que controlan el tráfico de red entrante desde orígenes externos y la distribuyen a los pods o servicios de back-end adecuados dentro del clúster de AKS-HCI. Funcionan con SLB para realizar el equilibrio de carga.

- Máquinas virtuales de puerta de enlace: las máquinas virtuales de puerta de enlace proporcionan conectividad entre el clúster de AKS-HCI y las redes externas. Actúan como un puente entre la red virtual de SDN interna y las redes externas, lo que permite que el flujo de tráfico de entrada y salida sea seguro.

- Controladores de red: los controladores de red son responsables de administrar la infraestructura de SDN dentro del clúster de AKS-HCI. Controlan tareas como la aplicación de directivas de red, la configuración de red y la configuración del equilibrador de carga.

Mediante el uso de SLB, máquinas virtuales del equilibrador de carga Mux, máquinas virtuales de puerta de enlace y controladores de red, AKS-HCI logra el equilibrio de carga para implementaciones híbridas. Garantiza que el tráfico de red entrante se distribuya eficazmente entre las aplicaciones que se ejecutan en el clúster, lo que proporciona alta disponibilidad y escalabilidad.

Nota:

AKS-HCI administra y configura estos componentes, lo que le permite centrarse en la implementación y administración de las aplicaciones mientras usa las funcionalidades integradas de equilibrio de carga de la plataforma.

Alternativas

En el caso de aplicaciones web y servicios basados en eventos, puede ejecutar App Service, Functions y Logic Apps en un clúster de Kubernetes habilitado para Azure Arc hospedado en Azure Local. En el caso de la base de datos, puede usar otra opción de almacenamiento, como el servidor PostgreSQL habilitado para Azure Arc.

En el caso de las aplicaciones web, puede usar Azure Front Door. Azure Front Door funciona en la capa 7, la capa HTTP/HTTPS. Usa el protocolo de difusión con TCP dividido y la red global de Microsoft para mejorar la conectividad global. Según el método de enrutamiento, puede asegurarse de que Azure Front Door enrute las solicitudes de cliente al back-end de aplicación más rápido y disponible.

Azure ExpressRoute le permite conectar su red local directamente a recursos de Azure mediante una conexión de red privada dedicada.

Si el repositorio está en GitHub, puede usar acciones de GitHub en lugar de Azure Pipelines.

Detalles del escenario

El objetivo principal es facilitar el escalado entre clústeres mediante la distribución eficaz de cargas de trabajo entre clústeres situados en dos centros de datos o ubicaciones diferentes. Este enfoque impide la sobrecarga de cualquier clúster único y optimiza el uso de recursos en todos los clústeres. La aplicación de funciones de Azure desempeña un papel fundamental en la distribución inteligente del tráfico en función de las condiciones de preparación del clúster, lo que mejora la eficacia, la escalabilidad, la disponibilidad y el rendimiento.

Este escenario es aplicable a las organizaciones que tratan con un conjunto estricto de restricciones, regulaciones de soberanía de datos o necesidades cruciales de resistencia y continuidad empresarial o control de cargas de trabajo críticas en entornos altamente restringidos y regulados, como bancos, finanzas, defensa y gobierno. Debido a las directivas normativas y de cumplimiento de las organizaciones, las aplicaciones y las bases de datos se ejecutan en el entorno local para evitar exponer datos confidenciales en la nube pública. Esta solución es útil cuando:

Las aplicaciones locales experimentan picos de uso durante la temporada alta y se escalan automáticamente dentro del clúster, pero el clúster primario alcanza el 100 % de su capacidad y quiere desviar el tráfico desbordado a otro clúster del centro de datos sin interrumpir la ejecución de ningún servicio.

Quiere resolver el reenrutamiento del tráfico de aplicaciones o API automáticamente al entorno local más cercano disponible.

Quiere simplificar la gobernanza y la administración de la configuración local y acceder a los servicios en la nube pertinentes que se filtran a través de un firewall o servidor proxy de forma coherente y segura a través de los servicios habilitados para Azure Arc implementados en Azure Local.

Posibles casos de uso

- Quiere implementar cargas de trabajo de alta disponibilidad, escalables, protegidas y restringidas en un entorno de instancia local de Azure Local.

- Quiere el escalado dinámico de aplicaciones en ejecución entre los centros de datos siempre que las aplicaciones locales experimenten picos en sus usos.

- Quiere aplicar la automatización basada en la nube con administración centralizada, gobernanza y supervisión.

- Tiene componentes locales y quiere usar otra configuración local para escalarlos.

- Quiere que la escalabilidad entre clústeres dinámica ejecute las aplicaciones en el entorno local hasta el momento en que pueda ampliar el escalado de las cargas de trabajo a las instancias en la nube.

Consideraciones

Estas consideraciones implementan los pilares del marco de buena arquitectura de Azure, que es un conjunto de principios guía que se pueden usar para mejorar la calidad de una carga de trabajo. Para más información, consulte Marco de buena arquitectura de Microsoft Azure.

Confiabilidad

La confiabilidad garantiza que la aplicación pueda cumplir los compromisos contraídos con los clientes. Para más información, consulte Resumen del pilar de fiabilidad.

Una empresa puede adoptar un enfoque híbrido para mantener sus sistemas manteniendo aplicaciones y recursos en el entorno local por motivos normativos y de rendimiento. Si quieren aplicar funcionalidades en la nube de Azure, pueden implementar la misma versión de las aplicaciones hospedadas en el clúster de Azure HCI en varias regiones. De este modo, cumple con su obligación de ofrecer servicios de alta disponibilidad y escalabilidad.

Seguridad

La seguridad proporciona garantías contra ataques deliberados y el abuso de datos y sistemas valiosos. Para más información, consulte Introducción al pilar de seguridad.

Al implementar AKS-HCI, es esencial tener en cuenta las prácticas de seguridad para ayudar a proteger las aplicaciones y la infraestructura. Estas son algunas consideraciones clave de seguridad para AKS-HCI:

Protección del acceso al clúster

- Limite el acceso al clúster de AKS-HCI siguiendo el principio de privilegios mínimos. Conceda solo permisos necesarios a usuarios, grupos o cuentas de servicio.

- Use mecanismos de autenticación seguros, como la integración de Microsoft Entra, Microsoft Entra Pod Identity o el control de acceso basado en rol de Kubernetes (RBAC de Kubernetes) para controlar el acceso al clúster y sus recursos.

- Considere la posibilidad de implementar la autenticación multifactor (MFA) para el acceso al clúster para agregar una capa adicional de seguridad.

Seguridad de las redes

- Implemente la segmentación de red y el aislamiento dentro del clúster de AKS-HCI mediante directivas de red de Kubernetes o grupos de seguridad de red de Azure.

- Controle el tráfico entrante y saliente con firewalls de nivel de red, como Azure Firewall, y restrinja el acceso en función de la lista de direcciones IP permitidas o el emparejamiento de red virtual.

- Cifre el tráfico de red entre servicios mediante la autenticación de Seguridad de la capa de transporte (TLS) o TLS mutua (mTLS).

Seguridad de la imagen de contenedor

- Use imágenes de contenedor seguras de orígenes de confianza y actualícelas periódicamente con las últimas revisiones de seguridad y correcciones de vulnerabilidades.

- Implemente herramientas de análisis de imágenes y evaluación de vulnerabilidades para identificar y corregir los problemas de seguridad en las imágenes de contenedor.

- Use mecanismos de verificación y firma de imágenes de contenedor para garantizar la integridad y la autenticidad de las imágenes.

Administración de secretos

- Evite codificar de forma rígida información confidencial (como contraseñas, claves de API o cadenas de conexión) en el código de la aplicación o los archivos de configuración.

- Use Azure Key Vault o una solución de administración segura de secretos para almacenar y recuperar información confidencial de forma segura.

- Use secretos de Kubernetes o integración de Azure Key Vault para insertar secretos de forma segura en los contenedores de aplicaciones.

Registro y supervisión

- Implemente el registro y la supervisión centralizados para los clústeres de AKS-HCI mediante Azure Monitor o soluciones de terceros.

- Configure los registros de auditoría, los registros de contenedor y los registros del sistema para capturar eventos de seguridad críticos.

- Configure mecanismos de alertas y notificaciones para detectar y responder proactivamente a incidentes de seguridad o anomalías.

Actualizaciones y aplicación de revisiones periódicas

- Mantenga actualizados los nodos de clúster de AKS-HCI y la infraestructura subyacente con las actualizaciones y revisiones de seguridad más recientes.

- Establezca un proceso de administración de revisiones para garantizar la aplicación oportuna de las correcciones de seguridad.

Consideraciones normativas y de cumplimiento

- Comprenda y cumpla con las normativas de seguridad y cumplimiento específicas del sector pertinentes (como HIPAA o PCI DSS) en función de los requisitos de su organización.

- Implemente controles y prácticas de seguridad para cumplir los estándares de cumplimiento aplicables a su sector.

Optimización de costos

La optimización de costos trata de buscar formas de reducir los gastos innecesarios y mejorar las eficiencias operativas. Para más información, vea Información general del pilar de optimización de costos.

Algunas consideraciones de optimización de costos para implementar servicios habilitados para Arc en Azure Local:

- Ajuste el tamaño correcto de los nodos de clúster de AKS-HCI en función de los requisitos reales de carga de trabajo para evitar el sobreaprovisionamiento o la infrautilización.

- El escalado automático de AKS-HCI ayuda a optimizar la asignación de recursos y reduce los costos durante períodos de baja demanda. Configure el escalado automático horizontal de pods (HPA) en función de los patrones de demanda y carga de trabajo para escalar automáticamente el número de pods del clúster de AKS-HCI.

-

Optimización del almacenamiento:

- Elija las opciones de almacenamiento adecuadas en función de los requisitos de carga de trabajo y las necesidades de rendimiento.

- Considere la posibilidad de usar Azure Disk Storage para volúmenes persistentes o Azure Files para el almacenamiento de archivos compartido.

- Optimice las configuraciones de almacenamiento, por ejemplo ajustando el tamaño y el tipo de discos en función de las demandas de carga de trabajo.

-

Etiquetado y administración de grupos de recursos:

- Implemente el etiquetado coherente de recursos para realizar un seguimiento de los recursos y clasificarlos.

- Use grupos de recursos para organizar lógicamente los recursos, lo que facilita la administración y el seguimiento de los costos.

-

Supervisión y optimización de costos continuas:

- Revise periódicamente los informes de costos y los paneles proporcionados por Microsoft Cost Management para identificar las oportunidades de ahorro de costos y optimizar los gastos.

- Use herramientas como Azure Advisor para recibir recomendaciones para optimizar el uso de recursos, mejorar la seguridad y reducir los costos.

- Reduzca los esfuerzos de implementación y mantenimiento con Azure DevOps Services.

Excelencia operativa

La excelencia operativa abarca los procesos de las operaciones que implementan una aplicación y la mantienen en ejecución en producción. Para más información, consulte Introducción al pilar de excelencia operativa.

Eficiencia del rendimiento

La eficiencia del rendimiento es la capacidad de la carga de trabajo para escalar con el fin de satisfacer de manera eficiente las demandas que los usuarios hayan ejercido sobre ella. Para obtener más información, vea Resumen del pilar de eficiencia del rendimiento.

La principal ventaja del escalado entre clústeres es la capacidad de ofrecer escalado a petición con entornos locales junto con un control completo sobre la configuración dentro de la red protegida de la organización.

Colaboradores

Microsoft mantiene este artículo. Originalmente lo escribieron los siguientes colaboradores.

Creadores de entidad de seguridad:

Mayuri Bhavsar | Arquitecto sénior de soluciones en la nube

Vidya Narasimhan | Arquitecto principal de soluciones en la nube

Otros colaboradores:

Himanshu Amodwala | Arquitecto sénior de soluciones en la nube

Nakul Joshi | Administrador principal de ingeniería de software

Vineeth Marar | Arquitecto sénior de soluciones en la nube

Para ver los perfiles no públicos de LinkedIn, inicie sesión en LinkedIn.

Pasos siguientes

- Patrón de alta disponibilidad de Kubernetes mediante Azure y Azure Stack Hub

- Documentación de Azure Kubernetes Service (AKS)