¿Cómo funciona la Seguridad del contenido de Azure AI?

La Seguridad del contenido de Azure AI funciona con texto e imágenes y contenido generado por IA.

Las funcionalidades de visión de seguridad de contenido se potencian con el modelo base Florence de Microsoft, que se ha entrenado con miles de millones de pares de imágenes de texto. El análisis de texto usa técnicas de procesamiento de lenguaje natural, lo que proporciona una mejor comprensión de los matices y el contexto. La Seguridad del contenido de Azure AI es multilingüe y puede detectar contenido dañino en formato corto y largo. Actualmente está disponible en inglés, alemán, español, francés, portugués, italiano y chino.

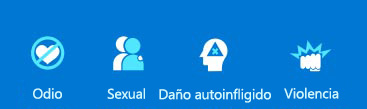

La seguridad del contenido de Azure AI clasifica el contenido en cuatro categorías:

Se usa un nivel de gravedad para cada categoría para determinar si el contenido debe bloquearse, enviarse a un moderador o aprobarse automáticamente.

Las características de seguridad de contenido de Azure AI incluyen:

Protección del contenido de texto

Texto moderado examina texto en cuatro categorías: violencia, odio de voz, contenido sexual y auto-daño. Se devuelve un nivel de gravedad de 0 a 6 para cada categoría. Este nivel ayuda a priorizar lo que necesita atención inmediata por parte de las personas y la urgencia. También puede crear una lista de bloqueados para buscar términos específicos de su situación.

Escudos de aviso es una API unificada para identificar y bloquear ataques de liberación de entradas a LLMs. Incluye tanto la entrada del usuario como los documentos. Estos ataques son avisos a los LLM que intentan omitir las características de seguridad integradas del modelo. Las solicitudes de usuario se prueban para asegurarse de que la entrada en LLM es segura. Los documentos se prueban para asegurarse de que no contienen instrucciones no seguras insertadas en el texto.

Detección de materiales protegidos comprueba el texto generado por IA para texto protegido, como recetas, letras de canciones protegidas u otro material original.

Detección de terreno protege frente a respuestas inexactas en texto generado por IA por LLMs. Los LLM públicos usan los datos disponibles en el momento en que se entrenaron. Sin embargo, los datos se pueden introducir después del entrenamiento original del modelo o se pueden compilar en datos privados. Una respuesta con base es una en la que la salida del modelo se basa en la información de origen. Una respuesta en primer plano es una en la que la salida del modelo varía de la información de origen. La detección de la base incluye una opción de razonamiento en la respuesta de la API. Esto agrega un razonamiento campo que explica cualquier detección de no en primer plano. Sin embargo, el razonamiento aumenta el tiempo de procesamiento y los costos.

Protección del contenido de la imagen

Moderación de imágenes busca contenido inapropiado en cuatro categorías: violencia, autolesión, sexo y odio. Se devuelve un nivel de gravedad: seguro, bajo o alto. A continuación, establezca un nivel de umbral de bajo, medio o alto. La combinación del nivel de gravedad y umbral determina si la imagen está permitida o bloqueada para cada categoría.

Moderación del contenido bidireccional examina tanto las imágenes como el texto, incluido el texto extraído de una imagen mediante el reconocimiento óptico de caracteres (OCR). El contenido se analiza en cuatro categorías: violencia, odio de voz, contenido sexual y auto-daño.

Soluciones de seguridad personalizadas

Categorías personalizadas le permite crear sus propias categorías proporcionando ejemplos positivos y negativos y entrenando el modelo. A continuación, el contenido se puede examinar según sus propias definiciones de categoría.

Mensaje del sistema de seguridad le ayuda a escribir mensajes eficaces para guiar el comportamiento de un sistema de inteligencia artificial.

Limitaciones

La seguridad del contenido de Azure AI usa algoritmos de inteligencia artificial, por lo que es posible que no siempre detecte un idioma inadecuado. Y, en ocasiones, podría bloquear el lenguaje aceptable porque se basa en algoritmos y aprendizaje automático para detectar lenguaje problemático.

La Seguridad del contenido de Azure AI debe probarse y evaluarse en datos reales antes de implementarse. Y una vez implementado, debe seguir supervisando el sistema para ver con precisión su rendimiento.

Evaluación de la precisión

Al evaluar la precisión de la Seguridad del contenido de Azure AI para su situación, compare su rendimiento con cuatro criterios:

- Verdadero positivo: identificación correcta del contenido dañino.

- Falso positivo: identificación incorrecta del contenido dañino.

- Verdadero negativo: identificación correcta del contenido inofensivo.

- Falso negativo: no se identifica el contenido dañino.

La Seguridad del contenido de Azure AI funciona mejor para admitir a moderadores humanos que pueden resolver casos de identificación incorrecta. Cuando las personas agregan contenido a un sitio, no esperan que las publicaciones se quiten sin motivo. Comunicarse con los usuarios sobre por qué el contenido se quita o marca como inapropiado ayuda a todos a comprender lo que está permitido y lo que no es.