Mitigación de daños posibles

Después de determinar una base de referencia y una manera de medir la salida dañina que genera una solución, puede tomar medidas para mitigar los daños posibles y, cuando sea necesario, volver a probar el sistema modificado y comparar los niveles de daño con la base de referencia.

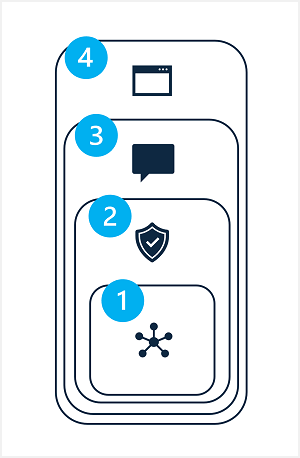

La mitigación de los daños posibles en una solución de inteligencia artificial generativa implica un enfoque por capas, en el que se pueden aplicar técnicas de mitigación en cada una de las cuatro capas, tal como se muestra aquí:

- Modelo

- Sistema de seguridad

- Metaprompt y fundamentación

- Experiencia del usuario

1: La capa Modelo

La capa Modelo consta de uno o varios modelos de IA generativa en el centro de la solución. Por ejemplo, la solución se puede crear en torno a un modelo como GPT-4.

Las mitigaciones que puede aplicar en la capa Modelo incluyen:

- Seleccionar un modelo adecuado para el uso previsto de la solución. Por ejemplo, si bien GPT-4 puede ser un modelo eficaz y versátil, en una solución que solo necesita clasificar entradas de texto pequeñas específicas, un modelo más simple podría proporcionar la funcionalidad necesaria con menor riesgo de generar contenido perjudicial.

- Ajustar un modelo fundacional con sus propios datos de entrenamiento para que las respuestas que genere tengan más probabilidades de ser pertinentes y ajustadas al ámbito del escenario de la solución.

2: La capa Sistema de seguridad

La capa Sistema de seguridad incluye configuraciones y funcionalidades en el nivel de plataforma que ayudan a mitigar los daños. Por ejemplo, Inteligencia artificial de Azure Studio incluye compatibilidad con filtros de contenido que aplican criterios para suprimir solicitudes y respuestas en función de la clasificación de contenido en cuatro niveles de gravedad (seguro, bajo, medio y alto) para cuatro categorías de daño posible (odio, sexual, violencia y autolesiones).

Otras mitigaciones de la capa Sistema de seguridad pueden incluir algoritmos de detección de abusos para determinar que se abusa sistemáticamente de la solución (por ejemplo, a través de grandes volúmenes de solicitudes automatizadas de un bot) y notificaciones de alerta que permiten una respuesta rápida a abusos posibles del sistema o comportamientos dañinos.

3: La capa de metaprompt y fundamentación

La capa de metaprompt y fundamentación se centra en la construcción de las solicitudes que se envían al modelo. Las técnicas de mitigación de daños que puede aplicar en esta capa incluyen:

- Especificar metaprompts o entradas del sistema que definen parámetros de comportamiento para el modelo.

- Aplicar la ingeniería de solicitudes para agregar datos de base a las solicitudes de entrada, maximizando la probabilidad de una salida relevante y no perjudicial.

- Usar un enfoque de generación aumentada de recuperación (RAG) para recoger datos contextuales de orígenes de datos fiables e incluirlos en las solicitudes.

4: La capa de experiencia del usuario

El nivel de experiencia del usuario incluye la aplicación de software a través de la cual los usuarios interactúan con el modelo de IA generativa, así como documentación u otro material adjunto de usuario que describe el uso de la solución para sus usuarios y partes interesadas.

Diseñar la interfaz de usuario de la aplicación para restringir entradas a temas o tipos específicos, o aplicar la validación de entrada y salida puede mitigar el riesgo de respuestas potencialmente dañinas.

La documentación y otras descripciones de una solución de inteligencia artificial generativa deben ser adecuadamente transparentes sobre las funcionalidades y limitaciones del sistema, los modelos en los que se basa y los daños posibles que pueden no abordarse siempre a través de las medidas de mitigación que se implementaron.