Depurar canalizaciones de Data Factory

Los requisitos y las expectativas de los clientes en cuanto a la integración de datos están cambiando. Por tanto, la necesidad de los usuarios de desarrollar y depurar sus flujos de trabajo de extracción, transformación y carga de datos (ETL) y de extracción, carga y transformación (ELT) de forma iterativa es cada más imperativa.

Azure Data Factory puede ayudarle a compilar y desarrollar canalizaciones de Data Factory de depuración iterativas al desarrollar una solución de integración de datos. Al crear una canalización con el lienzo de la canalización, podrá probar sus actividades y canalizaciones mediante la funcionalidad de depuración.

En Azure Data Factory, no es necesario publicar los cambios en la canalización o las actividades antes de depurar. Esto resulta útil en un escenario en el que desee probar los cambios y ver si funcionan según lo esperado antes de guardarlos y publicarlos realmente.

A veces, no desea depurar toda la canalización, sino probar solo una parte de ella. Una ejecución de depuración permite hacer exactamente eso. Puede probar la canalización de principio a fin o establecer un punto de interrupción. Si lo hace con el modo de depuración, puede ver de forma interactiva los resultados de cada paso mientras compila y depura la canalización.

Depuración y publicación de una canalización

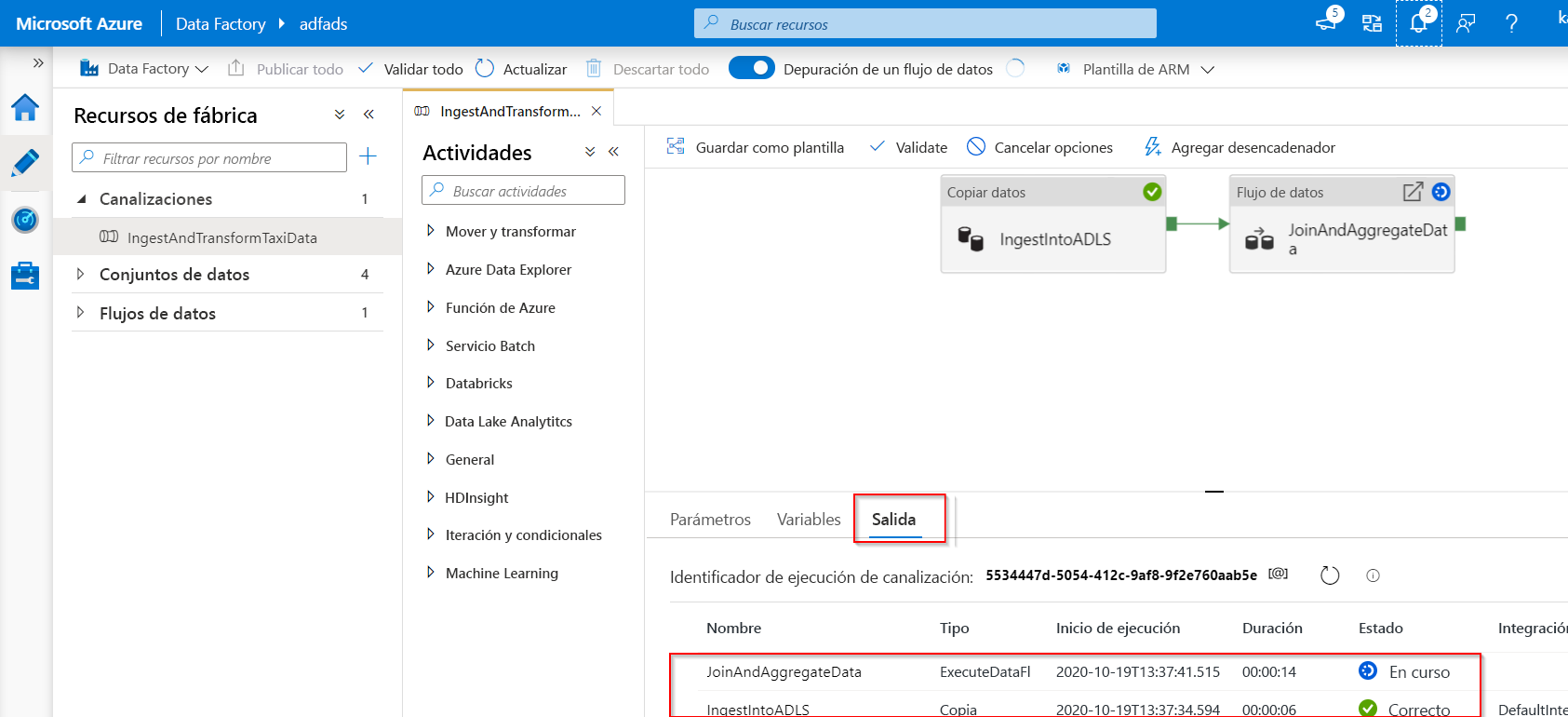

A medida que crea o modifica una canalización que se está ejecutando, podrá ver los resultados de cada actividad en la pestaña Salida del lienzo de la canalización.

Una vez que la serie de pruebas se ejecuta correctamente y quede satisfecho con los resultados, puede agregar más actividades a la canalización y continuar la depuración de manera iterativa. Si no queda conforme o quiere evitar que la canalización se depure, puede cancelar una serie de pruebas mientras está en curso. Tenga en cuenta que al seleccionar el control deslizante de depuración, la canalización se ejecutará. Por tanto, si por ejemplo la canalización contiene una actividad de copia, la serie de pruebas copiará los datos del origen al destino.

Un procedimiento recomendado consiste en usar carpetas de prueba en las actividades de copia y otras actividades al depurar, de modo que cuando quede satisfecho con los resultados y haya depurado la canalización, cambie a las carpetas reales de las operaciones normales.

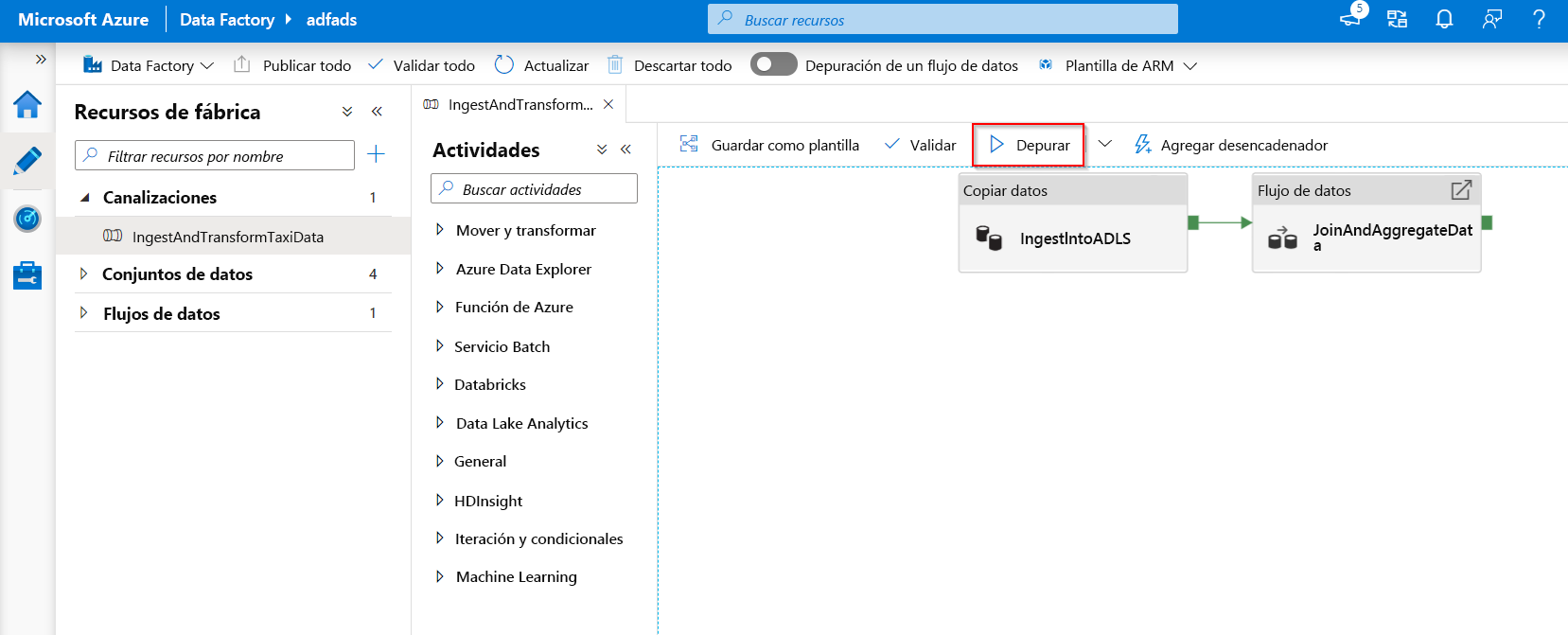

Para depurar la canalización, seleccione Depurar en la barra de herramientas. Verá el estado de ejecución de la canalización en la pestaña Output (Salida) en la parte inferior de la ventana.

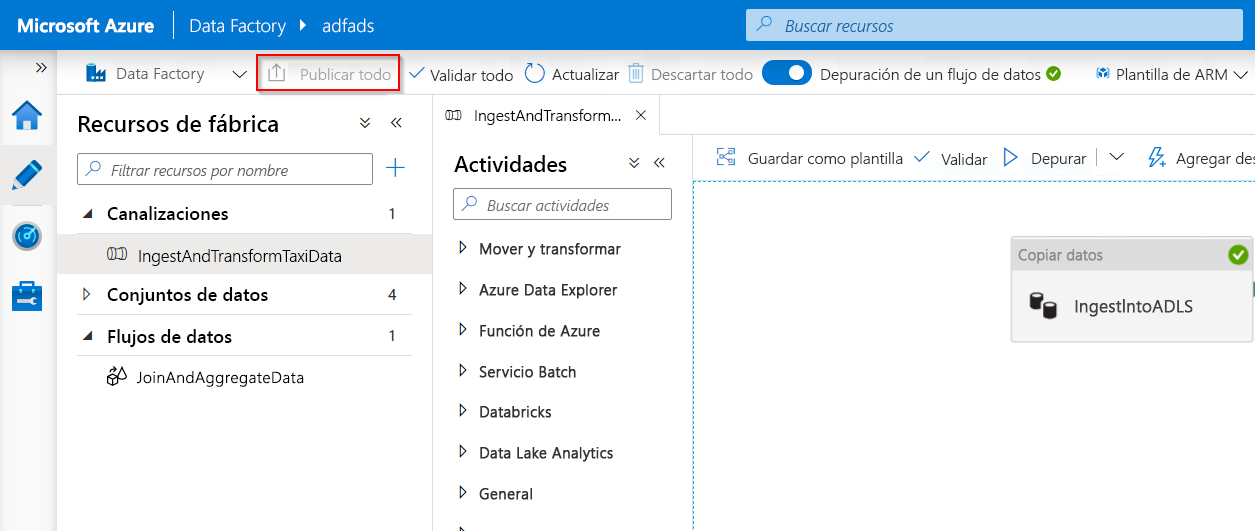

Después de que la canalización se puede ejecutar correctamente, en la barra de herramientas superior, seleccione Publicar todo. Esta acción publica las entidades (conjuntos de datos y canalizaciones) que creó para Data Factory.

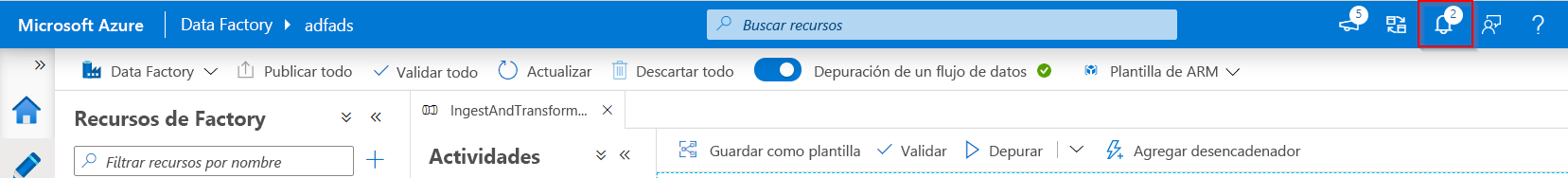

Espere a que aparezca el mensaje de publicación correcta. Para ver los mensajes de notificación, seleccione Mostrar notificaciones (icono de campana) en la parte superior derecha del portal (botón de campana).

Depuración del flujo de datos de asignación

Durante la compilación de flujos de datos de asignación, puede ver de forma interactiva cómo se ejecutan las transformaciones y formas de datos para que pueda depurarlas. Para usar esta funcionalidad, primero es necesario activar la característica "Data Flow Debug" (Depuración del flujo de datos).

La sesión de depuración se puede usar tanto en las sesiones de diseño de Data Flow como durante la ejecución de depuración de canalizaciones de flujos de datos. Una vez que el modo de depuración esté activado, compilará el flujo de datos con un clúster de Spark activo. El clúster de Spark se cerrará una vez que la depuración esté desactivada. Entonces, podrá elegir qué proceso utilizar. Cuando se usa un clúster de depuración, se reducirá el tiempo de inicio. Sin embargo, para cargas de trabajo complejas o paralelas, recomendamos que ponga en marcha su propio clúster Just-in-Time.

Para los flujos de datos de depuración se recomienda mantener el modo de depuración activado y comprobar y validar la lógica de negocios incluida en el flujo de datos. Poder consultar visualmente las transformaciones y formas de datos ayuda a ver los cambios.

Si quiere probar el flujo de datos en una canalización que ha creado, es mejor usar el botón Depurar del panel de la canalización. Aunque la vista previa de datos no escribe datos, una ejecución de depuración dentro del flujo de datos escribirá los datos en el destino del receptor, al igual que cuando se depura una canalización.

Configuración de depuración

Como se ha descrito antes, cada sesión de depuración que se inicia desde la interfaz de usuario de Azure Data Factory se considera una sesión nueva con su propio clúster de Spark. Para supervisar las sesiones, puede usar la vista de supervisión de la sesión de depuración a fin de administrar las sesiones de depuración que ha configurado Data Factory.

Para ver si un clúster de Spark está listo para depurarse, puede comprobar la indicación de estado del clúster en la parte superior de la superficie de diseño. Si es de color verde, está listo. Si el clúster no estaba en ejecución al activar el modo de depuración, el tiempo de espera podría ser de entre 5 y 7 minutos, ya que los clústeres deben ponerse en marcha.

Cuando termine la depuración, un procedimiento recomendado consiste en desactivar el modo de depuración para que finalice el clúster de Spark.

Durante la depuración, puede editar la vista previa de datos en un flujo de datos si selecciona Configuración de depuración. Algunos ejemplos de cambios en la vista previa de datos podrían ser un límite de filas o un origen de archivo, en caso de que se usen transformaciones de origen. Al seleccionar el servicio vinculado de almacenamiento provisional, puede usar Azure Synapse Analytics como origen.

Si tiene parámetros en la instancia de Data Flow o en cualquiera de los conjuntos de datos a los que se hace referencia, puede especificar los valores que se van usar durante la depuración si selecciona la pestaña Parámetros. Durante la depuración, los receptores no se necesitan y se omiten en el flujo de datos. Si quiere probar y escribir los datos transformados en el receptor, puede ejecutar el flujo de datos desde una canalización y usar la ejecución de depuración desde la canalización.

Como se ha descrito antes, en Azure Data Factory solo es posible depurar hasta un punto o actividad determinados. Para ello, puede usar en la actividad un punto de interrupción (hasta donde quiera probar) y, luego, seleccionar Depurar. La opción Depurar hasta aparece como un círculo rojo vacío en la esquina superior derecha del elemento. Tras seleccionar la opción Depurar hasta, cambia a un círculo de color rojo con relleno para indicar que el punto de interrupción está habilitado. A continuación, Azure Data Factory se asegurará de que la prueba solo se ejecute hasta el punto de interrupción de la actividad en la canalización. Esta característica es útil si solo quiere probar un subconjunto de las actividades de una canalización.

En la mayoría de los escenarios, las características de depuración de Azure Data Factory son suficientes. Sin embargo, a veces es necesario probar los cambios en una canalización dentro de un entorno de espacio aislado clonado. Un caso de uso para hacerlo es cuando hay canalizaciones ETL con parámetros en las que se le gustaría probar cómo se comportarían al desencadenar una llegada de archivo en lugar de una ventana de saltos de tamaño constante. En este caso, la clonación de un entorno de espacio aislado podría ser más adecuada.

Una de las ventajas de Azure Data Factory es que, como en la mayoría de los casos solo se cobra por el número de ejecuciones, una segunda instancia de Data Factory no tiene por qué suponer cargos adicionales.

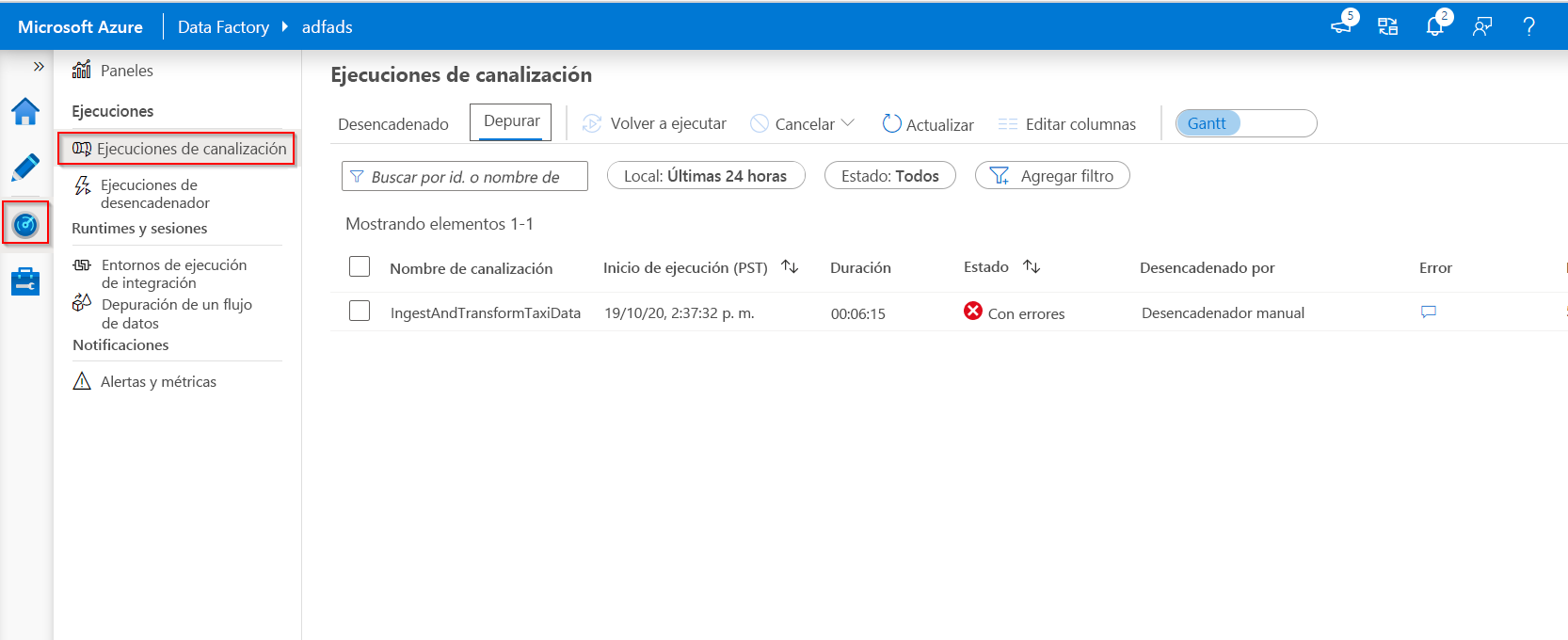

Supervisión de ejecuciones de depuración

Para supervisar las ejecuciones de depuración, puede comprobar la pestaña Salida, pero solo para la ejecución más reciente que se haya producido en la sesión de exploración, ya que no se mostrará el historial. Si quiere ver el historial de las ejecuciones de depuración, o todas las ejecuciones de depuración activas, puede ir a la pestaña Supervisión.

Hay que tener en cuenta que el servicio Azure Data Factory solo guarda el historial de ejecución de depuraciones durante 15 días. Para supervisar las sesiones de depuración de flujos de datos, también tendría que ir a la pestaña Supervisión.