Ejercicio: Moderación de imágenes

Contoso Camping Store proporciona a los clientes la capacidad de cargar fotos para complementar sus opiniones de productos. Los clientes encuentran esta característica útil, ya que proporciona información sobre cómo los productos se ven y funcionan fuera de las imágenes de marketing genéricas. Podríamos aplicar un modelo de inteligencia artificial para detectar si las imágenes publicadas por nuestros clientes son dañinas y, posteriormente, usar los resultados de detección para implementar las precauciones necesarias.

Contenido seguro

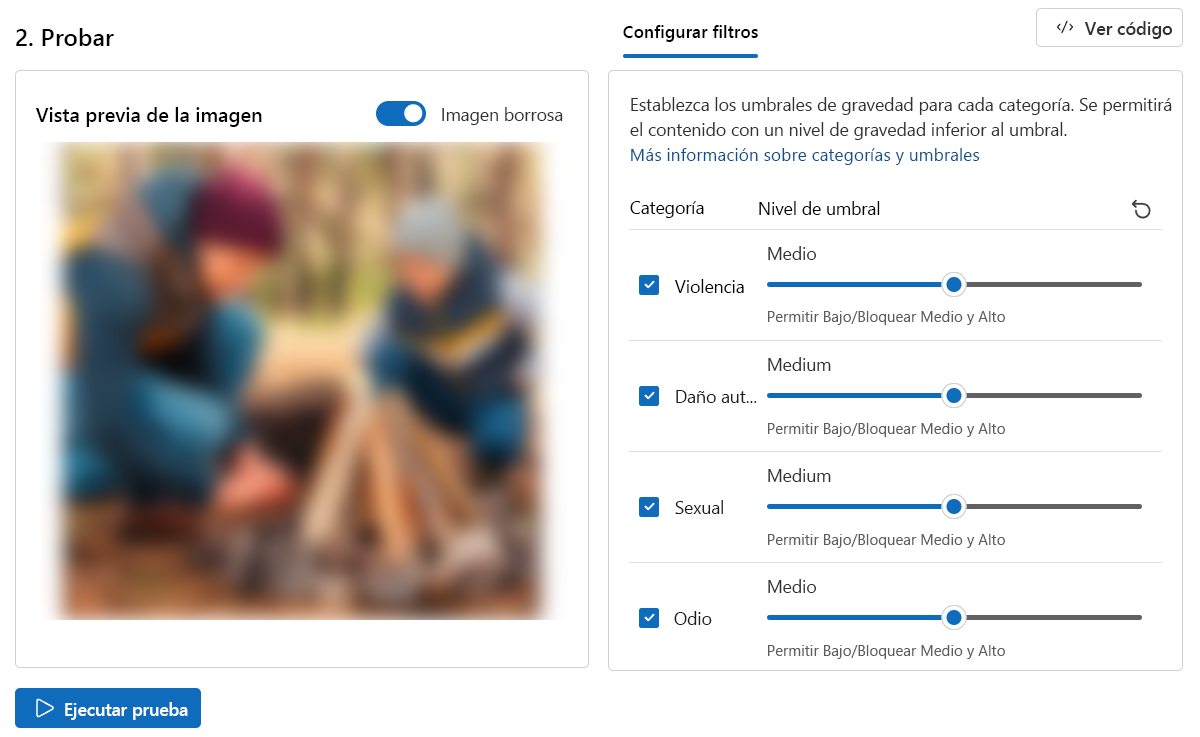

¡Vamos a probar primero una imagen de un camping familiar!

En la página Seguridad de contenido, seleccione Contenido moderado de la imagen.

Seleccione Examinar un archivo y cargue el archivo

family-builds-campfire.JPG.Establezca todos los Niveles de umbral en Medio.

Haga clic en Ejecutar prueba.

Como se esperaba, este contenido de imagen está Permitido, y el nivel de gravedad es Seguro en todas las categorías.

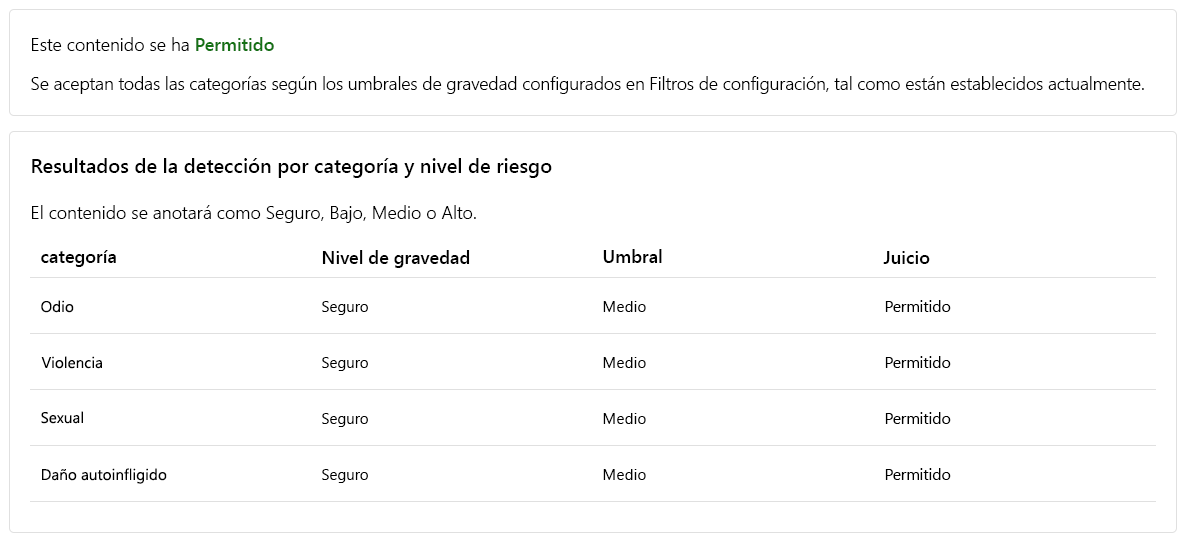

Contenido violento

También deberíamos prever que los clientes publiquen contenido de imágenes perjudiciales. Para asegurarnos de que tenemos en cuenta este escenario, vamos a probar la detección de contenido de imagen perjudicial.

Nota:

La imagen usada para las pruebas contiene una detección gráfica de un ataque de un oso. La imagen se desenfoca de forma predeterminada en la vista previa de la imagen. Sin embargo, puede usar el botón de alternancia Desenfocar la imagen para cambiar esta configuración.

- Seleccione Examinar un archivo y cargue el archivo

bear-attack-blood.JPG. - Establezca todos los Niveles de umbral en Medio.

- Haga clic en Ejecutar prueba.

De forma correcta, el contenido está bloqueado y fue rechazado por el filtro Violencia que tiene un nivel de gravedad alto.

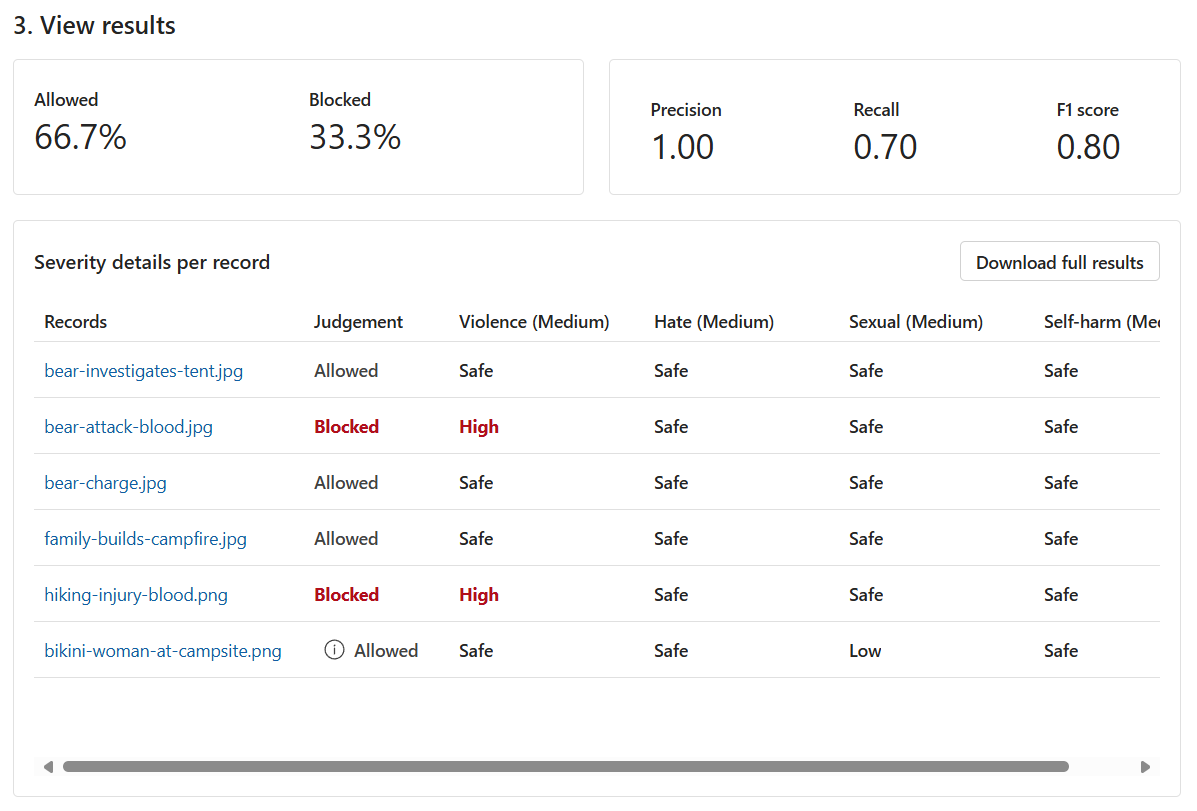

Ejecución de una prueba masiva

Hasta ahora, hemos probado el contenido de imágenes para imágenes aisladas singulares. Sin embargo, si tenemos un conjunto de datos masivo de contenido de imágenes, podríamos probar el conjunto de datos masivo a la vez y recibir métricas en función del rendimiento del modelo.

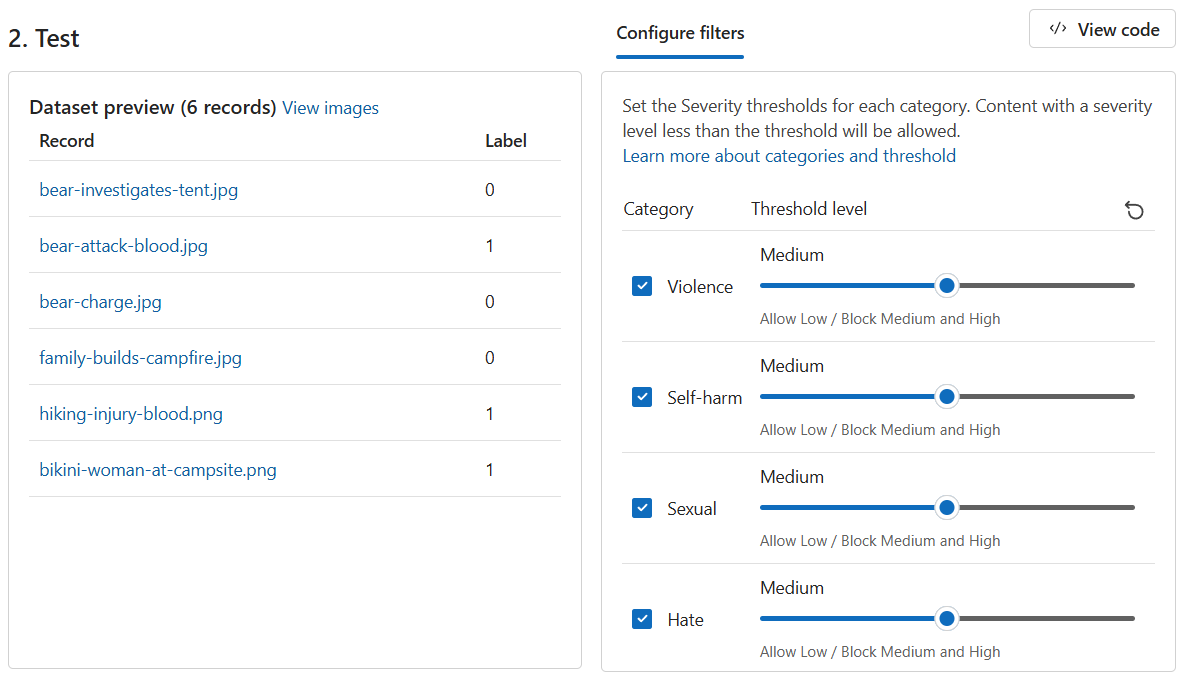

Tenemos un conjunto de datos masivo de imágenes proporcionadas por los clientes. El conjunto de datos también incluye imágenes perjudiciales de ejemplo para probar la capacidad del modelo para detectar contenido dañino. Cada registro del conjunto de datos incluye una etiqueta para indicar si el contenido es dañino. Vamos a realizar otra ronda de pruebas, pero esta vez con el conjunto de datos.

Cambie a la pestaña Ejecutar una prueba masiva.

Seleccione Examinar un archivo y cargue el archivo

bulk-image-moderation-dataset.zip.En la sección Vista previa del conjunto de datos, examine los Registros y su correspondiente Etiqueta. Un 0 indica que el contenido es aceptable (no dañino). Un 1 indica que el contenido es inaceptable (contenido dañino).

Establezca todos los Niveles de umbral en Medio.

Haga clic en Ejecutar prueba.

En función de los resultados, ¿hay espacio para mejorar? Si es así, ajuste los niveles de Umbral hasta que las métricas de Precisión, Recuperación y Puntuación de F1 estén más cerca de 1.