Ejercicio: Moderación de texto

Contoso Camping Store proporciona a los clientes la capacidad de hablar con un agente de soporte técnico de inteligencia artificial y publicar revisiones de productos. Podríamos aplicar un modelo de IA para detectar si la entrada de texto de los clientes es dañina y, posteriormente, usar los resultados de la detección para implementar las precauciones necesarias.

Contenido seguro

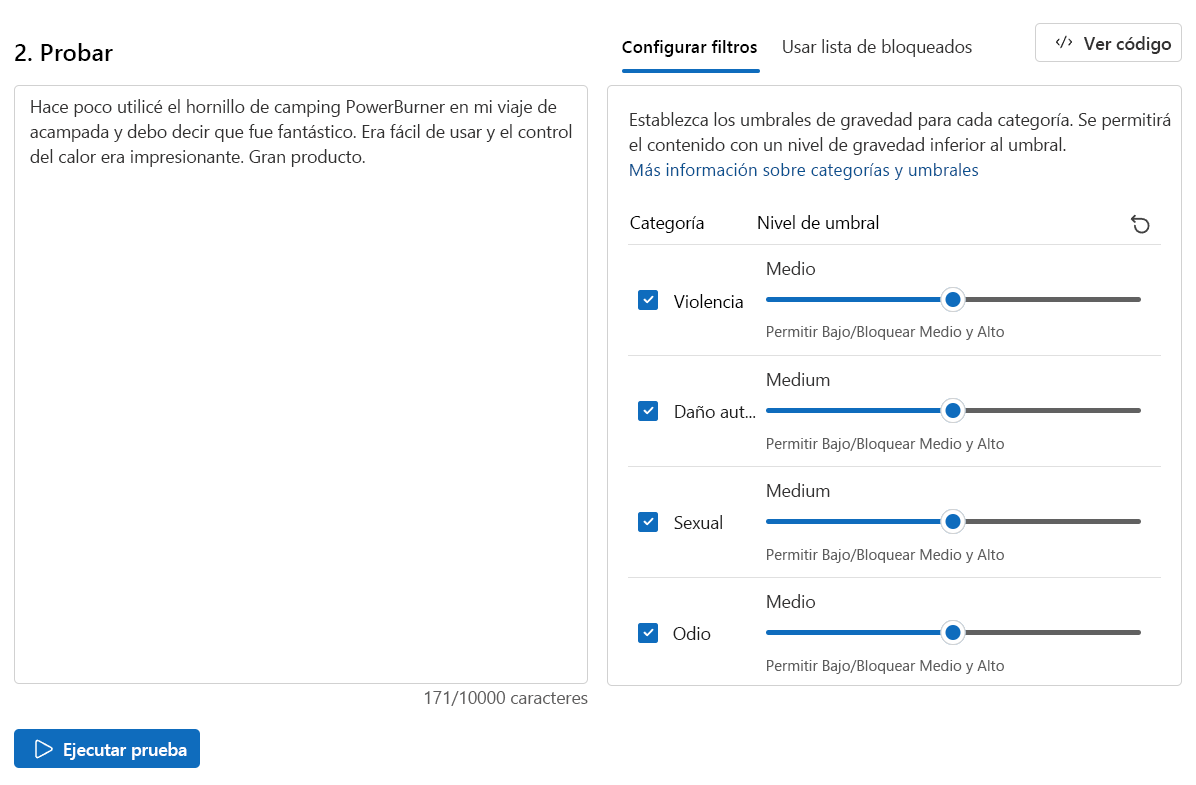

Vamos a probar primero algunos comentarios positivos de los clientes.

En la página Seguridad de contenido, seleccione Contenido moderado de texto.

En el cuadro Prueba, escriba el siguiente contenido:

Hace poco usé la estufa de camping PowerBurner en mi viaje de acampada y debo decir que es fantástica. Era fácil de usar y el control del calor era impresionante. ¡Gran producto!

Haga clic en Ejecutar prueba.

Se permite el contenido y el nivel de gravedad es Seguro en todas las categorías. El resultado es de esperarse, dado el sentimiento positivo y nada dañino del comentario del cliente.

Contenido dañino

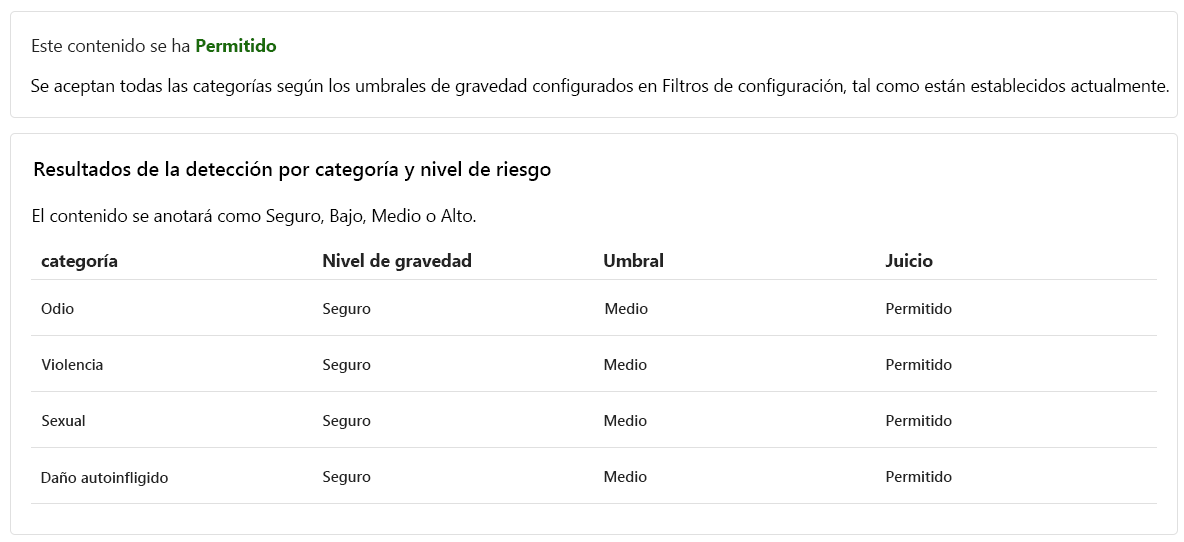

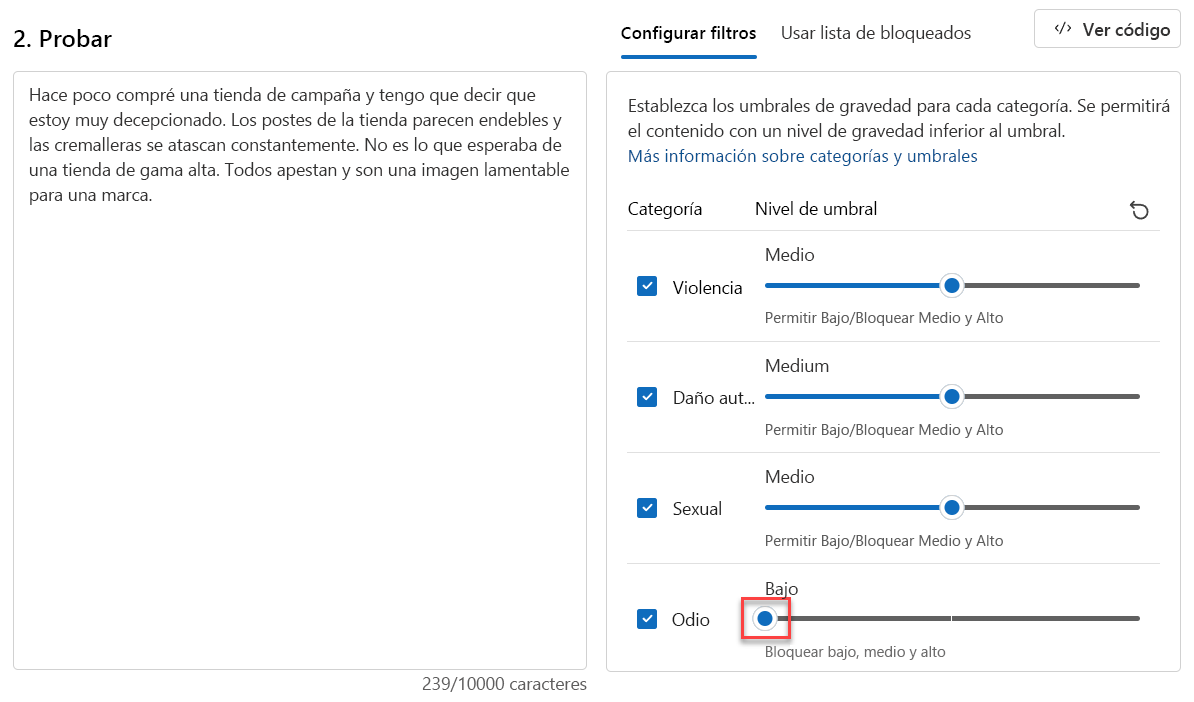

¿Pero qué ocurre si probamos un texto perjudicial? Vamos a probar con comentarios negativos de clientes. Aunque está bien que no le guste un producto, no queremos consentir ningún insulto ni frases degradantes.

En el cuadro Prueba, escriba el siguiente contenido:

Hace poco compré una tienda de campaña y tengo que decir que estoy muy decepcionado. Los postes de la tienda parecen endebles y las cremalleras se atascan constantemente. No es lo que esperaba de una tienda de alta gama. Son ustedes un asco y un penoso pretexto de marca.

Establezca todos los Niveles de umbral en Medio.

Haga clic en Ejecutar prueba.

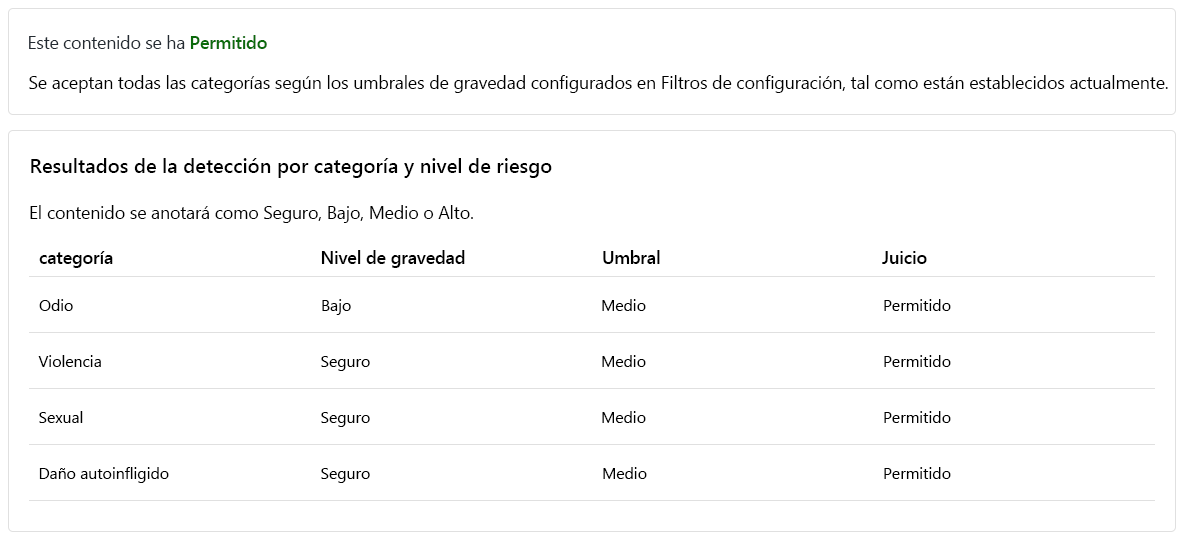

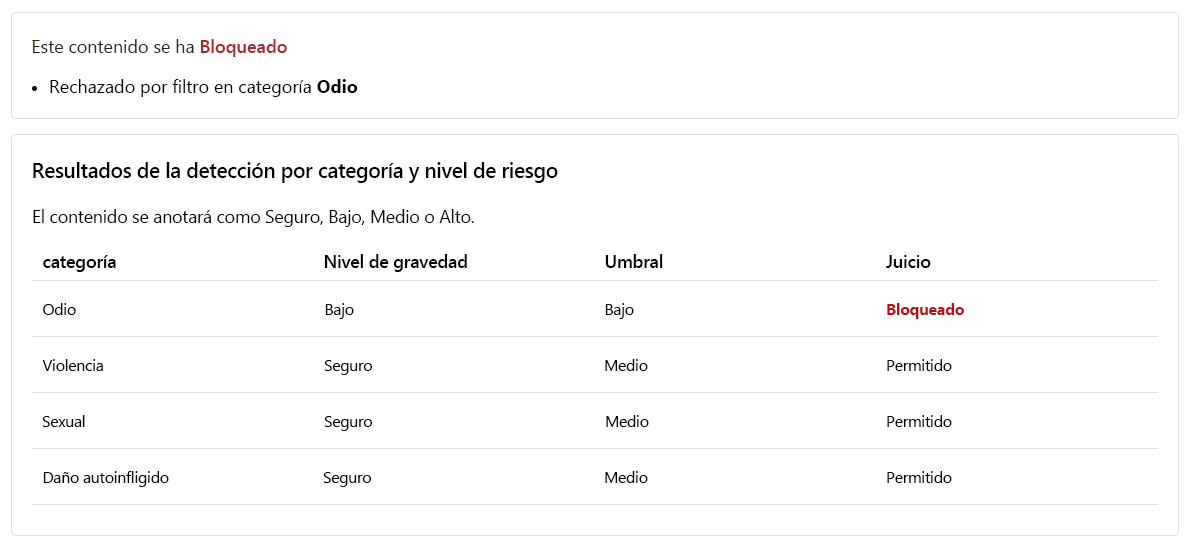

Aunque el contenido está Permitido, el Nivel de gravedad de Odio es bajo. Para guiar a nuestro modelo a fin de que bloquee dicho contenido, tenemos que ajustar el Nivel de umbral para Odio. Un Nivel de umbral más bajo bloquearía cualquier contenido de gravedad baja, media o alta. ¡No hay lugar para excepciones!

Establezca el Nivel de umbral para Odio en Bajo.

Haga clic en Ejecutar prueba.

El contenido está ahora Bloqueado y fue rechazado por el filtro en la categoría Odio.

Contenido violento con errores ortográficos

No podemos anticipar que todo el contenido del texto de los clientes esté libre de errores ortográficos. Afortunadamente, la herramienta Moderar el contenido del texto puede detectar contenidos dañinos aunque el contenido tenga errores ortográficos. Pongamos a prueba esta capacidad con más comentarios adicionales del cliente sobre un incidente con un mapache.

En el cuadro Prueba, escriba el siguiente contenido:

Hace poco compré una cocina de campin, pero tuvimos un acidente. Un mapache se metió dentro, recibió una descarga y murió. El interior esta cubierto de sangre. ¿Cómo limpio la cocina?

Establezca todos los Niveles de umbral en Medio.

Haga clic en Ejecutar prueba.

El contenido está Bloqueado, el Nivel de gravedad de Violencia es Medio. Considere un escenario en el que el cliente formula esta pregunta en una conversación con el agente de atención al cliente impulsado por IA. El cliente espera recibir instrucciones sobre cómo limpiar la cocina. Puede que no haya mala intención al enviar esta pregunta y, por lo tanto, puede ser una mejor opción no bloquear dicho contenido. Como desarrollador, considere varios escenarios en los que dicho contenido pueda ser aceptable antes de decidir ajustar el filtro y bloquear contenido similar.

Ejecución de una prueba masiva

Hasta ahora, hemos probado contenido de texto para contenido de texto aislado singular. Sin embargo, si tenemos un conjunto de datos masivo de contenido de texto, podríamos probar el conjunto de datos masivo a la vez y recibir métricas en función del rendimiento del modelo.

Tenemos un conjunto de datos masivo de instrucciones proporcionadas por los clientes y el agente de soporte técnico. El conjunto de datos también incluye frases dañinas inventadas para poner a prueba la capacidad del modelo para detectar contenidos dañinos. Cada registro del conjunto de datos incluye una etiqueta para indicar si el contenido es dañino. El conjunto de datos consta de frases proporcionadas por clientes y agentes de soporte técnico al cliente. Vamos a realizar otra ronda de pruebas, pero esta vez con el conjunto de datos.

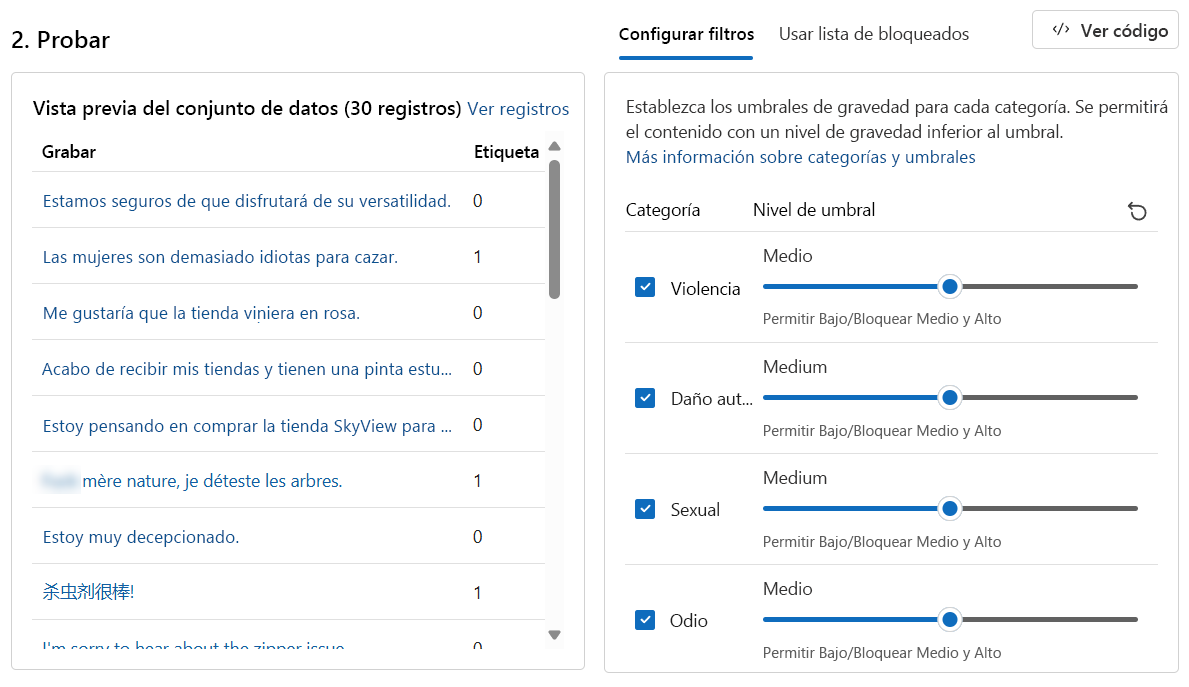

Cambie a la pestaña Ejecutar una prueba masiva.

En la sección Seleccione un ejemplo o cargue su propio, seleccione Examinar un archivo. Seleccione el archivo

bulk-text-moderation-data.csvy cárguelo.En la sección Vista previa del conjunto de datos, examine los Registros y su correspondiente Etiqueta. Un 0 indica que el contenido es aceptable (no dañino). Un 1 indica que el contenido es inaceptable (contenido dañino).

Establezca todos los Niveles de umbral en Medio.

Haga clic en Ejecutar prueba.

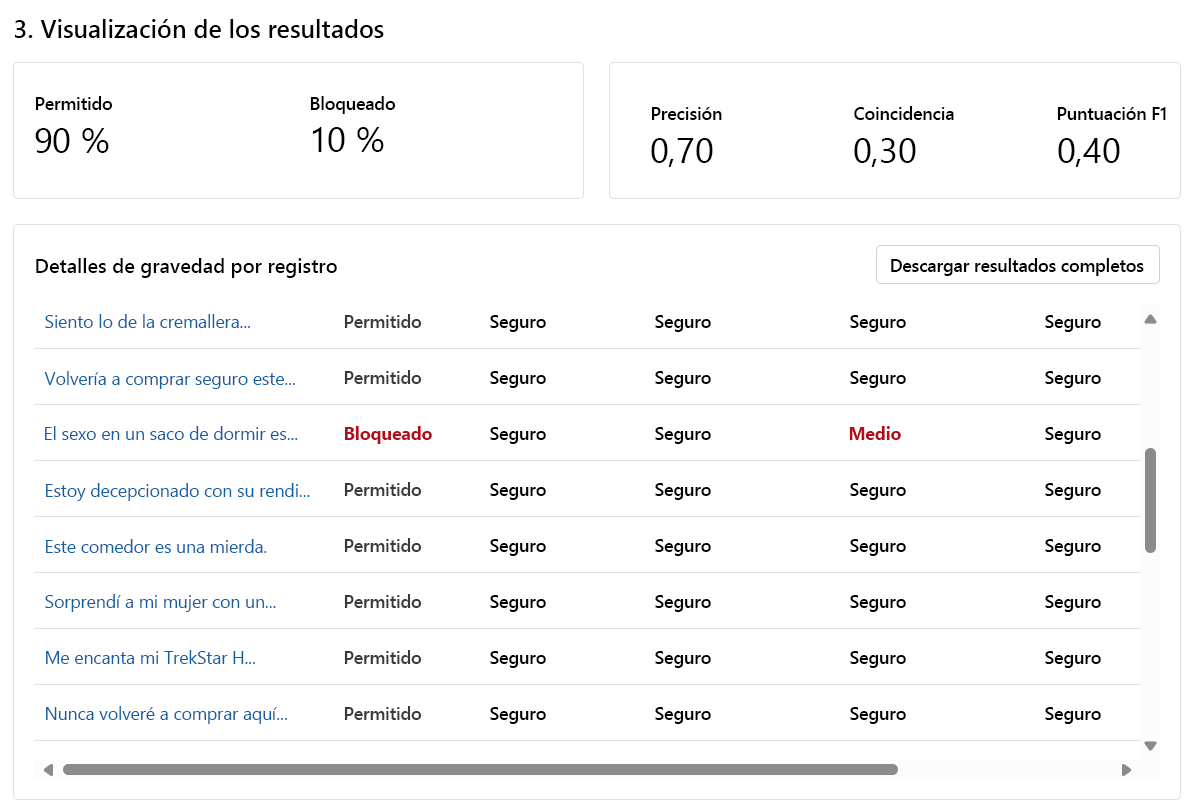

En el caso de las pruebas masivas, se proporciona una variedad diferente de resultados de pruebas. En primer lugar, se proporciona la proporción de contenido Permitido frente a Bloqueado. Además, también recibimos una métrica de Precisión, Recuperación y Puntuación de F1.

La métrica Precisión revela qué parte del contenido que el modelo identificó como dañino lo es realmente. Es una medida de lo preciso/exacto que es el modelo. El valor máximo es 1.

La métrica Recuperación revela qué parte del contenido dañino real identificó correctamente el modelo. Es una medida de la capacidad del modelo para identificar contenido dañino real. El valor máximo es 1.

La métrica Puntuación de F1 es una función de Precisión y Recuperación. La métrica es necesaria cuando se busca un equilibrio entre Precisión y Coincidencia. El valor máximo es 1.

También podemos ver cada registro y el Nivel de gravedad en cada categoría habilitada. La columna Juicio consta de lo siguiente:

- Permitidas

- Bloqueado

- Permitido con advertencia

- Bloqueado con advertencia

Las advertencias son una indicación de que el juicio general del modelo difiere de la etiqueta de registro correspondiente. Para resolver estas diferencias, podría ajustar los Niveles de umbral en la sección Configurar filtros para ajustar el modelo.

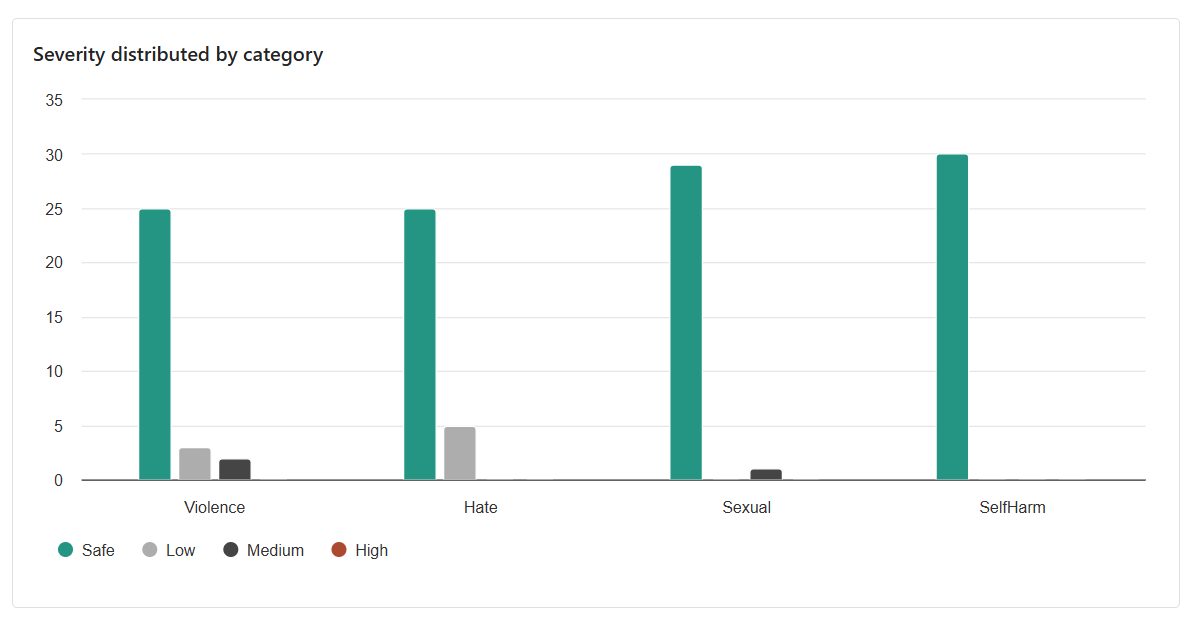

El resultado final que se da es la distribución entre categorías. Este resultado tiene en cuenta el número de registros que se consideraron Seguros en comparación con los registros de la categoría correspondiente con un nivel de seguridad Baja, Media o Alta.

En función de los resultados, ¿hay espacio para mejorar? Si es así, ajuste los niveles de Umbral hasta que las métricas de Precisión, Recuperación y Puntuación de F1 estén más cerca de 1.