Ejecución de experimentos con MLflow

Los experimentos de MLflow permiten que los científicos de datos realicen un seguimiento de las ejecuciones de entrenamiento en una colección denominada experimento. Las ejecuciones de experimentos son útiles para comparar los cambios a lo largo del tiempo o comparar el rendimiento relativo de los modelos con distintos valores de hiperparámetros.

Ejecución de un experimento

La creación de un experimento en Azure Databricks se produce automáticamente al iniciar una ejecución. A continuación se muestra un ejemplo de inicio de una ejecución en MLflow, en la que se registran dos parámetros y una métrica:

with mlflow.start_run():

mlflow.log_param("input1", input1)

mlflow.log_param("input2", input2)

# Perform operations here like model training.

mlflow.log_metric("rmse", rmse)

En este caso, el nombre del experimento es el nombre del cuaderno. Es posible exportar una variable denominada MLFLOW_EXPERIMENT_NAME para cambiar el nombre del experimento si así lo desea.

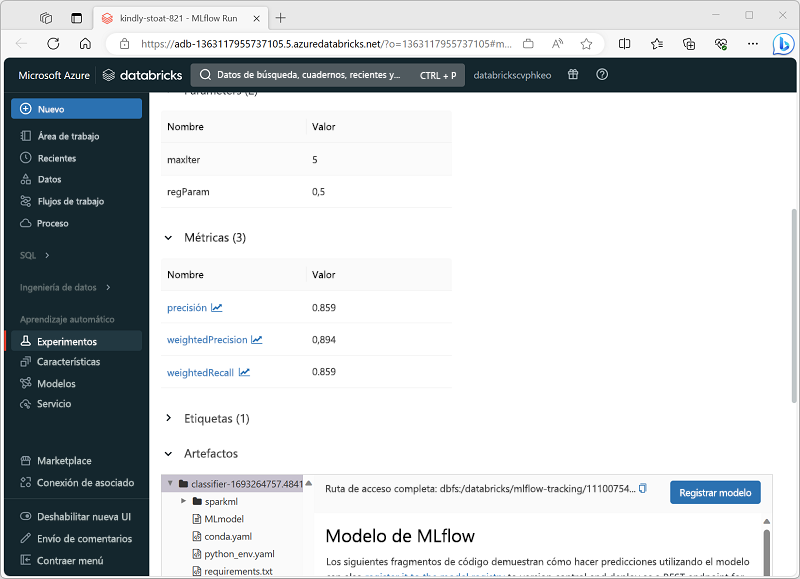

Revisión de la ejecución de un experimento

En el portal de Azure Databricks, la página Experimentos le permite ver detalles de cada ejecución del experimento, incluidos valores registrados de parámetros, métricas y otros artefactos.