Exploración de los modelos de lenguaje en el catálogo de modelos

Seleccionar un modelo de lenguaje para la aplicación de IA generativa es importante, ya que afecta al funcionamiento de la aplicación. Al desarrollar una aplicación de inteligencia artificial generativa con Azure AI Foundry, se crea una aplicación de chat que puede usar modelos de lenguaje con varios fines:

- Comprender la pregunta del usuario.

- Buscar el contexto pertinente.

- Generar una respuesta a la pregunta del usuario.

En el portal de Azure AI Foundry, puede examinar los modelos de lenguaje disponibles en el catálogo de modelos. Vamos a explorar el catálogo de modelos y los tipos de modelos de lenguaje disponibles a través de Azure AI.

Explorar el catálogo de modelos

En el portal de Azure AI Foundry, puede desplazarse al catálogo de modelos para explorar todos los modelos de lenguaje disponibles. Además, podrá importar cualquier modelo desde la biblioteca de código abierto Hugging Face al catálogo de modelos.

Sugerencia

Hugging Face es una comunidad de código abierto que hace que los modelos estén disponibles para el público. Es posible encontrar todos los modelos en su catálogo. Además, podría explorar la documentación para obtener más información sobre cómo funcionan los modelos individuales, como BERT.

El catálogo de modelos de Azure AI Foundry se integra con modelos tanto de Hugging Face como de otros orígenes. Desde el catálogo de modelos, puede explorar, ajustar e implementar modelos.

Importante

La disponibilidad del modelo difiere en función de la ubicación, también denominada región. La ubicación se especifica en el nivel del Centro de IA. Al crear un Centro de IA, puede usar el asistente de ubicación para especificar el modelo que desea implementar para obtener una lista de las ubicaciones en las que puede implementarlo. Para más información también puede explorar la tabla de resumen del modelo y la disponibilidad de regiones.

Exploración de los modelos de lenguaje

Los modelos básicos o de lenguaje disponibles en el catálogo de modelos ya están entrenados previamente. Puede implementar un modelo de lenguaje en un punto de conexión, o bien ajustar un modelo para que funcione mejor en una tarea especializada o en conocimientos específicos del dominio.

El modelo seleccionado depende del caso de uso y de las preferencias de implementación. En primer lugar, debe pensar en la tarea que desea que realice el modelo. Por ejemplo:

- Clasificación de textos

- Clasificación de tokens

- Respuesta a preguntas

- Resumen

- Traducción

Estos son algunos modelos de lenguaje que se usan habitualmente para varias tareas:

| Modelo | Descripción |

|---|---|

| BERT (Representaciones de codificador bidireccional de Transformadores) | Se centra en la codificación de la información mediante el uso del contexto de antes y después de un token (bidireccional). Normalmente, se usa cuando se desea ajustar un modelo para realizar una tarea específica, como la clasificación de texto y la respuesta a preguntas. |

| GPT (Transformador generativo previamente entrenado) | Está entrenado para crear texto coherente y relevante contextualmente y se usa normalmente para tareas como la generación de texto y las finalizaciones de chat. |

| LLaMA (Meta AI de modelos de lenguaje grandes) | Familia de modelos creados por Meta. Al entrenar modelos LLaMA, el enfoque se centró en proporcionar más datos de entrenamiento que aumentar la complejidad de los modelos. Puede usar modelos LLaMA para la generación de texto y las finalizaciones de chat. |

| Phi-3-mini (variación de parámetros 3.8B de los modelos PHI) | Un modelo liviano de última generación optimizado para entornos con restricción de recursos están restringidos e inferencia local (como en un teléfono), que admite mensajes de contexto largo de hasta 128 000 tokens. Se ha desarrollado pensando principalmente en la seguridad, la alineación y aprendizaje de refuerzo de los comentarios humanos. |

Después de seleccionar una tarea y filtrar los modelos disponibles adecuados para su objetivo, puede examinar el resumen del modelo en Azure AI Foundry para tener en cuenta otras consideraciones:

- Funcionalidades del modelo: Evalúe las funcionalidades del modelo de lenguaje y cómo se alinean con su tarea. Por ejemplo, un modelo como BERT es mejor para el reconocimiento de textos cortos.

- Datos de entrenamiento previo: Considere el conjunto de datos que se usa para entrenar previamente el modelo de lenguaje. Por ejemplo, GPT-2 se entrena con contenido de Internet sin filtrar que puede dar lugar a sesgos.

- Limitaciones y sesgos: Tenga en cuenta las limitaciones o los sesgos que puedan existir en el modelo de lenguaje.

- Compatibilidad con idiomas: explore qué modelos ofrecen compatibilidad con idiomas específicos o funcionalidad multilingüe que necesite para su caso de uso.

Sugerencia

Aunque Azure AI Foundry proporciona descripciones de cada modelo de lenguaje del catálogo de modelos, también puede encontrar más información sobre cada modelo en la tarjeta correspondiente del modelo. A las tarjetas de modelo se hace referencia en la información general de cada modelo y se hospedan en el sitio web de Hugging Face.

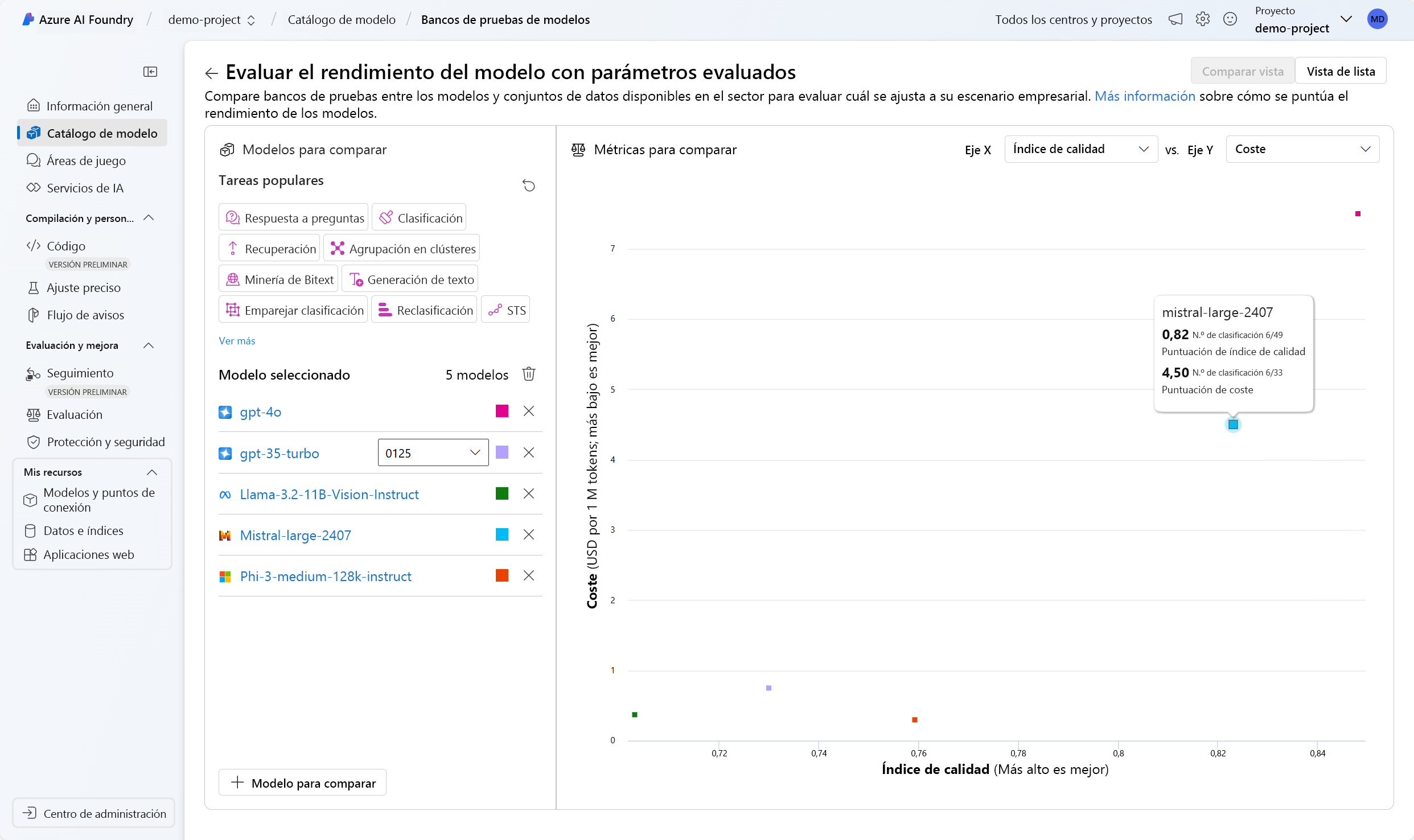

Comparación de pruebas comparativas entre modelos

Al explorar modelos de lenguaje, también puede comparar los bancos de pruebas de modelos disponibles antes de implementar e integrar cualquiera de los modelos. Los bancos de pruebas son tarjetas de informe de los modelos de lenguaje. Le ayudan a conocer el rendimiento de un modelo, para lo que lo comparan con otros mediante pruebas o tareas específicas. Los bancos de pruebas de modelos en el portal de Azure AI Foundry proporcionan una lista seleccionada de los modelos con un mejor rendimiento para una tarea determinada, en función de las métricas de los bancos de pruebas.

Estas son algunas de las métricas que se usan habitualmente para evaluar el rendimiento de los modelos de lenguaje:

| Métrica | Descripción |

|---|---|

| Precisión | Las puntuaciones de precisión están disponibles a nivel de conjunto de datos y modelo. A nivel de conjunto de datos, la puntuación es el valor medio de una métrica de precisión calculada sobre todos los ejemplos del conjunto de datos. La métrica de precisión usada coincide exactamente en todos los casos excepto en el conjunto de datos HumanEval que usa la métrica pass@1. La coincidencia exacta simplemente compara el texto generado por el modelo con la respuesta correcta según el conjunto de datos, notificando 1 si el texto generado coincide exactamente con la respuesta y 0 en caso contrario. Pass@1 mide la proporción de soluciones de modelo que pasan un conjunto de pruebas unitarias en una tarea de generación de código. A nivel de modelo, la puntuación de precisión es la media de las precisiones de nivel de conjunto de datos para cada modelo. |

| Coherencia | La coherencia evalúa en qué medida el modelo de lenguaje puede producir flujos de salida con facilidad, que se lean con naturalidad y se asemejen al lenguaje humano. |

| Fluidez | La fluidez evalúa el dominio del idioma de una respuesta predicha de IA generativa. Evalúa el nivel de conformidad del texto generado con las reglas gramaticales, estructuras sintácticas y uso adecuado del vocabulario, lo que da lugar a respuestas lingüísticas correctas y naturales. |

| GPTSimilarity | La similitud de GPT es una medida que cuantifica la similitud entre una frase verdadera real (o documento) y la frase de predicción generada por un modelo de IA. Se obtiene calculando primero la computación de inserciones de nivel de frase mediante la API de inserciones para la verdad real y la predicción del modelo. Estas incrustaciones representan representaciones vectoriales de alta dimensión de las oraciones, capturando su significado semántico y contexto. |

| Base | La base evalúa el nivel de alineación de las respuestas generadas del modelo de lenguaje con la información del origen de entrada. |

| Relevancia | La relevancia evalúa la medida en que las respuestas generadas del modelo de lenguaje son pertinentes y directamente relacionadas con las preguntas formuladas. |

Nota:

Al desarrollar y evaluar aplicaciones que usan modelos de lenguaje, es importante usar métricas que midan el rendimiento del modelo y de la aplicación. Las mismas métricas que se usan para los bancos de prueba, que comparan modelos diferentes, también se pueden usar para evaluar el rendimiento de un modelo individual durante el desarrollo. Estas métricas le ayudan a saber si el modelo funciona buen y a identificar las áreas de mejora.

Seleccionar el modelo que se adapte a sus necesidades puede ser un proceso iterativo. A continuación, aprenderá a implementar un modelo para que pueda probarlo y experimentar con la forma de optimizarlo para su caso de uso.