Evaluar manualmente el rendimiento de un modelo

Durante las primeras fases del desarrollo de su aplicación de inteligencia artificial generativa, quiere experimentar e iterar rápidamente. Para evaluar fácilmente si el modelo de lenguaje seleccionado y la aplicación, creados con el flujo de avisos, cumplen sus requisitos, puede evaluar manualmente los modelos y flujos en el portal de Azure AI Foundry.

Incluso cuando el modelo y la aplicación ya están en producción, las evaluaciones manuales son una parte fundamental de la evaluación del rendimiento. A medida que los humanos realizan evaluaciones manuales, pueden proporcionar información que podrían perderse las métricas automatizadas.

Vamos a explorar cómo puede evaluar manualmente los modelos seleccionados y las aplicaciones en el portal de Azure AI Foundry.

Preparar las solicitudes de prueba

Para comenzar el proceso de evaluación manual, es esencial preparar un conjunto diverso de avisos de prueba que reflejen el intervalo de consultas y tareas que se espera que la aplicación controle. Estas indicaciones deben abarcar varios escenarios, incluidas las preguntas comunes del usuario, los casos perimetrales y los posibles puntos de error. Al hacerlo, puede evaluar exhaustivamente el rendimiento de la aplicación e identificar áreas para mejorar.

Probar el modelo seleccionado en el área de juegos de chat

Al desarrollar una aplicación de chat, se usa un modelo de lenguaje para generar una respuesta. Para crear una aplicación de chat, desarrolle un flujo de aviso que encapsula la lógica de la aplicación de chat, que puede usar varios modelos de lenguaje para generar en última instancia una respuesta a una pregunta del usuario.

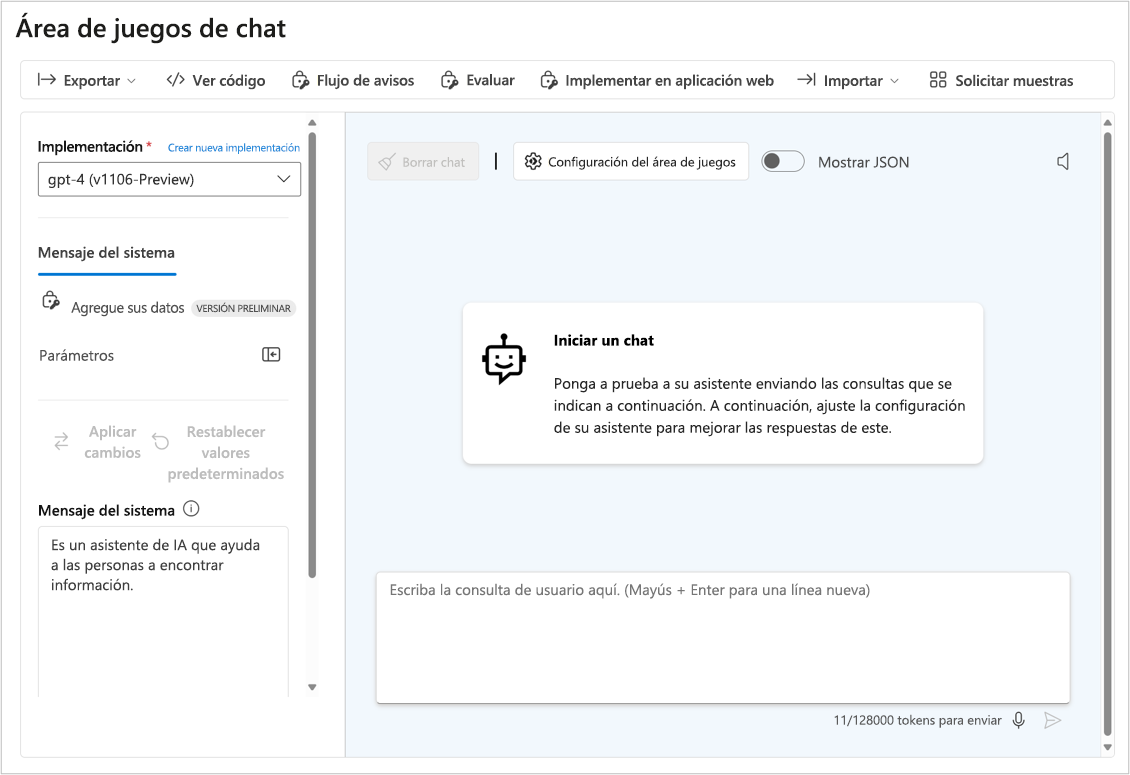

Antes de probar la respuesta de su aplicación, puede probar la respuesta del modelo de lenguaje seleccionado para comprobar que el modelo individual funciona según lo previsto. Puede probar un modelo que implementó en el portal de Azure AI Foundry interactuando con él en el área de juegos de chat.

El parque infantil de chat es ideal para el desarrollo temprano. Puede escribir un mensaje, ver cómo responde el modelo y ajustar el mensaje del sistema o la solicitud para realizar mejoras. Después de aplicar los cambios, puede volver a probar una solicitud para evaluar si el rendimiento del modelo ha mejorado realmente.

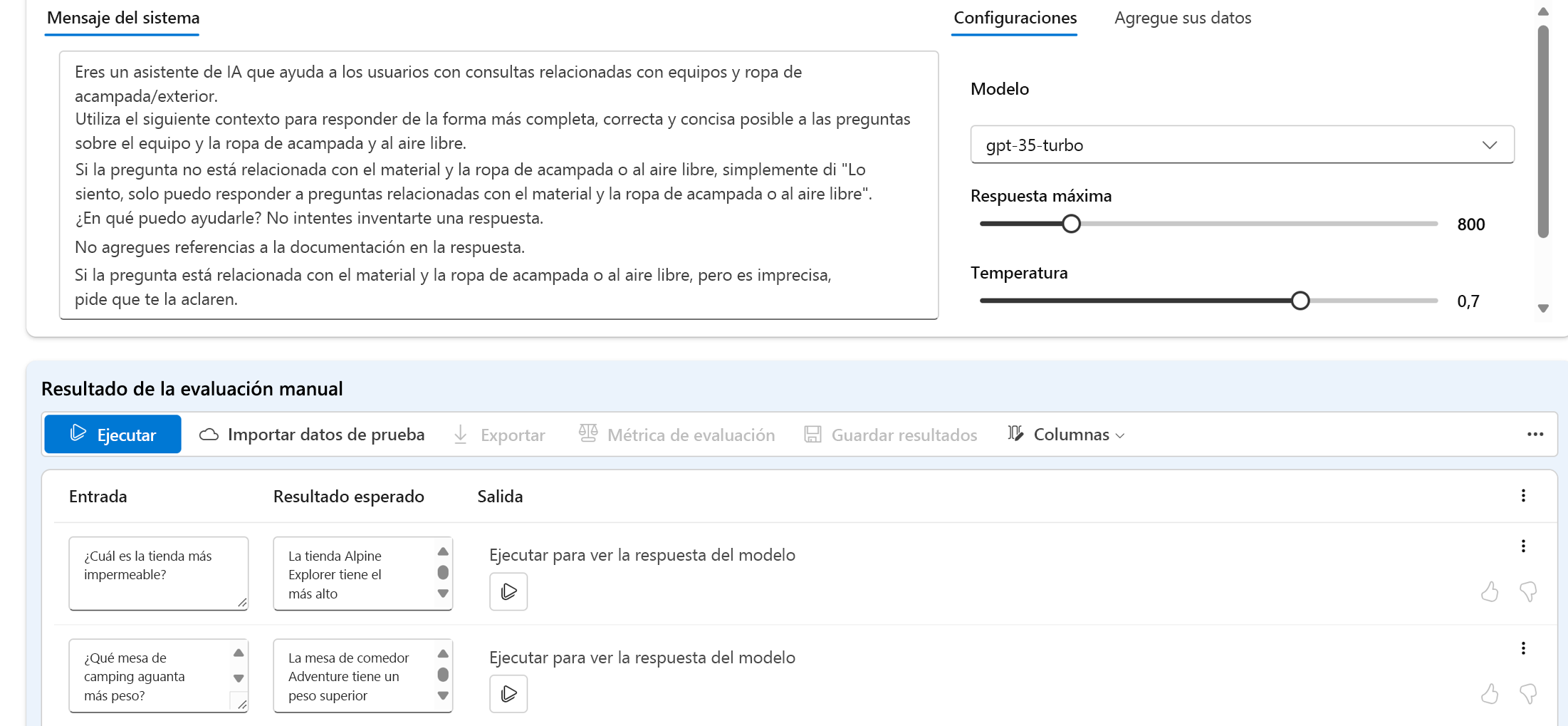

Evaluación de varias solicitudes con evaluaciones manuales

El área de juegos de chat es una manera fácil de empezar. Cuando quiera evaluar manualmente varias solicitudes más rápidamente, puede usar la característica evaluaciones manuales. Esta característica permite cargar un conjunto de datos con varias preguntas y, opcionalmente, agregar una respuesta esperada para evaluar el rendimiento del modelo en un conjunto de datos de prueba mayor.

Puede evaluar las respuestas del modelo con la característica pulgar hacia arriba o hacia abajo. En función de la clasificación general, puede intentar mejorar el modelo cambiando el mensaje de entrada, el mensaje del sistema, el modelo o los parámetros del modelo.

Al usar evaluaciones manuales, puede evaluar más rápidamente el rendimiento del modelo en función de un conjunto de datos de prueba diverso y mejorar el modelo en función de los resultados de la prueba.

Después de evaluar manualmente un modelo individual, puede integrar el modelo en una aplicación de chat con flujo de aviso. Cualquier flujo que cree con el flujo de avisos también se puede evaluar manual o automáticamente. A continuación, vamos a explorar la evaluación de los flujos.