Evaluación del rendimiento del modelo

Evaluar el rendimiento del modelo en diferentes fases es fundamental para garantizar su eficacia y confiabilidad. Antes de explorar las distintas opciones que tiene que evaluar el modelo, vamos a explorar los aspectos de la aplicación que puede evaluar.

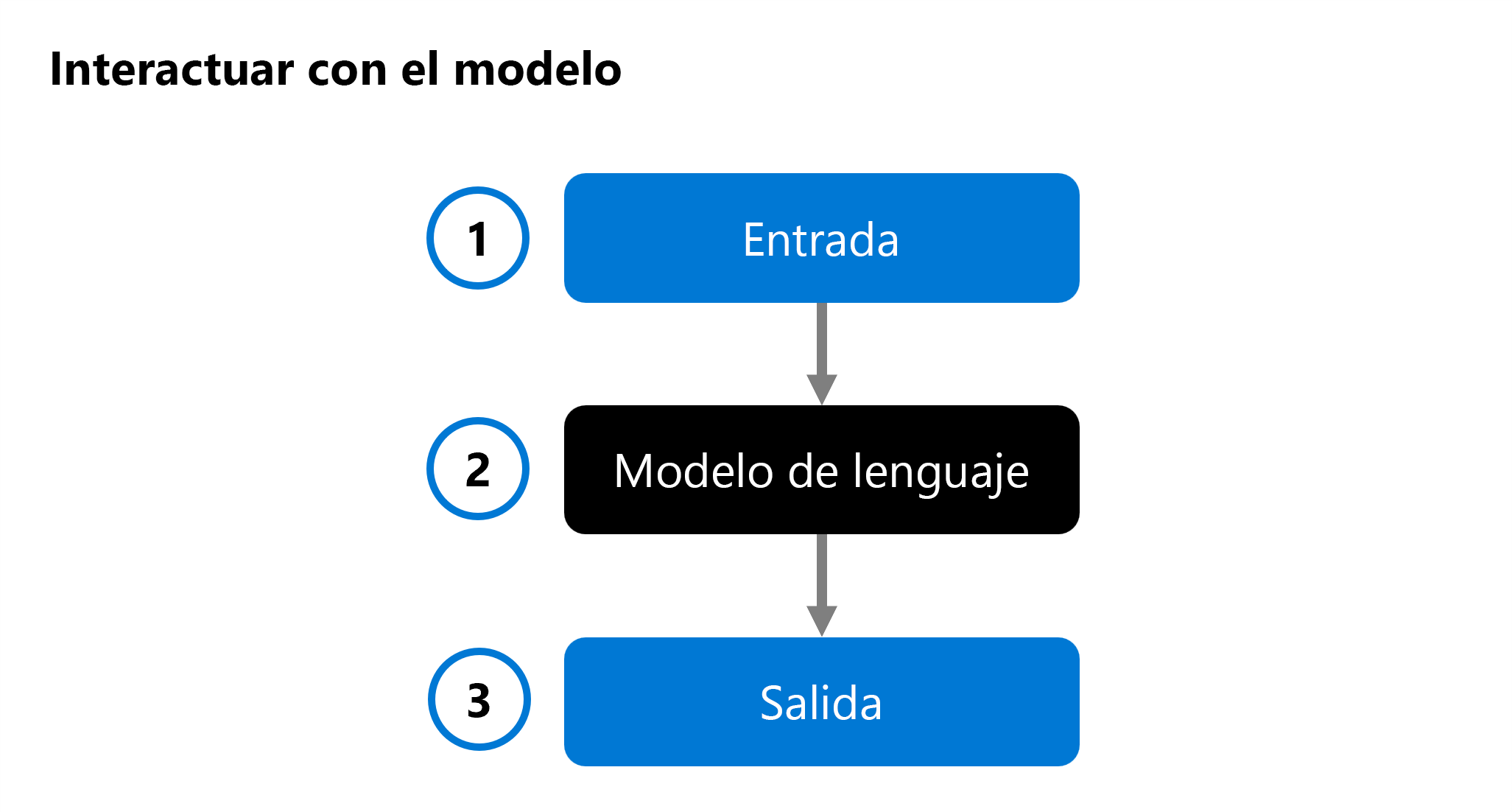

Al desarrollar una aplicación de inteligencia artificial generativa, se usa un modelo de lenguaje en la aplicación de chat para generar una respuesta. Para ayudarle a decidir qué modelo desea integrar en la aplicación, puede evaluar el rendimiento de un modelo de lenguaje individual:

Se proporciona una entrada (1) a un modelo de lenguaje (2) y se genera una respuesta como salida (3). A continuación, el modelo se evalúa mediante el análisis de la entrada, la salida y, opcionalmente, la comparación con la salida predefinida esperada.

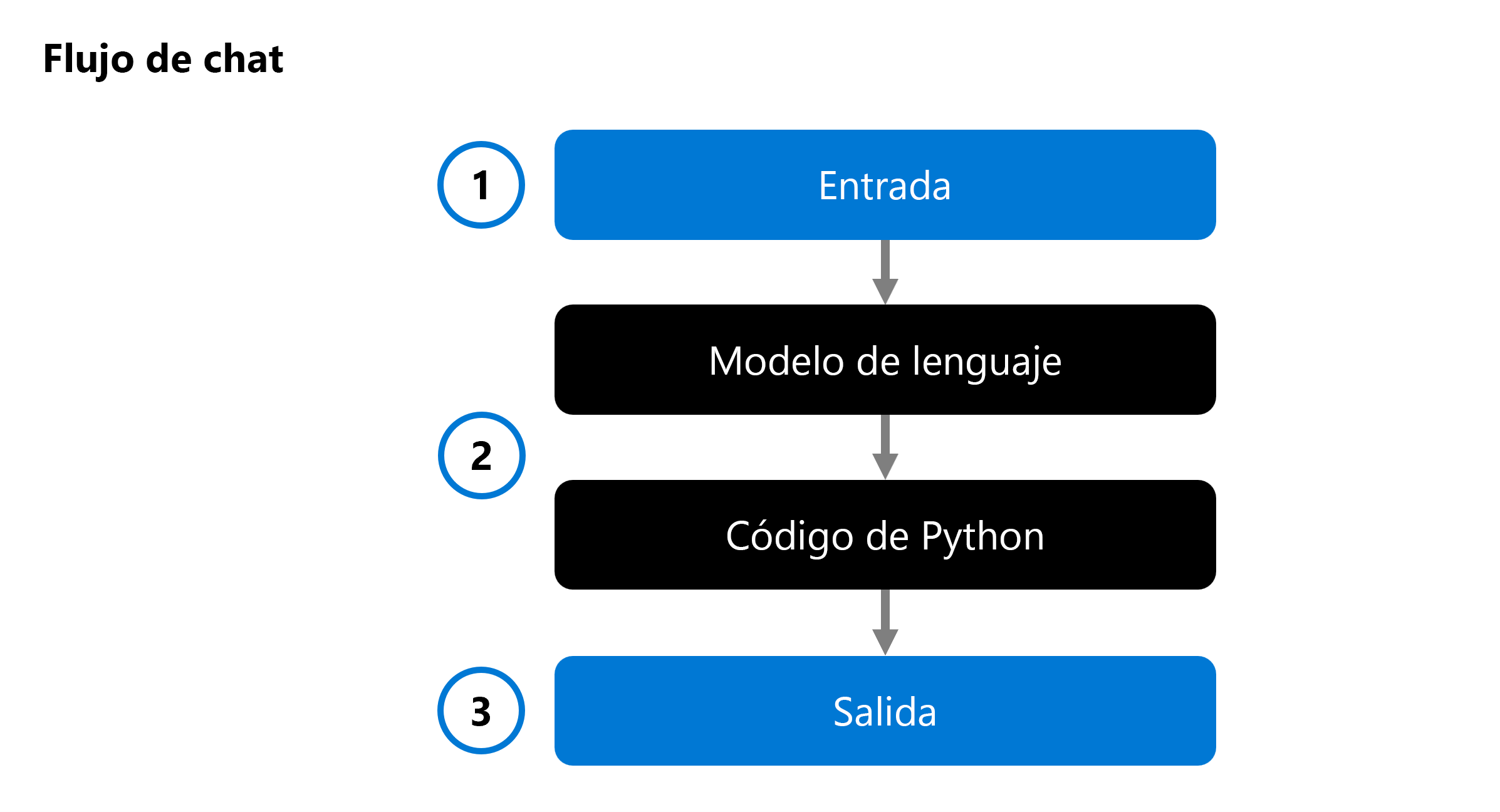

Al desarrollar una aplicación de inteligencia artificial generativa, se integra un modelo de lenguaje en un flujo de chat:

Un flujo de chat permite orquestar flujos ejecutables que pueden combinar varios modelos de lenguaje y código de Python. El flujo espera una entrada (1), la procesa mediante la ejecución de varios nodos (2) y genera una salida (3). Puede evaluar un flujo de chat completo y sus componentes individuales.

Al evaluar la solución, puede empezar a probar un modelo individual y, finalmente, probar un flujo de chat completo para validar si la aplicación de inteligencia artificial generativa funciona según lo previsto.

Vamos a explorar varios enfoques para evaluar el modelo y el flujo de chat, o la aplicación de inteligencia artificial generativa.

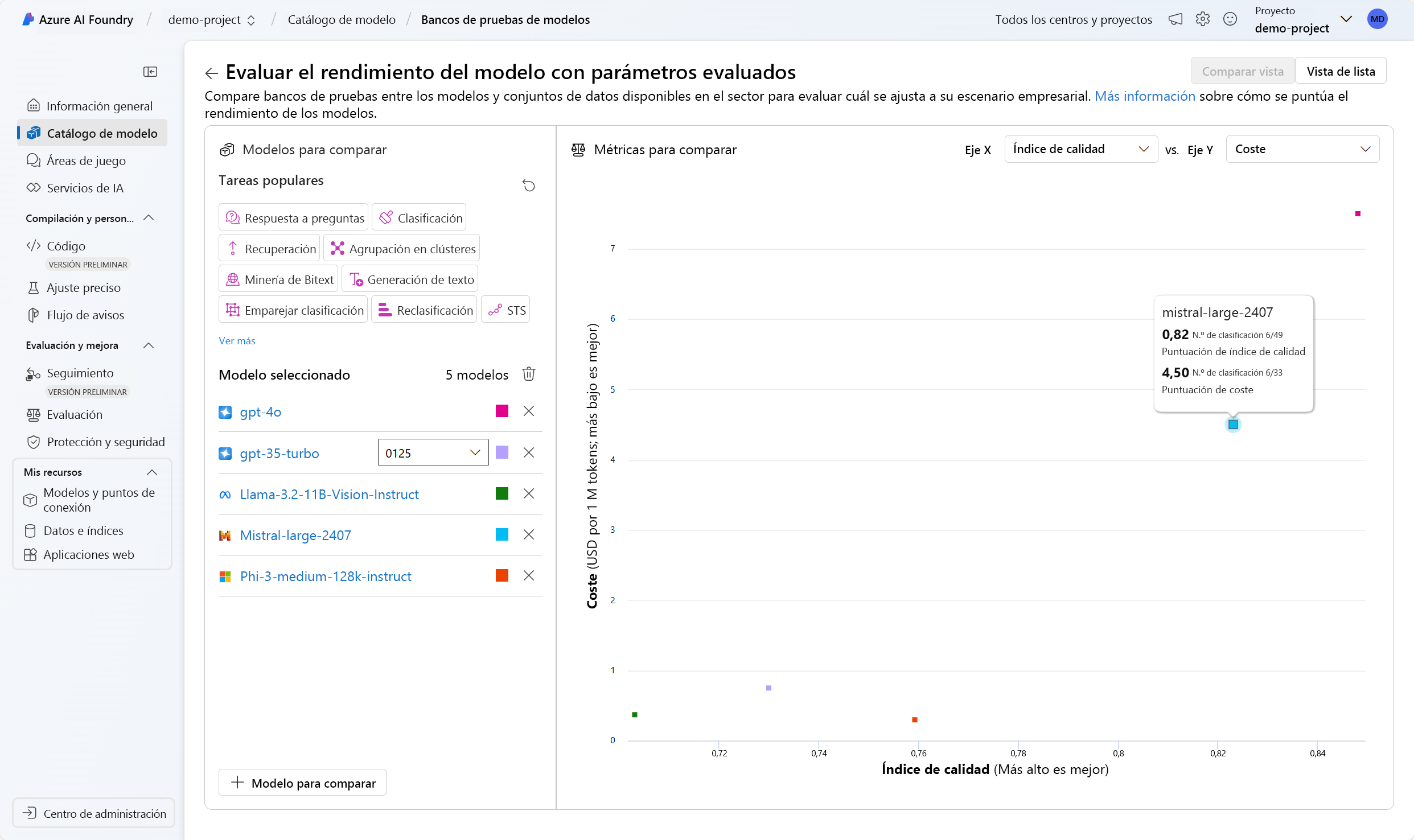

Bancos de pruebas de modelos

Las pruebas comparativas de modelos son métricas disponibles públicamente entre modelos y conjuntos de datos. Estas pruebas comparativas le ayudan a comprender cómo funciona el modelo en relación con otros usuarios. Algunos puntos de referencia usados habitualmente incluyen:

- Exactitud: Compara el texto generado por el modelo con la respuesta correcta según el conjunto de datos. El resultado es uno si el texto generado coincide exactamente con la respuesta y cero de lo contrario.

- Coherencia: Mide si la salida del modelo fluye sin problemas, lee de forma natural y se parece al lenguaje similar al humano.

- Fluidez: Evalúa la forma en que el texto generado cumple las reglas gramaticales, las estructuras sintácticas y el uso adecuado del vocabulario, lo que da lugar a respuestas lingüísticas correctas y de sonido natural.

- Similitud GPT: Cuantifica la similitud semántica entre una frase de verdad básica (o documento) y la frase de predicción generada por un modelo de IA.

En el portal de Azure AI Foundry, puede explorar las pruebas comparativas de modelos para todos los modelos disponibles antes de implementar un modelo:

Evaluaciones manuales

Las evaluaciones manuales implican evaluadores humanos que evalúan la calidad de las respuestas del modelo. Este enfoque proporciona información sobre los aspectos que podrían perderse las métricas automatizadas, como la relevancia del contexto y la satisfacción del usuario. Los evaluadores humanos pueden evaluar las respuestas en función de criterios como relevancia, información y compromiso.

Métricas de aprendizaje automático tradicional

Las métricas de aprendizaje automático tradicionales también son valiosas para evaluar el rendimiento del modelo. Una de estas métricas es lapuntuación F1, que mide la proporción del número de palabras compartidas entre las respuestas de verdad generadas y terrestres. La puntuación F1 es útil para tareas como la clasificación de texto y la recuperación de información, donde la precisión y la recuperación son importantes.

Métricas asistidas por IA

Las métricas asistidas por IA usan técnicas avanzadas para evaluar el rendimiento del modelo. Estas métricas pueden incluir:

- Métricas de riesgo y seguridad: Estas métricas evalúan los posibles riesgos y problemas de seguridad asociados a las salidas del modelo. Ayudan a garantizar que el modelo no genere contenido perjudicial o sesgado.

- Métricas de calidad de generación: Estas métricas evalúan la calidad general del texto generado, teniendo en cuenta factores como la creatividad, la coherencia y el cumplimiento del estilo o tono deseados.