Calidad de datos para el patrimonio de datos de Fabric Lakehouse

Fabric OneLake es un lago de datos único, unificado y lógico para toda la organización. Un lago de datos procesa grandes volúmenes de datos de varios orígenes. Al igual que Microsoft OneDrive, OneLake viene automáticamente con todos los inquilinos de Microsoft Fabric y está diseñado para ser el único lugar para todos los datos de análisis. OneLake trae clientes:

- Un lago de datos para toda la organización

- Una copia de datos para su uso con varios motores analíticos

OneLake tiene como objetivo proporcionarle el máximo valor posible de una sola copia de datos sin movimiento de datos ni duplicación. Ya no es necesario copiar datos solo para usarlos con otro motor o desglosar silos para poder analizar los datos con datos de otros orígenes. Puede usar Microsoft Purview para catalogar el patrimonio de datos de tejido y medir la calidad de los datos para controlar e impulsar la acción de mejora.

Puede usar el acceso directo para hacer referencia a los datos almacenados en otras ubicaciones de archivo. Estas ubicaciones de archivo pueden estar dentro del mismo área de trabajo o en diferentes áreas de trabajo, dentro de OneLake o externas a OneLake en Azure Data Lake Storage (ADLS), Amazon Web Services (AWS) S3 o Dataverse con más ubicaciones de destino próximamente. La ubicación del origen de datos no importa tanto, los accesos directos de OneLake hacen que los archivos y las carpetas parezcan que los tiene almacenados localmente. Cuando los equipos trabajan de forma independiente en áreas de trabajo independientes, los accesos directos permiten combinar datos entre diferentes grupos de negocios y dominios en un producto de datos virtual para satisfacer las necesidades específicas de un usuario.

Puede usar la creación de reflejo para reunir datos de varios orígenes en Fabric. La creación de reflejo en Fabric es una solución de bajo costo y baja latencia para reunir datos de varios sistemas en una única plataforma de análisis. Puede replicar continuamente el patrimonio de datos existente directamente en OneLake de Fabric, incluidos los datos de Azure SQL Database, Azure Cosmos DB y Snowflake. Con los datos más actualizados en un formato que se puede consultar en OneLake, ahora puede usar todos los servicios diferentes de Fabric. Por ejemplo, la ejecución de análisis con Spark, la ejecución de cuadernos, la ingeniería de datos, la visualización a través de informes de Power BI, etc. Las tablas Delta se pueden usar en cualquier lugar de Fabric, lo que permite a los usuarios acelerar su recorrido hacia Fabric.

Registro de Fabric OneLake

Para configurar el examen de Mapa de datos, primero debe registrar el origen de datos que desea examinar. Para examinar un área de trabajo de Fabric, no hay cambios en la experiencia existente para registrar un inquilino de Fabric como origen de datos. Para registrar un nuevo origen de datos, siga estos pasos:

- En el portal de Microsoft Purview, vaya a Mapa de datos.

- Seleccione Registrar.

- En Registrar orígenes, seleccione Tejido.

Consulte las mismas instrucciones de configuración de inquilinos y entre inquilinos .

Configuración del examen del mapa de datos

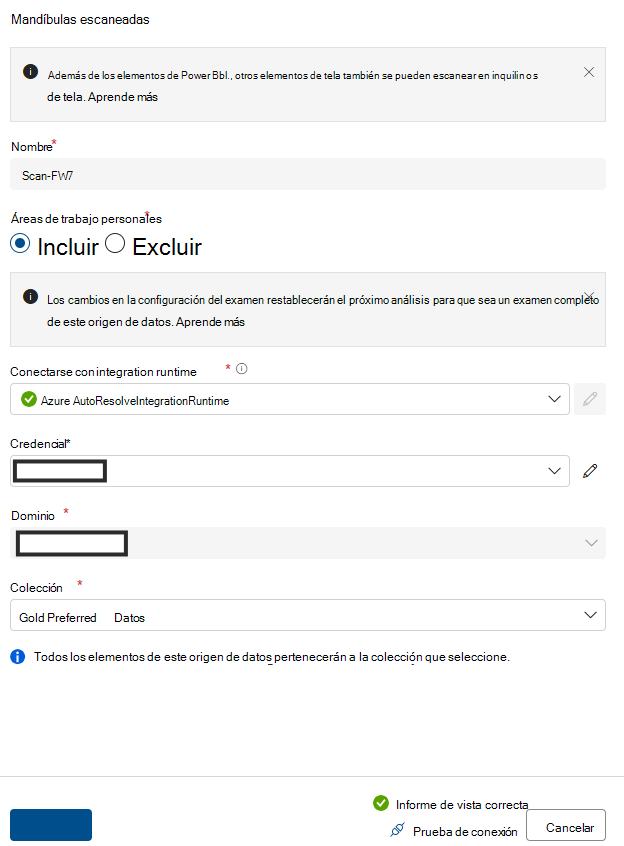

Para examinar los elementos subartifact de Lakehouse, no hay cambios en la experiencia existente en Data Map para configurar un examen. Hay otro paso para conceder la credencial de examen con al menos el rol Colaborador en las áreas de trabajo de Fabric para extraer la información del esquema de los formatos de archivo admitidos.

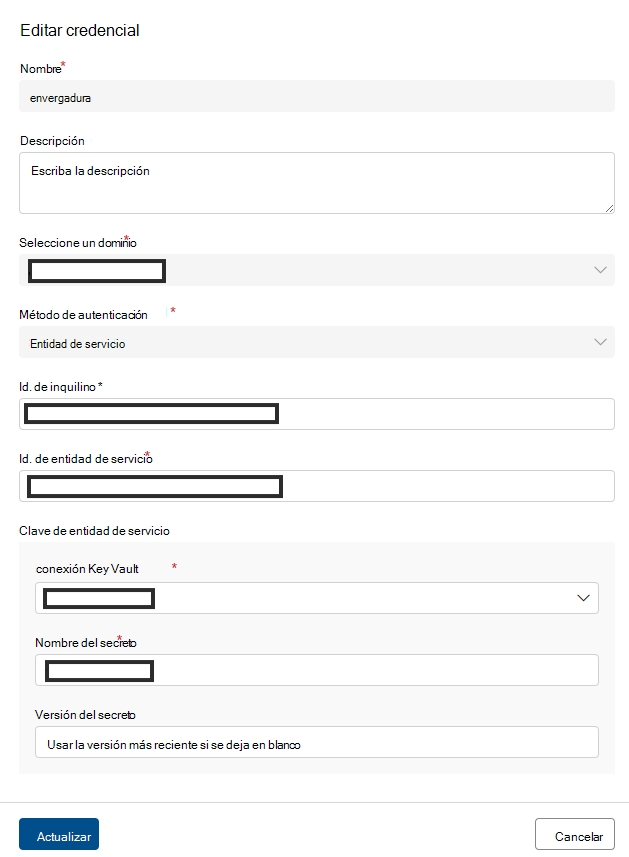

Actualmente solo se admite la entidad de servicio como método de autenticación. La compatibilidad con MSI sigue en el trabajo pendiente.

Consulte las mismas instrucciones de configuración de inquilinos y entre inquilinos .

Configuración de la conexión para el examen de Fabric Lakehouse

Después de registrar Fabric Lakehouse como origen, puede seleccionar Fabric en la lista de orígenes de datos registrados en Data Map y seleccionar Nuevo examen. Agregue un identificador de origen de datos y siga estos pasos:

Creación de un grupo de seguridad y una entidad de servicio

Asegúrese de agregar esta entidad de servicio y la identidad administrada de Purview a este grupo de seguridad y, a continuación, proporcione este grupo de seguridad.

Asociación del grupo de seguridad con el inquilino de Fabric

- Inicie sesión en el portal de administración de Fabric.

- Seleccione la página Configuración del inquilino. Debe ser un Administración de Fabric para ver la página de configuración del inquilino.

- Seleccione Administración configuración de > API Permitir que las entidades de servicio usen LAS API de administrador de solo lectura.

- Seleccione Grupos de seguridad específicos.

- Seleccione Administración configuración de > API Mejorar las respuestas de las API de administrador con metadatos detallados y Mejorar las respuestas de las API de administrador con expresiones > DAX y mashup Habilite la alternancia para permitir que Mapa de datos de Microsoft Purview detecte automáticamente los metadatos detallados de los conjuntos de datos de Fabric como parte de sus exámenes. Después de actualizar la configuración de Administración API en el inquilino de Fabric, espere unos 15 minutos antes de registrar una conexión de examen y prueba.

Proporcione Administración permiso de API de solo lectura a este grupo de seguridad.

Agregue SPN al campo Credencial .

Agregue el nombre del recurso de Azure.

Agregue el identificador de inquilino.

Agregue el identificador de principio de servicio.

Agregue Key Vault conexión.

Agregar nombre de secreto.

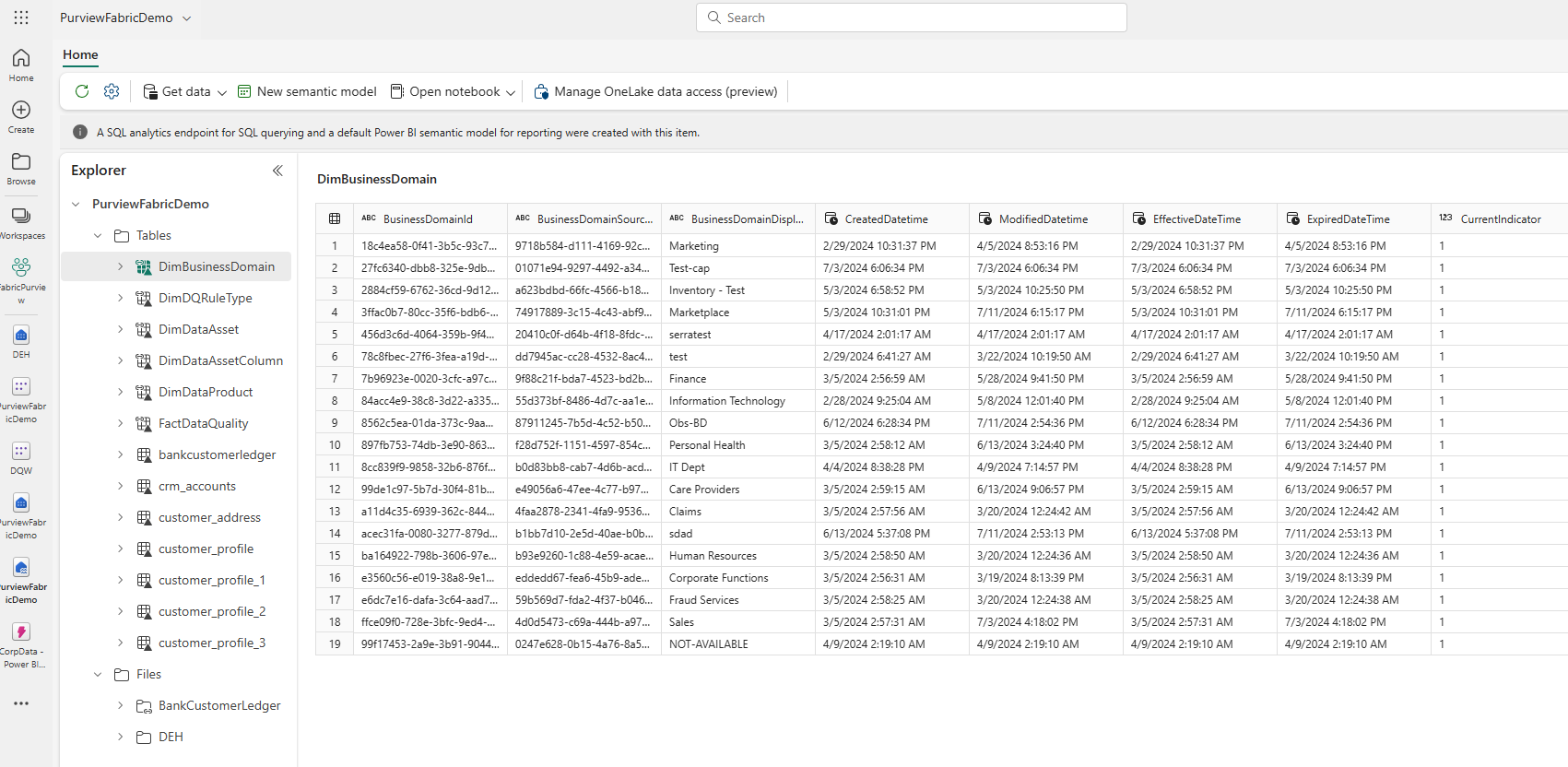

Después de finalizar el examen de Mapa de datos, busque una instancia de Lakehouse en Catálogo unificado.

- En el portal de Microsoft Purview, abra Catálogo unificado.

- Seleccione Detección y, a continuación, Recursos de datos.

- En la página Recursos de datos , seleccione Microsoft Fabric.

- Seleccione Áreas de trabajo de Fabric y, a continuación, seleccione un área de trabajo de la lista.

- En la página del área de trabajo, busque la instancia de Lakehouse en Nombre del elemento.

Para examinar las tablas de Lakehouse:

- En una página del área de trabajo, seleccione el nombre de elemento Tablas.

- Seleccione un recurso de tabla de Lakehouse que aparece en Nombre del elemento.

- Vea la página de detalles del recurso para buscar metadatos como el esquema, el linaje y las propiedades.

Requisitos previos del examen de calidad de datos de Fabric Lakehouse

- Acceso directo, reflejo o carga de los datos en Fabric Lakehouse en formato delta.

Importante

Si ha agregado nuevas tablas, archivos o un nuevo conjunto de datos a Fabric Lakehouse mediante creación de reflejo o acceso directo, debe ejecutar un examen de ámbito de Mapa de datos para catalogar esos nuevos conjuntos de datos antes de agregar esos recursos de datos a un producto de datos para la evaluación de la calidad de los datos.

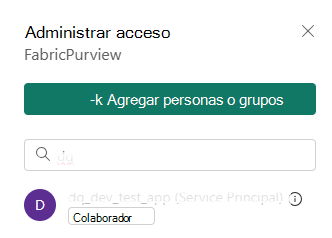

- Conceder derecho de colaborador al área de trabajo para PURVIEW MSI

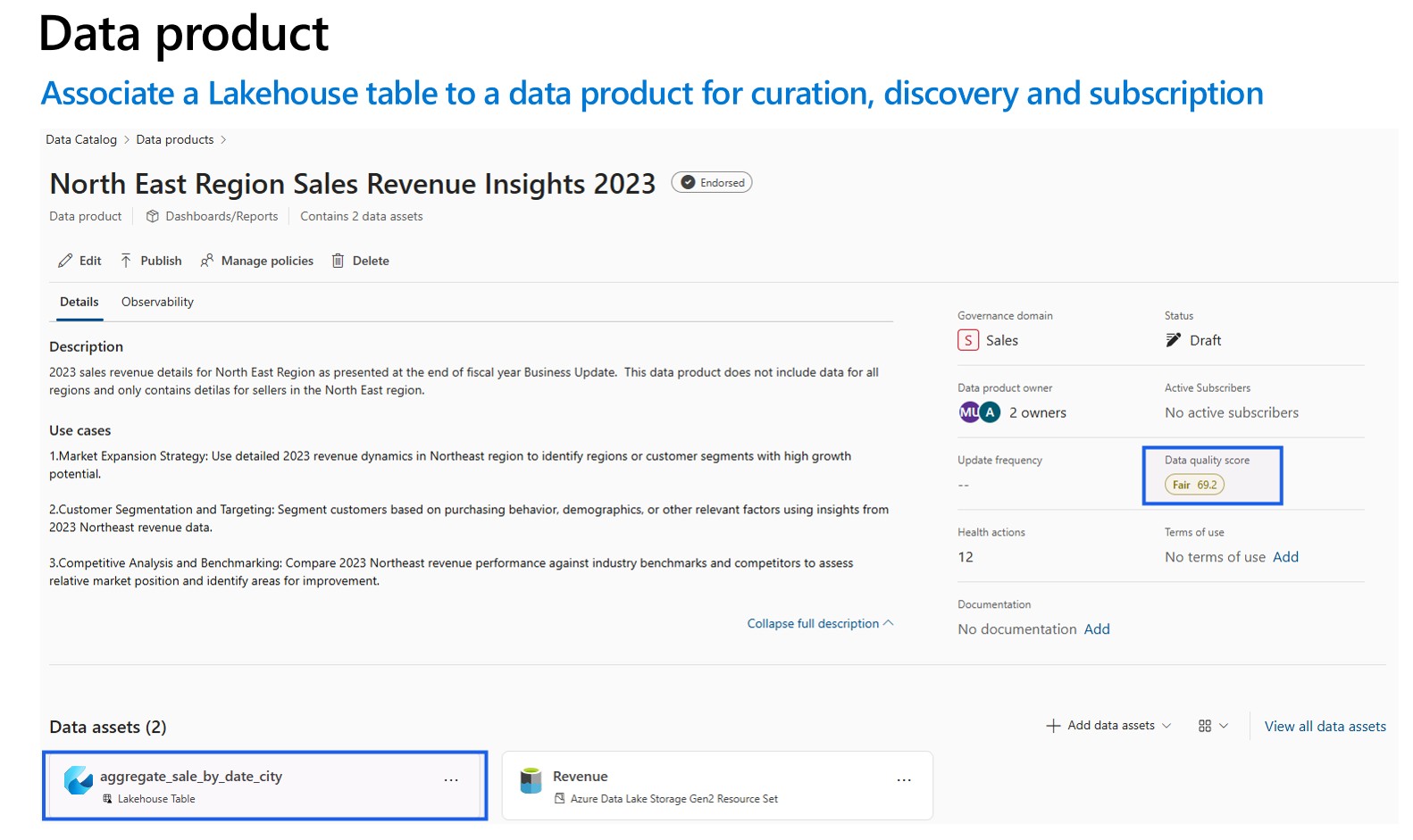

- Agregue un recurso de datos escaneado de Lakehouse a los productos de datos del dominio de gobernanza. En la página de un producto de datos de Catálogo unificado, busque Recursos de datos y seleccione Agregar recursos de datos. La generación de perfiles de datos y el examen de calidad de datos solo se pueden realizar para los recursos de datos asociados a los productos de datos en el dominio de gobernanza.

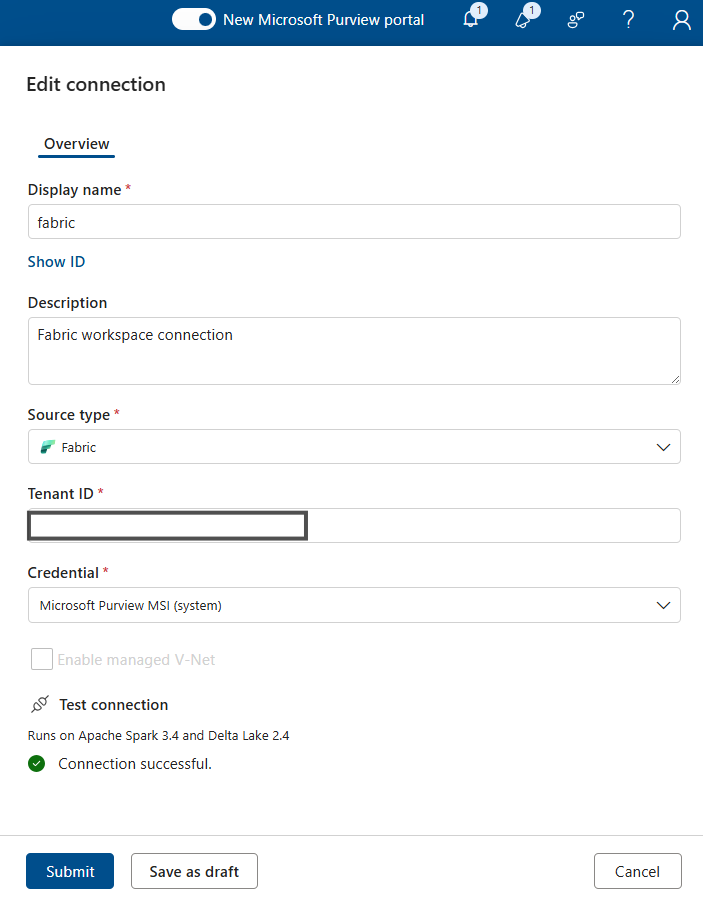

Para la generación de perfiles de datos y el examen de calidad de datos, debe crear una conexión de origen de datos, ya que se usan diferentes conectores para conectar el origen de datos y para examinar los datos con el fin de capturar hechos y dimensiones de calidad de datos. Para configurar una conexión:

En Catálogo unificado, seleccione Administración de estado y, después, Calidad de datos.

Seleccione un dominio de gobernanza y, en la lista desplegable Administrar, seleccione Connections.

Seleccione Nuevo para abrir la página de configuración de conexión.

Agregue el nombre para mostrar de la conexión y una descripción.

Agregue el tipo de origen Fabric.

Agregue el identificador de inquilino.

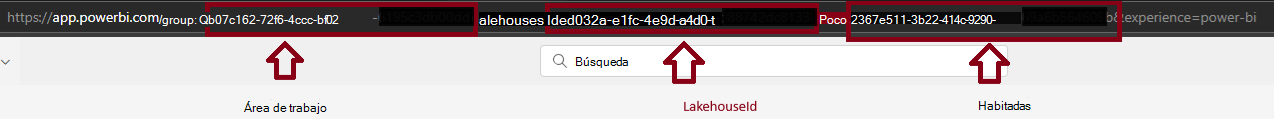

Agregar identificador de área de trabajo

Agregar id. de Lakehouse

Agregue Credential - Microsoft Purview MSI.

Pruebe la conexión para asegurarse de que la conexión configurada se realiza correctamente.

Importante

- Para un examen de calidad de datos, microsoft Purview MSI debe tener acceso de colaborador al área de trabajo de Fabric para conectar el área de trabajo de Fabric. Para conceder acceso de colaborador, abra el área de trabajo de Fabric, seleccione tres puntos (...), seleccione Acceso al área de trabajo, Agregar personas o grupo y, a continuación, agregue MSI de Purview como colaborador.

- Las tablas de tejido deben estar en formato Delta o Iceberg.

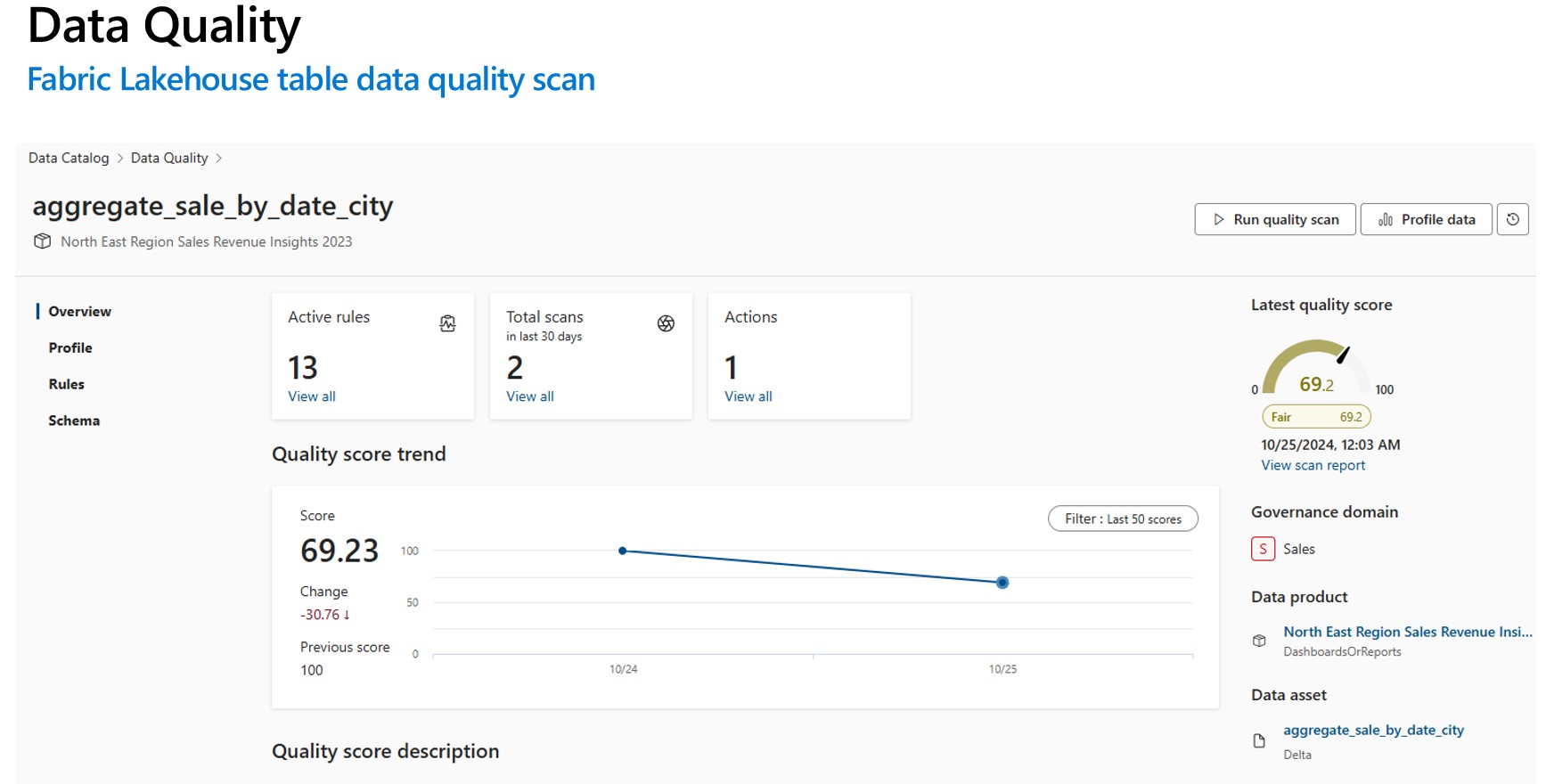

Generación de perfiles y análisis de calidad de datos (DQ) para buscar datos en Fabric Lakehouse

Una vez completada correctamente la configuración de la conexión, puede generar perfiles, crear y aplicar reglas y ejecutar un examen de calidad de datos (DQ) de los datos en Fabric Lakehouse. Siga la guía paso a paso que se describe a continuación:

- Asocie una tabla de Lakehouse a un producto de datos para su conservación, detección y suscripción. Obtenga información sobre cómo crear y administrar productos de datos.

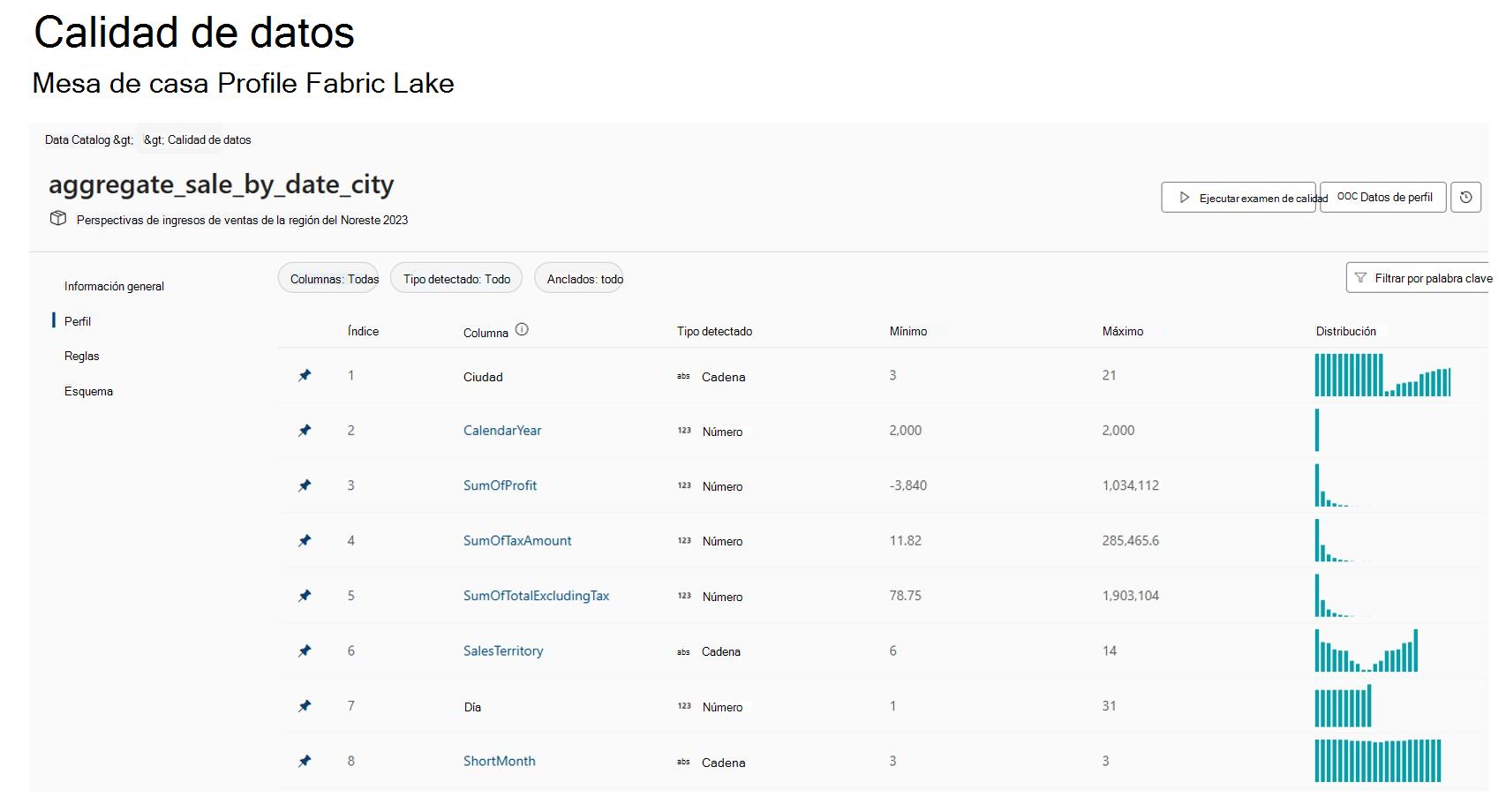

- Tabla de Profile Fabric Lakehouse. Obtenga información sobre cómo configurar y ejecutar la generación de perfiles de datos para un recurso de datos.

- Configure y ejecute el examen de calidad de datos para medir la calidad de los datos de una tabla de Fabric Lakehouse. Obtenga información sobre cómo configurar y ejecutar un examen de calidad de datos.

Importante

- Asegúrese de que los datos están en formato Delta o Iceberg.

- Asegúrese de que el examen de Mapa de datos se ejecutó correctamente. Si no es así, vuelva a ejecutar el examen.

Limitaciones

Data Quality for Parquet file está diseñado para admitir:

- Directorio con el archivo de elementos de Parquet. Por ejemplo: ./Sales/{Parquet Part Files}. El nombre completo debe seguir

https://(storage account).dfs.core.windows.net/(container)/path/path2/{SparkPartitions}. Asegúrese de que no haya patrones {n} en la estructura de directorios o subdirectorio; debe ser una FQN directa que conduce a {SparkPartitions}. - Directorio con archivos Parquet con particiones, con particiones por columnas dentro del conjunto de datos, como los datos de ventas particionados por año y mes. Por ejemplo: ./Sales/{Year=2018}/{Month=Dec}/{Parquet Part Files}.

Se admiten ambos escenarios esenciales que presentan un esquema de conjunto de datos parquet coherente. Limitación: no está diseñado para N jerarquías arbitrarias de directorios con archivos Parquet o no lo admitirá. Recomendamos al cliente que presente datos en (1) o (2) estructura construida. Por lo tanto, recomendamos al cliente que siga el estándar parquet compatible o migre sus datos al formato delta compatible con ACID .

Sugerencia

Para mapa de datos

- Asegúrese de que SPN tiene permisos de área de trabajo.

- Asegúrese de que la conexión de examen usa SPN.

- Se recomienda ejecutar un examen completo si va a configurar un examen de Lakehouse por primera vez.

- Compruebe que los recursos ingeridos se han actualizado o actualizado.

Catálogo unificado

- La conexión de DQ debe usar las credenciales de MSI.

- Lo ideal es crear un nuevo producto de datos para probar por primera vez el examen de DQ de datos de Lakehouse

- Agregue los recursos de datos ingeridos y compruebe que los recursos de datos están actualizados.

- Pruebe a ejecutar el perfil, si se ejecuta correctamente, pruebe a ejecutar la regla DQ. Si no se realiza correctamente, intente actualizar el esquema de recursos (> esquema de importación de administración de esquemas)

- Algunos usuarios también tenían que crear un nuevo Lakehouse y datos de ejemplo solo para comprobar que todo funciona desde cero. En algunos casos, trabajar con recursos que se han ingerido anteriormente en el mapa de datos no es coherente.

Recursos

- Configuración y ejecución de la generación de perfiles de datos de los datos

- Configuración y ejecución del examen de calidad de datos

- Preguntas más frecuentes y autoayuda

- Configuración de la conexión de calidad de datos

- Más información sobre la creación de reflejo en Fabric

- Accesos directos de OneLake

- Data Quality for Fabric mirrored data sources (Calidad de datos para orígenes de datos reflejados en Fabric)

- Calidad de datos para los orígenes de datos de accesos directos de OneLake