Transformación de datos mediante la ejecución de una actividad de definición de trabajo de Spark

La actividad Definición de trabajos de Spark en Data Factory para Microsoft Fabric permite crear conexiones a las definiciones de trabajos de Spark y ejecutarlas desde una canalización de datos.

Prerrequisitos

Para empezar, debe completar los siguientes requisitos previos:

- Una cuenta de inquilino con una suscripción activa. Crear una cuenta de forma gratuita.

- Se crea un área de trabajo.

Añadir una actividad de definición de trabajo de Spark a una canalización mediante la interfaz de usuario

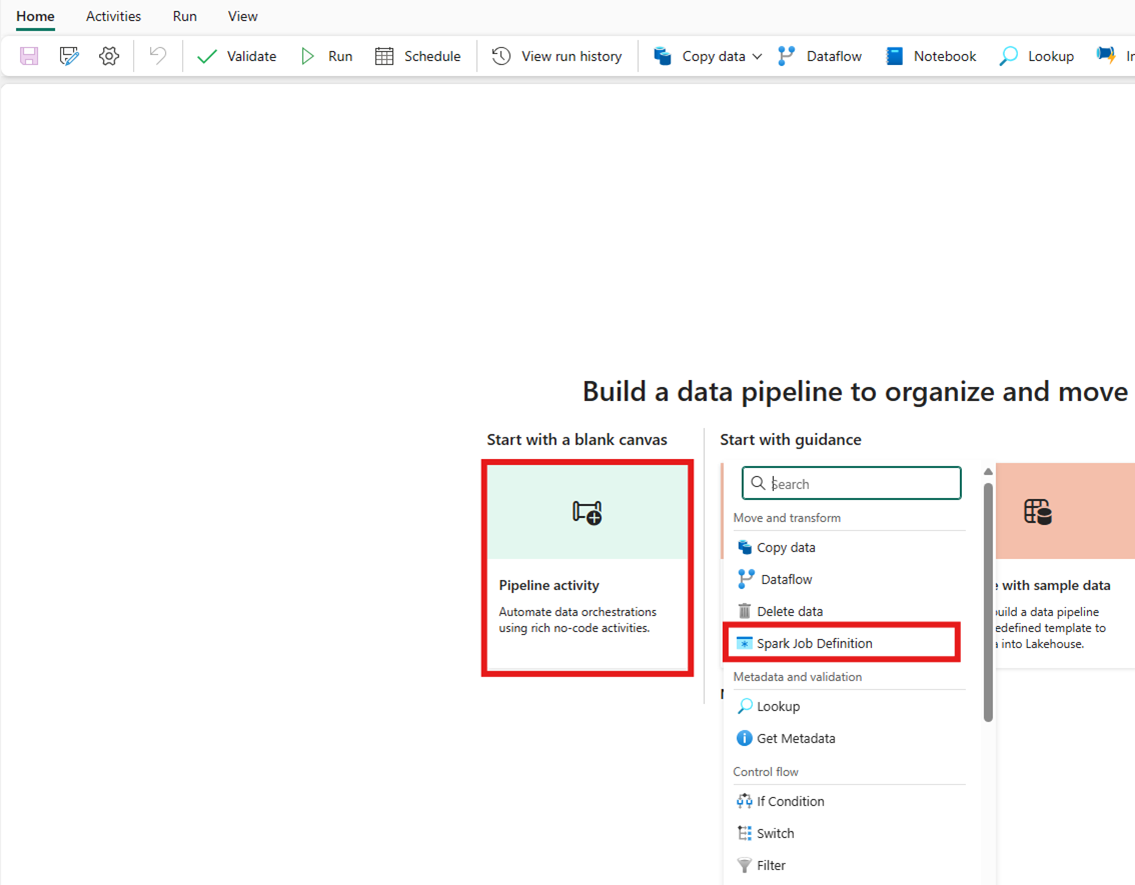

Cree una nueva canalización de datos en el área de trabajo.

Busque Definición de trabajo de Spark desde la tarjeta de inicio y selecciónelo o seleccione la actividad en la barra de Actividades para agregarla a la zona de diseño del flujo de trabajo.

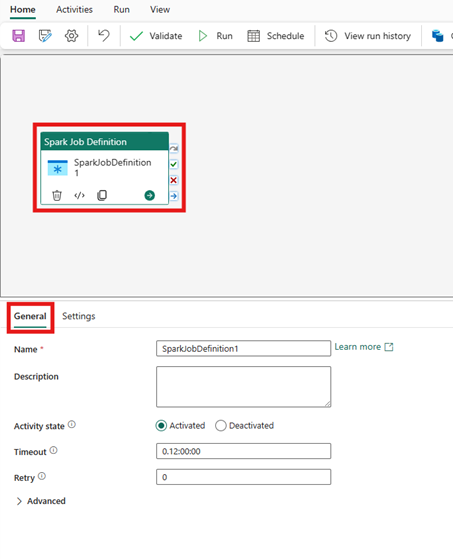

Seleccione la nueva actividad de definición de trabajo de Spark en el lienzo del editor de canalizaciones si aún no está seleccionada.

Consulte la guía de Configuración general para configurar las opciones que se encuentran en la pestaña de Configuración general.

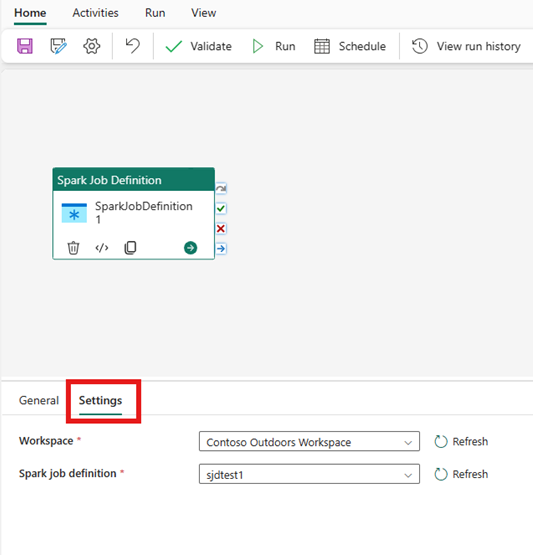

Configuración de la actividad de definición de tareas de Spark

Seleccione la pestaña Configuración en el panel de propiedades de la actividad y, a continuación, seleccione el área de trabajo de Fabric que contiene la definición de trabajo de Spark que desea ejecutar.

Limitaciones conocidas

Las limitaciones actuales de la actividad de definición de trabajo de Spark para Fabric Data Factory se enumeran aquí. Esta sección está sujeta a cambios.

- Actualmente no se admite la creación de una nueva actividad de definición de trabajo de Spark dentro de la actividad (en Configuración)

- La compatibilidad con parametrización no está disponible.

- Aunque apoyamos la supervisión de la actividad a través de la pestaña de salida, aún no es posible supervisar la definición del trabajo de Spark a un nivel más granular. Por ejemplo, los vínculos a la página de supervisión, el estado, la duración y las ejecuciones anteriores de definición de trabajo de Spark no están disponibles directamente en Data Factory. Sin embargo, puede ver información más detallada en la página de supervisión de la definición del trabajo de Spark.

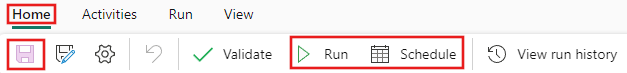

Guardar y ejecutar o programar la canalización

Después de configurar las demás actividades necesarias para la canalización, cambie a la pestaña Inicio de la parte superior del editor de canalizaciones y seleccione el botón Guardar para guardar la canalización. Seleccione Ejecutar para ejecutarla directamente o Programar para programarla. También puede ver el historial de ejecución aquí o configurar otras opciones.