Escenario de precios mediante Flujo de datos Gen2 para cargar 2 GB de datos de Parquet en una tabla de Lakehouse

En este escenario, se usó Flujo de datos Gen2 para cargar 2 GB de datos de Parquet almacenados en Azure Data Lake Storage (ADLS) Gen2 en una tabla de Lakehouse en Microsoft Fabric. Se han usado los datos de ejemplo NYC Taxi-green para los datos de Parquet.

Los precios utilizados en el siguiente ejemplo son hipotéticos y no pretenden reflejar precios reales exactos. Estos son solo para demostrar cómo puede calcular, planear y administrar el costo de los proyectos de Data Factory en Microsoft Fabric. Además, dado que las capacidades de Fabric tienen un precio único en cada región, usamos los precios de pago por uso para una capacidad de Fabric en Oeste de EE. UU. 2 (una región típica de Azure), a 0,18 USD por CU por hora. Consulte la página de precios de Microsoft Fabric para explorar otras opciones de precios de capacidad de Fabric.

Configuración

Para lograr este escenario, es preciso crear un flujo de datos con los siguientes pasos:

- Inicialización del flujo de datos: obtenga datos de archivos de Parquet de 2 GB de la cuenta de almacenamiento de ADLS Gen2.

- Configuración de Power Query:

- Vaya a Power Query.

- Asegúrese de que la opción para almacenar provisionalmente la consulta está habilitada.

- Continúe para combinar los archivos de Parquet.

- Transformación de datos:

- Promueva encabezados para mayor claridad.

- Quite las columnas innecesarias.

- Ajuste los tipos de datos de columna según sea necesario.

- Definición del destino de los datos de salida:

- Configure Lakehouse como destino de salida de datos.

- En este ejemplo, se creó y utilizó una instancia de Lakehouse en Fabric.

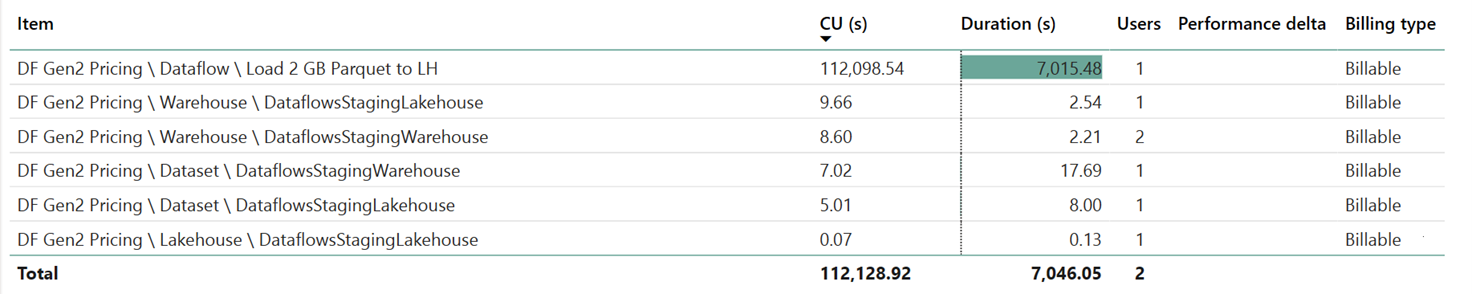

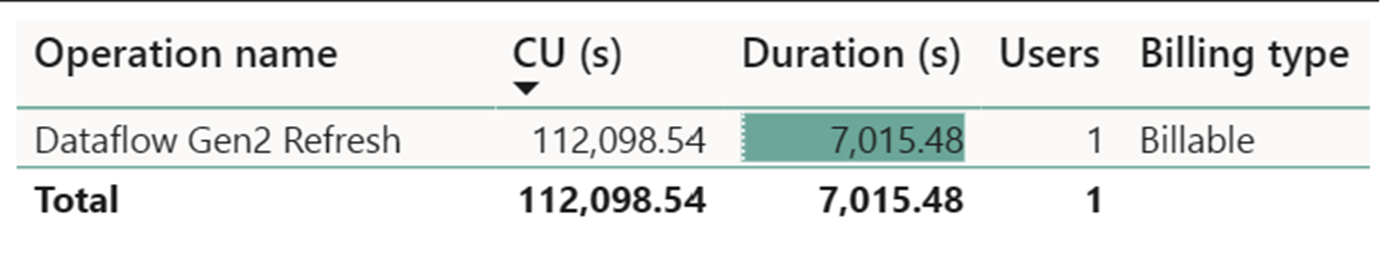

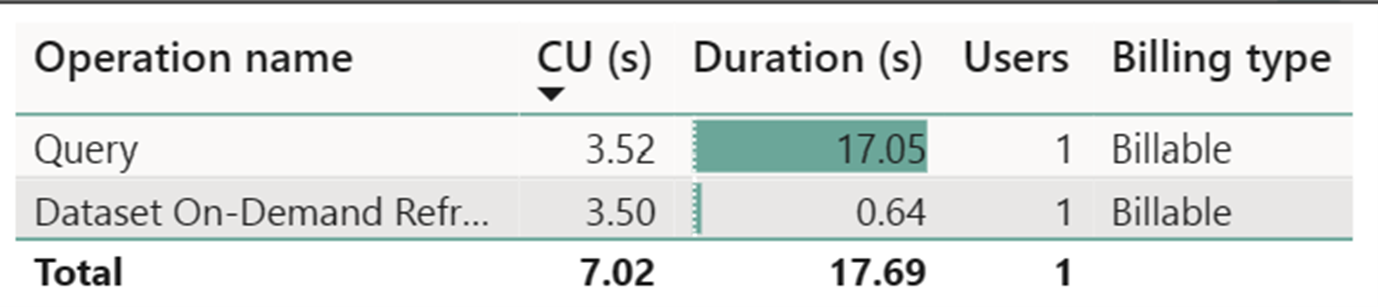

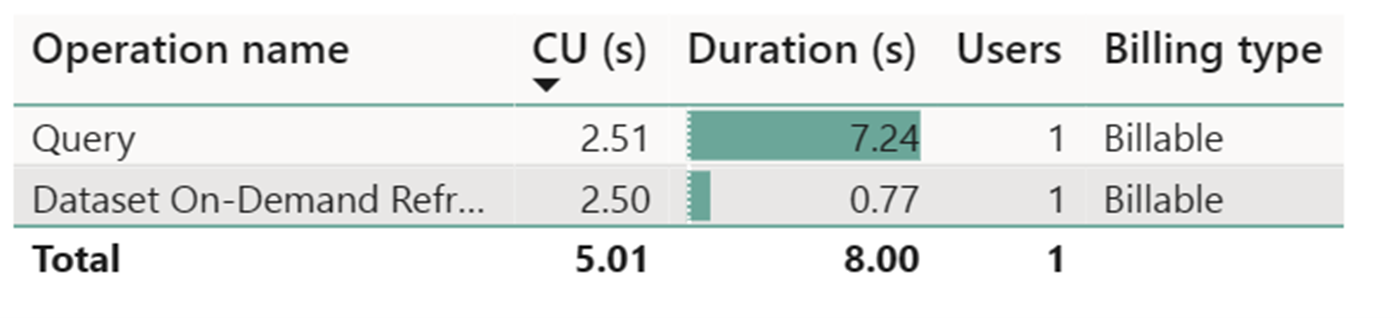

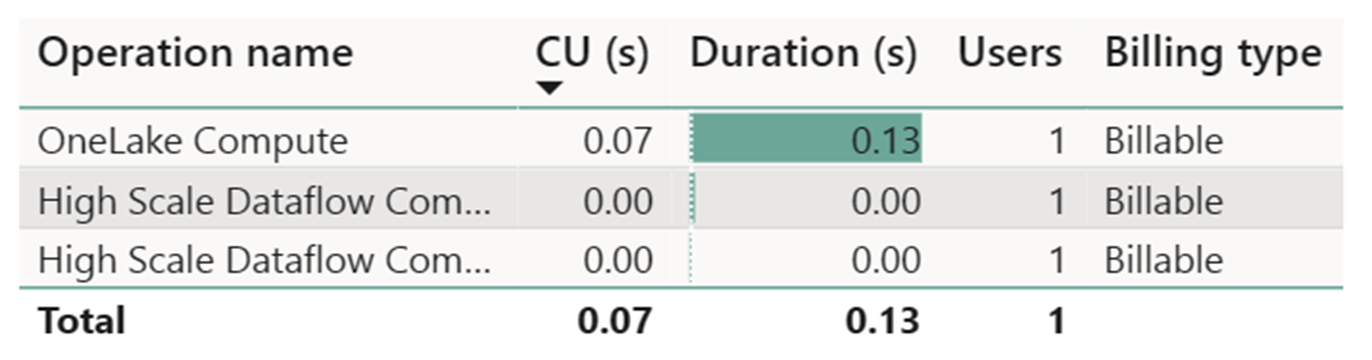

Estimación de costos mediante la aplicación Métricas de Fabric

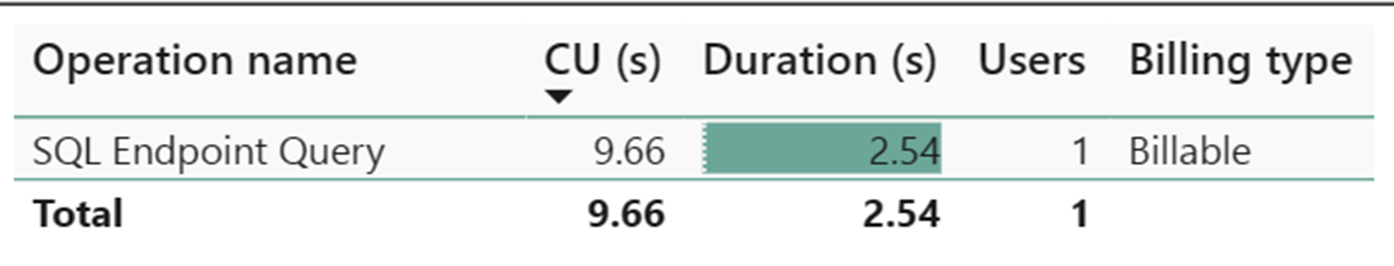

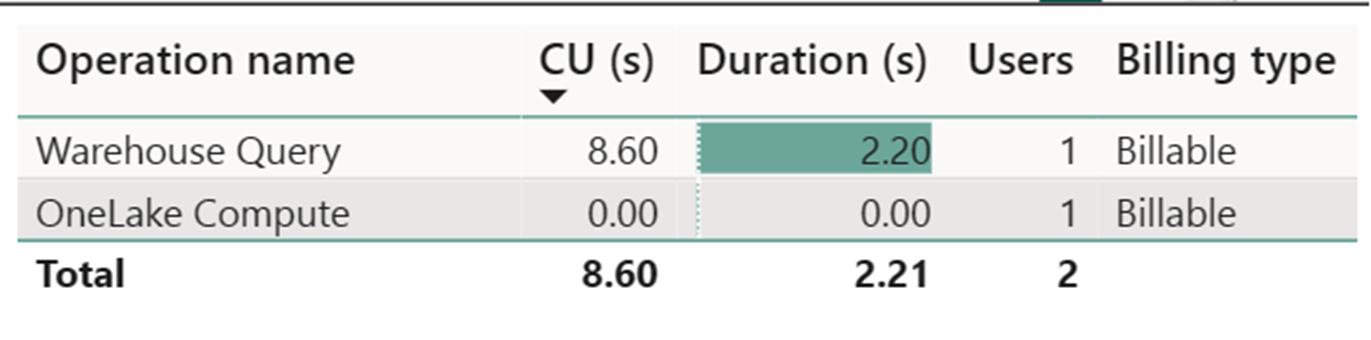

El medidor de proceso de flujo de datos a gran escala ha registrado una actividad insignificante. El medidor de proceso estándar para las operaciones de actualización de Flujo de datos Gen2 consume 112 098,540 unidades de proceso (CU). Es importante tener en cuenta que otras operaciones, como la consulta de almacenamiento, la consulta de punto de conexión SQL y la actualización a petición del conjunto de datos, constituyen aspectos detallados de la implementación de Flujo de datos Gen2 que son actualmente transparentes y necesarios para sus operaciones correspondientes. Sin embargo, estas operaciones se ocultarán en futuras actualizaciones y se deben omitir al calcular los costos de Flujo de datos Gen2.

Nota:

Aunque se notifica como métrica, la duración real de la ejecución no es pertinente al calcular las horas de CU efectivas con la aplicación Métricas de Fabric, ya que la métrica de segundos de CU que también notifica ya tiene en cuenta su duración.

| Metric | Nivel Estándar de Compute | Proceso a gran escala |

|---|---|---|

| Total de segundos de CU | 112 098,54 segundos de CU | 0 segundos de CU |

| Horas efectivas de CU facturadas | 112 098,54 / (60*60) = 31,14 horas de CU | 0 / (60*60) = 0 horas de CU |

Costo total de ejecución a 0,18 USD/hora de CU = (31,14 horas de CU) * (0,18 USD/hora de CU) ~= 5,60 USD