Ingesta de datos en Fabric mediante la actividad de copia de Azure Data Factory

El conector de Microsoft Fabric Lakehouse en Azure Data Factory (ADF) y Azure Synapse Analytics habilitan operaciones de lectura y escritura en Microsoft Fabric Lakehouse (tanto para tablas como para archivos). Este conector le permite usar sus canalizaciones existentes de ADF y Synapse, así como los flujos de datos de asignación, para interactuar con Fabric Lakehouses. Este artículo le ayuda a configurar Microsoft Fabric para permitir la autenticación de la entidad de servicio y, a continuación, muestra el conector de Lakehouse para leer y escribir en Fabric Lakehouse.

Para obtener más información sobre Microsoft Fabric Lakehouse, consulte ¿Qué es un lago?

Conector de Azure Data Factory Lakehouse

Un nuevo conector de servicio vinculado de Lakehouse y dos nuevos conjuntos de datos ahora están disponibles para los clientes que quieren empezar a leer y escribir en Microsoft Fabric Lakehouse. Para obtener una guía completa sobre el conector de Lakehouse, consulte Copia y transformación de datos en Microsoft Fabric Lakehouse Files (versión preliminar).

Autenticación

Servicio vinculado de Azure Data Factory

El conector de Microsoft Fabric Lakehouse requiere una entidad de servicio (SPN) o un registro de aplicación para la autenticación. Para comenzar, debe crear un SPN nuevo o usar uno existente. Microsoft Fabric permite el acceso de SPN a grupos de seguridad específicos o a toda la organización. Si un grupo de seguridad específico es la opción que usa la organización, el SPN usado en el conector de Lakehouse debe pertenecer a un grupo de seguridad que se agregue a la lista de permitidos.

Nota

No se necesitan permisos de API de Power BI (delegados)

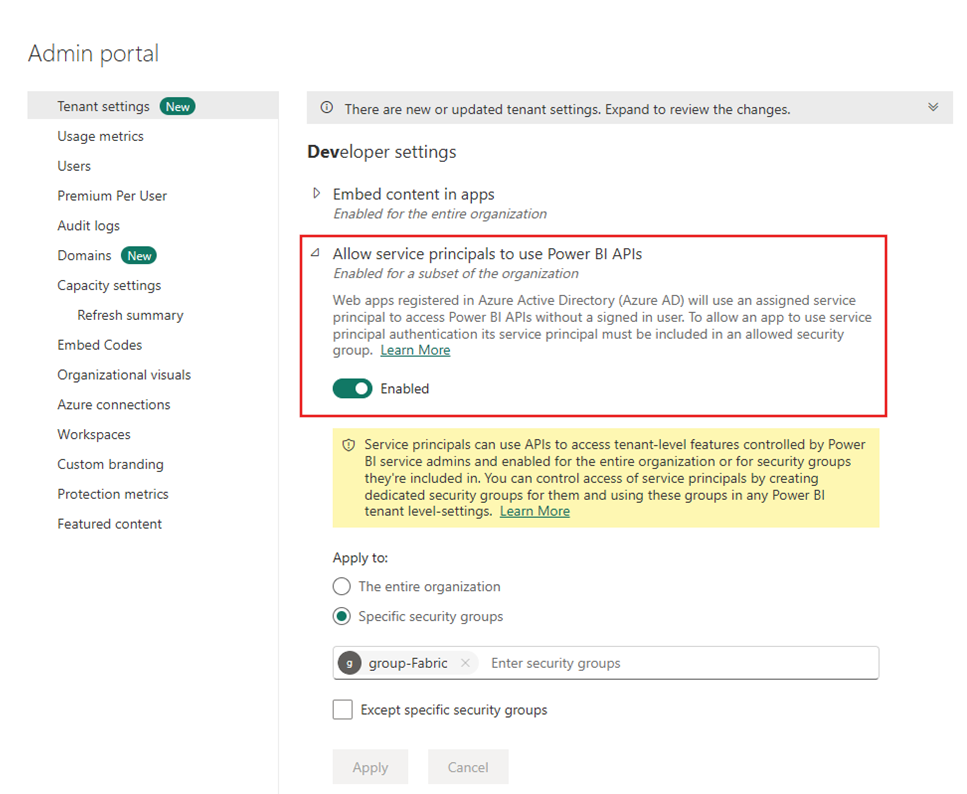

Acceso a las API de Power BI

En el portal de administración de Power BI, el administrador de inquilinos de Power BI debe habilitar Permitir que las entidades de servicio usen las API de Power BI. El grupo de seguridad debe especificarse bajo la configuración Permitir que las entidades de servicio usen las API de Power BI, o puede habilitarse para toda la organización.

Para obtener una guía completa, consulte Inserción de contenido de Power BI en una aplicación de análisis insertada con un servicio y una clave secreta de aplicación.

Nota

Al asignar el grupo de seguridad al área de trabajo, puede haber un retraso para que la entidad de servicio tenga acceso al área de trabajo debido al almacenamiento en caché de permisos en Azure. Si necesita acceso inmediato, puede usar PowerShell para forzar una actualización de los permisos del usuario. Para ello, abra PowerShell como administrador y ejecute los siguientes comandos:

Install-Module -Name MicrosoftPowerBIMgmt

Connect-PowerBIServiceAccount -Tenant '<TENANT ID>' -ServicePrincipal -Credential (Get-Credential)

Get-PowerBIWorkspace

Invoke-PowerBIRestMethod -URL 'https://api.powerbi.com/v1.0/myorg/RefreshUserPermissions' -Method Post -Body ''

Get-PowerBIWorkspace

Acceso al área de trabajo

Una vez agregado el grupo de seguridad, el grupo de seguridad o la entidad de servicio también se deben agregar a cada área de trabajo como Miembro, colaborador o administrador. Consulte Proporcionar a los usuarios acceso a las áreas de trabajo para obtener más información.

Demostración: Configuración de la autenticación

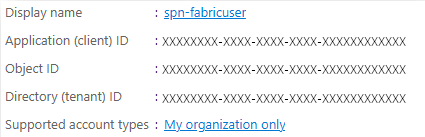

Entidad de servicio de registro de aplicaciones

Cree o use una entidad de servicio de registro de aplicaciones (SPN) existente. Siga los pasos sobre cómo registrar una aplicación con Microsoft Entra ID y crear una entidad de servicio.

Nota

No es necesario asignar un URI de redirección.

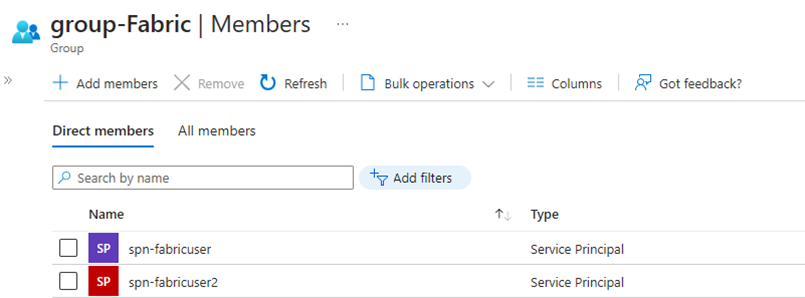

Grupo de seguridad

Cree un nuevo grupo de seguridad de Microsoft Entra o use uno existente y, a continuación, agregue el SPN a él. Siga los pasos descritos en Crear un grupo básico y agregar miembros para crear un grupo de seguridad de Microsoft Entra.

Portal de administración de Power BI

En el portal de administración de Power BI, vaya a Configuración del desarrollador y seleccione Permitir que las entidades de servicio usen las API de Power BI y, a continuación, habilítela. A continuación, agregue el grupo de seguridad del paso anterior. Para obtener más información sobre la configuración de inquilinos del portal de administración de Power BI, consulte Configuración de inquilinos.

Nota

Asegúrese de que la configuración Los usuarios pueden acceder a los datos almacenados en OneLake desde aplicaciones externas a Fabric está habilitada. Consulte Permitir que las aplicaciones que se ejecutan fuera de Fabric accedan a los datos a través de OneLake.

Área de trabajo

Agregue el SPN o el grupo de servicios al área de trabajo con acceso de miembro, colaborador o administrador.

Azure Data Factory: servicio vinculado

Desde Azure Data Factory, cree un nuevo servicio vinculado de Microsoft Fabric Lakehouse.

Nota

Para encontrar el espacio de trabajo y los identificadores de Lakehouse, vaya a su Fabric Lakehouse e identifíquelo en la URL. Por ejemplo: https://.../groups/<ID de espacio de trabajo>>/lakehouses/<ID de Lakehouse>

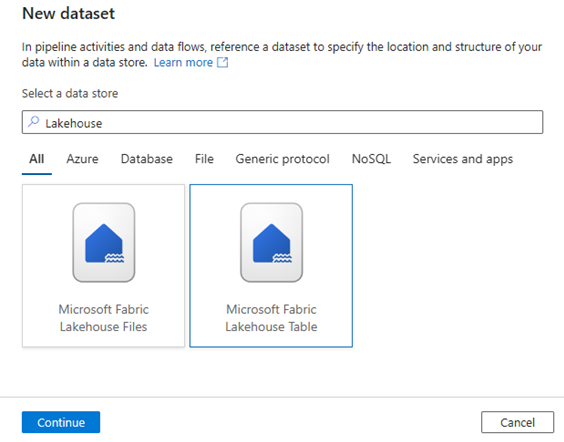

Azure Data Factory: Conjunto de datos

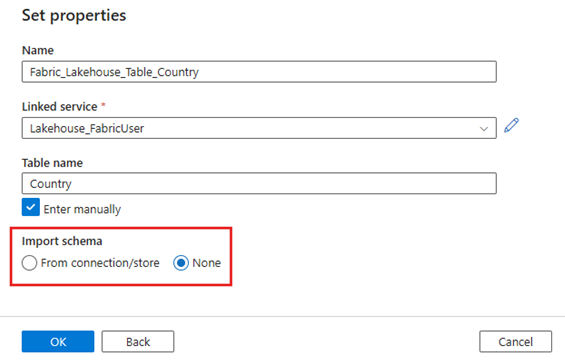

Cree un conjunto de datos que haga referencia al servicio vinculado Microsoft Fabric Lakehouse.

Nota

Seleccione Ninguno para la opción importar esquema si la tabla no existe aún y está especificando manualmente un nuevo nombre de tabla.

Demostración: Escritura en una tabla de Fabric Lakehouse con una canalización de ADF

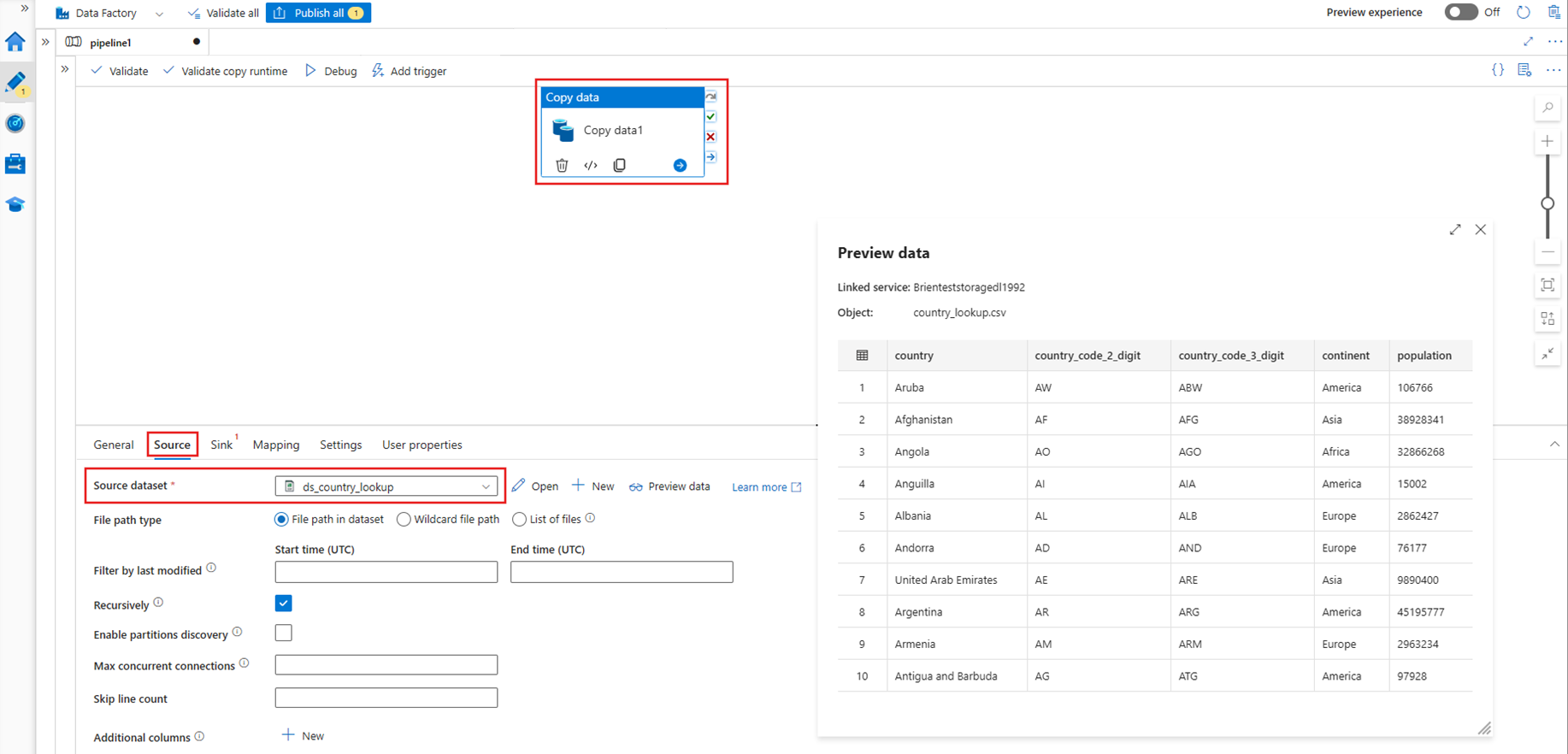

Fuente

Cree una nueva canalización y agregue una actividad de copia al lienzo de la canalización. Desde la pestaña de origen de la actividad de copia, seleccione un conjunto de datos de origen que quiera mover a una tabla en Lakehouse. En este ejemplo, hacemos referencia a un archivo .csv desde una cuenta de Azure Data Lake Storage (ADLS) Gen2.

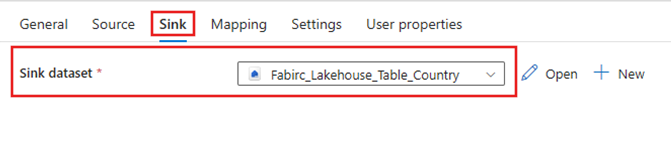

Receptor

Navegue a la pestaña Destino de la actividad de copia y seleccione el conjunto de datos Fabric Lakehouse que se creó anteriormente.

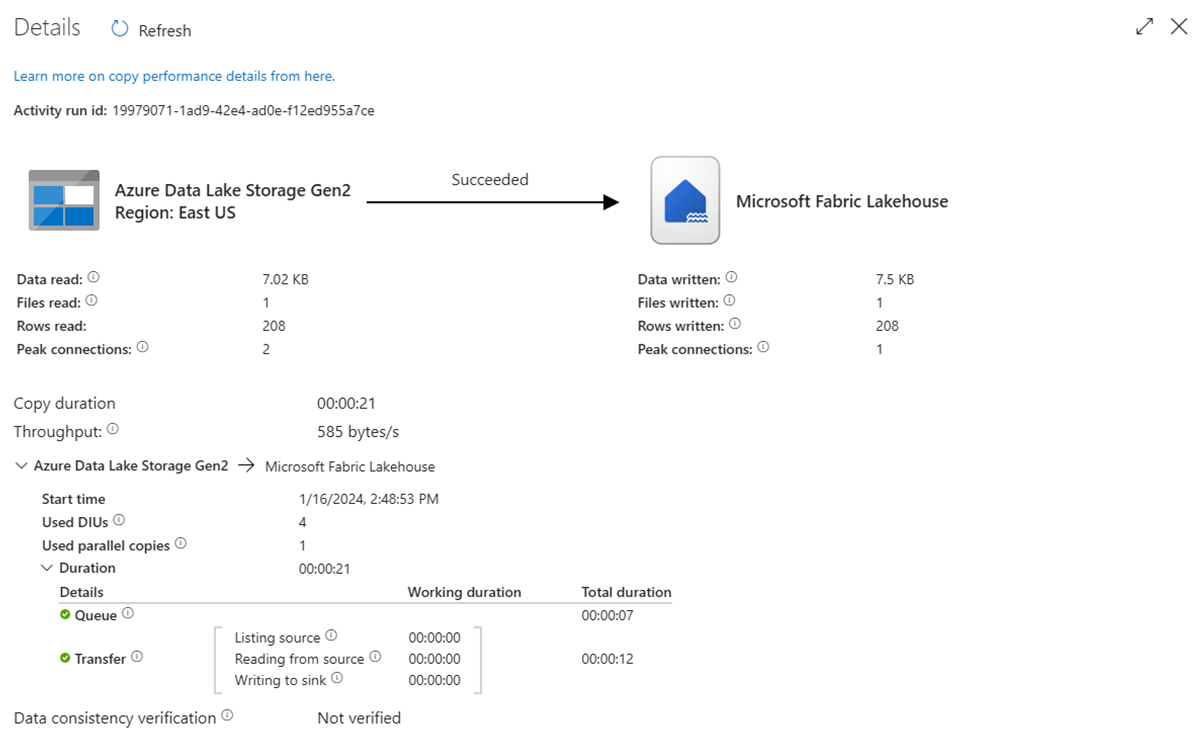

Ejecución de la canalización

Ejecute la canalización para mover los datos de .csv a la tabla Fabric Lakehouse.

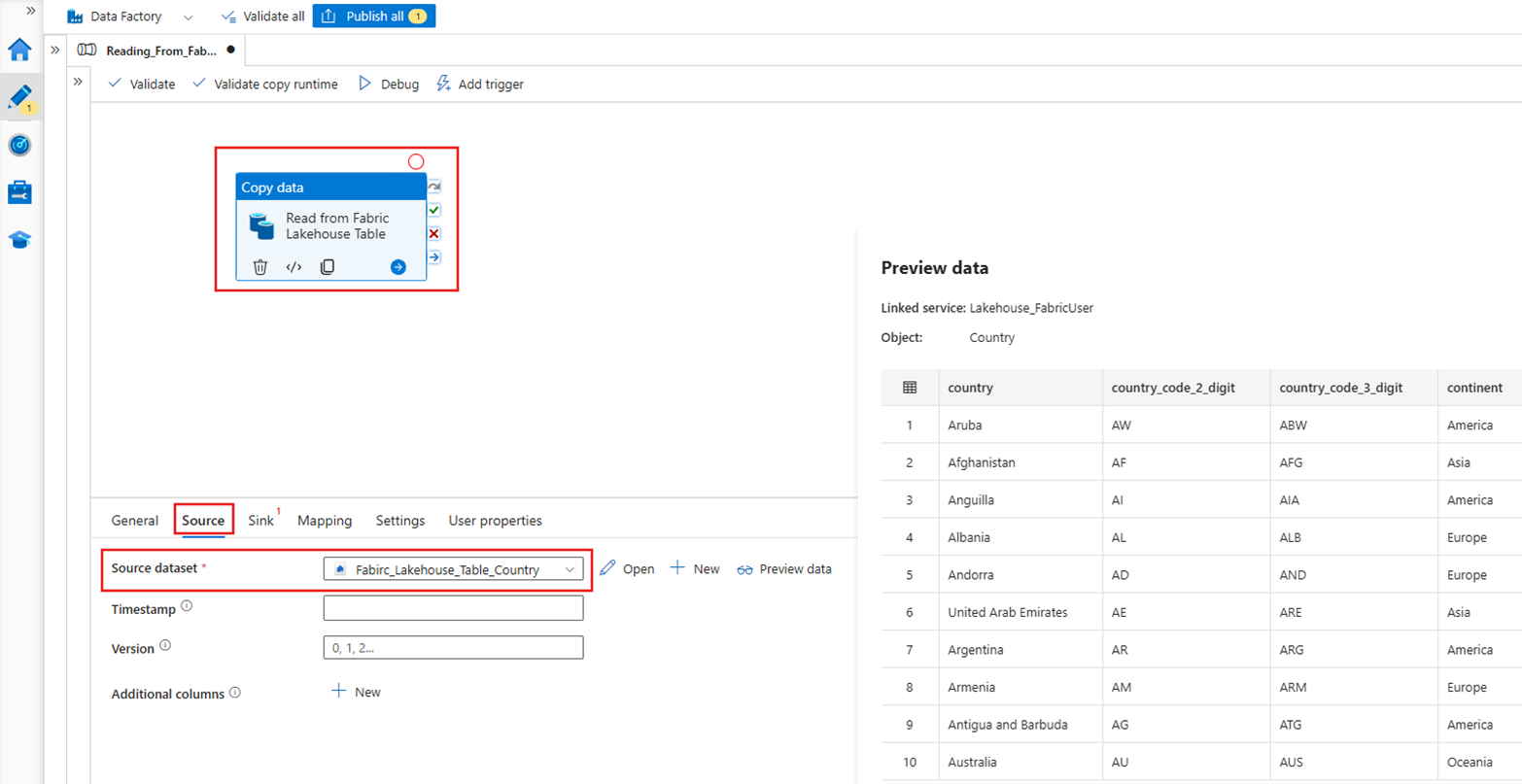

Demostración: Leer desde una tabla de Fabric Lakehouse con una canalización de ADF

En la sección anterior, se ha mostrado cómo usar ADF para escribir en una tabla de Fabric Lakehouse. Ahora, vamos a leer de una tabla de Fabric Lakehouse y escribir en un archivo Parquet en Azure Data Lake Storage (ADLS) Gen2 con un proceso similar.

Fuente

Cree una nueva canalización y agregue una actividad de copia al lienzo de la canalización. En la pestaña Origen de la actividad de copia, seleccione el conjunto de datos Fabric Lakehouse que se creó anteriormente.

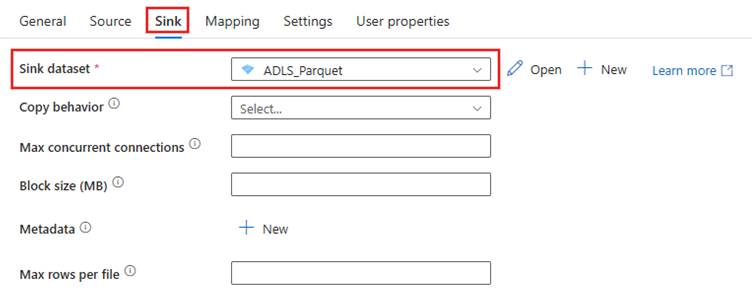

Receptor

Vaya a la pestaña receptor de la actividad de copia y seleccione el conjunto de datos de destino. En este ejemplo, el destino es Azure Data Lake Storage (Gen2), como un archivo Parquet.

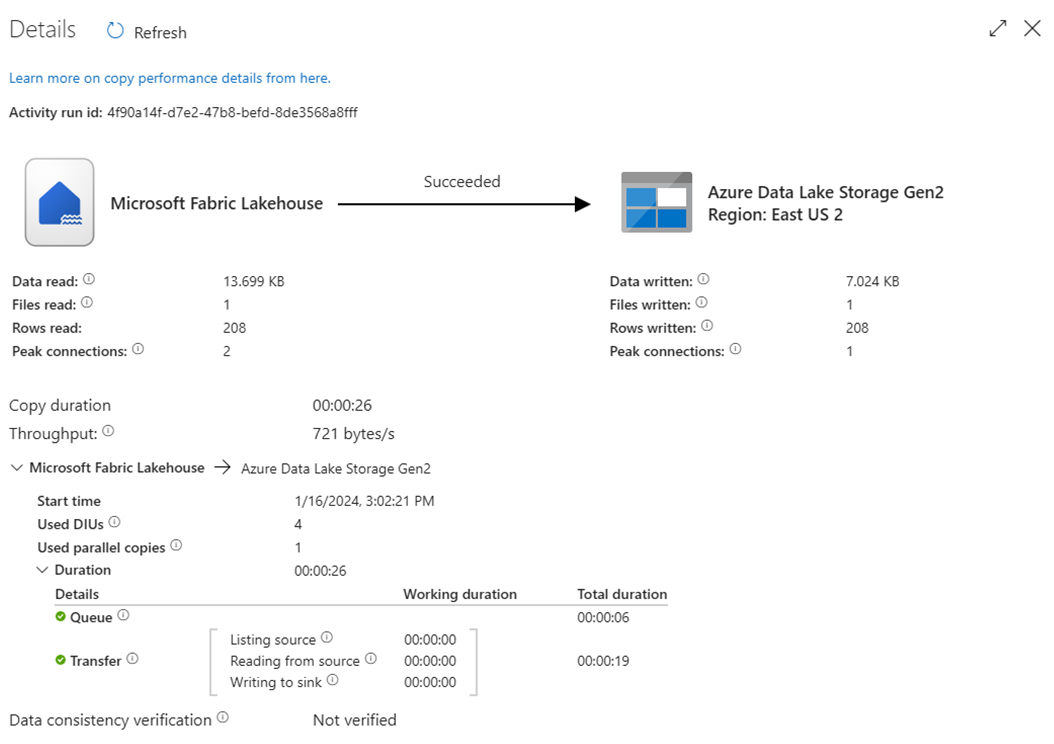

Ejecución de la canalización

Ejecute la canalización para mover los datos de la tabla Fabric Lakehouse al archivo Parquet en ADLS Gen2.

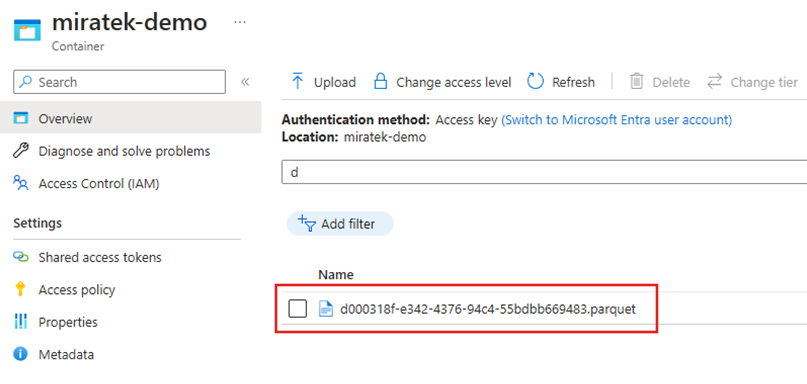

Inspeccione el archivo Parquet en ADLS Gen2

Los datos de la tabla Fabric Lakehouse ahora están disponibles en ADLS Gen2 como un archivo Parquet.

Resumen

En esta sección, hemos explorado los requisitos de Lakehouse Connector mediante la autenticación de la entidad de servicio en una instancia de Microsoft Fabric Lakehouse y, a continuación, se describe un ejemplo para leer y escribir en Lakehouse desde una canalización de Azure Data Factory. Este conector y sus funcionalidades también están disponibles en los flujos de datos de asignación de Azure Data Factory, Azure Synapse Analytics y los flujos de datos de asignación de Azure Synapse Analytics.